随着人工智能技术的迅速发展,传统的个人电脑已经面临升级的需求。AI PC时代,如何能使大模型更好地服务企业和个人?中科创达交出了第一份答卷。

近日,中科创达凭借其在终端、边缘计算领域的多年技术沉淀以及在大模型领域的创新探索,利用模型压缩、分布式以及张量并行技术,成功在搭载了高通8系列芯片平台的边缘设备上实现了LLaMA-2 130亿参数模型的稳定运行,成为业内首家取得此突破的大模型企业。这一创举将使得端侧设备能够运行更大参数的模型,同时提高了端侧设备的推理速度,为大模型在端侧的应用奠定了坚实的基础。

模型压缩及张量并行技术提升端侧AI效率

自今年3月份ChatGPT-3对外开放以来,大模型及其应用以极其惊人的发展速度席卷全球,由此带来了对于算力需求的急速攀升。云端算力面临成本和供给压力,无法满足AI算力需求,端侧AI为这一难题提供了解决方案。随着高通、Intel等芯片厂商陆续发布具有更高算力并支持生成式AI的终端芯片,AI PC时代拉开序幕。

AI PC作为终端、边缘与云技术融合的创新产物,具有成本、时延和隐私方面的天然优势,可以作为云端算力的补充。在即将到来的AI PC时代,中科创达将能够充分发挥自身在终端、操作系统、边缘计算、软件以及生态合作方面的优势,助力品牌商和开发者抓住行业转型的契机,为终端用户带来在办公、娱乐、学习等多场景下的更为高效便捷的体验。

边缘AI加速大模型在B端落地应用

此次中科创达的成功实践不仅验证了13B大模型在端侧的落地,也为大模型在边缘的应用打开了新的可能性。以往,大型模型主要在云端进行训练和推理,而现在,边缘设备也能够胜任更大参数的模型。这将为各行各业带来更多的机会和挑战,无论是语音识别、图像处理还是自然语言处理,都能够受益于这一创新。

未来,AI将以端云协同的模式,即云端进行模型训练,而推理则集中在离数据产生距离更近的端侧及边缘侧进行,有效缓解AI算力不足的需求和缺口。由此加速大模型应用在智能驾驶、具身智能、智能家居、智能物联网等场景的落地。

审核编辑:彭菁

-

芯片

+关注

关注

462文章

53539浏览量

459168 -

高通

+关注

关注

78文章

7683浏览量

198657 -

人工智能

+关注

关注

1813文章

49741浏览量

261561 -

大模型

+关注

关注

2文章

3442浏览量

4969

原文标题:AI PC时代,端侧运行130亿参数模型,中科创达是如何做到的?

文章出处:【微信号:THundersoft,微信公众号:ThunderSoft中科创达】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

DeepSeek模型如何在云服务器上部署?

Cognizant加速AI模型企业级开发

企业部署AI大模型怎么做

如何在RAKsmart服务器上实现企业AI模型部署

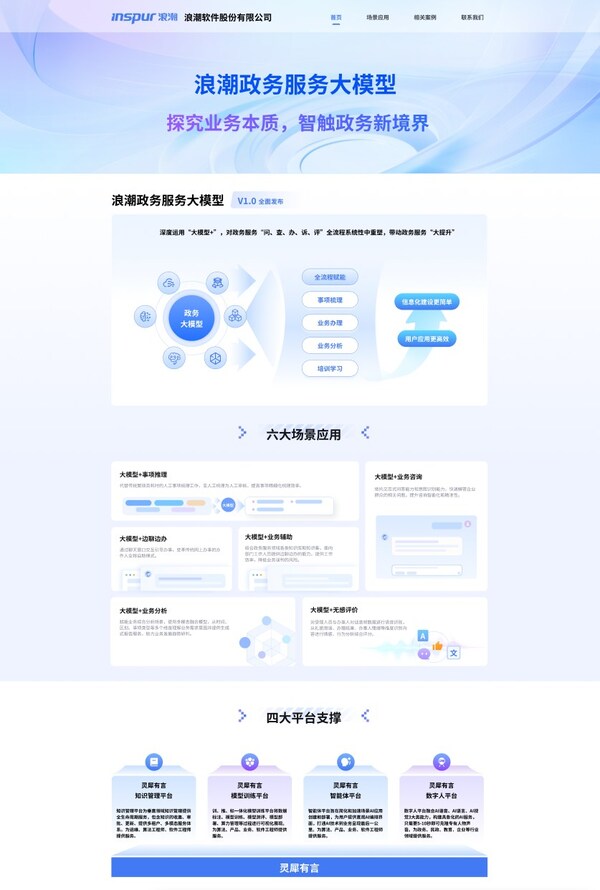

浪潮软件率先推出政务服务大模型,重塑全场景应用

请问如何能让模型的效果更好?

普强深思大模型智能机器人重塑企业高效服务新范式

Dataedo Data Catalog每个人都能养数据

企业AI模型托管怎么做的

华为云 Flexus 云服务器 X 实例之 Docker 环境下部署 JmalCloud 个人网盘

如何能使大模型更好地服务企业和个人

如何能使大模型更好地服务企业和个人

评论