有理论基础,我们就可以进行深度优化了。为什么 transformer 性能这么好?它给众多大语言模型带来的上下文学习 (In-Context Learning) 能力是从何而来?在人工智能领域里,transformer 已成为深度学习中的主导模型,但人们对于它卓越性能的理论基础却一直研究不足。 最近,来自 Google AI、苏黎世联邦理工学院、Google DeepMind 研究人员的新研究尝试为我们揭开谜底。在新研究中,他们对 transformer 进行了逆向工程,寻找到了一些优化方法。论文《Uncovering mesa-optimization algorithms in Transformers》:

。 该研究的贡献包括:

。 该研究的贡献包括:

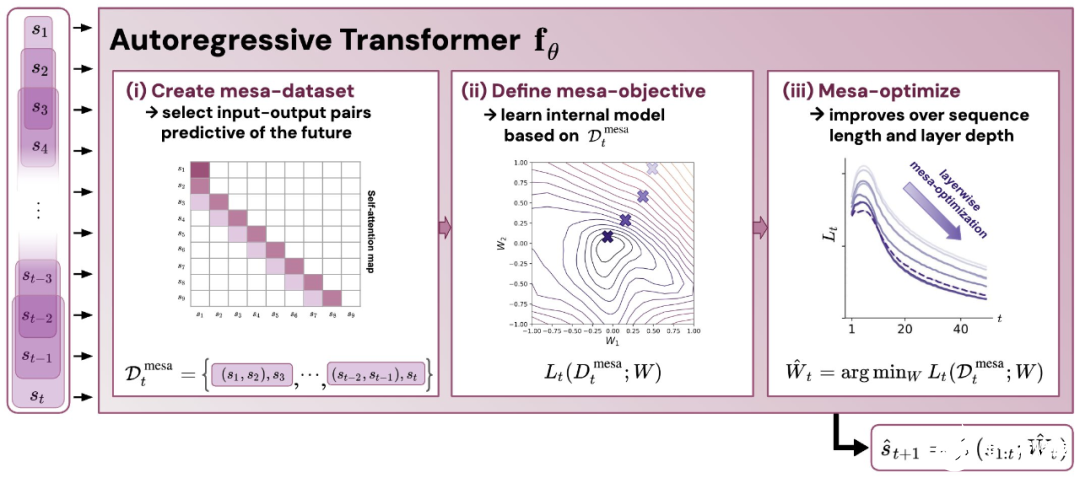

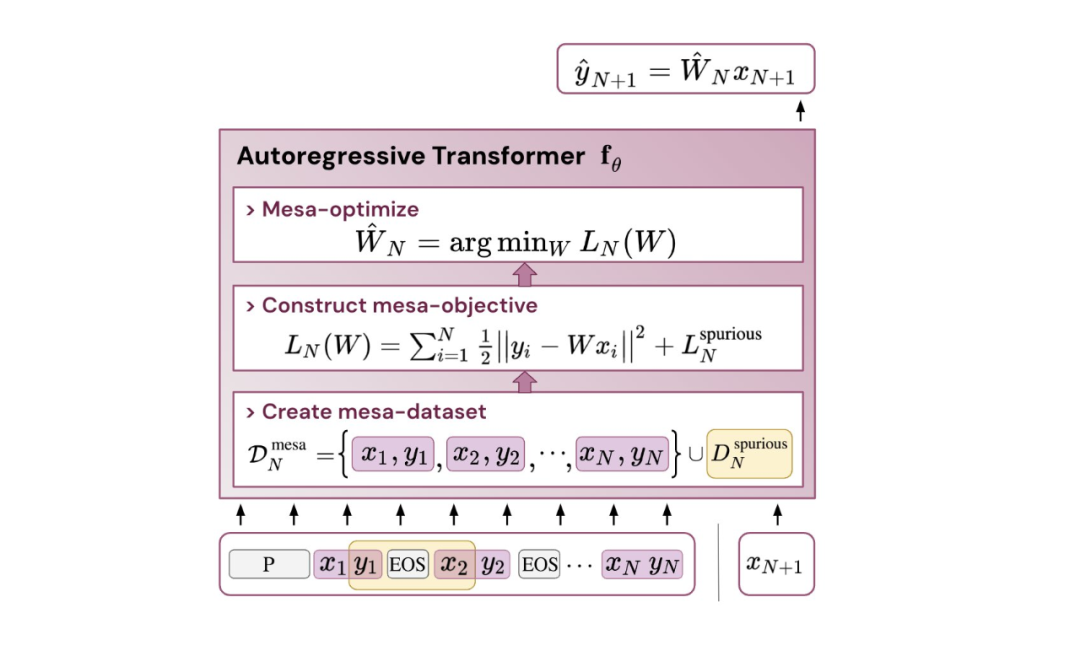

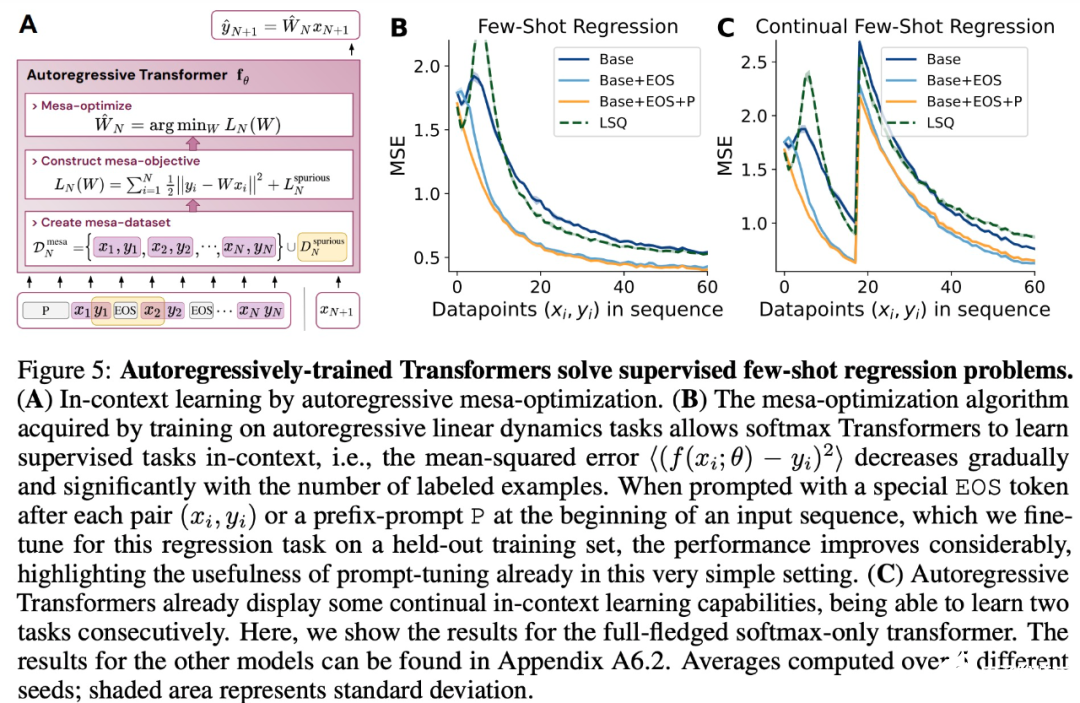

- 概括了 von Oswald 等人的理论,并展示了从理论上,Transformers 是如何通过使用基于梯度的方法优化内部构建的目标来自回归预测序列下一个元素的。

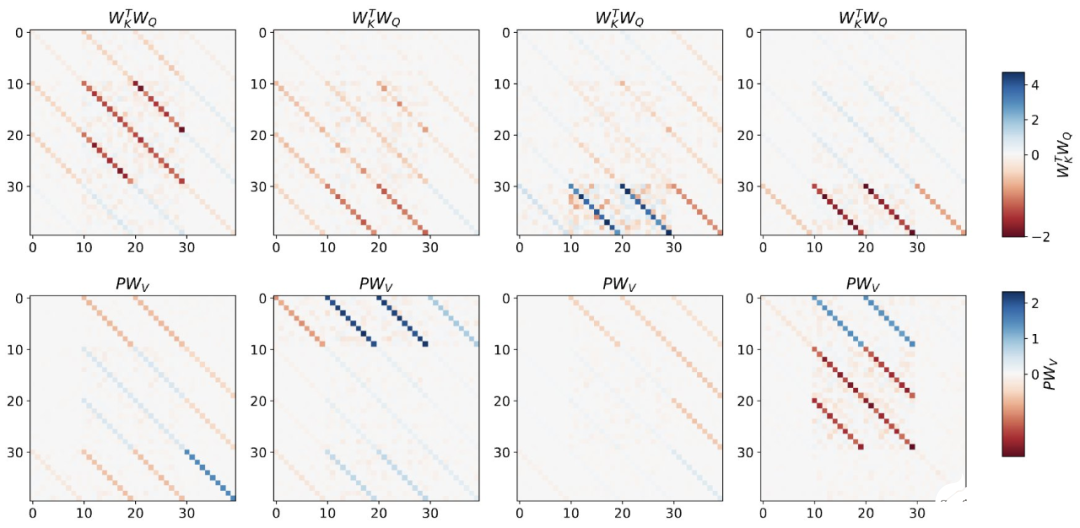

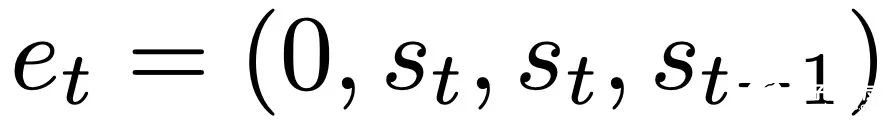

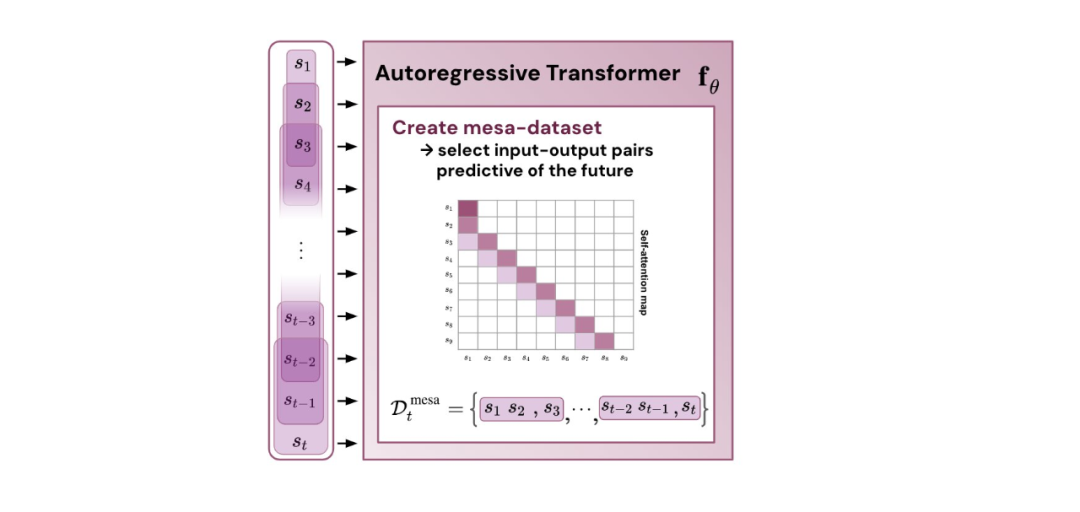

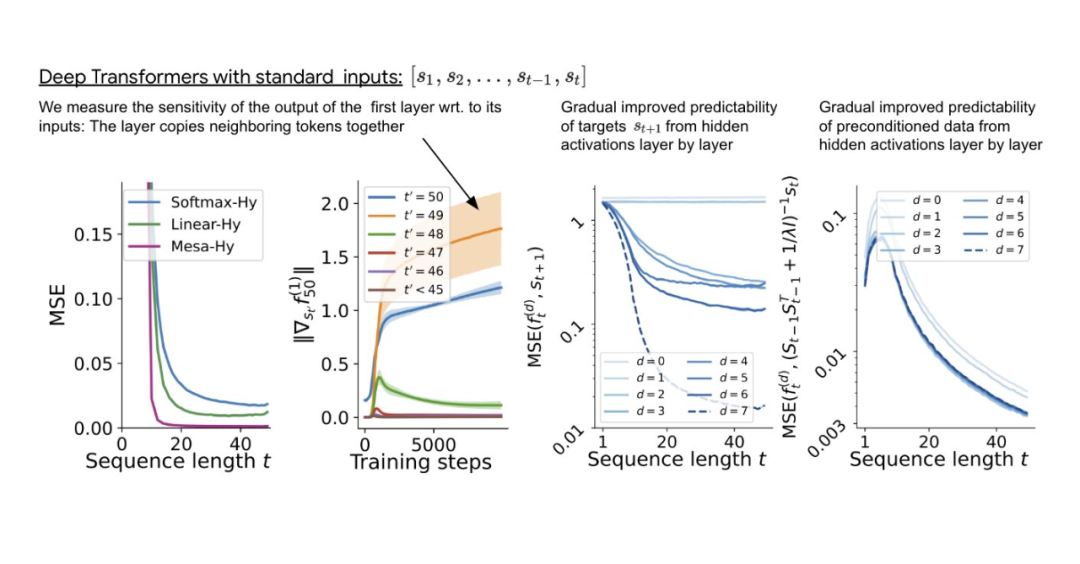

- 通过实验对在简单序列建模任务上训练的 Transformer 进行了逆向工程,并发现强有力的证据表明它们的前向传递实现了两步算法:(i) 早期自注意力层通过分组和复制标记构建内部训练数据集,因此隐式地构建内部训练数据集。定义内部目标函数,(ii) 更深层次优化这些目标以生成预测。

- 与 LLM 类似,实验表明简单的自回归训练模型也可以成为上下文学习者,而即时调整对于改善 LLM 的上下文学习至关重要,也可以提高特定环境中的表现。

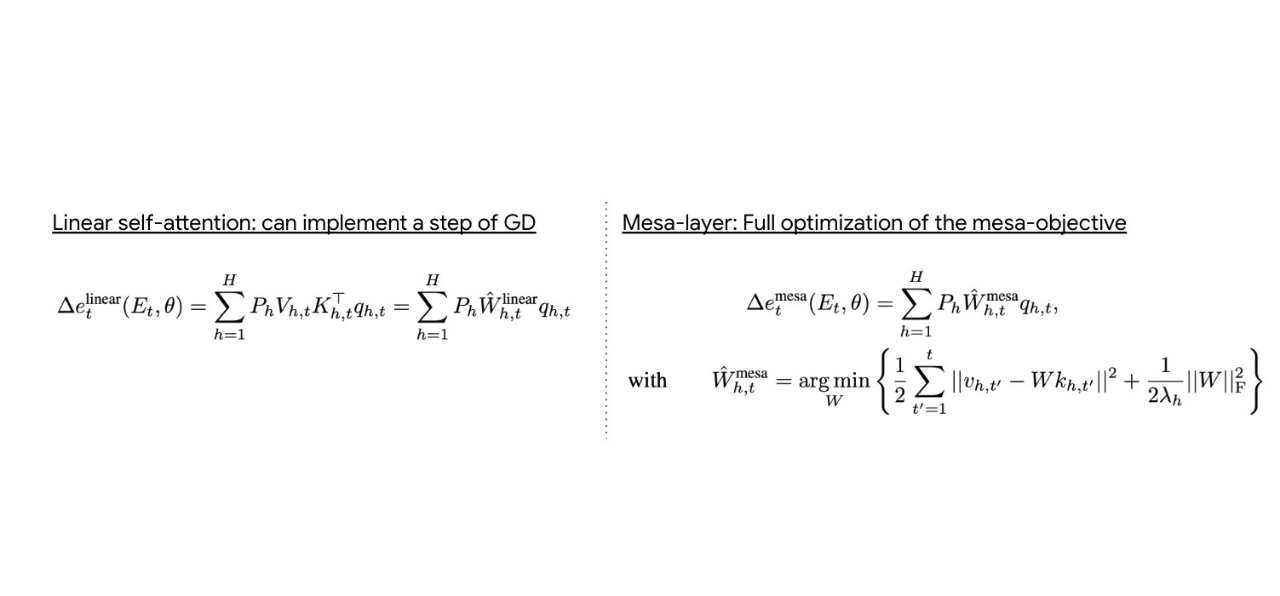

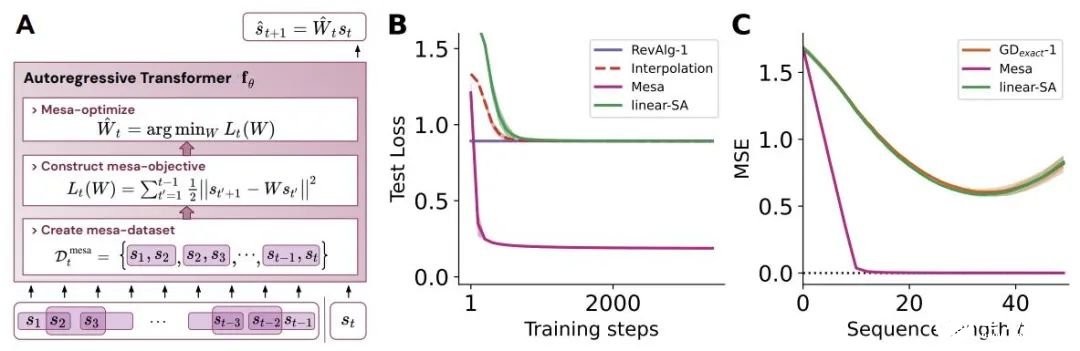

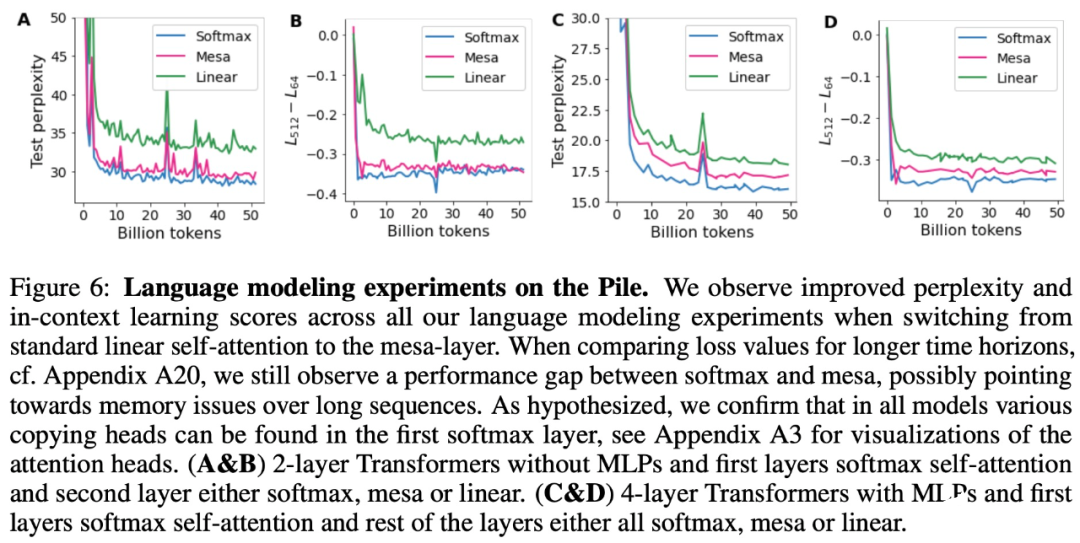

- 受发现注意力层试图隐式优化内部目标函数的启发,作者引入了 mesa 层,这是一种新型注意力层,可以有效地解决最小二乘优化问题,而不是仅采取单个梯度步骤来实现最优。实验证明单个 mesa 层在简单的顺序任务上优于深度线性和 softmax 自注意力 Transformer,同时提供更多的可解释性。

- 在初步的语言建模实验后发现,用 mesa 层替换标准的自注意力层获得了有希望的结果,证明了该层具有强大的上下文学习能力。

,这对应于选择 W_0 = 0。

,这对应于选择 W_0 = 0。

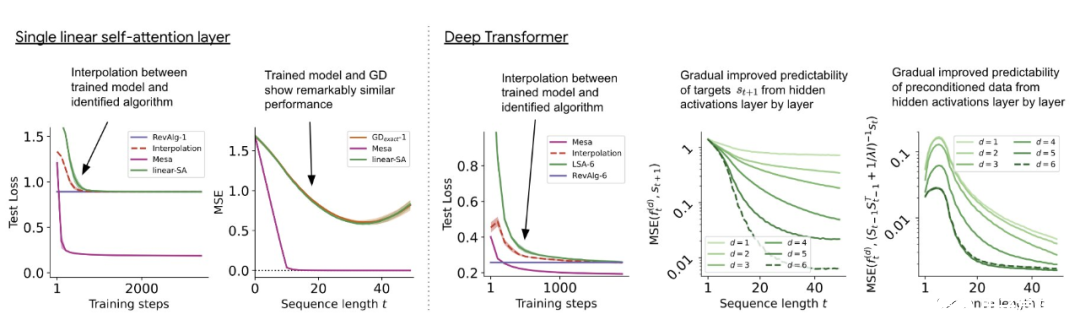

与单层模型一样,作者在训练模型的权重中看到了清晰的结构。作为第一个逆向工程分析,该研究利用这个结构并构建一个算法(RevAlg-d,其中 d 表示层数),每个层头包含 16 个参数(而不是 3200 个)。作者发现这种压缩但复杂的表达式可以描述经过训练的模型。特别是,它允许以几乎无损的方式在实际 Transformer 和 RevAlg-d 权重之间进行插值。 虽然 RevAlg-d 表达式解释了具有少量自由参数的经过训练的多层 Transformer,但很难将其解释为 mesa 优化算法。因此,作者采用线性回归探测分析(Alain & Bengio,2017;Akyürek et al.,2023)来寻找假设的 mesa 优化算法的特征。 在图 3 所示的深度线性自注意力 Transformer 上,我们可以看到两个探针都可以线性解码,解码性能随着序列长度和网络深度的增加而增加。因此,基础优化发现了一种混合算法,该算法在原始 mesa-objective Lt (W) 的基础上逐层下降,同时改进 mesa 优化问题的条件数。这导致 mesa-objective Lt (W) 快速下降。此外可以看到性能随着深度的增加而显着提高。 因此可以认为自回归 mesa-objective Lt (W) 的快速下降是通过对更好的预处理数据进行逐步(跨层)mesa 优化来实现的。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

人工智能

+关注

关注

1813文章

49742浏览量

261581 -

深度学习

+关注

关注

73文章

5591浏览量

123912 -

DeepMind

+关注

关注

0文章

131浏览量

12135 -

Transformer

+关注

关注

0文章

154浏览量

6818 -

大模型

+关注

关注

2文章

3444浏览量

4970

原文标题:Transformer的上下文学习能力是哪来的?

文章出处:【微信号:tyutcsplab,微信公众号:智能感知与物联网技术研究所】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

热点推荐

大语言模型如何处理上下文窗口中的输入

本博客介绍了五个基本概念,阐述了大语言模型如何处理上下文窗口中的输入。通过明确的例子和实践中获得的见解,本文介绍了多个与上下文窗口有关的基本概念,如词元化、序列长度和注意力等。

Transformer如何让自动驾驶变得更聪明?

]自动驾驶中常提的Transformer本质上是一种神经网络结构,最早在自然语言处理里火起来。与卷积神经网络(CNN)或循环神经网络(RNN)不同,Transformer能够自动审视所有输入信息,并动态判断哪些部分更为关键,同时可以将这些重要信息有效地关联起来。

请问riscv中断还需要软件保存上下文和恢复吗?

以下是我拷贝的文档里的说明,这个中断处理还需要软件来写上下文保存和恢复,在使用ARM核的单片机都不需要考虑这些的,使用过的小伙伴能解答吗?

3.8. 进出中断的上下文保存和恢复

RISC-V架构

发表于 10-20 09:56

【「AI芯片:科技探索与AGI愿景」阅读体验】+第二章 实现深度学习AI芯片的创新方法与架构

彻底改变了自然语义处理的研究和应用。它引入了自注意机制和位置编码,能够有效的捕捉输入序列中的关联信息,实现更好的上下文理解和建模。

Transformer 模型由一个编码器和一个解码器组成,是一种

发表于 09-12 17:30

自动驾驶中Transformer大模型会取代深度学习吗?

[首发于智驾最前沿微信公众号]近年来,随着ChatGPT、Claude、文心一言等大语言模型在生成文本、对话交互等领域的惊艳表现,“Transformer架构是否正在取代传统深度学习”这一话题一直被

鸿蒙NEXT-API19获取上下文,在class中和ability中获取上下文,API迁移示例-解决无法在EntryAbility中无法使用最新版

摘要:随着鸿蒙系统API升级至16版本(modelVersion5.1.1),多项API已废弃。获取上下文需使用UIContext,具体方法包括:在组件中使用getUIContext(),在类中使

Transformer架构中编码器的工作流程

编码器是Transformer体系结构的基本组件。编码器的主要功能是将输入标记转换为上下文表示。与早期独立处理token的模型不同,Transformer编码器根据整个序列捕获每个token的

Transformer架构概述

由于Transformer模型的出现和快速发展,深度学习领域正在经历一场翻天覆地的变化。这些突破性的架构不仅重新定义了自然语言处理(NLP)的标准,而且拓宽了视野,彻底改变了AI的许多方面。

快手上线鸿蒙应用高性能解决方案:数据反序列化性能提升90%

近日,快手在Gitee平台上线了鸿蒙应用性能优化解决方案“QuickTransformer”,该方案针对鸿蒙应用开发中广泛使用的三方库“class-transformer”进行了深度优化,有效提升

发表于 05-15 10:01

如何应对边缘设备上部署GenAI的挑战

过去十年间,人工智能(AI)和机器学习(ML)领域发生了巨大的变化。卷积神经网络(CNN)和循环神经网络(RNN)逐渐被Transformer和生成式人工智能(GenAI)所取代,这标志着该领域进入了一个全新的发展阶段。这一转变源于人们需要更准确、高效且具备

S32K在AUTOSAR中使用CAT1 ISR,是否需要执行上下文切换?

如果我们在 AUTOSAR 中使用 CAT1 ISR,是否需要执行上下文切换?另外,是否需要返回指令才能跳回到作系统?您有没有带有 CAT1 ISR 的 S32K3x4 微控制器的示例?

发表于 03-27 07:34

DeepSeek推出NSA机制,加速长上下文训练与推理

的特性,专为超快速的长上下文训练和推理而设计。 NSA通过针对现代硬件的优化设计,显著加快了推理速度,并大幅度降低了预训练成本,同时保持了卓越的性能表现。这一机制在确保效率的同时,并未牺牲模型的准确性或功能。 在广泛的基准测试、涉及长上

如何使用MATLAB构建Transformer模型

Transformer 模型在 2017 年由 Vaswani 等人在论文《Attentionis All You Need》中首次提出。其设计初衷是为了解决自然语言处理(Nature

transformer专用ASIC芯片Sohu说明

2022年,我们打赌说transformer会统治世界。 我们花了两年时间打造Sohu,这是世界上第一个用于transformer(ChatGPT中的“T”)的专用芯片。 将transformer

《具身智能机器人系统》第7-9章阅读心得之具身智能机器人与大模型

方法

元学习+GPICL方法

零样本能力

提供高性能,无需任务特定微调即可推广到新任务。

零样本性能较差,专注于通过上下文学习适应任务。

可

发表于 12-24 15:03

为什么transformer性能这么好?Transformer的上下文学习能力是哪来的?

为什么transformer性能这么好?Transformer的上下文学习能力是哪来的?

评论