最近,总部位于旧金山的人工智能初创公司 Inflection AI 在新一轮融资中筹集了 13 亿美元,投资方包括微软、英伟达和谷歌前首席执行官埃里克·施密特,这笔资金将支持 Inflection AI 的首款产品——名为Pi (Personal A.I)的个人助理和伴侣的进一步开发,该产品于 5 月推出。

此次融资使 Inflection 筹集的资金总额达到 15 亿美元。该公司此前曾于 2022 年初从部分投资者那里筹集了 2.25 亿美元,其中包括前 Meta 首席技术官 Mike “Schrep” Schroepfer、Google DeepMind 联合创始人兼首席执行官 Demis Hassabis 以及流行艺术家Will.i.am。

Inflection 的目标是打造一种通用的人工智能数字助理。包括盖茨在内的许多技术专家将这种助手视为所有人机交互的未来。

盖茨在高盛表示:“无论谁赢得personal agent,这都是一件大事,因为你将永远不会再去搜索网站,你永远不会再去生产力网站,你永远不会再去亚马逊。” 就在几周前,盖茨参与了另一家“独角兽”,即估值超过 10 亿美元的人工智能初创公司的融资,加入了一群著名投资者的行列,向矿业初创公司KoBold Metals 注入资金。

Inflection 新一轮融资的规模反映出投资者对开创生成式 AI 的初创公司的热情高涨,尤其是那些创建底层大语言模型 (LLM) 的公司,这些公司是当前 AI 热潮的核心。近几个月来,Cohere、Anthropic 和 Runway 等初创公司已宣布完成数亿美元的融资。但 Inflection 的 10 亿多美元资金也反映出创建这些人工智能模型的巨额费用,这些模型必须在大型数据中心的昂贵的专用计算机芯片上进行训练。

英伟达创始人兼首席执行官黄仁勋在一份声明中表示:“人工智能革命的一个强大好处是能够使用自然的对话语言与超级计算机交互,以简化我们日常生活的各个方面。” “Inflection AI 的世界级团队正在帮助领导这项开创性的工作,部署 Nvidia AI 技术来开发、训练和部署大规模的生成式 AI 模型,从而实现令人惊叹的个人数字助理。”

Inflection AI 由首席执行官 Mustafa Suleyman 共同创立,他还于 2012 年与 Hassabis 一起帮助创建了高级人工智能研究实验室 DeepMind。谷歌于 2014 年以约 6.5 亿美元收购了 DeepMind。Suleyman因被多名员工指控欺凌而于 2019 年从 DeepMind 离职,但后来短暂返回公司,然后加入谷歌担任负责人工智能产品管理和政策的副总裁。随后他于 2022 年离开谷歌,加入风险投资公司Greylock Partners,Inflection AI 的孵化地。Greylock 合伙人 Reid Hoffman 是PayPal和LinkedIn的联合创始人,也是 OpenAI 的早期支持者,也是 Inflection 的联合创始人。

许多风险投资家预测人工智能个人助理将融入日常生活。Andreessen Horowitz 的亿万富翁创始人马克·安德森 (Marc Andreessen) 在一份 7000 字的宣言中写道,像 Pi 这样的聊天机器人有一天会普及到从创意艺术到政府的各个领域。

安德森在 6 月份写道:“每个人都会有一位人工智能助理/教练/导师/培训师/顾问/治疗师,他们具有无限的耐心、无限的同情心、无限的知识和无限的帮助。” “人工智能助手将伴随生活中所有的机遇和挑战,最大限度地提高每个人的成果。”

Inflection 的第一个产品是一个名为 Pi 的聊天机器人,它比这种精灵般的personal agent受到的限制要大得多。事实上,它比许多竞争的聊天机器人(例如 OpenAI 的 ChatGPT 和 Google 的 Bard)更加有限。Suleyman告诉《财富》杂志, Pi 的设计目的只是成为一个有同理心的倾听者和良好的对话者,而不是一个用于撰写研究报告、集思广益营销想法或编写软件代码的工具——所有这些任务都是聊天机器人可以执行的。

Suleyman在Collision 直播中表示:“我认为每个人的口袋里都会有一位知识渊博、友善、乐于助人且非常务实的参谋长。” “没有任何人可以在一次经历和一个人中同时完成所有这些技能......它将是参谋,它将是红颜知己,它将是参谋长,它将是教练,它将是教育家和教师,合二为一。”

“个人人工智能将成为我们一生中最具变革性的工具。这确实是一个拐点,”Suleyman指出。“我们很高兴能与 Nvidia、Microsoft 和 CoreWeave 以及 Eric、Bill 和其他许多人合作,将这一愿景变为现实。”

Inflection 表示,Pi 是“老师、教练、知己、创意合作伙伴和参谋”,其主要作用在于随时准备好与用户进行现场对话。

三位著名的创始人

Inflection AI 拥有三位著名的创始人,至少根据 Crunchbase 上的资料显示,还有第四位联合创始人,他似乎在人工智能领域的重要公司工作,但其网站上没有透露他的身份,就像他没有被确定为 OpenAI 的联合创始人成员之一一样。这个人—— Carlos Virella——没有太多的痕迹,据我们所知,可能是阿甘正传式的讽刺。但 Inflection AI 的其他三位创始人——其中一位也是 OpenAI 的联合创始人——被曝光。这三者都与 Web 2.0 初创社区息息相关,是十年前开始的人工智能革命的重要组成部分,两者的结合是 Inflection AI 推出名为 Pi 的个人人工智能服务的原因。

里德·霍夫曼 (Reid Hoffman) 是众所周知的 LinkedIn 企业网络联合创始人之一,当在线拍卖商 eBay 于 2002 年 8 月斥资 15 亿美元收购在线支付处理商 PayPal 时,他开始成为硅谷的一员。1998 年 12 月,一家名为 Confinity 的公司成立时,他担任该公司的董事,并于 2000 年 1 月被任命为执行副总裁,负责该公司的所有对外关系。三个月后,Confinity 与另一家名为 X.com 的公司合并。埃隆·马斯克 (Elon Musk) 是后者的联合创始人,彼得·蒂尔 (Peter Thiel) 是前者的联合创始人,2002 年 2 月,PayPal 上市,筹集了 6100 万美元,成为互联网泡沫破灭期间为数不多的亮点之一。因此,仅仅六个月后,eBay 就完成了收购。

2003 年 1 月,霍夫曼与他人共同创立了 LinkedIn,并担任董事长兼首席执行官,并开始运营其产品,并于 2009 年秋季成为 Greylock Partners 的合伙人。2016 年 6 月,微软斥资 262 亿美元收购 LinkedIn,霍夫曼是控股股东,他自己在这笔交易中赚取了 28.4 亿美元。霍夫曼现在仍在 Greylock,但他的个人资金以及微软联合创始人比尔·盖茨、前 Sun Microsystems 和谷歌高管埃里克·施密特、Nvidia 和微软以及小型 GPU 计算云构建专家CoreWeave的投资正在帮助资助 Inflection AI。霍夫曼是 OpenAI 和微软的董事会成员,由于与 Inflection AI 存在利益冲突,他于 3 月份辞去了 OpenAI 的职务。鉴于这家软件巨头与 OpenAI 的紧密合作关系,很难相信霍夫曼会在微软董事会任职更长时间,但话又说回来,微软正在投资 Inflection AI,作为一种对冲。因此,也许存在太多的利益冲突,它们就像双重否定一样相互抵消。

Inflection AI 首席科学家 Karén Simonyan 和首席执行官 Mustafa Suleyman 都是人工智能领域的长期研究人员,他们创建并出售了成功的公司。

Simonyan 于 2013 年在牛津大学创建了 VGGNet 图像处理框架,该框架通过一家名为 Vision Factory AI 的公司进行了商业化,并很快被一家名为 DeepMind Technologies 的神秘人工智能初创公司收购,Simonyan 成为该公司的首席研究科学家。DeepMind 成立于 2010 年 6 月,Suleyman 担任首席产品官,随后 Google 进入该领域,并在 DeepMind 收购 Vision Factory 后不久收购了 DeepMind。Facebook(当时还不叫 Meta Platforms)曾在 2013 年试图收购 DeepMind,谷歌为 DeepMind 的强化学习人工智能技术支付了 4 亿到 6.5 亿美元之间的费用。

如果你想追踪其中的联系,Suleyman 自 2022 年 1 月以来一直是 Greylock 的合作伙伴,很容易看出 Hoffman 和 Suleyman 在走廊里炮制了 Inflection AI。2022 年 5 月,当微软、霍夫曼、盖茨和施密特以及 Mike Schroepfer、Demis Hassabis、Will.i.am、Horizons Ventures 和 Dragoneer 共同投资时,Greylock 是 Inflection AI 筹集 2.25 亿美元资金时的主要投资者。6 月底,Inflection AI 筹集了第二笔 13 亿美元的资金,Nvidia 和 CoreWeave 成为新投资者。

人工智能正处于拐点

Inflection AI 的目标是让地球上的每个人都可以使用其 Pi(personal intelligence 的缩写)人工智能助手。考虑到运行LLM来回答愚蠢问题的高昂成本,计算这样的努力需要多少计算能力以及如何负担得起,这将是很有趣的。但暂时把它放在一边。

为了实现这一目标,Inflection AI 做了三件事:拥有懂得如何做人工智能的联合创始人、拥有大笔资金的联合创始人、拥有大笔资金的朋友以及有通过人工智能致富的雄心的联合创始人。因此,Inflection AI 建立了自己的 LLM(第一个迭代称为 Inflection-1),并且像 OpenAI 一样,将在必要的硬件上投入大量资金,以提高该模型的准确性并将其扩展到更大的数量。Pi 服务的用户数量。

考虑到用于训练LLM的计算引擎的高昂成本,这将需要大量资金。因此他们六月份大幅提升指出。

Inflection AI 与 Nvidia 和 CoreWeave 合作,在其 Inflection-1 LLM 上(跨越 3,500 个 Hopper GPU)在 11 分钟内运行了 MLPerf 参考训练基准。我们不知道有多少 GPU 用于训练支撑 Pi 服务的 Inflection-1 模型,但它的数量可能比这个还要多,而且如果我们不得不猜测的话,它可能使用 Nvidia“Ampere”A100 GPU 加速器。

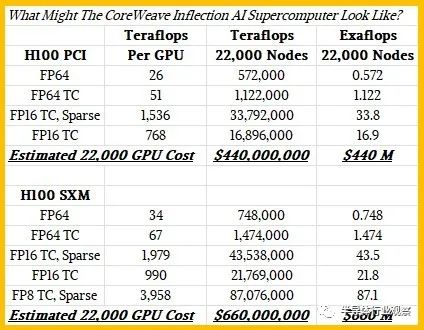

我们所知道的是,Nvidia 和 CoreWeave 正在合作在云中创建一个 AI 集群,该集群将拥有超过 22,000 个 H100 GPU 加速器,用于训练我们认为将是 Inflection-2 LLM 的人员。Inflection AI 宣称,这 22,000 个 H100 GPU 将“在 16 位精度调制解调器中提供惊人的 22 exaflops,如果使用较低的精度,甚至会更高”,并接着说,如果完成了高性能 Linpack (HPL) 矩阵数学测试放在上面,就像一台HPC超级计算机一样,它会在当前的Top500排行榜上排名第二,但在El Capitan和Aurora全面上线后可能会跌至第四。

如果您使用 Hopper PCI-Express 卡对 22,000 个 GOPU 加速器进行计算,超大规模提供商和云构建者通常使用这些卡来创建集群,而不是在四个或八个 GPU 的集群之间使用 NVLink Switch 互连的 HGX 式板并使用 Hopper GPU 的 SXM5 变体,然后在 Tensor Core 矩阵数学引擎上以 FP16 精度,在没有稀疏性支持的情况下获得 16.9 exaflops,在打开稀疏性支持的情况下获得 33.8 exaflops。您还可以使用 H100 上的 FP64 双精度矢量数学单元获得额定为 572 petaflops 的集群。这与 Inflection AI 在其公告中谈论的 FP16 精度的 22 exaflops 不符。

这就是有趣的地方。如果您对服务器机箱内将使用 NVLink Switch 互连的 22,000 个 H100 SXM5 GPU 加速器进行计算,那么您将得到一个集群,在 FP16 精度下,在未激活稀疏性的情况下,聚合峰值性能为 21.8 exaflops。(这可能会告诉您有关 Inflection-1 LLM 的一些信息,因为它可能不会使用大量稀疏数据。)这四舍五入为 Inflection AI 所说的 22 exaflops,这也产生了一台峰值为 748 petaflops 的超级计算机FP64 矢量性能和 1.47 exaflops(FP64 在 Tensor Cores 矩阵引擎上运行)。(据我们所知,没有很多 HPC 应用程序已移植到 Tensor Core。)

假设 Linpack 基准测试的计算效率为 65%,则该集群在 Top500 排名中的评级为 486 petaflops 左右,这将使其略高于日本 RIKEN 实验室“Fugaku”超级计算机的 442 petaflops 评级,后者在 2017 年排名第二。远低于目前排名第一的美国橡树岭国家实验室“Frontier”超级计算机 1.19 exaflops 的性能。阿贡国家实验室的“Aurora A21”系统预计将在今年晚些时候使用英特尔 CPU 和 GPU 交付时达到 2 exaflops 峰值,劳伦斯利弗莫尔国家实验室的“El Capitan”系统也将在今年晚些时候推出将远高于 2 exaflops 峰值。

这提出了一个重要的观点。对于要考虑将云计算机与本地计算机进行比较的情况,您必须让它始终为单个客户运行。我们认为 Inflection AI 机器也会出现这种情况,甚至有可能该公司会在其上运行 Linpack,只是为了表明自己的观点,并在 11 月份真正进入 Top500 榜单。但是,如果 Inflection AI 没有几乎连续地使用机器——我们想说的是绝对连续地使用机器,就像世界 HPC 实验室的机器一样,但也许说 75% 或 80% 的时间就足够了——那么它不应该被算作本身就是一台独特的机器。

这将我们引向下一点。如此大量的容量需要花费多少钱?让我们从使用 H100 PCI-Express 卡的集群开始尝试一下。假设这些 H100 PCI-Express 卡的价格约为 20,000 美元,按我们认为接近当前市场价格计算,即 4.4 亿美元。需要 2,750 个节点来容纳所有这些 GPU,每个机箱有 8 个。配备一对强大的 CPU、2 TB 内存和用于数据和操作系统存储的 34.5 TB NVM-Express 闪存(总共十个驱动器,两个用于操作系统的skinny驱动器),每个驱动器的运行成本可能约为 150,000 美元。另外还有 4.125 亿美元。正如 Nvidia 喜欢说的那样,InfiniBand 网络是另外 20%,即 2.13 亿美元,这使其达到 10.7 亿美元。

现在,让我们看看 SXM 设置。同样是 2,750 个节点,但这次 GPU 的成本可能约为 30,000 美元,因此 22,000 个节点的成本为 6.6 亿美元。这些节点在机箱内的 NVLink Switch 成本还有 25,000 美元左右,机箱外的 InfiniBand 成本也有 2.13 亿美元左右。现在您的资产达到 13.5 亿美元。这看起来就像 Inflection AI 正在讨论的使用 CoreWeave 和 Nvidia 构建的集群的场景。

这比美国政府为其百亿亿级超级计算机投入的资金要多得多,美国政府按标价计算的成本约为 5 亿至 6 亿美元,加上一次性工程 (NRE) 成本。

云开销(包括系统管理、房地产和电力成本)很容易再增加 2 亿美元,加上 CoreWeave 约 5% 的利润率,成本将增加至 16.3 亿美元。这略高于 Inflection AI 迄今为止从投资者那里筹集的 15.3 亿美元。幸运的是,有了云,它不必像巨大的预留实例那样一次性全部支付。或者,也许确实如此,这就是为什么价格不会高于这个。(你能想象为这样一个集群按需付费吗?)

Pi 订阅的价格是多少?需要有多少用户以及多快才能支付费用?比尔盖茨有足够的钱,不必关心,英伟达和微软也是如此。也许里德·霍夫曼也是。但您可以放心,所有这些数学计算都已完成。

-

人工智能

+关注

关注

1813文章

49734浏览量

261498 -

语言模型

+关注

关注

0文章

570浏览量

11254 -

英伟达

+关注

关注

23文章

4040浏览量

97664

原文标题:用22000个英伟达H100入局AI,初创企业的豪赌

文章出处:【微信号:semiwebs,微信公众号:芯通社】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

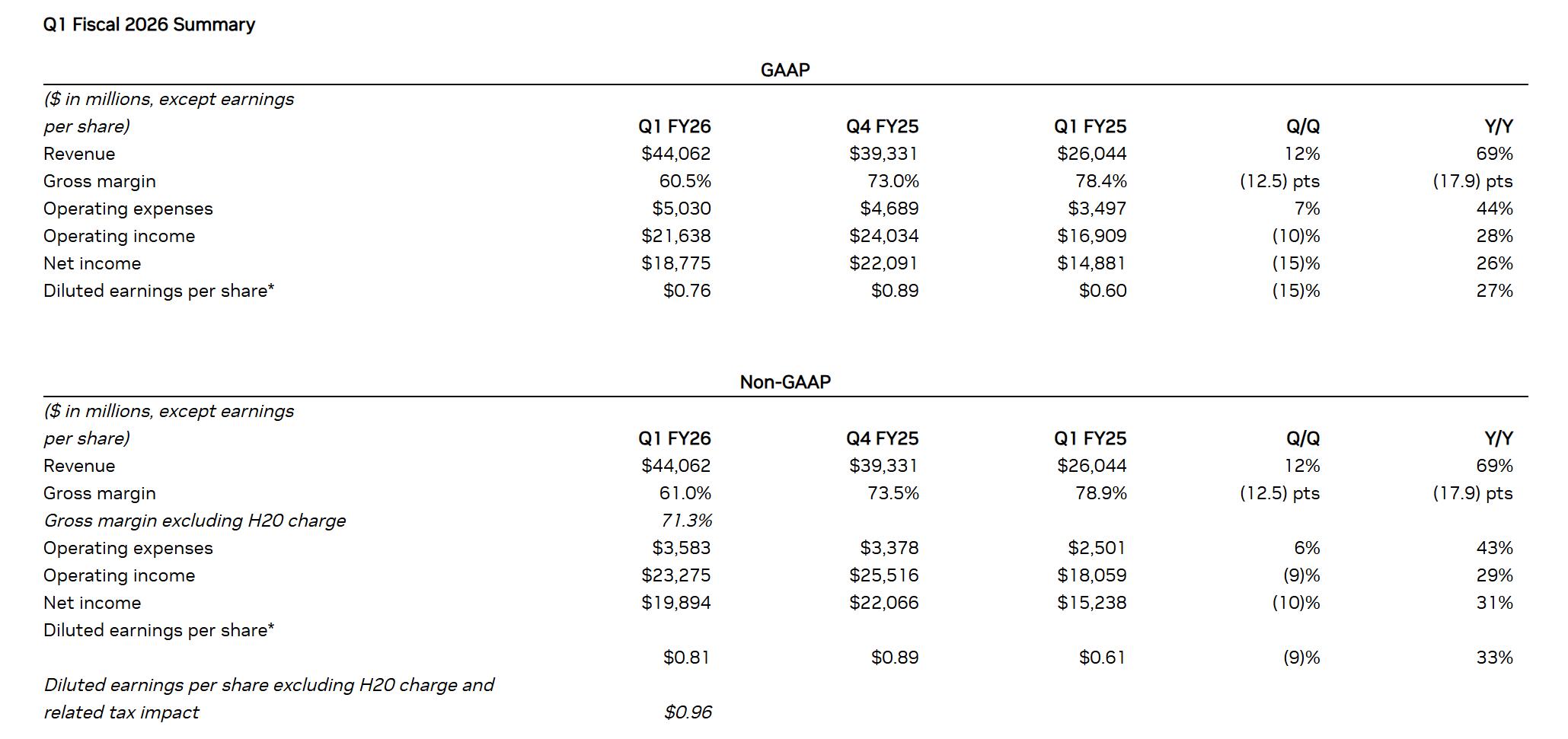

AI推理需求井喷!英伟达Q1营收大涨,H20禁售难挡增长步伐

传统眼镜企业入局AI眼镜,场景精准、生态协同加速落地潮

英伟达 Q3 狂揽 308 亿

英伟达 H100 GPU 掉卡?做好这五点,让算力稳如泰山!

英伟达被传暂停生产H20芯片 外交部回应

搞定英伟达 H100 ECC 报错:从原理到维修,一步到位解烦忧

H20中国区卖爆!英伟达紧急向台积电加订30万块

今日看点丨英伟达将为中国市场推出新AI芯片 售价大幅低于H20;中科曙光与海光信息宣布战略重组

GPU 维修干货 | 英伟达 GPU H100 常见故障有哪些?

用22000个英伟达H100入局AI,初创企业的豪赌

用22000个英伟达H100入局AI,初创企业的豪赌

评论