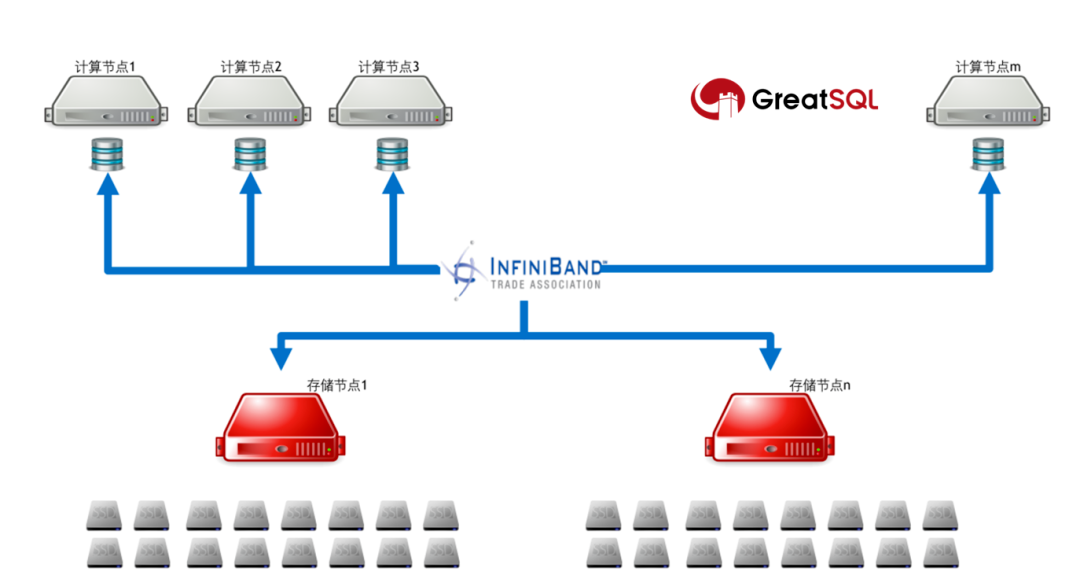

InfiniBand 是一种被目前各种追求高性能的应用广泛使用的网络互连技术,基于 IBTA(InfiniBand Trade Association)而定义的高带宽、低延时、低 CPU 利用率、大规模易扩展的通信技术。原生支持 RDMA 技术,在保证高带宽输出的基础上,大大降低数据访问延迟及通信过程中对于 CPU 资源的消耗,并支持各种先进的网络计算(In-Network Computing)技术,为高性能计算、人工智能、云计算、存储等众多数据密集型应用提供了强大的网络性能支撑。通过高速的 InfiniBand 技术,将业务负载由单机运行转化为基于多机协作的高性能计算集群,并使高性能集群的性能得以进一步地释放和优化。

GreatSQL 是由万里数据库维护的国内自主 MySQL 分支版本,专注于提升 MGR 可靠性及性能,支持 InnoDB 并行查询特性,适用金融级应用。

此次通过对比测试基于 InfiniBand 的 NVMe SSD 池化方案 及本地 NVMe SSD 的传统方案的性能表现,评估使用基于 InfiniBand 的存算分离架构对分布式数据库性能的提升程度及扩展性,经过双方合作,通过大量数据分析,可以看出基于 InfiniBand 池化方案的存算分离架构的性能更优稳定性更强,为 GreatSQL 进一步提升竞争力提供了有力的基础平台支撑。

1、NVIDIA InfiniBand 池化方案介绍

分布式数据库集群由两部分组成:

计算节点是无 SSD 盘的裸金属服务器,运行 MySQL 业务程序;

存储节点提供 NVMe SSD 资源池,通过软件聚合方式提供高性能 Lun 实现对于数据库的数据的存储服务。

两部分服务器通过 Quantum 平台的 InfiniBand 网络实现对计算节点和存储节点的无损连接,结合 NVMe-oF(NVMe over Fabric)高效的数据存储传输协议,将存储节点的 Lun 挂载到计算节点,实现结算节点本地高性能的数据存储能力。

2. 测试环境

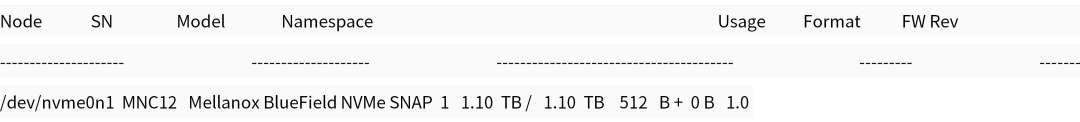

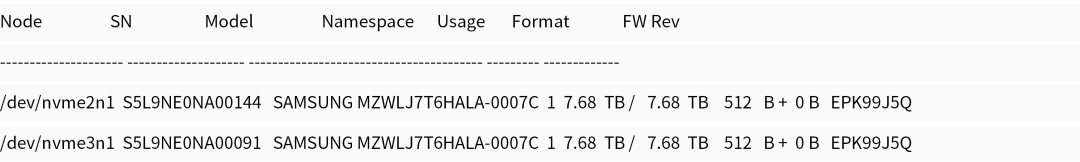

为了可以公平对比两种方案的优劣,两次测试均采用同一台计算服务器进行测试,不同的是,本地方案存储由本地的 PCIe4.0 NVMe SSD 承载,InfiniBand 池化方案由 100Gbps 速率的 HDR100 网卡接入,通过相同型号的 NVMe SSD 组成的全闪服务器借助 NVMe-oF 提供高性能虚拟 Lun 完成数据访问。

2.1 存储设备

InfiniBand 池化方案

本地 SSD

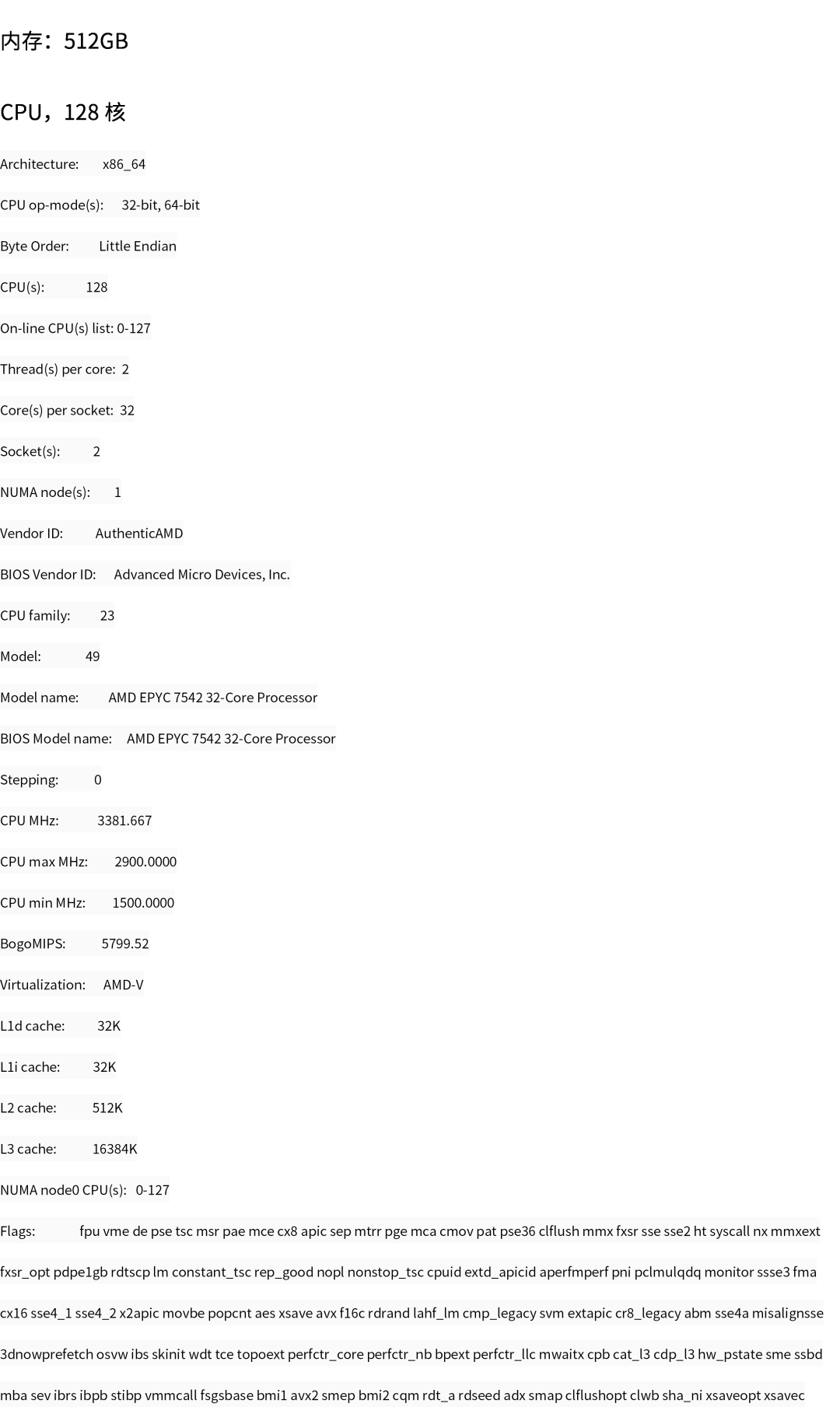

2.2 CPU&内存

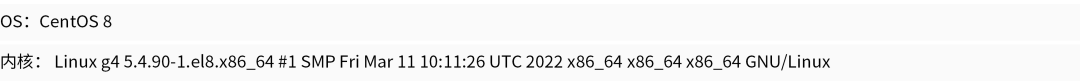

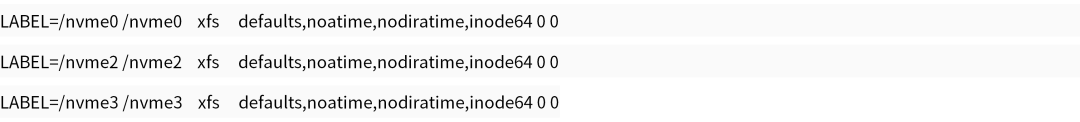

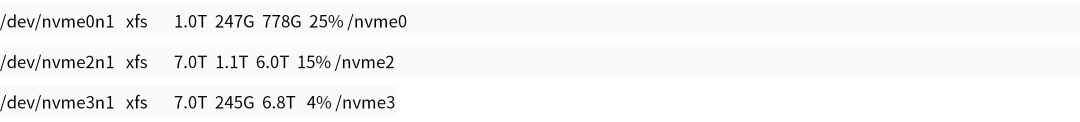

2.3 操作系统

文件系统

块设备

2.4 压测参数&指标

压测工具:sysbench

模式:oltp_read_write。

每轮压测时长:900 秒。

每轮压测休眠间隔:180 秒。

共 64 个表。

每个表 12500000 条记录。

整个测试库大小约 186 G。

采用InnoDB引擎。

并发线程数变化:8、16、32、64、128。

ibp(innodb buffer pool)变化:47G、93G、140G、186G(约为物理数据的25%、50%、75%、100%)。

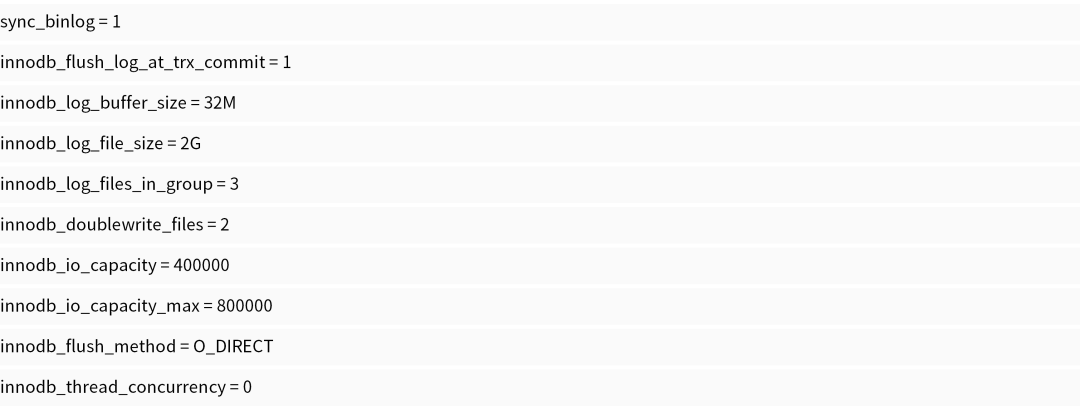

主要参数选项:

sysbench 测试命令模板:

3. 性能表现&总结

3.1 测试总结

结论先行,整体测试情况如下:

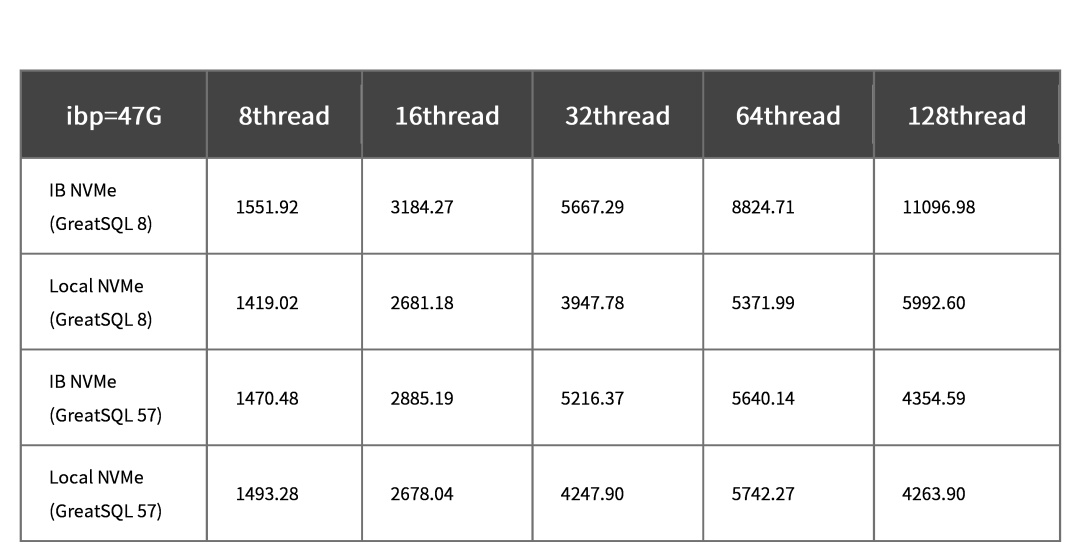

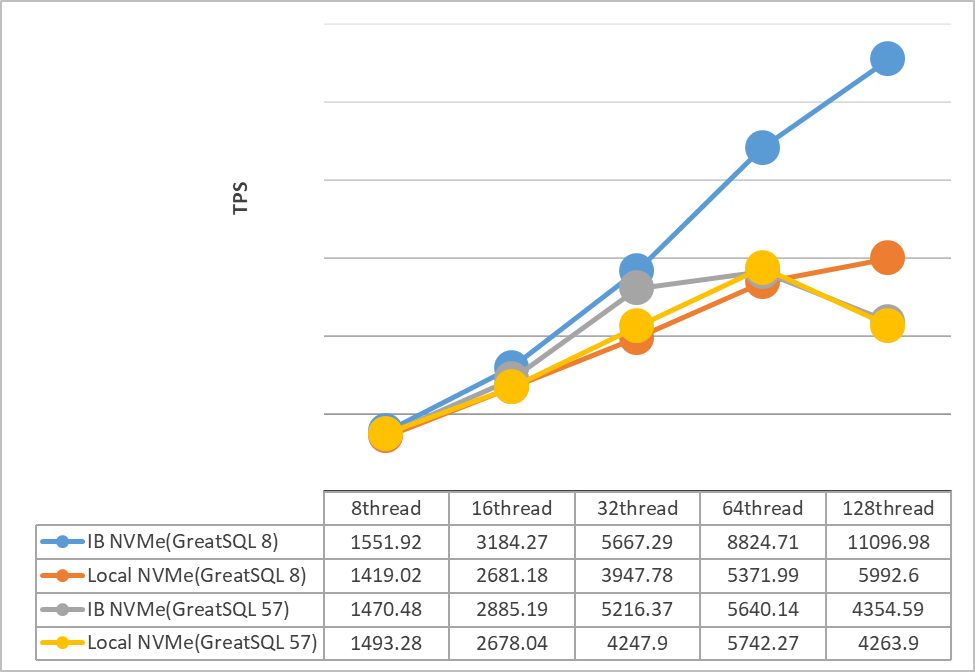

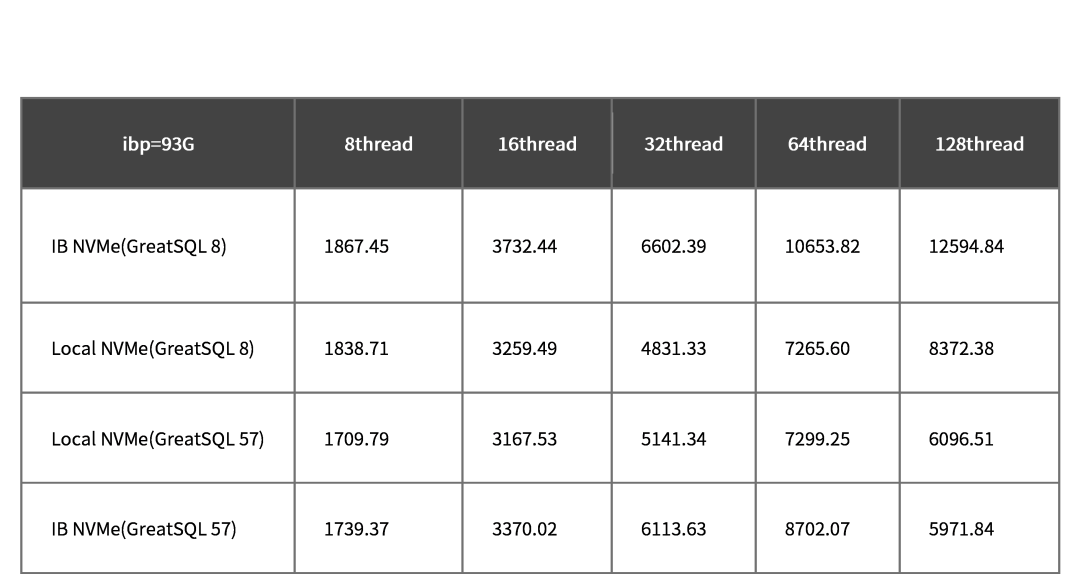

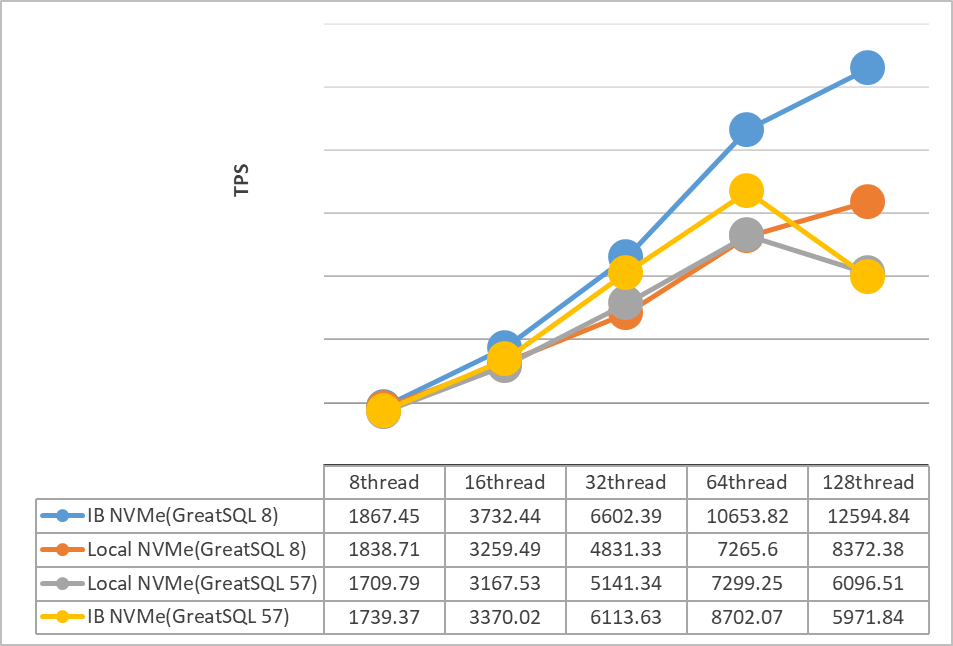

当ibp不足以覆盖全部物理数据时:

1)GreatSQL 8.x 性能远高于 GreatSQL 5.7。2)并发线程数越高,IB+NVMe SSD vs 本地NVMe SSD 的差距越小。3)ibp 越大,GreatSQL 5.7 和 8.0 性能越接近。

当 ibp 基本可以覆盖全部物理数据时:

1)GreatSQL 5.7 的性能整体比 GreatSQL 8.0 略好。

总的测试下来看,IB NVMe SSD 相比 本地 NVMe SSD 的性能要更好,也更稳定一些。

尝试对比测试了组提交(binlog group commit),在本案中对性能影响很小,这里不再赘述。

尝试对比设置 innodb_thread_concurrency = 64|128,发现加上后,在 ibp 足够大,且并发也打满 128 线程后,性能更稳定些,波动没那么大了,且最终整体性能也能提升约 8% ~ 10%(不过也要考虑到,真实生产环境中,很少会跑满这么大压力)。

总的来说,当物理内存不足以覆盖业务数据时(生成环境中这种情况很常见),如果单靠增加物理内存以提升数据库性能可能从性价比角度看并不划算,不如换个思路,提升本地物理 I/O 设备的性能,毕竟现在 NVMe SSD 的性能可以跑到很高。

3.2 测试数据对比图表

1)ibp=47G

2)ibp=93G

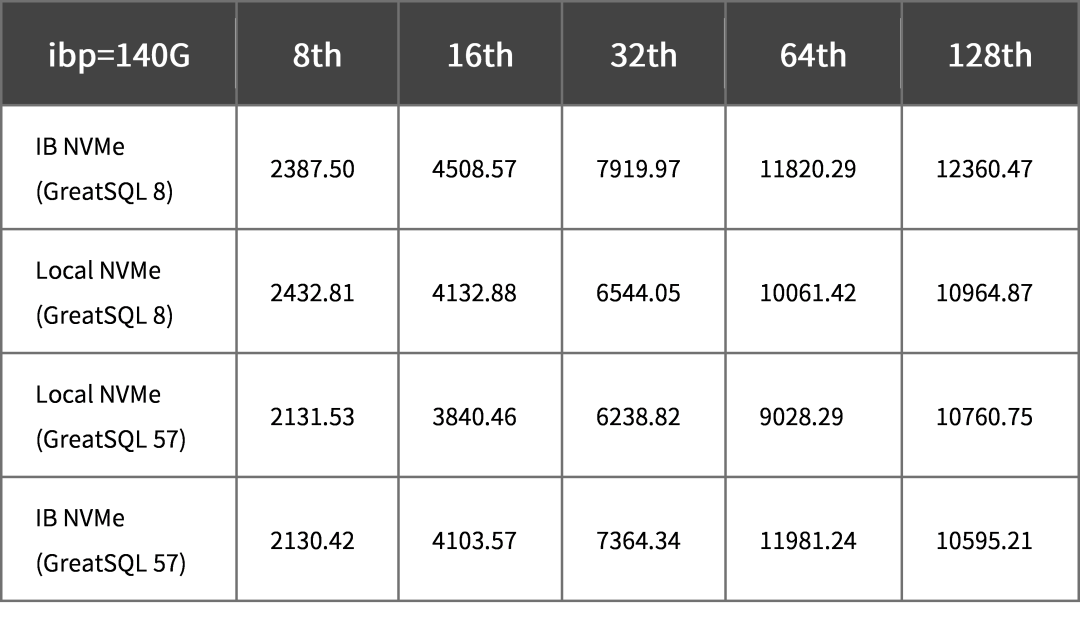

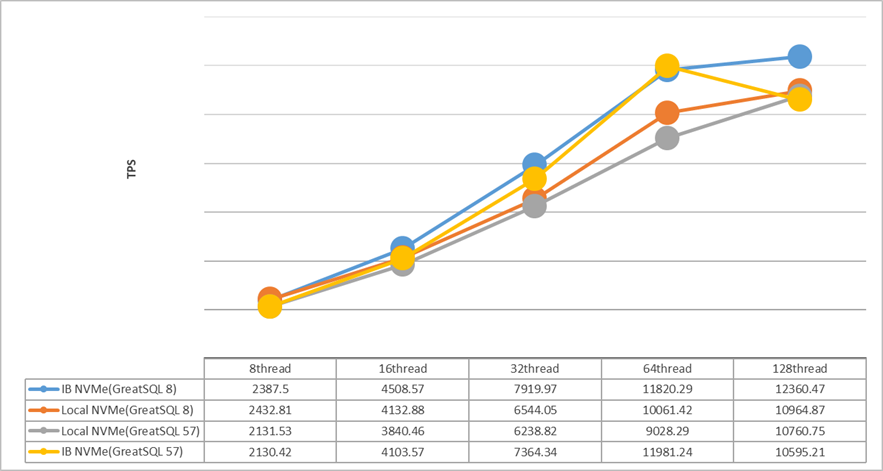

3)ibp=140G

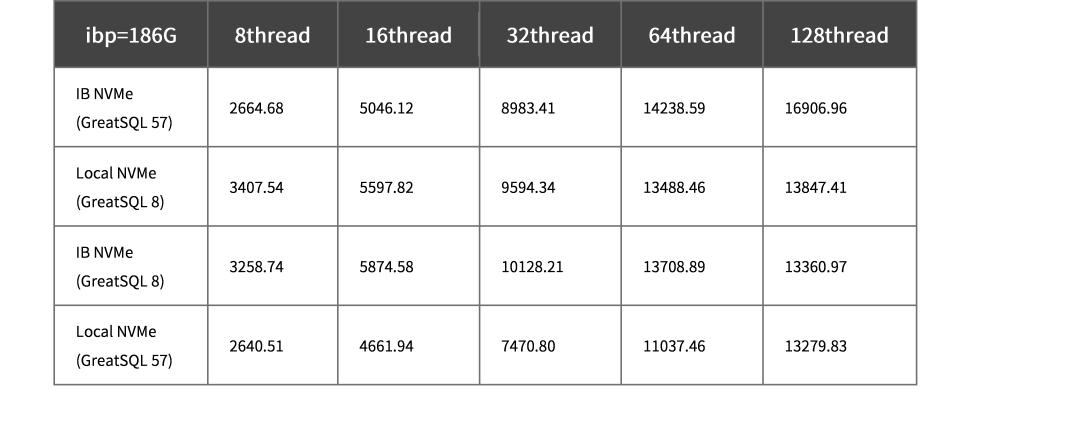

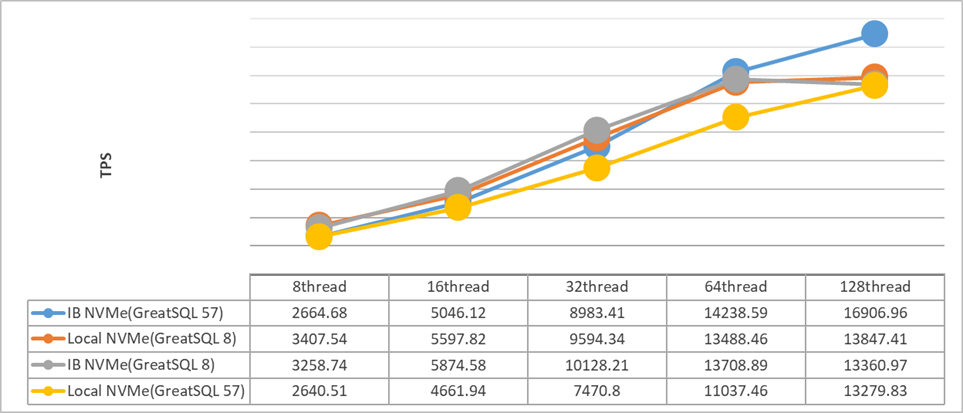

4)ibp=186G

4. 结语

从以上测试数据中,可以明显看到采用了 InfiniBand 池化方案数据库性能在不同场景中性能都有不同程度的明显提升,由其在高并发场景下,表现由于突出。

未来,万里数据库将推动 GreatSQL 协同 NVIDIA 探索更多基于 InfiniBand 在数据库中的结合点和创新点,基于 NVIDIA InfiniBand 打造数据库+网络软硬一体化联合解决方案,为用户创造更多价值。

-

数据

+关注

关注

8文章

7314浏览量

93970 -

SSD

+关注

关注

21文章

3061浏览量

121774 -

InfiniBand

+关注

关注

1文章

31浏览量

9534

原文标题:GreatSQL & NVIDIA InfiniBand NVMe SSD 存算分离池化方案:实现高性能分布式部署

文章出处:【微信号:NVIDIA_China,微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

基于 InfiniBand 的 NVMe SSD池化方案的性能表现

基于 InfiniBand 的 NVMe SSD池化方案的性能表现

评论