处理人工生成的文本数据一直是一项重要但具有挑战性的任务,因为人类语言对于机器理解往往具有自然的鲁棒性。

尽管如此,仍然有许多高效的 NLP 模型,例如 Google 的 BERT 和 Open AI 的 GPT2,它们的功能是通过高级处理和计算来理解这些数据。这些模型在搜索引擎中找到了它们的应用,因为搜索命令需要与相关的来源和页面匹配,而与术语的性质无关。

麻省理工学院的 SpAtten 学习系统通过其优化的软件硬件设计专注于高效的搜索预测,从而以更少的计算能力进行高级自然语言处理。因此,SpAtten 系统的架构取代了高端 CPU 和 GPU 的组合,它们共同输出类似于 MIT 的 SpAtten 学习系统的效率。

SpAtten 学习系统中的注意力机制

当数据量大时,注意力机制在自然语言处理中起着至关重要的作用。特别是在文本数据包含对建模可能不是很重要的各种特征的情况下。这可能会浪费系统的整体计算。因此,神经网络输入层中的注意力机制从文本数据中动态提取相关特征,可以优化算法在广泛数据集上的处理。

SpAtten 使用注意力机制算法去除在 NLP 方面权重较小的单词。因此,它有选择地从输入的文本数据中挑选出相关的关键词。这避免了对不必要的文本数据的实时处理,从而节省了系统的整体计算时间。然而,这种处理提供了效率和准确性,但它的代价是设计良好的硬件与这种复杂的算法兼容。

因此,麻省理工学院一直致力于其新 SpAtten 学习系统的软件和硬件方面。设计的硬件致力于优化这些复杂的算法,以减少处理和内存访问。这些技术在用于文本数据时克服了构建具有高效处理速度和能力的系统的挑战。因此,硬件“以更少的计算能力实现了精简的 NLP”。

SpAtten 架构的优化技术

循环和卷积神经网络被认为是深度学习模型的理想选择,但麻省理工学院关于“SpAtten: Efficient Sparse Attention Architecture with Cascade Token and Head Pruning”的研究论文让我们注意到注意力机制可以比这些网络表现更好,如前一部分所述。

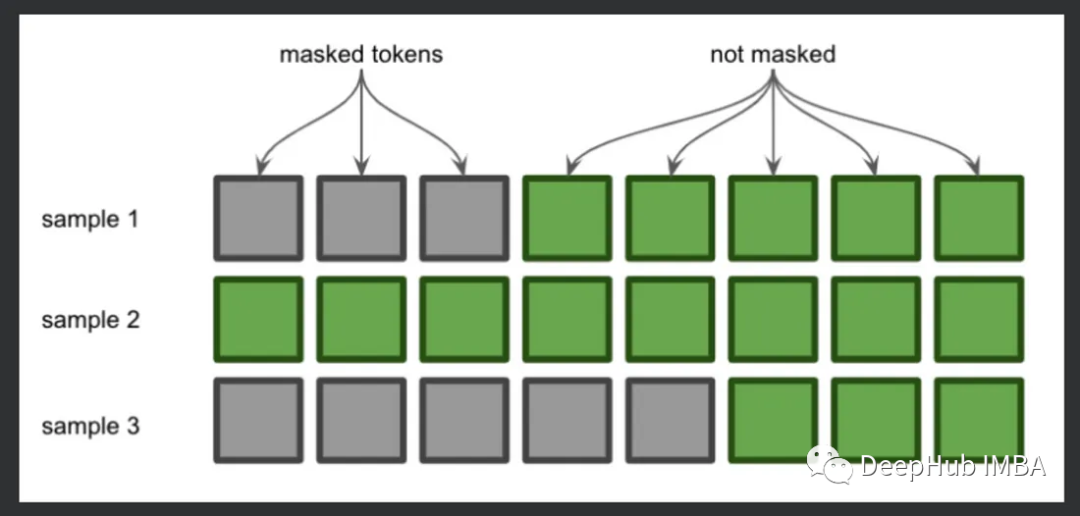

该架构支持级联修剪技术,该技术对令牌和头进行操作,而不是传统方法中使用的权重。正如术语“剪枝”暗示移除令牌一样,一旦从层中移除令牌/头,那么它将永远不会在后续层中被处理,因为它被永久“剪枝”或从系统中移除。这就是为什么优化数据的实时处理并且系统适应输入实例的原因。

该系统使用渐进式量化技术来减少 DRAM 访问。仅当 MSB 不足以执行量化时,该技术才对 LSB 起作用。然而,这是以计算为代价的,但内存访问显着减少。因此,它使注意力层动态和自适应以优化 DRAM 访问。该系统还带有内置的 SRAM,用于存储可在众多查询中重复使用的已删除令牌。

通用的 AI 加速器、GPU、TPU 和 NPU 即使支持高计算能力也无法实现这些技术,因为这些组件只能增强现有的传统神经网络,包括 CNN 和 RNN。因此,麻省理工学院设计了专门的硬件来实现这些优化算法。

SpAtten 学习系统的分析

SpAtten 硬件架构的模拟揭示了其与竞争处理器相比的高处理能力。麻省理工学院表示:“SpAtten 的运行速度比第二好的竞争对手(TITAN Xp GPU)快 100 倍以上。此外,SpAtten 的能源效率是其竞争对手的 1000 多倍,这表明 SpAtten 可以帮助减少 NLP 的大量电力需求。”

Google 的 BERT 和 Open AI 的 GPT2 模型也使用类似的注意力机制,但是复杂的判别和生成技术会导致延迟和延迟。MIT 的 SpAtten 是 NLP 算法和专用于注意力机制的专用硬件的组合。这种组合控制了标准 CPU 在 GPT-2 或 BERT 上运行时消耗的高功耗。

审核编辑:郭婷

-

处理器

+关注

关注

68文章

18261浏览量

222087 -

gpu

+关注

关注

27文章

4415浏览量

126650 -

深度学习

+关注

关注

73文章

5236浏览量

119899

发布评论请先 登录

相关推荐

Transformers的功能概述

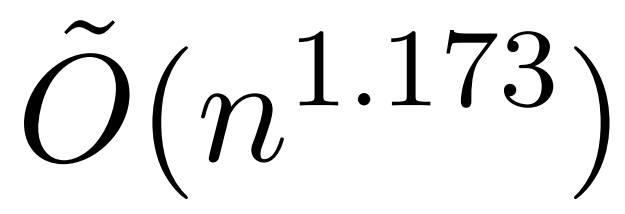

全新近似注意力机制HyperAttention:对长上下文友好、LLM推理提速50%

详细介绍注意力机制中的掩码

PyTorch教程-16.5。自然语言推理:使用注意力

PyTorch教程-11.5。多头注意力

PyTorch教程-11.6. 自注意力和位置编码

PyTorch教程-11.4. Bahdanau 注意力机制

基于YOLOv5s基础上实现五种视觉注意力模块的改进

一种新的深度注意力算法

详解五种即插即用的视觉注意力模块

MIT的SpAtten架构将注意力机制用于高级NLP

MIT的SpAtten架构将注意力机制用于高级NLP

评论