又到了一年的CES展会,除了应接不暇的创新消费科技产品以外,英特尔、英伟达与AMD的“蓝绿红”大战也是大家喜闻乐见的传统节目之一。那么三家半导体公司在今年开篇放出了哪些猛料呢?

AMD:首发Pluton硬件安全处理器

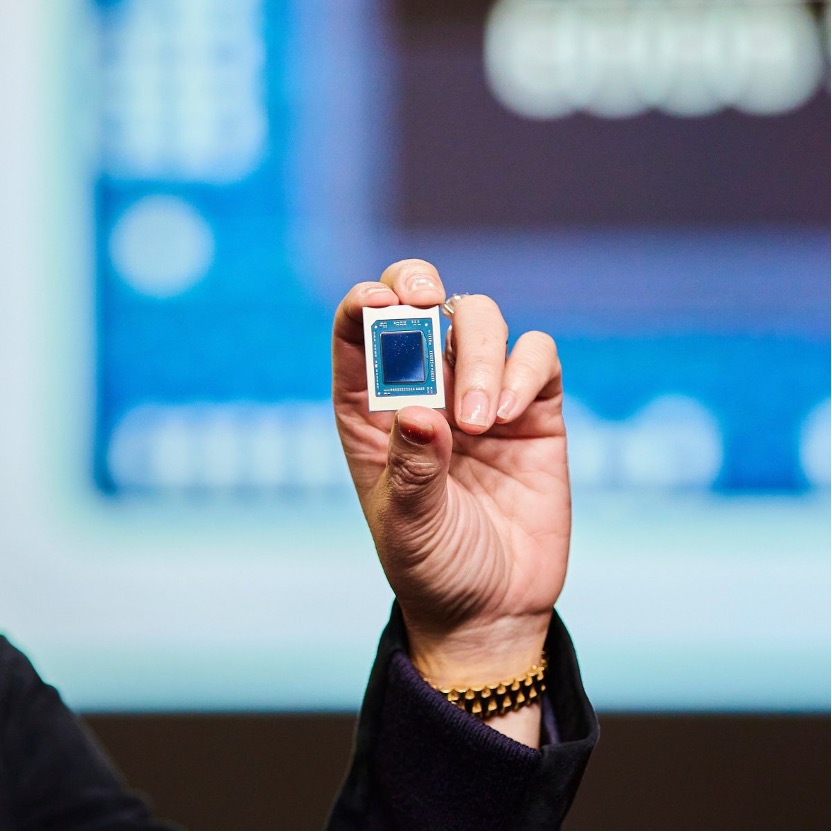

AMD在今年的CES 2022上发布了新一代移动处理器,Ryzen 6000。该系列APU采用了台积电6nm制程,集成了Zen 3+架构的CPU,和RDNA2架构的GPU。与上一代5000系列APU相比,处理性能最高提升了1.3倍。不过性能提升最大的还是GPU部分,Ryzen 6000系列集成了最多12个RNDA2 GPU核心,图形性能比上一代最高提升2倍。新的硬件平台还提供了DDR5、USB4和Wi-Fi 6E的支持,可以说在连接性上也实现了全面提升。搭载Ryzen 6000系列APU的笔记本也将在今年2月陆续开始面世。

这次发布的Ryzen移动处理器还首发集成了一个新的硬件安全单元,那就是微软的Pluton硬件安全处理器。类似于处理器的设计最初被微软用于Xbox游戏主机和Azure Sphere云服务器中,然而微软于2020年11月宣布了用于Windows的Pluton处理器,并声称会集成到AMD、英特尔和高通的处理器中,用于未来的Windows PC。如今随着AMD率先集成该处理器,说明相关的推广已经开始了,相信英特尔和高通的笔记本芯片也会马上跟进。

大家从去年的各大新闻中,也都知道了最新的Windows 11需要TPM这样的硬件安全模块。然而在微软看来,TPM这种位于CPU之外的安全硬件虽然抵御了十数年的攻击,但在如今创新的攻击下,也开始变得不安全起来。在可以物理接触到硬件的情况下,攻击者可以瞄准CPU和TPM之间的通信通道,也就是总线接口。

而Pluton处理器则是直接集成在CPU中,即便攻击者获得了硬件,也难以攻破。微软强调Pluton处理器可以采用三种配置:一是作为TPM,如此以来在Windows 11笔记本上就无需额外的TPM 2.0模块,直接用Pluton来保存Windows Hello等安全信息。另一种是作为非TPM的安全处理器,用于其他弹性的安全方案。最后,即便CPU已经集成了这一处理器,OEM也可以选择默认禁用。

上一次发布会中,AMD公布了他们最新的3D V-Cache技术,在CES 2022的发布会上,AMD终于公布了首发该技术的产品Ryzen 7 5800X3D,让我们一观该技术带来的性能提升。5800X3D在制程技术上还没有做到极致,采用的仍是台积电7nm计算Die+格芯12nm I/O Die的设计,但其L2+L3总缓存达到了惊人的100MB。值得一提的是,在96MB的L3总缓存中,只有64MB为3D V-Cache,剩下的32MB仍是2D cache。在不同的测试场景中,Ryzen 7 5800X3D与Ryzen 9 5900X相比有着10%到40%的提升。根据AMD进行的测试,5800X3D甚至可以在多数场景中,凭借8核超过刚发布不久的英特尔16核CPU i9-12900K。

AMD CEO苏姿丰还短暂提到了下一代Zen 4架构处理器,5nm、支持DDR5和PCIE 5.0均为已知的情报了。AMD目前已经拿到了基于Zen 4架构的Ryzen 7000系列CPU试产芯片,并声称在测试中收获了不错的结果,但正式发布还需要等到2022年下半年。

英伟达:入门与高端GPU两手抓

英伟达今年在CES上公布的硬件产品就没那么让人眼前一亮了,甚至可以说是两个极端,分别是一张甜品级显卡和一张核弹级显卡。

首先就是甜品级的RTX 3050显卡,该显卡的定位是以60 FPS运行市面上绝大多数作品。据英伟达透露,Geforce显卡的用户群体中,有75%仍在使用GTX显卡,尤其是GTX 1050和GTX 1060这样的入门显卡。这对于已经在此基础上更新两代的英伟达来说,明显不是一个很好的迭代进度。但考虑到目前已有的甜品级显卡RTX 3060依旧没有达到市场指导价,仍由于芯片短缺处于一个高溢价状态,于是英伟达决定用均价为249美元的RTX 3050继续推进RTX30系列的市场占有率。

而核弹级显卡为全新的RTX 3090Ti,据已知性能,这张卡像是RTX 3090的加强版。RTX 3080Ti的着色器性能为40TFlops,光线追踪性能为78TFlops,AI算力为320TFlops。这张卡显存容量与3090一样,仍然采用的是24GB的GDDR6X,只不过从原来的19.5Gbps提升至21Gbps。单从这些参数性能上来看,RTX 3090Ti的提升并不算很大,与RTX 3090相比提升幅度大约在10%左右,但是据业内人士透露。其功耗却达到了可怕的450W,不知道这是不是三星工艺的锅,但好在该显卡首次采用了单16pin的供电方式。

英特尔:PC与自动驾驶

英特尔首先发布了全新的i9-12900KS处理器,虽然核心数配置与i9-12900K一样,但前者最高可以提供5.5GHz的频率。不过该处理器仅供货给OEM,而不会直接售卖,估计将用于一些高端的整机产品。

此外,英特尔正式公布了第12代英特尔酷睿H系列移动CPU,该系列同样基于Intel 7制程打造,一共包含22款新CPU,功耗从35W到65W不等。旗舰产品i9 12900HK采用了6个性能核心和8个能效核心的设计,与上一代旗舰i9-11980HK相比,性能提升高达40%。英特尔酝酿已久的Arc显卡终于也宣布开始出货了,首批产品将用于合作OEM的高性能笔记本,预计2022年第一季度正式发售。

不只是CPU和GPU,英特尔也为旗下的Mobileye公布了一系列ADAS处理器EyeQ6L、EyeQ6H和EyeQ Ultra。EyeQ6L和EyeQ6H作为第六代EyeQ处理器,分别面向超低功耗和超高性能的ADAS场景。EyeQ6L将作为EyeQ4 SoC的替代,其封装大小却只有后者的55%,性能却足以驱动入门与高端的L2级ADAS应用。EyeQ6H则具备两个EyeQ5的性能,可用于支持L2+的ADAS功能。

EyeQ Ultra / Intel Mobileye

EyeQ Ultra基于第七代EyeQ架构,算力达到176TOPS和4.2TFLOPS。该处理器将集成12核24线程的CPU(RISC-V核心)、LDDR5x内存和更多的(64个)通用计算加速器与CNN加速器。EyeQ Ultra的性能可以满足L4自动驾驶的所有需求与应用,而不用担心使用多个SoC带来的能耗和成本。据Mobileye透露,EyeQ Ultra的目标是以5000到10000美元的系统成本和100W左右的总功耗,为未来的Robotaxi和消费车辆提供自动驾驶方案。

不过这两代处理器似乎并没有转向英特尔自己生产的意向,EyeQ6L和EyeQ6H仍将采用台积电的7nm制程,而EyeQ Ultra将用上台积电的5nm制程。其中EyeQ6L已于去年开始送样筛选,预计2023年中期开始量产,EyeQ6H将于今年开始送样,预计2024年末开始量产。至于最高端的EyeQ Ultra则要等到2023年底才会首次流片,全面车规级量产则要等到2025年,搭载该处理器的车型估计也要排到2025年之后。

AMD:首发Pluton硬件安全处理器

AMD在今年的CES 2022上发布了新一代移动处理器,Ryzen 6000。该系列APU采用了台积电6nm制程,集成了Zen 3+架构的CPU,和RDNA2架构的GPU。与上一代5000系列APU相比,处理性能最高提升了1.3倍。不过性能提升最大的还是GPU部分,Ryzen 6000系列集成了最多12个RNDA2 GPU核心,图形性能比上一代最高提升2倍。新的硬件平台还提供了DDR5、USB4和Wi-Fi 6E的支持,可以说在连接性上也实现了全面提升。搭载Ryzen 6000系列APU的笔记本也将在今年2月陆续开始面世。

Ryzen 6000系列APU / AMD

这次发布的Ryzen移动处理器还首发集成了一个新的硬件安全单元,那就是微软的Pluton硬件安全处理器。类似于处理器的设计最初被微软用于Xbox游戏主机和Azure Sphere云服务器中,然而微软于2020年11月宣布了用于Windows的Pluton处理器,并声称会集成到AMD、英特尔和高通的处理器中,用于未来的Windows PC。如今随着AMD率先集成该处理器,说明相关的推广已经开始了,相信英特尔和高通的笔记本芯片也会马上跟进。

大家从去年的各大新闻中,也都知道了最新的Windows 11需要TPM这样的硬件安全模块。然而在微软看来,TPM这种位于CPU之外的安全硬件虽然抵御了十数年的攻击,但在如今创新的攻击下,也开始变得不安全起来。在可以物理接触到硬件的情况下,攻击者可以瞄准CPU和TPM之间的通信通道,也就是总线接口。

而Pluton处理器则是直接集成在CPU中,即便攻击者获得了硬件,也难以攻破。微软强调Pluton处理器可以采用三种配置:一是作为TPM,如此以来在Windows 11笔记本上就无需额外的TPM 2.0模块,直接用Pluton来保存Windows Hello等安全信息。另一种是作为非TPM的安全处理器,用于其他弹性的安全方案。最后,即便CPU已经集成了这一处理器,OEM也可以选择默认禁用。

上一次发布会中,AMD公布了他们最新的3D V-Cache技术,在CES 2022的发布会上,AMD终于公布了首发该技术的产品Ryzen 7 5800X3D,让我们一观该技术带来的性能提升。5800X3D在制程技术上还没有做到极致,采用的仍是台积电7nm计算Die+格芯12nm I/O Die的设计,但其L2+L3总缓存达到了惊人的100MB。值得一提的是,在96MB的L3总缓存中,只有64MB为3D V-Cache,剩下的32MB仍是2D cache。在不同的测试场景中,Ryzen 7 5800X3D与Ryzen 9 5900X相比有着10%到40%的提升。根据AMD进行的测试,5800X3D甚至可以在多数场景中,凭借8核超过刚发布不久的英特尔16核CPU i9-12900K。

AMD CEO苏姿丰还短暂提到了下一代Zen 4架构处理器,5nm、支持DDR5和PCIE 5.0均为已知的情报了。AMD目前已经拿到了基于Zen 4架构的Ryzen 7000系列CPU试产芯片,并声称在测试中收获了不错的结果,但正式发布还需要等到2022年下半年。

英伟达:入门与高端GPU两手抓

英伟达今年在CES上公布的硬件产品就没那么让人眼前一亮了,甚至可以说是两个极端,分别是一张甜品级显卡和一张核弹级显卡。

首先就是甜品级的RTX 3050显卡,该显卡的定位是以60 FPS运行市面上绝大多数作品。据英伟达透露,Geforce显卡的用户群体中,有75%仍在使用GTX显卡,尤其是GTX 1050和GTX 1060这样的入门显卡。这对于已经在此基础上更新两代的英伟达来说,明显不是一个很好的迭代进度。但考虑到目前已有的甜品级显卡RTX 3060依旧没有达到市场指导价,仍由于芯片短缺处于一个高溢价状态,于是英伟达决定用均价为249美元的RTX 3050继续推进RTX30系列的市场占有率。

而核弹级显卡为全新的RTX 3090Ti,据已知性能,这张卡像是RTX 3090的加强版。RTX 3080Ti的着色器性能为40TFlops,光线追踪性能为78TFlops,AI算力为320TFlops。这张卡显存容量与3090一样,仍然采用的是24GB的GDDR6X,只不过从原来的19.5Gbps提升至21Gbps。单从这些参数性能上来看,RTX 3090Ti的提升并不算很大,与RTX 3090相比提升幅度大约在10%左右,但是据业内人士透露。其功耗却达到了可怕的450W,不知道这是不是三星工艺的锅,但好在该显卡首次采用了单16pin的供电方式。

英特尔:PC与自动驾驶

英特尔首先发布了全新的i9-12900KS处理器,虽然核心数配置与i9-12900K一样,但前者最高可以提供5.5GHz的频率。不过该处理器仅供货给OEM,而不会直接售卖,估计将用于一些高端的整机产品。

此外,英特尔正式公布了第12代英特尔酷睿H系列移动CPU,该系列同样基于Intel 7制程打造,一共包含22款新CPU,功耗从35W到65W不等。旗舰产品i9 12900HK采用了6个性能核心和8个能效核心的设计,与上一代旗舰i9-11980HK相比,性能提升高达40%。英特尔酝酿已久的Arc显卡终于也宣布开始出货了,首批产品将用于合作OEM的高性能笔记本,预计2022年第一季度正式发售。

不只是CPU和GPU,英特尔也为旗下的Mobileye公布了一系列ADAS处理器EyeQ6L、EyeQ6H和EyeQ Ultra。EyeQ6L和EyeQ6H作为第六代EyeQ处理器,分别面向超低功耗和超高性能的ADAS场景。EyeQ6L将作为EyeQ4 SoC的替代,其封装大小却只有后者的55%,性能却足以驱动入门与高端的L2级ADAS应用。EyeQ6H则具备两个EyeQ5的性能,可用于支持L2+的ADAS功能。

EyeQ Ultra / Intel Mobileye

EyeQ Ultra基于第七代EyeQ架构,算力达到176TOPS和4.2TFLOPS。该处理器将集成12核24线程的CPU(RISC-V核心)、LDDR5x内存和更多的(64个)通用计算加速器与CNN加速器。EyeQ Ultra的性能可以满足L4自动驾驶的所有需求与应用,而不用担心使用多个SoC带来的能耗和成本。据Mobileye透露,EyeQ Ultra的目标是以5000到10000美元的系统成本和100W左右的总功耗,为未来的Robotaxi和消费车辆提供自动驾驶方案。

不过这两代处理器似乎并没有转向英特尔自己生产的意向,EyeQ6L和EyeQ6H仍将采用台积电的7nm制程,而EyeQ Ultra将用上台积电的5nm制程。其中EyeQ6L已于去年开始送样筛选,预计2023年中期开始量产,EyeQ6H将于今年开始送样,预计2024年末开始量产。至于最高端的EyeQ Ultra则要等到2023年底才会首次流片,全面车规级量产则要等到2025年,搭载该处理器的车型估计也要排到2025年之后。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

amd

+关注

关注

25文章

5647浏览量

139022 -

NVIDIA

+关注

关注

14文章

5496浏览量

109091 -

intel

+关注

关注

19文章

3506浏览量

190570

发布评论请先 登录

相关推荐

热点推荐

从 CPU 到 GPU,渲染技术如何重塑游戏、影视与设计?

渲染技术是计算机图形学的核心内容之一,它是将三维场景转换为二维图像的过程。渲染技术一直在不断演进,从最初的CPU渲染到后来的GPU渲染,性能和质量都有了显著提升。从CPU到GPU:技术

aicube的n卡gpu索引该如何添加?

请问有人知道aicube怎样才能读取n卡的gpu索引呢,我已经安装了cuda和cudnn,在全局的py里添加了torch,能够调用gpu,当还是只能看到默认的gpu0,显示不了gpu1

发表于 07-25 08:18

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】+NVlink技术从应用到原理

前言

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」书中的芯片知识是比较接近当前的顶尖芯片水平的,同时包含了芯片架构的基础知识,但该部分知识比较晦涩难懂,或许是由于我一直从事的事芯片

发表于 06-18 19:31

无法在GPU上运行ONNX模型的Benchmark_app怎么解决?

在 CPU 和 GPU 上运行OpenVINO™ 2023.0 Benchmark_app推断的 ONNX 模型。

在 CPU 上推理成功,但在 GPU 上失败。

发表于 03-06 08:02

OpenVINO™检测到GPU,但网络无法加载到GPU插件,为什么?

OpenVINO™安装在旧的 Windows 10 版本 Windows® 10 (RS1) 上。

已安装 GPU 驱动程序版本 25.20.100.6373,检测到 GPU,但网络无法加载

发表于 03-05 06:01

GPU加速计算平台的优势

传统的CPU虽然在日常计算任务中表现出色,但在面对大规模并行计算需求时,其性能往往捉襟见肘。而GPU加速计算平台凭借其独特的优势,吸引了行业内人士的广泛关注和应用。下面,AI部落小编为大家分享GPU加速计算平台的优势。

从CPU到GPU:渲染技术的演进和趋势

渲染技术是计算机图形学的核心内容之一,它是将三维场景转换为二维图像的过程。渲染技术一直在不断演进,从最初的CPU渲染到后来的GPU渲染,性能和质量都有了显著提升。一、从CPU到GPU:

GPU渲染才是大势所趋?CPU渲染与GPU渲染的现状与未来

在3D建模和渲染领域,随着技术的发展,CPU渲染和GPU渲染这两种方法逐渐呈现出各自独特的优势,并且在不同的应用场景中各有侧重。尽管当前我们处在一个CPU渲染和GPU渲染并行发展的时代

fpga和cpu的区别 芯片是gpu还是CPU

一、FPGA与CPU的区别 FPGA(Field-Programmable Gate Array,现场可编程门阵列)和CPU(Central Processing Unit,中央处理器)是两种不同类

2024年GPU出货量增长显著,超越CPU

6%的同比增长,总量超过2.51亿颗,这一数据不仅彰显了GPU市场的繁荣,也反映了当前市场对于图形处理能力的巨大需求。 尤为值得一提的是,与同样作为计算机核心部件的CPU相比,GPU在2024年的出货量上占据了明显优势。据JPR

FPGA+GPU+CPU国产化人工智能平台

平台采用国产化FPGA+GPU+CPU构建嵌入式多核异构智算终端,可形成FPGA+GPU、FPGA+CPU、CPU+FPGA等组合模式,形成低功耗、高可扩展性的硬件系统,结合使用场景灵

ASIC和GPU的原理和优势

芯片”。 准确来说,除了它俩,计算芯片还包括大家更熟悉的CPU,以及FPGA。 行业里,通常会把半导体芯片分为数字芯片和模拟芯片。其中,数字芯片的市场规模占比较大,达到70%左右。 数字芯片,还可以进一步细分,分为:逻辑芯片、存储芯片以及微控制单元(MCU)。CPU、

CES开年大戏,GPU和CPU硝烟再起

CES开年大戏,GPU和CPU硝烟再起

评论