12月1日消息,据国外媒体报道,出于软硬件整合、向消费者提供更好体验、推出更好服务等方面的考虑,越来越多的厂商在研发芯片,人工智能方面较为明显,SK电讯就已推出了自研AI芯片SAPEON X220。

SK电讯目前已在官网公布了自研AI芯片SAPEON X220的消息,官网的信息显示,这一自研AI芯片SAPEON X220经过优化设计,用于更快的处理人工智能任务,通过高效的并行处理大量数据来减少对电力的消耗。

从SK电讯官网公布的数据来看,SAPEON X220深度学习计算速度为每秒6.7千帧,较AI服务公司目前广泛使用的GPU快1.5倍,同时对电力的消耗较AI服务公司常用的GPU减少20%,成本也降低了50%。

SK电讯方面还表示,他们自研的SAPEON X220 AI芯片,将通过对大量数据的快速计算来提高AI数据中心的性能,从而提供高质量的AI服务。

SAPEON X220 AI芯片很快就将在SK电讯相关的业务中应用,他们在官网上表示,从明年开始,SAPEON X220就将用于SK电讯的AI服务NUGU,改善语音识别能力。除了AI服务NUGU,SAPEON X220 AI芯片也将用于SK电讯旗下的其他公司。

责任编辑:PSY

-

gpu

+关注

关注

28文章

5099浏览量

134468 -

SK海力士

+关注

关注

0文章

1003浏览量

40991 -

深度学习

+关注

关注

73文章

5590浏览量

123912 -

AI芯片

+关注

关注

17文章

2065浏览量

36570

发布评论请先 登录

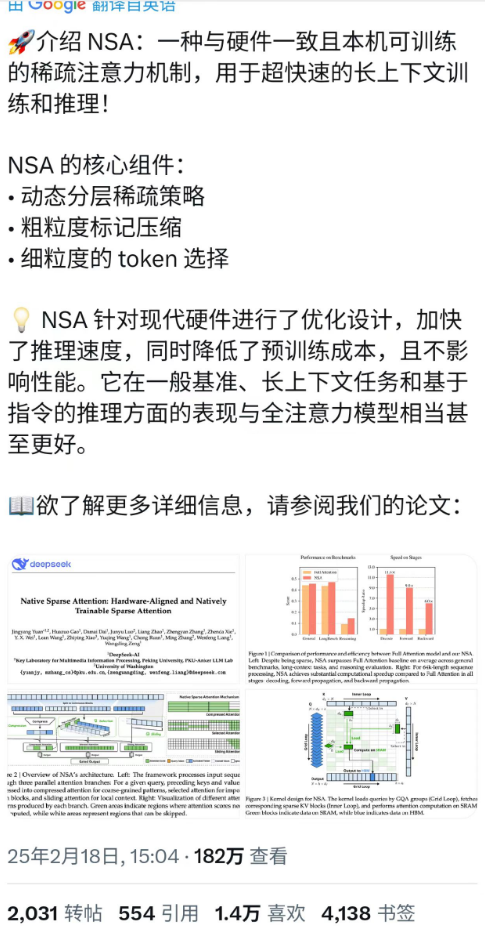

DeepSeek最新论文:训练速度提升9倍,推理速度快11倍!

为啥 AI 计算速度这么惊人?—— 聊聊 GPU、内存与并行计算

苹果AI革命:M5芯片10核GPU、AI处理速度翻倍,Apple Glass在路上

【「AI芯片:科技探索与AGI愿景」阅读体验】+神经形态计算、类脑芯片

【「AI芯片:科技探索与AGI愿景」阅读体验】+第二章 实现深度学习AI芯片的创新方法与架构

【「AI芯片:科技探索与AGI愿景」阅读体验】+AI芯片的需求和挑战

【「AI芯片:科技探索与AGI愿景」阅读体验】+内容总览

AI 芯片浪潮下,职场晋升新契机?

AI芯片:加速人工智能计算的专用硬件引擎

RK3588核心板在边缘AI计算中的颠覆性优势与场景落地

使用NVIDIA CUDA-X库加速科学和工程发展

在CM32M433R MCU上调用riscv_sqrt_f32()函数的计算速度比直接调用sqrtf()要慢,为什么?

FPGA+AI王炸组合如何重塑未来世界:看看DeepSeek东方神秘力量如何预测......

深度学习工作负载中GPU与LPU的主要差异

SK电讯已推出自研AI芯片SAPEON X220,深度学习计算速度提升GPU 1.5倍

SK电讯已推出自研AI芯片SAPEON X220,深度学习计算速度提升GPU 1.5倍

评论