人类驾驶与自主驾驶在对交通环境的理解方式上有着明显差别。首先,人主要通过视觉来理解交通场景,而机器感知需要融合多种异构的传感信息才能保证行车安全。其次,一个熟练的驾驶员可以轻松适应各种动态交通环境,但现有的机器感知系统却会经常输出有噪声的感知结果,而自主驾驶要求感知结果近乎100%准确。

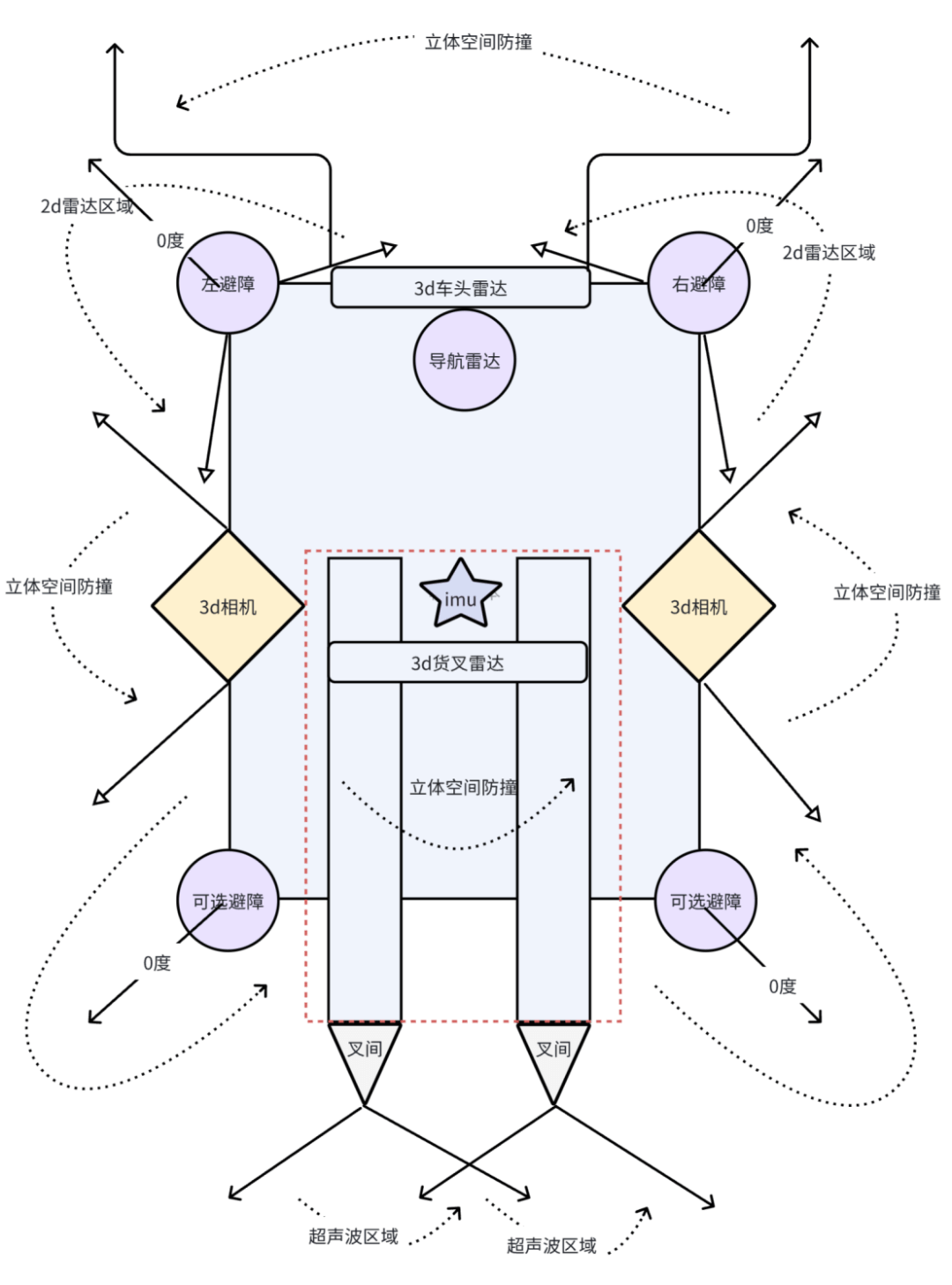

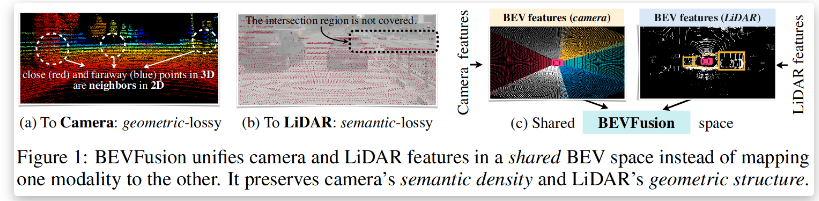

本文提出了一种用于无人车交通环境感知的视觉主导的多传感器融合计算框架,通过几何和语义约束融合来自相机、激光雷达(LIDAR)及地理信息系统(GIS)的信息,为无人车提供高精度的自主定位和准确鲁棒的障碍物感知,并进一步讨论了已成功集成到上述框架内的鲁棒的视觉算法,主要包括从训练数据收集、传感器数据处理、低级特征提取到障碍物识别和环境地图创建等多个层次的视觉算法。所提出的框架里已用于自主研发的无人车,并在各种真实城区环境中进行了长达八年的实地测试,实验结果验证了视觉主导的多传感融合感知框架的鲁棒性和高效性。

-

传感器

+关注

关注

2573文章

54369浏览量

786069 -

无人车

+关注

关注

1文章

316浏览量

37608

原文标题:无人车自主定位和障碍物感知的视觉主导多传感器融合方法

文章出处:【微信号:IV_Technology,微信公众号:智车科技】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

时识科技牵头制定动态视觉传感器性能测试方法国家标准

集成光传感器:工业智能时代的环境感知核心

离轴技术:赋能无人机精准配送的核心芯片应用

机器人竞技幕后:磁传感器芯片激活 “精准感知力”

AGV机器人如何实现毫秒级避障?深度解析多传感器融合的核心技术

【「# ROS 2智能机器人开发实践」阅读体验】视觉实现的基础算法的应用

融合视觉传感器厂商锐思智芯完成B轮融资

从安防到元宇宙:RK3588如何重塑视觉感知边界?

国内首颗车规级数字环境光传感器

BEVFusion —面向自动驾驶的多任务多传感器高效融合框架技术详解

用于无人车交通环境感知的视觉主导的多传感器融合计算框架

用于无人车交通环境感知的视觉主导的多传感器融合计算框架

评论