对于“未来的算法能与现有半导体芯片或正在开发之新运算架构契合”这件事,我们能抱持多大的信心?随着算法的进展速度超越硬件技术进展进步,甚至是最先进的深度学习模型都可以被布署于只要5美元的Raspberry Pi开发板。

在1980年代的处理器上执行目前最先进的算法,与在目前最先进的处理器上执行1980年代之算法,哪一种可以算得更快?答案令人惊讶,通常是在旧处理器上执行新算法能算得更快。虽然摩尔定律(Moore’s Law)因为是电子产业快速发展的驱动力而备受关注,但它只是驱动力的其中之一,我们经常忘记算法的进展速度其实在很多情况下都胜过摩尔定律。

根据德国柏林工业大学教授、知名数学家Martin Grötschel的观察,在1988年需要花费82年才能算出解答的一个线性程序设计问题,在2003年只需要1分钟就能解决;在这段时间,硬件的速度快了1,000倍,算法的进步则达到4万3,000倍。

美国麻省理工学院(MIT)教授Dimitris Bertsimas的类似研究结果显示,在1991年至2013年间,混合整数求解器(mixed integer solvers)算法速度快了58万倍,同时间顶尖超级计算机的硬件速度只有进步32万倍。据说类似的结果也发生在其他类型的约束优化(constrained optimization)问题和质因子分解(prime number factorization)问题中。

过去五年来,AI无论在学界、业界或是新创领域都呈现爆炸性发展,最大的转折点可能是发生在2012年,当时一个来自加拿大多伦多大学(University of Toronto)的团队AlexNet,利用深度学习方法一举赢得了年度计算机视觉影像辨识大赛ImageNet Large Scale Visual Recognition Challenge (ILSVRC)冠军,自此深度学习就成为实现AI的关键方程式。

计算机视觉的演进已蔓延至自然语言处理和其他AI领域。智能喇叭、实时计算机翻译、机器人对冲基金(robotic hedge funds),以及web参考引擎(web reference engines)…等等新产物,已经不会再让我们感到惊讶。

AI也成为了交通运输产业的驱动力(这也是Autotech Ventures的投资目标之一);我们已经观察到,先进驾驶辅助系统(ADAS)、自动驾驶、车队检测(fleet inspection)、制造质量控制,以及车载人机接口等等应用领域具备庞大的发展潜力。到目前为止,我们已经投资了几家在诸如ADAS、自动驾驶、视觉检测与边缘运算等应用领域开发AI解决方案的新创公司,在分析这些商机时,算法和硬件之间的交互作用是我们进行投资决策时的关键考虑因素之一。

大众对AI硬件的关注

基于深度学习的AI在其转折点之后,出现了对绘图处理器(GPU)的强劲需求。由于具备很强的平行运算能力,GPU对于深度学习算法所采用的逻辑碰巧能展现惊人效率;GPU大厂Nvidia在市场竞争中脱颖而出,其股价从2013年到2018年上涨了20倍。

当然,Nvidia竞争对手们正在努力追赶;高通(Qualcomm)、Arm和其他公司将注意力集中在AI芯片设计上,英特尔(Intel)则收购了AI芯片新创公司Nervana Systems。Google、Facebook、苹果(Apple)和亚马逊(Amazon)纷纷投入了为自家数据中心及其他计划开发自有AI处理器,也有一些新创公司(例如Graphcore、Mythic、Wave Computing、Cerebras和SambaNova)看准商机,试图设计更好的图灵机(Turing machine)系统。像D-wave Systems和IBM等其他一些公司也在积极探索后图灵时代的架构。大多数芯片开发的目标是赶上或超过Nvidia。然而,据我们所知,大多数处理器都是针对今日的AI算法进行设计。

尽管需要庞大的前期开发成本,我们仍将经历各种AI芯片设计的“寒武纪大爆发”。AI前景如此诱人,让产业玩家愿意投入巨资开发硬件,在以往是要让硬件与基础数学算法匹配,但对于让现有半导体芯片或正在开发的新运算架构能与未来的算法契合,我们有多大的信心?

有鉴于算法的演进速度和幅度变化是如此之快,许多AI芯片设计可能还没上市就过时了;我们推测明日的AI算法可能会需要完全不同的运算架构、内存资源,以及数据传输能力等等条件。

尽管深度学习框架已经出现很长一段时间,直到最近才真正被付诸实现,这要感谢摩尔定律所预测的硬件技术进展。最初的数学不一定是为工程实践而设计的,因为早期研究人员无法想象今日花1,000美元就能获得的运算能力有多么大。现今许多AI实作都是使用原始的数学模型,朝着准确、简单且更深层的方向发展,或者添加更多数据;但这样只会很快消耗GPU的运算容量。只有一小部分研究人员专注于改善基础数学和算法框架的难题。

还是有很多机会认识并利用这些新颖的数学进展,我们所观察到的方法包括精简冗余数学运算(redundant mathematical operations)而减少运算时间,将卷积压缩到较小的矩阵而减少内存需求,或者对加权矩阵进行二值化(binarize)而简化数学运算。这些是算法演进的第一次尝试,其发展之快已经开始超越硬件进展。

举例来说,从美国加州大学伯克利分校(UC Berkeley)研究项目独立的DeepScale ,就是将应用于ADAS和自动驾驶的AI,“塞进”车用芯片(不是GPU),与仅采用算法的物体检测模型相比较,他们的神经网络模型的指令周期要快30倍,同时在功耗和内存占用方面也有很大的提升,足以在这几年问世的现有硬件上执行。

另一个算法大跃进的案例来自美国的非营利研究机构艾伦人工智能研究所(Allen Institute of Artificial Intelligence),该机构研究人员采用一种利用神经网络二值化的创新数学方法,已经证明可以大幅提高速度,同时降低功耗和内存要求;如此甚至能让最先进的深度学习模型布署于售价仅5美元的Raspberry Pi平台上。研究人员最近将这种算法和处理工具独立为一家公司XNOR.ai,旨在于边缘设备布署AI,并进一步推动AI算法的进步。

有趣的是,新的二值化框架从根本上改变了最佳处理逻辑的类型,它们不再需要解决神经网络所需的32位浮点卷积,而只需要进行位计数运算(bit counting operations)——这将改变GPU领域的权力平衡。此外如果这些算法与专门设计的芯片相匹配,则可以进一步降低运算资源需求。

算法的进步不会停止;有时需要数年甚至数十年才能发明(或者说是发现)新的算法。这些突破无法以与摩尔定律推动的运算进展相同之方式来预测。它们本质上是非确定性的;但是当它们发生时,整个局势变化通常会让现有的主导者变成脆弱的猎物。

黑天鹅效应

畅销书《黑天鹅效应:如何及早发现最不可能发生但总是发生的事》(The Black Swan: The Impact of the Highly Improbable)的作者在书中阐明,最佳决策在很大程度上取决于分析过程是不可预测或不确定;换句话说,我们是在处理“已知的未知”(known unknowns)还是“未知的未知”(unknown unknowns)?算法创新基本上是未知的未知,因为它们的发现时间不确定以及影响不可预测,押注于这类发展需要持续的关注。

然而,在应用数学领域,尤其是AI应用领域,在最近二十年内出现了数次颠覆性的算法发现,它们与GPU一起,将AI从一个不起眼的研究领域带到了商业化最前线。

我们意识到这些运算领域“黑天鹅”的潜力,它们将使现有芯片架构成为过去,或者在一夜之间让它们的市场地位重新洗牌。对我们来说,这些「黑天鹅」最后可能会实现更安全的自动驾驶车辆,以及许多其他未知的应用案例。

-

人工智能

+关注

关注

1813文章

49734浏览量

261426 -

AI算法

+关注

关注

0文章

270浏览量

13055

原文标题:AI算法的进步速度远超硬件的摩尔定律

文章出处:【微信号:worldofai,微信公众号:worldofai】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

利用超微型 Neuton ML 模型解锁 SoC 边缘人工智能

国务院最新动向!中国首部“人工智能+”行动纲领出台意味着什么?

挖到宝了!人工智能综合实验箱,高校新工科的宝藏神器

挖到宝了!比邻星人工智能综合实验箱,高校新工科的宝藏神器!

超小型Neuton机器学习模型, 在任何系统级芯片(SoC)上解锁边缘人工智能应用.

最新人工智能硬件培训AI 基础入门学习课程参考2025版(大模型篇)

自动驾驶“单车智能”并不意味着不联网?

人工智能是做什么的

开售RK3576 高性能人工智能主板

AI人工智能隐私保护怎么样

智驭AI,赋能未来——首师大附中 香橙派人工智能课程开课了!

苹果软件更新默认启用人工智能

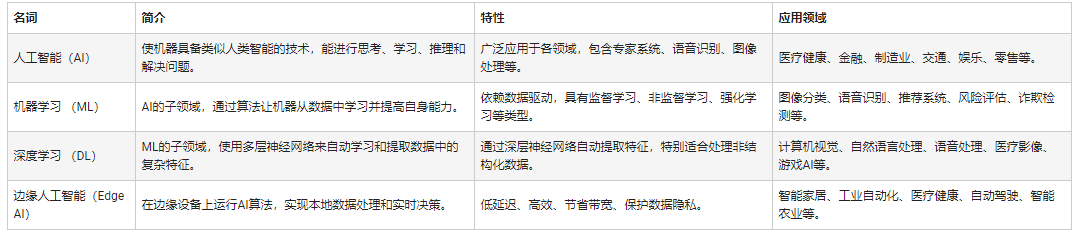

人工智能和机器学习以及Edge AI的概念与应用

人工智能推理及神经处理的未来

AI算法进步神速对人工智能意味着什么

AI算法进步神速对人工智能意味着什么

评论