大模型的快速发展正推动AI算力需求进入爆发式增长阶段。与此同时,不同应用场景又对AI芯片提出了多样化的挑战:例如在大模型Prefill场景,对算力要求更高,对内存带宽的要求则远低于Decode场景;大模型训练场景则不仅需要高算力与大容量内存,还需要更高的互连带宽与大规模集群组网能力。显然,单一的芯片架构已难以满足多元化的业务需求,为部署不同类型的业务,大模型应用厂商往往需要引入多种不同架构的AI芯片。因此造成的跨芯片架构间业务代码迁移与维护工作,尤其是算子迁移工作,往往耗时数月,成为业务迁移流程中的主要瓶颈。

针对行业痛点,北京智源人工智能研究院依托AI算法优化、芯片架构分析、编译器技术和分布式通信领域的多年积累,联手众多社区伙伴共同启动了众智FlagOS项目,旨在通过统一软件层解耦AI模型与异构硬件,打破不同架构芯片之间的软件生态壁垒,为芯片硬件与上层AI应用之间搭建统一且高效衔接的桥梁,系统性解决“适配难、调优慢、协同弱”三大行业难题,实现“一次开发,处处运行”,致力于为AI产业打造开放协同的创新技术底座。

从2024年初起,寒武纪和智源研究院开始进行FlagGems(基于Triton的高性能通用AI算子库)的联合开发工作,后续进一步拓展到FlagTree(统一多后端的增强版Triton编译器)、FlagCX(统一通信库)、FlagScale(并行训推一体框架)等组件。至2025年9月,寒武纪已经完成对FlagOS下各组件的适配和优化工作。随着智源研究院在“AICC2025暨首届FlagOS开放计算开发者大会”发布了FlagOS v1.5,寒武纪产品可通过众智大模型全栈生态基座支撑更广泛的生态伙伴。

寒武纪与FlagOS的适配与优化主要集中在算子、编译器、分布式通信库和并行框架组件等方面,以下将逐一介绍。

FlagGems

FlagGems是基于Triton语言实现的大模型算子库,目标是在多硬件后端上提供高性能的算子实现,并通过基准测试与自适应调优,持续优化性能表现。项目提供面向不同芯片厂商的后端适配机制、可配置的调优参数体系,以及完整的文档、测试与基准评测入口。

作为FlagOS生态的核心算子组件库,FlagGems以“高复用性、极致性能、架构通用性”为设计理念,通过标准化算子模块体系,大幅降低芯片厂商的算子开发与适配成本。作为首批深度参与FlagGems生态建设的芯片厂商,寒武纪全程投入算子适配与性能调优验证工作,目前已完成206/209个核心算子的全功能支持,平均性能提升达1.9倍,其中绝大部分算子性能达到原生算子的80%以上。寒武纪将持续探索性能优化边界,针对低效能的凹点算子展开专项攻坚,进一步消除性能瓶颈,实现全算子高性能覆盖。

FlagTree

FlagTree是一个面向多种AI芯片的开源统一编译器,致力于为多元化的AI硬件生态提供统一的编译、适配和优化能力。项目以Triton生态为基础,兼容现有主流AI芯片后端,统一代码仓库,并快速实现单仓库多后端支持,为上游模型开发者与下游芯片厂商的协作与创新提供了极大便利,可大幅提升开发效率,促进了Triton生态的繁荣和演进。

在寒武纪与FlagTree的深度合作中,寒武纪Triton已成功合并至FlagTree主代码仓库。基于FlagTree编译器与FlagGems算子库,寒武纪针对QWen3-8B大语言模型开展全链路适配验证:将模型中的37个核心算子(涵盖矩阵乘法matmul、层归一化layer_norm、注意力机制attention等关键计算单元)替换为FlagGems提供的Triton优化算子,在寒武纪芯片上进行推理性能测试,整网推理吞吐性能达到原生算子版本的80%,完全满足实时推理场景需求。

这一成果不仅验证了FlagTree+FlagGems技术栈的工程稳定性,更彰显了Triton框架两大核心优势:显著提升开发效率,算子迭代周期从传统的2周大幅缩短至3天;跨架构兼容性,为前沿LLM模型的快速工程化开辟了高效技术路径。

FlagCX

FlagCX是一款面向大规模AI训练的通信中间件,通过对底层硬件差异进行抽象,使开发者能够在异构硬件环境中无缝开展分布式训练,从而有效提升资源利用效率和训练性能。

FlagCX开源后,寒武纪即开始积极参与共建。从FlagCX v0.1.0版本开始,寒武纪就实现了绝大部分通信原语的支持,如今已完成对allreduce、reducescatter、allgather、send、recv等通信操作的全面支持。这种支持并非简单的接口对接,而是通过FlagCX统一适配器模块,实现了FlagCX与寒武纪原生CNCL通信库的高效、深度集成。

FlagCX通过其核心层(FlagCX Core)处理异构通信,同时通过适配器无缝兼容包括寒武纪CNCL在内的各大厂商同构通信库。这意味着,当用户在纯寒武纪MLU集群上进行同构训练时,FlagCX能够直接调用经过深度优化的CNCL库,确保通信性能与直接使用CNCL原生库基本持平,几乎无性能损耗。这种深度集成保障寒武纪用户在享受FlagCX统一接口便利性的同时,同样可以获得原生性能体验。

在寒武纪MLU与其他AI芯片的混合环境中,FlagCX成功保障混合训练的模型精度与纯MLU独立训练结果完全一致。更重要的是,在如此复杂的异构环境下,平均单卡吞吐量仍能达到MLU独立训练的99%以上。性能测试表明寒武纪MLU与FlagCX的结合,可以做到精度无损且性能和原生通信库持平的水平,为用户使用异构算力资源进行大模型训推提供了可靠的技术基础。

FlagScale

FlagScale是智源人工智能研究院主导开发的大模型全生命周期工具集,是FlagOS生态的核心组成部分,致力于构建覆盖模型开发、分布式训练与推理部署的统一技术体系。框架融合了Megatron-LM、vLLM、SGLang、Verl等主流开源项目,为大模型提供从训练到推理的一站式解决方案。

在与FlagScale的深度合作中,寒武纪基于MLU硬件平台完成了对Megatron-LM训练框架和vLLM推理框架的全面适配与优化。在训练环节,MLU平台已充分支持智源Megatron体系下的多类主流模型,包括Llama系列、Aquila2系列、Qwen3系列等,并覆盖从模型并行到混合精度的完整训练流程;在推理环节,MLU平台对vLLM框架实现了完备的兼容支持,可高效运行社区开源的多种大语言模型推理任务。

在完成框架级适配后,结合MLU架构特性,寒武纪还围绕通信、算子和内存调度进行了多层次性能优化。通过集成自研CNCL通信库、CNNL高性能算子库及混合精度算子调度机制,可显著提升分布式训练的通信效率与算力利用率;在vLLM推理中,针对 Attention、LayerNorm、GEMM等核心算子进行了指令级与内存访问模式优化,为后续性能提升奠定基础。

凭借在FlagScale生态中的深度集成与架构适配经验,寒武纪MLU平台具备了对未来FlagScale开发或开放的新模型进行快速、即时适配的能力。无论是Megatron-LM体系下的新一代训练模型,还是vLLM推理端的最新开源模型,MLU都能够在框架演进中实现同步更新与性能优化,保持良好的生态兼容性和持续演进能力。

FlagScale的全面适配与持续优化,使寒武纪MLU在大模型训练与推理全链路中具备了统一、高效、可扩展的框架级生态能力。这一进展不仅加速了国产AI硬件在开源大模型生态中的融合,也为大模型的工程化和高性能部署提供了有力支撑。

-

AI

+关注

关注

89文章

38077浏览量

296302 -

寒武纪

+关注

关注

13文章

212浏览量

74791 -

大模型

+关注

关注

2文章

3439浏览量

4960

原文标题:寒武纪拥抱众智FlagOS生态

文章出处:【微信号:Cambricon_Developer,微信公众号:寒武纪开发者】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

超越茅台,“寒王上位”!营收暴增43倍,半年狂赚10亿,“中国英伟达”成了?

寒武纪“炸裂”财报!一季度营收增长40倍,积极备货应对“爆单”?

寒武纪3000亿市值与GPU厂商密集IPO,AI芯片正是当打之年

寒武纪引领AI芯片软件新生态

商汤科技与寒武纪达成战略合作

寒武纪成功适配DeepSeek-V3.2-Exp模型

寒武纪股价破1200大关创历史新高 DeepSeek适配国产芯片成直接原因

寒武纪85后创始人陈天石身价超1500亿

寒武纪联手阶跃星辰成立模芯生态创新联盟

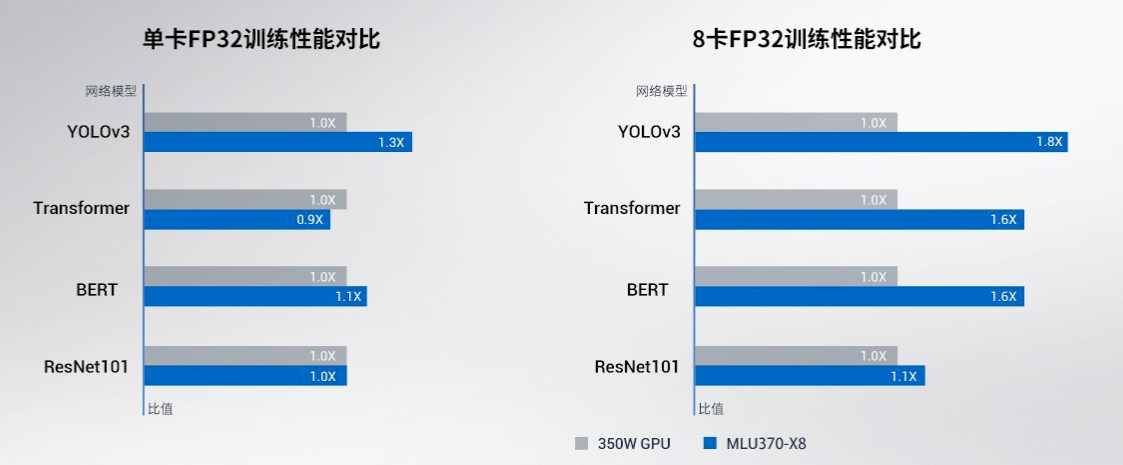

寒武纪基于思元370芯片的MLU370-X8 智能加速卡产品手册详解

寒武纪一季度营收大涨4230% 净利润3.55亿 扭亏为盈

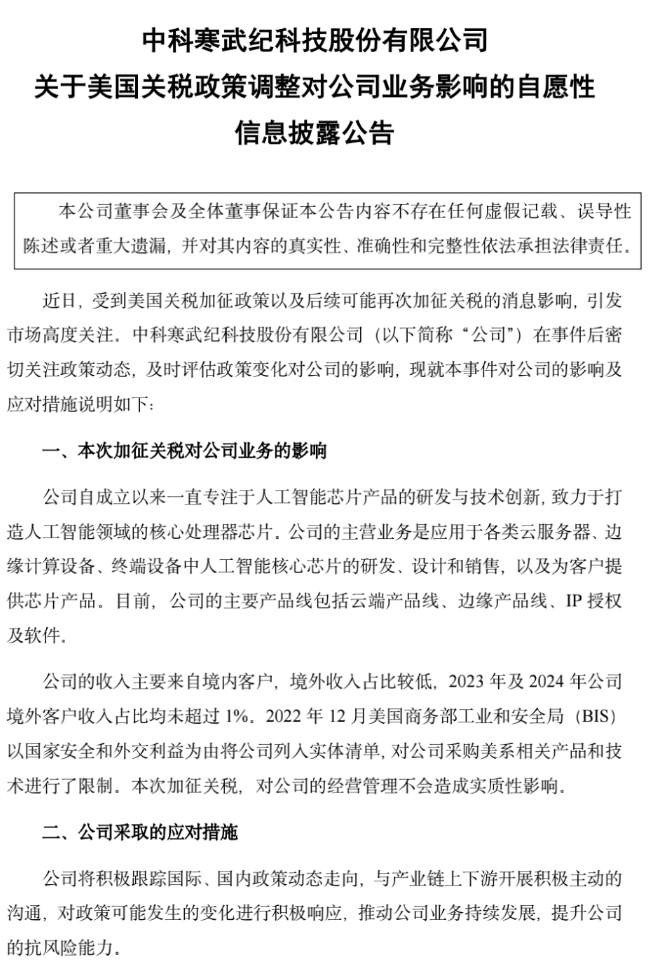

美国业务收入占比低,寒武纪等回应加征关税

寒武纪产品与众智FlagOS全面适配

寒武纪产品与众智FlagOS全面适配

评论