作者:算力魔方创始人/英特尔创新大使刘力

C#不仅在PC游戏开发、大型商业系统领域应用广泛,还成为开源测控、机器视觉与运动控制,以及PC数集与分析领域中的主流开发语言!

在开源测控、机器视觉、数采与分析三大领域中,如何快速将AI模型集成到应用程序中,实现AI赋能和应用增值?最容易的方式是:在C#中,使用OpenVINO™工具套件集成AI模型。

一,什么是OpenVINO™ 工具套件?

OpenVINO™ 工具套件是一个用于优化和部署人工智能(AI)模型,提升AI推理性能的开源工具集合,不仅支持以卷积神经网络(CNN)为核心组件的预测式AI模型(Predictive AI),还支持以Transformer为核心组件的生成式AI模型(Generative AI)。

OpenVINO™工具套件支持对基于PyTorch、TensorFlow、PaddlePaddle等主流深度学习框架训练好的模型进行优化,提升其在英特尔® CPU、独立显卡、集成显卡、NPU等硬件上的AI推理计算性能。

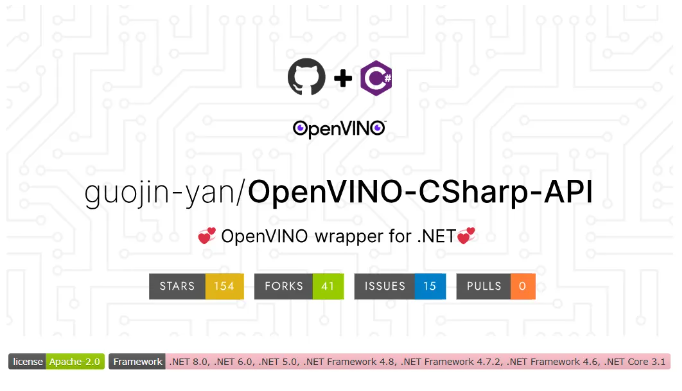

二,什么是OpenVINO™ C# API?

OpenVINO™ C# API 是一个开源的 OpenVINO™ 的 .Net wrapper(包装器)项目,它基于最新的OpenVINO™ Runtime库开发,通过调用官方的OpenVINO™ C API ,允许开发者在 .NET 和 .NET Framework 环境中使用 C# 语言调用AI模型,并实现AI模型在英特尔® CPU、独立显卡、集成显卡、NPU上的推理加速。

OpenVINO™ C# API的GitHub仓:https://github.com/guojin-yan/OpenVINO-CSharp-API

为了方便开发者使用,OpenVINO™ C# API提供了NuGet Package,可以通过NuGet管理工具直接进行安装。

三,搭建OpenVINO™ C# API开发环境

搭建OpenVINO™ C# API开发环境共分三步:

1.安装.NET 8.0

2.在VS Code中配置C#开发环境

3.使用NuGet安装OpenVINO™ C# API依赖项

本节依次介绍。

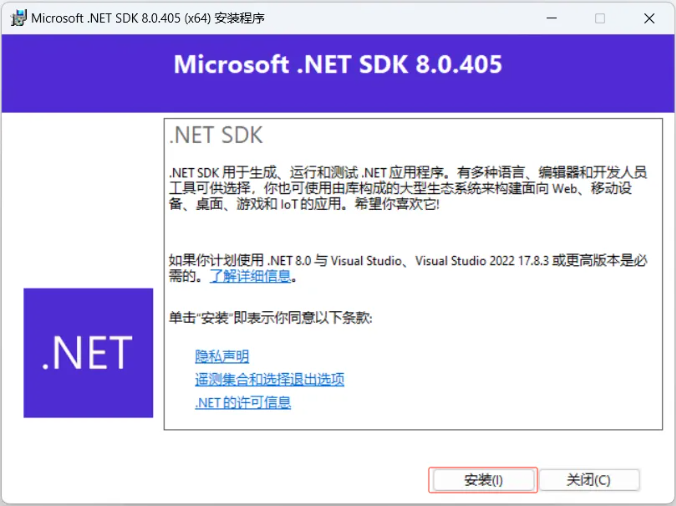

1,安装.NET 8.0:

请进入.NET官网下载地址:https://dotnet.microsoft.com/zh-cn/download,下载.NET 8.0安装包。

下载完毕后,以管理员方式运行安装包,并按默认方式完成安装。

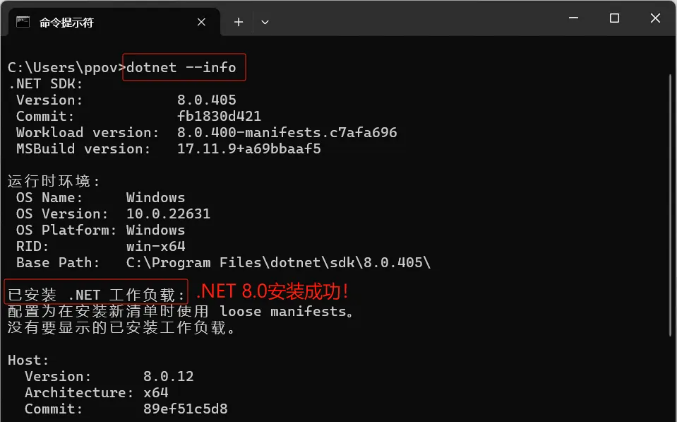

安装完毕后,请启动“命令提示符”,然后输入 “dotnet --info” 指令,验证安装是否成功:

2,在VS Code中配置C#开发环境:

VS Code(Visual Studio Code)是一款由微软开发的开源、免费、跨平台的轻量级代码编辑器;支持多种编程语言(如C、C++、C#、Java、Python、JavaScript等)的代码编辑,具备语法高亮、代码折叠、代码补全、代码重构等功能;广泛应用于各类软件开发领域。

[注意]:使用VS Studio的开发者,无需安装VS Code的插件,可略过该小节!

首先,请从:https://code.visualstudio.com/,下载并安装VS Code。

然后,启动VS Code,在“Extensions:Marketplace”中搜索关键字:“C#”,依次安装C#和C# Dev Kit插件。

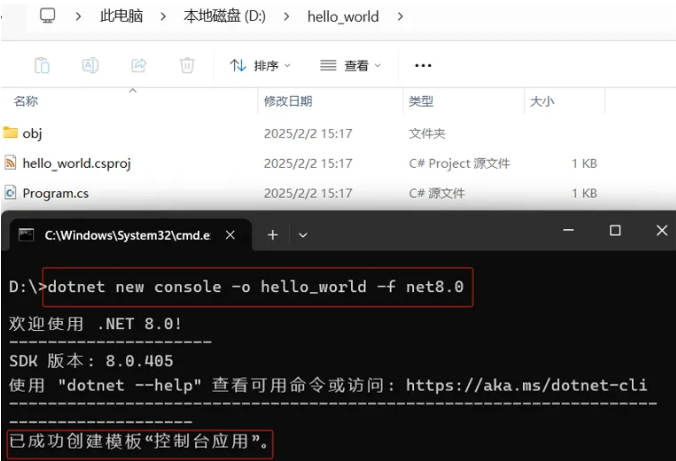

接着,启动“命令提示符”并输入 “dotnet new console -o hello_world -f net8.0”命令,创建一个名叫“hello_world”的C# console项目。

最后,启动VS Code,并用“File-->Open Folder...”打开hello_world文件夹,然后点击“Run Project...”按钮,若在Terminal中成功输出“Hello, World!”说明在VS Code配置C#开发环境成功!

3,使用NuGet安装OpenVINO™ C# API:

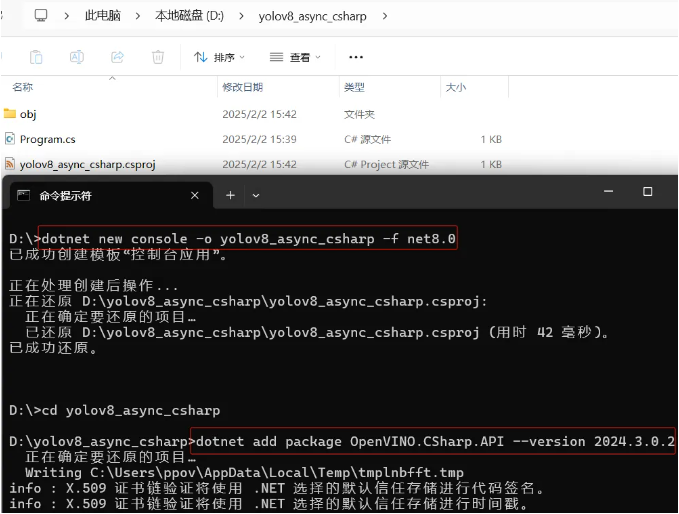

首先,启动“命令提示符”,用命令创建YOLOv8推理项目:

dotnet new console -o yolov8_async_csharp -f net8.0

然后,进入“yolov8_async_csharp”目录,使用NuGet安装OpenVINO™ C# API,命令如下:

dotnet add package OpenVINO.CSharp.API --version 2024.3.0.2 dotnet add package OpenVINO.runtime.win --version 2024.3.0.1 dotnet add package OpenVINO.CSharp.API.Extensions.OpenCvSharp --version 1.0.6.1

最后,使用NuGet安装OpenCvSharp4:

dotnet add package OpenCvSharp4 --version 4.9.0.20240103 dotnet add package OpenCvSharp4.runtime.win --version 4.9.0.20240103

到此,OpenVINO™ C# API开发环境搭建完毕!

四,用C# 编写OpenVINO™推理程序

首先,请从:

https://github.com/openvino-book/openvino_handbook/tree/main/chapter_5/C%23/yolov8_async_csharp,

下载范例程序Program.cs(覆盖yolov8_asysc_csharp文件夹中的Program.cs),测试视频test_video.mp4和yolov8s IR格式模型,放入yolov8_asysc_csharp文件夹中。

然后,点击“Run project”或使用快捷键“Ctrl+F5”运行程序,结果如下视频所示:

https://live.csdn.net/v/462063

五,总结

OpenVINO™ C# API 易学易用,可以方便将AI模型集成到C#应用程序中!

如果你有更好的文章,欢迎投稿!

稿件接收邮箱:nami.liu@pasuntech.com

更多精彩内容请关注“算力魔方®”!

审核编辑 黄宇

-

AI

+关注

关注

89文章

38162浏览量

296844 -

OpenVINO

+关注

关注

0文章

117浏览量

717

发布评论请先 登录

如何在Ollama中使用OpenVINO后端

在Visual Studio中使用OpenVINO™ C API时无法读取网络怎么解决?

OpenVINO中的量化模型与OpenVINO ESR模型结果不一致是怎么回事?

请问使用2022.2时是否可以读取模型OpenVINO™层?

创建了用于OpenVINO™推理的自定义C++和Python代码,从C++代码中获得的结果与Python代码不同是为什么?

为什么无法在OpenVINO™ 2021.3源中使用CMAKE编译ONNX模型?

运行时OpenVINO™找不到模型优化器,为什么?

通过Docker映像OpenVINO™ DL Workbench OpenVINO™安装,无法上传模型怎么解决?

为什么无法在运行时C++推理中读取OpenVINO™模型?

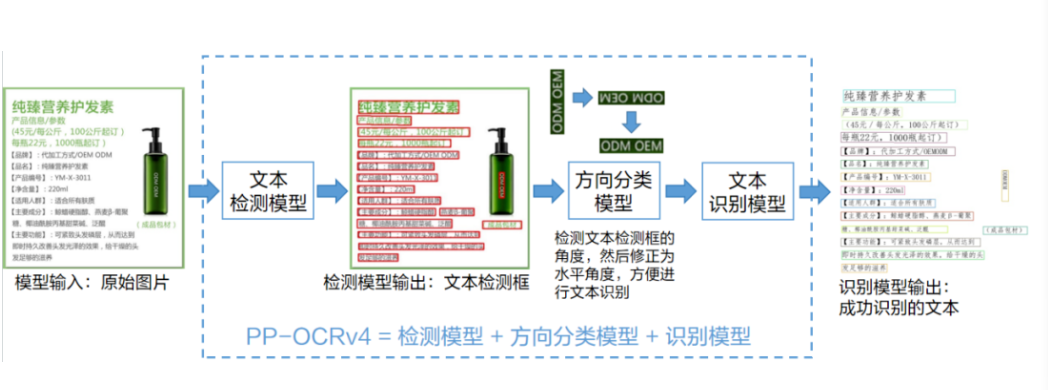

使用OpenVINO C# API轻松部署飞桨PP-OCRv4模型

C#中使用OpenVINO™:轻松集成AI模型!

C#中使用OpenVINO™:轻松集成AI模型!

评论