LLM630

LLM推理,视觉识别,可开发,灵活扩展

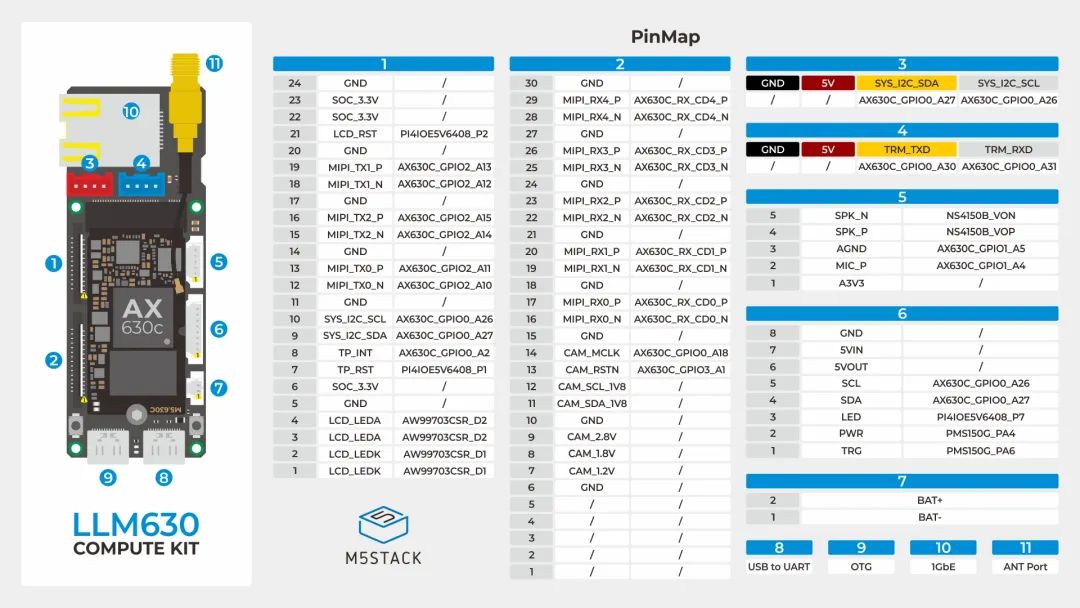

LLM630 Compute Kit是一款 AI 大语言模型推理开发平台,专为边缘计算和智能交互应用而设计。该套件的主板搭载爱芯AX630CSoC 处理器,集成了 3.2 TOPs@INT8 算力的高能效 NPU,提供强大的 AI 推理能力,能够高效执行复杂的视觉(CV)及大语言模型(LLM)任务,满足各类智能应用场景的需求。主板同时配备 JL2101-N040C 千兆网口芯片 和 ESP32-C6 无线通信芯片,支持 Wi-Fi 6@2.4G,用作设备的网卡,提供高速数据传输能力,实现 Wi-Fi 和以太网的桥接功能。无论是通过有线连接进行大规模数据交换,还是通过无线通信与远程服务器或其他智能设备进行实时互动,该平台都能确保高效的数据交互。主板还集成了 SMA 天线接口,进一步增强无线信号的稳定性和传输距离,确保在复杂网络环境下的稳定通信。内置 4GB LPDDR4 内存(其中 2GB 供用户使用,2GB 专用于硬件加速)和 32GB eMMC 存储,支持多模型并行加载与推理,确保任务处理高效顺畅。

与主板完美配合的底板大幅扩展了LLM630 Compute Kit的功能性和适用性。它集成了BMI270 六轴传感器,提供精准的姿态感应和运动检测能力,适用于各种动态应用。内置的NS4150B D类功放以及麦克风和扬声器接口支持高质量的语音输入和音频输出,实现全双工通信模式,增强用户交互体验。底板还配备了双 Grove 接口及LCD/DSI和CAM/CSI MIPI 接口,便于扩展外设如显示屏和摄像头模块。同时,底板集成了外接天线接口和一个 千兆网口,为设备提供灵活的网络连接和增强的无线性能。此外,设备用户按键实现开关机和模式切换等功能,提高了设备的易用性和交互性。

底板的充电芯片和预留电池插座支持自定义电池配置,确保平台即使在无外部电源时也能长时间稳定运行。集成的电量检测芯片实时监控电池状态。MicroSD 卡槽支持存储扩展,以及后续将支持的AI模型更新功能。双Type-C接口不仅支持高效的数据传输,还提供OTG功能,使设备连接更加灵活,确保数据交换和设备连接的高效率。

LLM630 Compute Kit 支持StackFlow 框架,开发者可以轻松通过几行代码实现边缘智能应用,快速启动各种 AI 任务。平台支持多种 AI 应用,包括视觉识别,语音识别、文本转语音和唤醒词识别等功能,并支持分开调用或 pipeline 自动流转,方便开发。平台还支持 Yolo11 DepthAnything 等视觉模型,InternVL2.5-1B 多模态大模型,Qwen2.5-0.5/1.5B Llama3.2-1B 大语言模型和 Whisper Melotts 语音模型等,支持热更新,后续将持续支持最先进的热门的大模型,赋能智能识别与分析,确保平台紧跟技术发展和社区潮流。

LLM630 Compute Kit 适用于长时间运行的智能设备,广泛应用于安防监控,智能销售,智能农业,智能家居控制,互动机器人和教育等领域,能够为边缘智能应用提供强大的计算能力与灵活的扩展性。

-

AI

+关注

关注

89文章

38121浏览量

296672 -

语言模型

+关注

关注

0文章

570浏览量

11255 -

LLM

+关注

关注

1文章

340浏览量

1257

发布评论请先 登录

NVIDIA TensorRT LLM 1.0推理框架正式上线

米尔RK3576部署端侧多模态多轮对话,6TOPS算力驱动30亿参数LLM

基于米尔瑞芯微RK3576开发板的Qwen2-VL-3B模型NPU多模态部署评测

Votee AI借助NVIDIA技术加速方言小语种LLM开发

信而泰×DeepSeek:AI推理引擎驱动网络智能诊断迈向 “自愈”时代

如何在魔搭社区使用TensorRT-LLM加速优化Qwen3系列模型推理部署

新品|CamModule SC850SL,为 LLM630 打造的高清摄像头模组

首创开源架构,天玑AI开发套件让端侧AI模型接入得心应手

新品 | Module LLM Kit,离线大语言模型推理模块套装

新品| LLM630 Compute Kit,AI 大语言模型推理开发平台

新品| LLM630 Compute Kit,AI 大语言模型推理开发平台

评论