7月31日,集邦咨询发布的最新报告揭示了AI服务器领域的一个重要趋势:随着计算能力与功耗的同步攀升,特别是NVIDIA计划在年底推出的下一代Blackwell平台将带来显著的功耗增长,液冷散热技术正逐步成为行业标配,预计今年底其市场渗透率将达到10%。

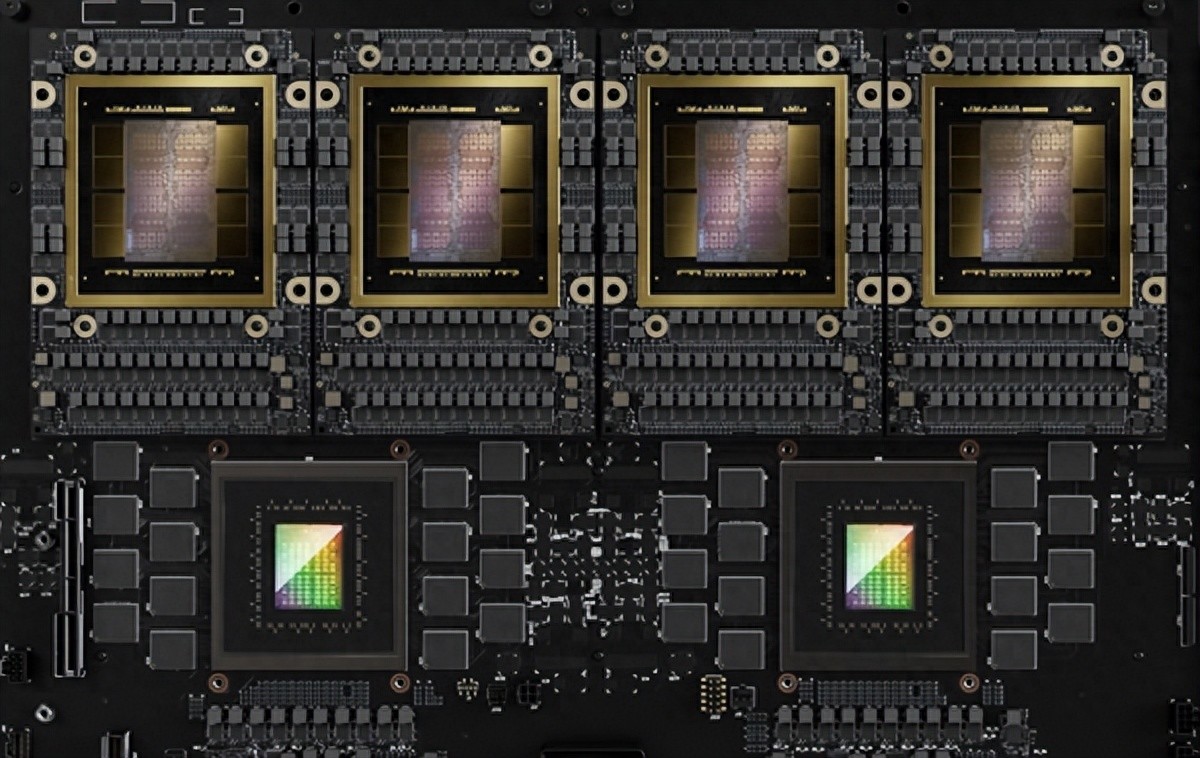

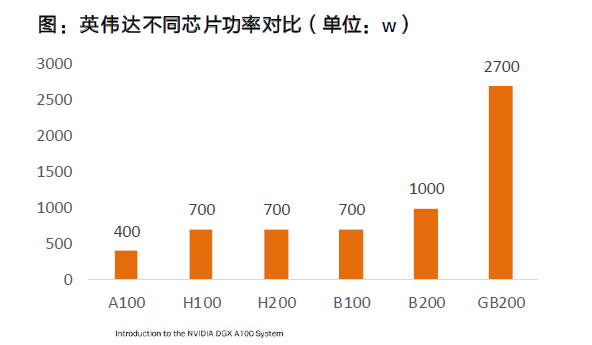

报告进一步指出,NVIDIA的Blackwell平台预计将在2025年正式大规模部署,接替当前的Hopper平台,成为高端市场的核心力量,占据近83%的市场份额。Blackwell B200单芯片的功耗已飙升至1000W,而由一颗Grace CPU与两颗Blackwell GPU组成的GB200超级芯片更是惊人地达到了2700W,这一数字远超前辈产品。

回顾历史,Hopper家族的H100与H200 GPU功耗均为700W,而H20则相对较低,为400W。Grace+Hopper超级芯片的功耗也达到了1000W。随着NVIDIA在服务器领域的布局深化,如HGX服务器预装8颗GPU,以及NVL36、NVL72等更高密度配置的推出,整体功耗分别攀升至70千瓦与140千瓦,对散热技术提出了前所未有的挑战。

为应对这一挑战,NVL36服务器计划在2024年底率先上市,初期将采用风冷与液冷并行的散热方案。而紧随其后的NVL72服务器,则计划在2025年直接优先采用液冷技术,其整体设计与散热系统的复杂性也显著增加。

NVIDIA预计,到2025年,基于GB200的NVL36服务器出货量有望达到6万台,同时Blackwell GPU的总出货量预计将介于210万至220万颗之间。这一预测进一步凸显了液冷散热技术在未来AI服务器市场中的关键地位。

在液冷散热系统的构成中,冷却分配单元(CDU)扮演着至关重要的角色,负责调节系统内冷却液的流量,确保温度得到有效控制。目前,维谛技术(Vertiv)是NVIDIA AI服务器方案中的主要CDU供应商,同时奇鋐、双鸿、台达电、CoolIT等企业也在积极进行测试验证,以期在这一新兴市场中占据一席之地。

-

cpu

+关注

关注

68文章

11216浏览量

222952 -

NVIDIA

+关注

关注

14文章

5496浏览量

109094 -

gpu

+关注

关注

28文章

5099浏览量

134461

发布评论请先 登录

锦富技术斩获液冷板订单

GB10超级芯片开卖!正式杀入AI PC

总功率超198kW,AI服务器电源对元器件提出了哪些要求?

新思科技携手英伟达加速芯片设计,提升芯片电子设计自动化效率

鸿海GB200 AI服务器顺利完成英伟达交付目标

英伟达GB200 NVL72服务器出货量调低

英伟达Blackwell芯片机架出现故障 订单下滑

MediaTek与NVIDIA携手设计GB10 Grace Blackwell超级芯片

英伟达推出GB200 NVL4芯片!液冷UQD快接头崛起

NVIDIA GB200 CPU+GPU超级芯片功耗达2700W

NVIDIA GB200 CPU+GPU超级芯片功耗达2700W

评论