英伟达Grace-Hopper提供了一个紧密集成的CPU + GPU解决方案,针对生成式人工智能逐渐成为主导的市场环境。

为了提高性能,这家GPU制造商将HBM3e内存放入了名为GH200的新型芯片封装中,该封装包括一个Grace CPU和一个Hopper GPU。Hopper以前在芯片封装中使用HBM3存储器。

英伟达将把两个GH200芯片(每个都有一个72核CPU和一个Hopper GPU)连接到一个更大的芯片集群中,用于扩展数据中心。

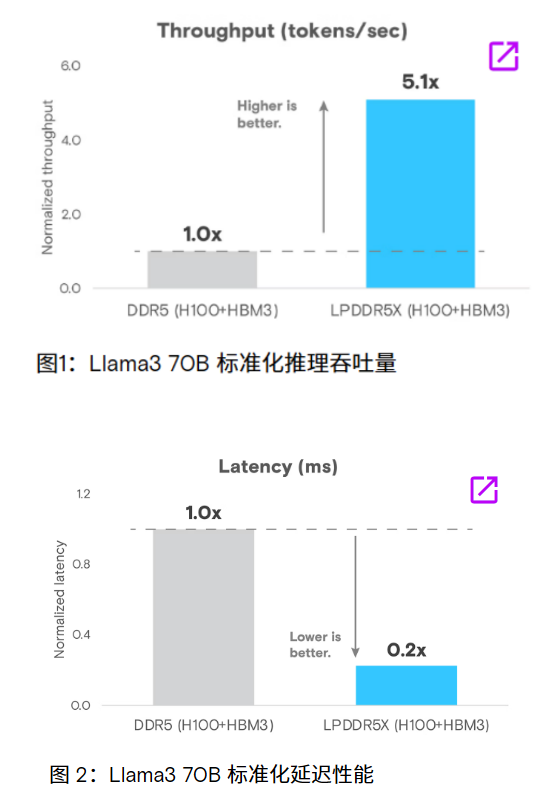

HBM3e内存比HBM3快50%,总带宽为每秒10TB;CPU基于Neoverse V2设计。英伟达CEO黄仁勋表示:“这些芯片正在生产中,我们将在2023年年底左右进行样品测试。”

一个封装中的两个GH200芯片将具有282GB的HBM3e内存,这相比于之前GH100芯片的192GB HBM内存是一大改进。它还将拥有每秒8千万亿次的人工智能计算能力,以及每秒10 TB的HBM3e性能。

该芯片组可以接受任何大型语言模型,“可以疯狂地进行推理”。英伟达表示,这些芯片可以运行3.5倍大的模型,并通过更快的内存带宽获得性能提升。

该公司打算将256个GH200 GPU配置到一个名为Grace Hopper的超级计算机系统中,该系统将提供1百亿亿次的人工智能性能。黄仁勋将该系统称为“世界上最大的单一GPU”,所有256个GH200协同工作。

目前所有的大型学习模型都是在Grace Hopper超级计算机这样的系统上训练的。黄仁勋说,未来随着人工智能在设备之间的分布越来越广,每个应用程序都将使用一个大型语言模型。随着越来越多的公司探索人工智能来提高运营效率,HopperGPU现在很受欢迎。该公司承认GPU供应短缺。

黄仁勋还描绘了如何分解其GPU路线图以满足分布式模型。Grace Hopper超级计算机位于顶部,然后可以将其分配到具有不同要求的服务器和桌面GPU上的不同GPU上。

审核编辑:刘清

-

gpu

+关注

关注

28文章

5099浏览量

134456 -

人工智能

+关注

关注

1813文章

49734浏览量

261509 -

英伟达

+关注

关注

23文章

4040浏览量

97668 -

HBM

+关注

关注

2文章

426浏览量

15698

原文标题:英伟达GH200增加HBM3e内存!

文章出处:【微信号:SSDFans,微信公众号:SSDFans】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

国产GPU再下一城,群起突围英伟达+AMD

英伟达+联发科,打入游戏本市场?

英伟达发布 NVQLink 开放系统架构;国内首个汽车芯片标准验证平台投入使用

英伟达力挺SOCAMM2,国产存储厂商紧密跟进

aicube的n卡gpu索引该如何添加?

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】+NVlink技术从应用到原理

英伟达拟再推中国特供GPU,今年6月量产!

GPU 维修干货 | 英伟达 GPU H100 常见故障有哪些?

新思科技亮相英伟达GTC 2025大会

英伟达带来Reflex 2低延迟技术

微软大手笔采购英伟达AI芯片

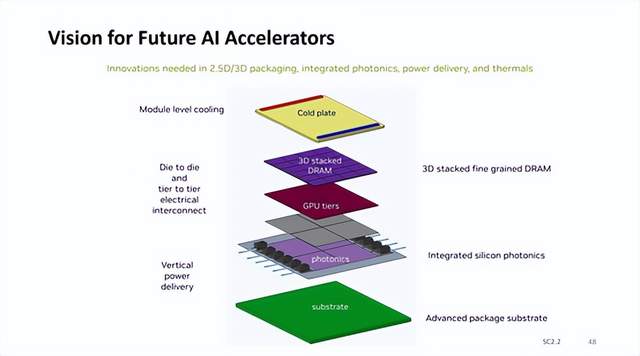

英伟达AI加速器新蓝图:集成硅光子I/O,3D垂直堆叠 DRAM 内存

英伟达Grace-Hopper提供一个紧密集成的CPU + GPU解决方案

英伟达Grace-Hopper提供一个紧密集成的CPU + GPU解决方案

评论