谷歌正迅速成为 BFF Nvidia 的强大对手——为其超级计算机提供动力的 TPU v5p AI 芯片速度更快,内存和带宽比以往任何时候都多,甚至击败了强大的 H100

TPU v5p——谷歌最强大的定制设计人工智能加速器——已被部署为该公司的“人工智能超级计算机”提供动力。 这是一种专门为运行人工智能应用程序而构建的超级计算架构,而不是通常运行科学工作负载的超级计算机,因为 TPU 不适合于此。

最新版本的 TPU 每个 Pod 有 8,960 个芯片(构成系统),而 v4 中有 4,096 个芯片,并且就每个 Pod 的 FLOP 总可用性而言,其可扩展性是其四倍。 这些新 Pod 提供 4,800Gbps 的吞吐量。 新 Pod 还配备 95GB 高带宽内存 (HBM),而 TPU v4 中则配备 32GB HBM RAM。

与Nvidia 提供 GPU 供其他公司购买不同,谷歌的定制 TPU 仍保留在内部,供其自己的产品和服务使用。 谷歌的 TPU 长期以来一直用于为其 Gmail、YouTube 和 Android 等服务提供支持,最新版本也用于训练 Gemini。

它的功能甚至足以与 Nvidia 广受欢迎的 H100 GPU 相媲美,后者是处理 AI 工作负载的最佳显卡之一。 根据该公司自己的数据,该组件在训练工作负载方面比 Nvidia 的 A100 GPU 快四倍。

与此同时,根据 4 月份发布的研究显示,谷歌 TPU v4 的速度预计比 A100 快 1.2 至 1.7 倍。 因此,令人难以置信的粗略计算表明,TPU v5p 的速度大约是 A100 的 3.4 到 4.8 倍,这使其与 H100 相当!

审核编辑:刘清

-

加速器

+关注

关注

2文章

836浏览量

39712 -

RAM

+关注

关注

8文章

1398浏览量

119822 -

TPU

+关注

关注

0文章

164浏览量

21535 -

HBM

+关注

关注

2文章

426浏览量

15698 -

人工智能芯片

+关注

关注

1文章

122浏览量

30807

原文标题:TPU v5p人工智能芯片

文章出处:【微信号:计算机视觉芯片设计,微信公众号:计算机视觉芯片设计】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

谷歌云发布最强自研TPU,性能比前代提升4倍

边缘计算中的AI加速器类型与应用

创客总部加入MathWorks加速器计划

挖到宝了!人工智能综合实验箱,高校新工科的宝藏神器

挖到宝了!比邻星人工智能综合实验箱,高校新工科的宝藏神器!

关于人工智能处理器的11个误解

是德示波器DSOX6002A在人工智能芯片测试中的应用

AI芯片:加速人工智能计算的专用硬件引擎

TPU处理器的特性和工作原理

Google推出第七代TPU芯片Ironwood

谷歌第七代TPU Ironwood深度解读:AI推理时代的硬件革命

谷歌新一代 TPU 芯片 Ironwood:助力大规模思考与推理的 AI 模型新引擎

Cognizant将与NVIDIA合作部署神经人工智能平台,加速企业人工智能应用

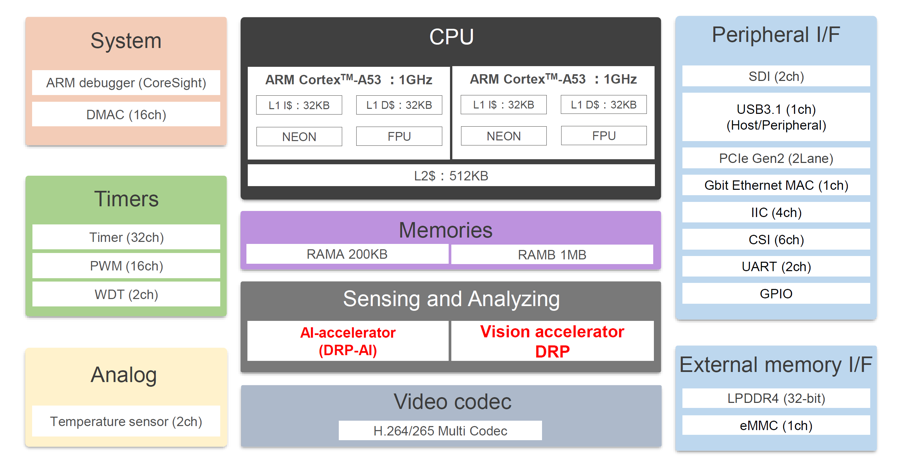

支持实时物体识别的视觉人工智能微处理器RZ/V2MA数据手册

谷歌最强大的定制设计人工智能加速器—TPU v5p芯片

谷歌最强大的定制设计人工智能加速器—TPU v5p芯片

评论