先后和 OpenAI、Meta 牵手推动大模型发展的微软,也正在加快自家小模型的迭代。就在今天,微软正式发布了一个 27 亿参数的语言模型——Phi-2。这是一种文本到文本的人工智能程序,具有出色的推理和语言理解能力。

同时,微软研究院也在官方 X 平台上如是说道,“Phi-2 的性能优于其他现有的小型语言模型,但它足够小,可以在笔记本电脑或者移动设备上运行”。

Phi-2 的性能真能优于大它 25 倍的模型?

对于Phi-2 的发布,微软研究院在官方公告的伊始便直言,Phi-2 的性能可与大它 25 倍的模型相匹配或优于。

这也让人有些尴尬的事,不少网友评价道,这岂不是直接把 Google 刚发的 Gemini 最小型号的版本给轻松超越了?

那具体情况到底如何?

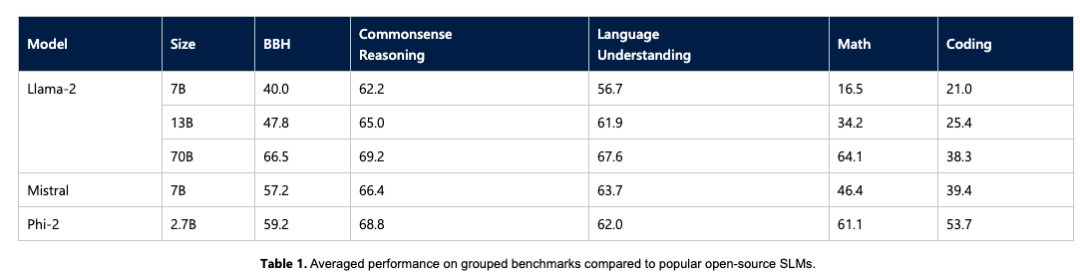

微软通过时下一些如 Big Bench Hard (BBH)、常识推理(PIQA、WinoGrande、ARC easy 和 Challenge、SIQA)、语言理解(HellaSwag、OpenBookQA、MMLU(5-shot)、 SQuADv2、BoolQ)、数学(GSM8k)和编码(HumanEval)等基准测试,将 Phi-2 与 7B 和 13B 参数的 Mistral 和 Llama-2 进行了比较。

最终得出仅拥有 27 亿个参数的 Phi-2 ,超越了 Mistral 7B 和 Llama-2 7B 以及 13B 模型的性能。值得注意的是,与大它 25 倍的 Llama-2-70B 模型相比,Phi-2 还在多步推理任务(即编码和数学)上实现了更好的性能。

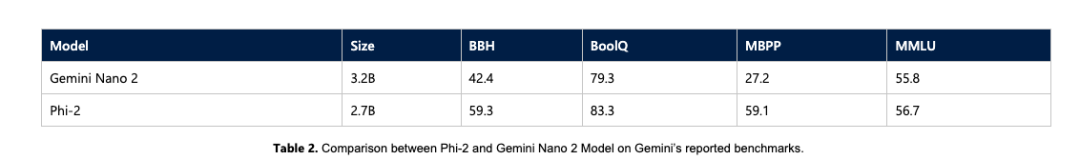

此外,如上文所提及的,微软研究人员也直接在基准测试中放上了其与Google 全新发布的 Gemini Nano 2 正面PK 的结果,不出所料,Phi-2尽管尺寸较小,但性能还是把Gemini Nano 2 超了。

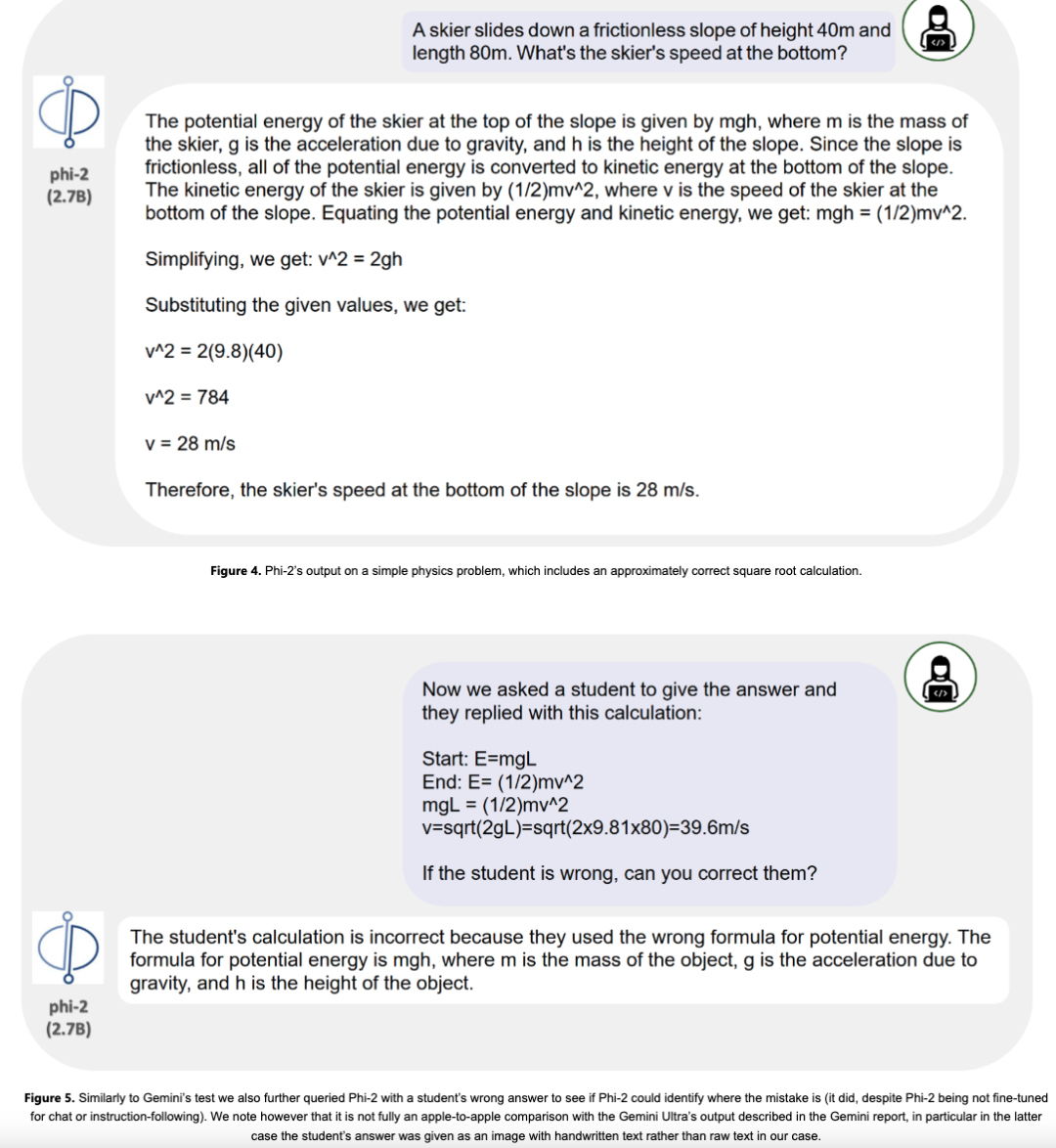

除了这些基准之外,研究人员似是在暗讽 Google 前几日在Gemini 演示视频中造假一事,因为当时 Google 称其即将推出的最大、最强大的新人工智能模型 Gemini Ultra 能够解决相当复杂的物理问题,并且甚至纠正学生的错误。

事实证明,尽管 Phi-2 的大小可能只是 Gemini Ultra 的一小部分,但它也能够正确回答问题并使用相同的提示纠正学生。

微软的改进

Phi-2 小模型之所以有如此亮眼的成绩,微软研究院在博客中解释了原因。

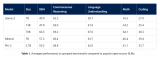

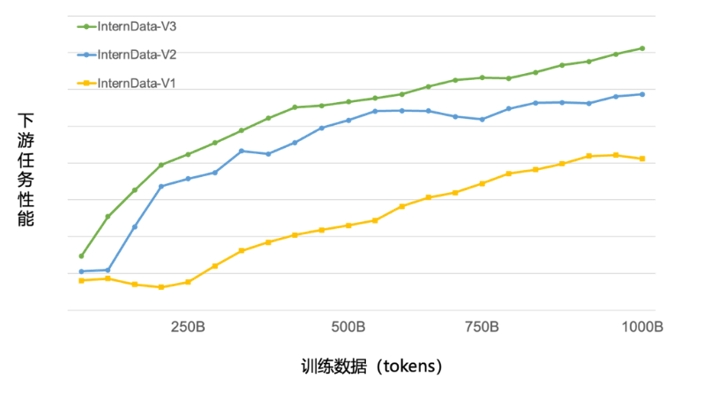

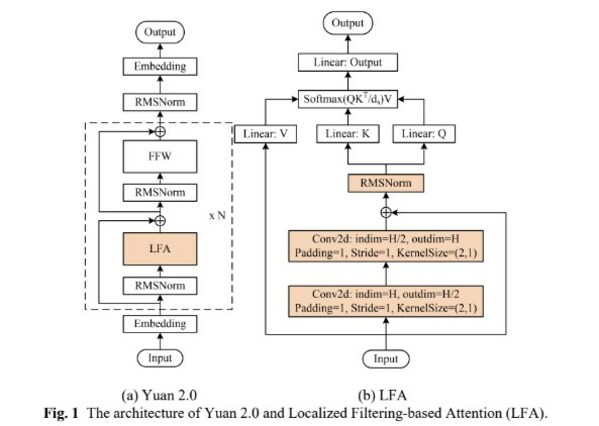

一是提升训练数据的质量。Phi-2 是一个基于 Transformer 的模型,其目标是预测下一个单词,它在 1.4T 个词组上进行了训练,这些词组来自 NLP 和编码的合成数据集和网络数据集,包括科学、日常活动和心理理论等用于教授模型常识和推理的内容。Phi-2 的训练是在 96 个 A100 GPU 上耗时 14 天完成的。

其次,微软使用创新技术进行扩展,将其知识嵌入到 27 亿参数 Phi-2 中。

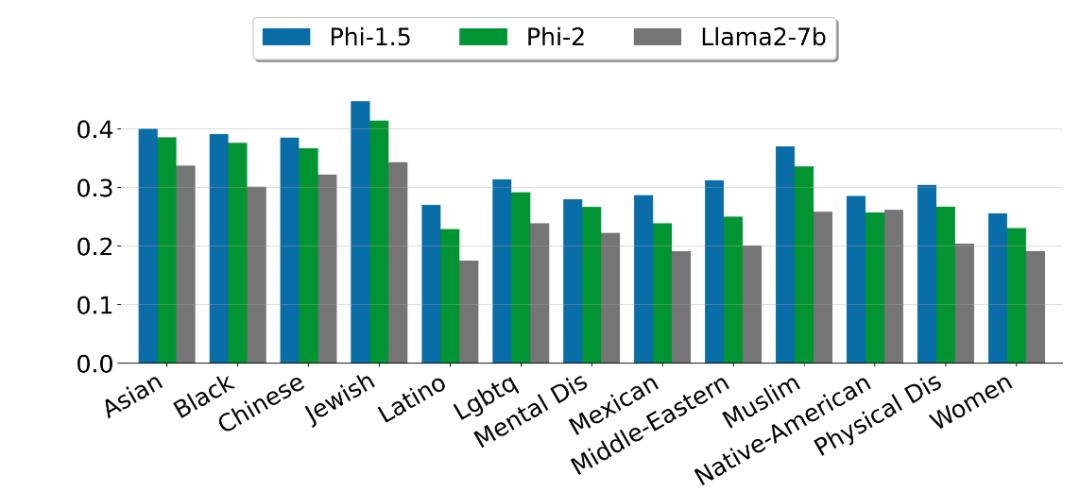

微软指出,Phi-2 是一个基础模型,没有通过人类反馈强化学习(RLHF)进行调整,也没有经过指导性微调。尽管如此,与经过对齐的现有开源模型相比,微软观察到在毒性和偏差方面,Phi-2 有更好的表现。

写在最后

话说 Phi-2 的发布的确在小模型的性能上实现了突破,不过也有媒体发现它还存在很大的局限性。

因为根据微软研究许可证显示,其规定了 Phi -2 只能用于“非商业、非创收、研究目的”,而不是商业用途。因此,想要在其之上构建产品的企业就不走运了。

审核编辑:刘清

-

编码器

+关注

关注

41文章

3364浏览量

131560 -

OpenAI

+关注

关注

8文章

763浏览量

5918 -

大模型

+关注

关注

2文章

1542浏览量

1137

原文标题:只有 27 亿参数,微软发布全新 Phi-2 模型!

文章出处:【微信号:AI科技大本营,微信公众号:AI科技大本营】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

NVIDIA加速微软最新的Phi-3 Mini开源语言模型

微软发布phi-3AI模型,性能超越GPT-3.5

微软下架最新大语言模型WizardLM-2,缘因“幻觉测试疏忽”

昆仑万维发布新版MoE大语言模型天工2.0

优于10倍参数模型!微软发布Orca 2 LLM

【飞腾派4G版免费试用】仙女姐姐的嵌入式实验室之五~LLaMA.cpp及3B“小模型”OpenBuddy-StableLM-3B

微软宣布推出一个27亿参数的语言模型Phi-2

微软Phi-2 2.7B性能领先谷歌Gemini Nano-2 3.2B

大语言模型简介:基于大语言模型模型全家桶Amazon Bedrock

盘古大模型参数量有多少

微软韦青:“大语言模型”之于人类,新启蒙时代的思考

微软正式发布一个27亿参数的语言模型—Phi-2

微软正式发布一个27亿参数的语言模型—Phi-2

评论