英伟达在世界电脑会议(sc2023)上发布了最新ai芯片h200,对ai模型进行了训练。

英伟达大幅升级了热门的h100人工智能gpu。新高端芯片芯片h200基于英伟达的hopper架构,是第一个使用高带宽内存的gpu,速度更快。建立一个大的语言模型是必要的。推理或生成问题答案时性能比h100提高60 ~ 90%。

英伟达方面表示,以hbm3e为基础,h200每秒提供4.8tb、141gb的存储器,与a100相比,容量和带宽分别增加2倍和2.4倍。

在备受关注的人工智能领域,英伟达表示,h200将进一步提高性能。llama 2(700亿个llm)的推理速度是h100的两倍。未来的软件更新有望为h200带来更多的性能和改进。

h200由英伟达hgx h200服务器主板4频道和8频道组成,可与hgx h100系统的硬件和软件兼容。

据悉,大型计算机制造企业和云服务提供企业将从明年第二季度开始使用h200。亚马逊的aws、Alphabet公司的谷歌云、微软的azure、甲骨文的云基础设施已承诺从明年开始使用该新芯片。

英伟达表示,希望通过推出新产品,赶上人工智能(ai)模型和服务数据集规模的增加。随着内存容量的增加,h200向软件提供数据的速度将会加快,这一过程将训练人工智能来完成图像和语音识别等工作。

过去英伟达通常每两年更新一次芯片架构,而最新的芯片架构是hopper。但nvidia向投资者表示,随着上月对gpu的需求剧增,原本每2年推出新的架构,现在改为每1年推出新的架构。

-

存储器

+关注

关注

39文章

7715浏览量

170869 -

人工智能

+关注

关注

1813文章

49746浏览量

261605 -

英伟达

+关注

关注

23文章

4041浏览量

97689

发布评论请先 登录

突发!特朗普批准英伟达H200芯片对华出口,抽成25%

今日看点:特朗普允许英伟达对华出口H200芯片,但要抽成25%;众擎完成 A1+ 轮与 A2 轮融资

今日看点:马斯克:特斯拉已部署超百万颗 AI 芯片;长鑫存储发布全新 DDR5 内存新品

英伟达 Q3 狂揽 308 亿

外媒:英伟达正开发新款中国特供芯片B30A 或为旗舰AI芯品B300的阉割版

特朗普要叫停英伟达对华特供版 英伟达H20出口限制 或损失55亿美元

新思科技携手英伟达加速芯片设计,提升芯片电子设计自动化效率

今日看点丨传英特尔或被拆分,台积电、博通考虑接手;英伟达联手联发科开发AI PC和手机芯片

GMI Cloud推出基于英伟达H200的DeepSeek系列模型

鸿海GB200 AI服务器顺利完成英伟达交付目标

英伟达发布DeepSeek R1于NIM平台

英伟达携手Illumina与Mayo Clinic,加速医疗健康AI应用

英伟达发布Cosmos世界基础模型

英伟达GB300 AI服务器预计2025年Q2发布,强化水冷散热需求

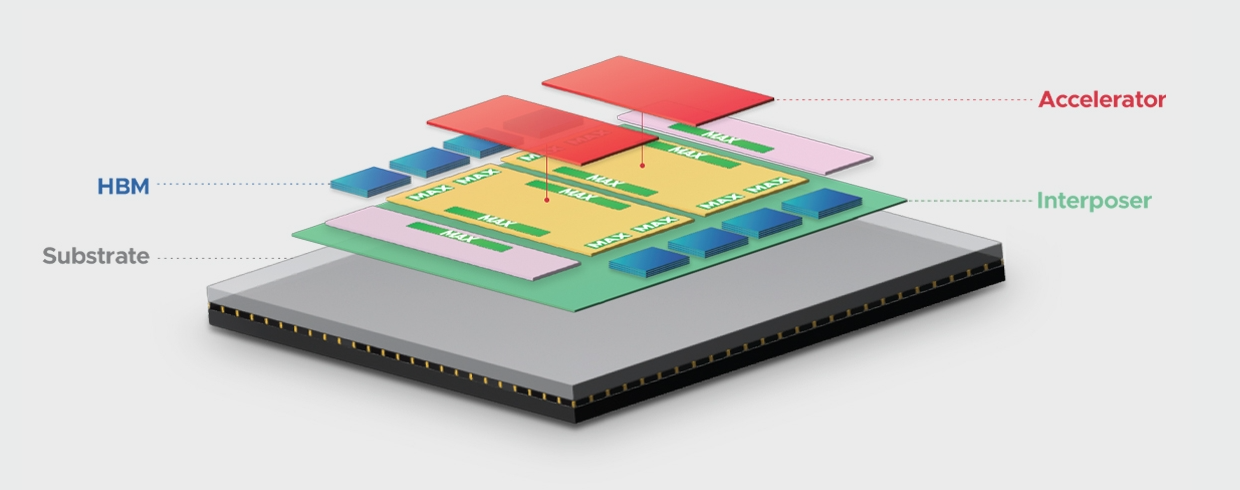

一颗芯片面积顶4颗H200,博通推出3.5D XDSiP封装平台

世界最强AI芯H200发布,英伟达:性能提升90%

世界最强AI芯H200发布,英伟达:性能提升90%

评论