编者按

近年来,因为AI芯片的火热,HBM作为当中一个核心组件,在近年来的关注热度水涨船高。关于HBM技术的细节,可以参考半导体行业观察之前的文章《存储巨头竞逐HBM》。在本文中,我们将回顾HBM的崛起故事,帮助大家了解这个高带宽内存的前世今生。

以下为文章正文:

2015年6月17日,AMD中国在北京望京召开发布会。

这场发布会上,媒体的目光全集中在某款重磅产品之上,它就是全新的Radeon R9 Fury X显卡,其采用代号为Fiji XT(斐济群岛)的28nm制程GPU核心,采用4GB HBM堆叠显存,拥有64个计算单元(CU)、4096个GCN架构流处理器(SP),核心频率为1050MHz,单精度浮点性能达到了8.6TFlops,而 HBM显存拥有4096 bit带宽,等效频率1Ghz,显存总带宽达到了512GB/S,除了显存容量外,各项配置无愧于旗舰之名。

虽说这是HBM显存首次亮相,但AMD早已联合SK海力士等厂商潜心研发多年,而Fury X作为首款搭载HBM的显卡,自然会被AMD寄予厚望。

时任AMD CEO的苏姿丰表示,HBM采用堆叠式设计实现存储速度的提升,大幅改变了GPU逻辑结构设计,DRAM颗粒由“平房设计”改为“楼房设计”,所以HBM显存能够带来远远超过当前GDDR5所能够提供的带宽上限,其将率先应用于高端PC市场,和英伟达(NVIDIA)展开新一轮的竞争。

针对R9 Fury X仅有4GB显存,而R9 290X新版本却配备了8GB GDDR5显存这一问题,AMD事业群CTO Joe Macri还特意回应表示,显存容量其实并不是问题,GDDR5可以做到很大,但也有着很严重的浪费,其实有很多空间都未得到充分利用,AMD未来会深入研究如何更高效率地利用这4GB HBM显存。

八年多时间过去了,AMD官网上挂着的RX 7000系列全部采用GDDR6显存,当初辛辛苦苦和海力士合作多年才得来的HBM显存早已不见踪影,只有用于AI计算的加速卡还残留着当初的豪言壮语。

而曾经的对手英伟达,用A100和H100两块显卡,轻松拿下了万亿美元的市值,坐稳了AI时代的宝座,而它们用的显存,正是AMD当初力推的HBM。

苦研七年作嫁衣

时间再倒回2015年,AMD事业群CTO Joe Macri在纽约分析师大会上,接受了媒体的专访,针对首次落地应用的HBM做了一系列回答。

Macri表示,AMD自2009年开始,就已经着手HBM的研发工作,在长达7年的时间里,AMD与SK海力士在内的众多业界伙伴一起完成了HBM的最终落地。

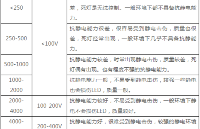

他首先谈到了HBM显存的必要性,2015年主流的显存规格是GDDR5,经过多年的使用和发展已经进入了瓶颈期,迫切需要新的替代技术,简单来讲,就是GPU的功耗不可能无限制地增长下去,越来越大的高规格显存正在挤压GPU核心的功耗空间,以前一张卡就200W功耗,显存分到30W,而之后的大容量显存却水涨船高,60W、70W、80W……再加上核心的提升,一张显卡往往有五六百瓦的功耗,也难怪被称之为核弹卡。

Macri觉得,显存面临的关键问题就是显存带宽,它却决于显存的位宽和频率,位宽都是GPU决定的,太高了会严重增大GPU芯片面积和功耗,所以高端显卡一直停留在384/512位。同时,GDDR5的频率已经超过7GHz,提升空间不大了。另外,GDDR5(包括以前的显存)都面临着“占地面积”的问题。一大堆显存颗粒围绕在GPU芯片周围,这已经是固定模式,GDDR5再怎么缩小也无法改变,而且已经不可能再继续大幅度缩小了。

即使在今天来看,AMD这番关于显卡功耗的话也挑不出什么毛病,GDDR5的频率确实到了上限,而功耗问题也一直困扰着厂商和消费者,英伟达最新的RTX 40系显卡为了缩减功耗和成本,就对显存位宽开了刀,功耗倒是小了,但是跑高分辨率游戏又变得不利索了。

事实上,行业内大部分人都觉得GDDR已经不行了到头了,但还是捏着鼻子继续用,因为大家的共识是,成熟且落后的技术总比先进但不可靠的技术好,只有AMD彻底改变了思路,毕竟这家公司从诞生起,就不缺乏改变的勇气。

勇气是有了,不过AMD能够在显存上革新,还是极大程度上受到了大洋彼岸日本的启发。

1999年,日本超尖端电子技术开发机构(ASET)开始资助采用TSV技术开发的3D IC芯片,该项目名为“高密度电子系统集成技术研发”;2004年,尔必达开始研发TSV技术,同时接受了来自日本政府的新能源与产业技术开发组织(NEDO)的资助;2006年,尔必达与NEC、OKI共同开发出采用TSV技术的堆栈8颗128Mb的DRAM架构……

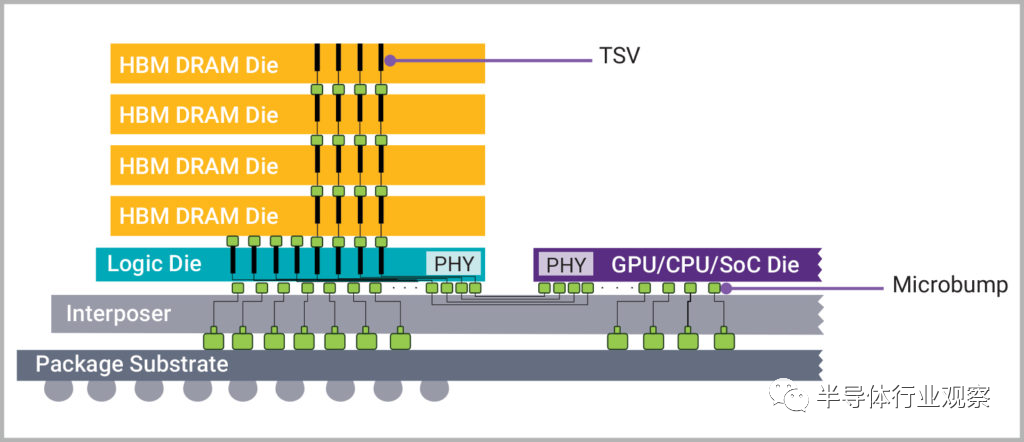

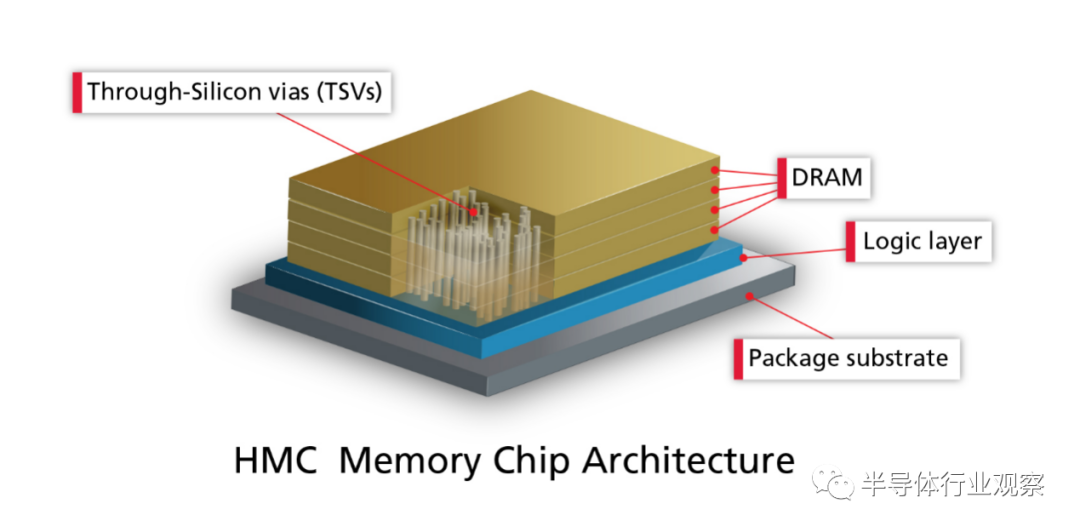

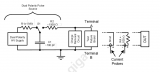

什么是TSV呢?TSV全称为Through Silicon Via,是一种新型三维堆叠封装技术,主要是将多颗芯片(或者晶圆)垂直堆叠在一起,然后在内部打孔、导通并填充金属,实现多层芯片之间的电连接。相比于传统的引线连接多芯片封装方式,TSV能够大大减少半导体设计中的引线使用量,降低工艺复杂度,从而提升速度、降低功耗、缩小体积。

这项技术不光能运用于DRAM领域,在NAND和CIS上也有广阔的前景,其最早就是在闪存上得以实践:东芝在2007 年 4 月推出了具有 8 个堆叠芯片的 NAND 闪存芯片,随后海力士又在 2007 年 9 月推出了具有 24 个堆叠芯片的 NAND 闪存芯片。

2009年,尔必达宣布已成功开发业内第一款TSV DRAM芯片,其使用8颗1GB DDR3 SDRAM堆叠封装而来,并在2011年6月开始交付样品,TSV技术正式走上内存这个大舞台。

紧随其后的是韩国与美国厂商,2011年3月,SK海力士宣布采用TSV技术的16GB DDR3内存(40nm级)研发成功, 9月,三星电子推出基于TSV技术的3D堆叠32GB DDR3(30nm级),10月,三星电子和美光科技联合宣布推出基于 TSV 技术的混合内存立方(HMC) 技术。

AMD在收购ATI后,就已经打起了显存的主意,但想要从头研发全新的显存标准,光靠自己的GPU部门闭门造车显然是不够的,于是AMD拉来了几个至关重要的合作伙伴:有3D 堆叠内存经验的韩厂海力士,做硅中介层的联电,以及负责封装测试的日月光和Amkor。

HBM应运而生,前面提到了GDDR陷入到了内存带宽和功耗控制的瓶颈,而HBM的思路,就是用TSV技术打造立体堆栈式的显存颗粒,让“平房”进化为“楼房”,同时通过硅中介层,让显存连接至GPU核心,并封装在一起,完成显存位宽和传输速度的提升,可谓是一举两得。

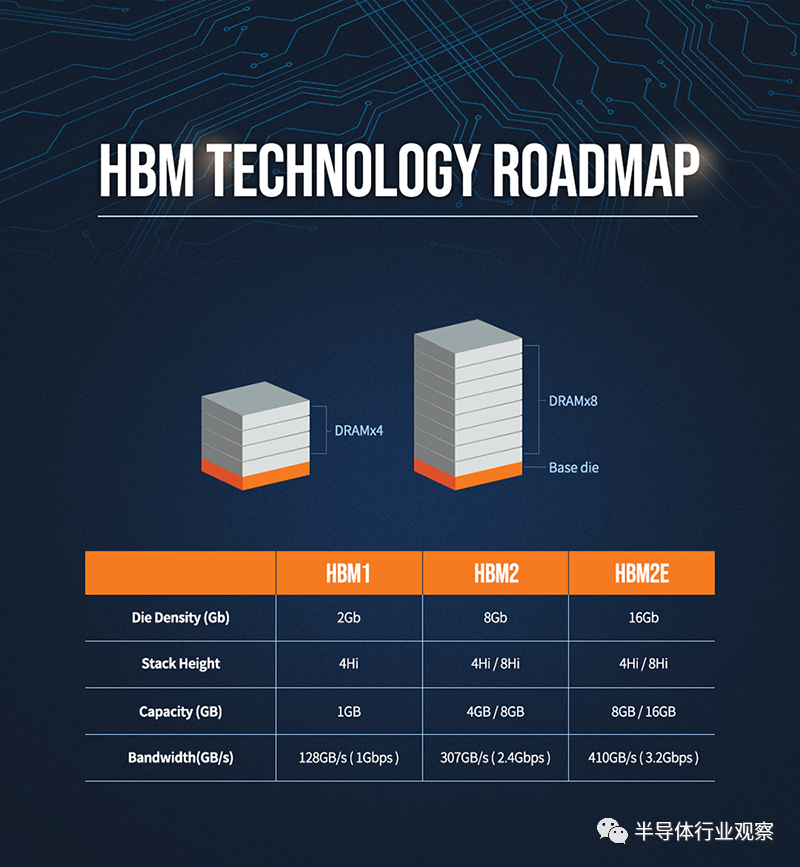

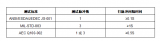

2013年,经过多年研发后,AMD和SK海力士终于推出了HBM这项全新技术,还被定为了JESD235行业标准,HBM1的工作频率约为1600 Mbps,漏极电源电压为1.2V,芯片密度为2Gb(4-hi),其带宽为4096bit,远超GDDR5的512bit。

除了带宽外,HBM对DRAM能耗的影响同样重要,同时期的 R9 290X在DRAM上花费了其250W额定功耗的15-20%,即大约38-50W的功耗,算下来GDDR5每瓦功耗的带宽为10.66GB/秒,而HBM每瓦带宽超过35GB/秒,每瓦能效提高了3倍。

此外,由于GPU核心和显存封装在了一起,还能一定程度上减轻散热的压力,原本是一大片的散热区域,浓缩至一小块,散热仅需针对这部分区域,原本动辄三风扇的设计,可以精简为双风扇甚至是单风扇,变相缩小了显卡的体积。

反正好处多得数不清楚,不论是AMD和SK海力士,还是媒体和众多玩家,都认定了这才是未来的显存,英伟达主导的GDDR已经过时了,要被扫进历史的垃圾堆了。

坏处嘛,前文中提到的旗舰显卡仅支持4GB显存算一个,毕竟高带宽是用来跑高分辨率的,结果显存大小缩水直接让HBM失去了实际应用意义。

而价格更是压倒AMD的最后一根稻草:HBM1的成本已不可考,但8GB HBM2的成本约150美元,硅中介层成本约25美元,总计175美元,同时期的8GB GDDR5仅需52美元,在没有考虑封测的情况下,HBM成本已经是GDDR的三倍左右,一张RX Vega 56零售价才400美元,一半的成本都花在了显存之上,GPU部门本来是要补贴CPU部门的,结果现在情况却要反过来,谁又能担待得起呢?

因而AMD火速取消了后续显卡的HBM显存搭载计划,老老实实跟着英伟达的步伐走了,在RX 5000系列上直接改用了GDDR6显存,HBM在AMD的游戏显卡上二世而亡。

反观英伟达,却是以逸待劳,2016年4月,英伟达发布了Tesla P100显卡,内置16GB HBM2显存,带宽可达720GB/s,具备21 Teraflops的峰值人工智能运算性能。

英伟达在HBM上并未像AMD一样深耕多年,怎么突然反手就是一张搭载了HBM2的显卡,对AMD发起了反攻的号角呢?

背后的原因其实还颇有些复杂,Tesla P100显卡所用的HBM2显存,并非来自于AMD的合作伙伴SK海力士,而是隔壁的三星电子,同样是韩厂的它,在基于TSV技术的3D堆叠内存方面的开发并不逊色于海力士多少,在奋起直追的情况下,很快就缩小了差距,而英伟达正有开发HBM相关显卡之意,二者一拍即合。

至于AMD与联电、日月光、Amkor等好不容易搞定的硅中介层与2.5D封测,英伟达则是找到了业界的另一个大佬——台积电,看上了它旗下的先进封装技术CoWoS(Chip-on-Wafer-on-Substrate),其早在2011年就推出了这项技术,并在2012年首先应用于Xilinx的FPGA上,二者同样是一拍即合。

此后的故事无需赘言,英伟达从P100到V100,从A100再到H100,连续数张高算力的显卡几乎成为了AI训练中的必备利器,出货量节节攀升,甚至超越了传统的游戏显卡业务,而HBM也在其中大放光彩,成为了镶嵌着的最耀眼的一颗宝石。

起了个大早,赶了个晚集,是对AMD在HBM上的最好概括,既没有凭借HBM在游戏显卡市场中反杀英伟达,反而被英伟达利用HBM巩固了AI计算领域的地位,白白被别人摘了熟透甜美的桃子。

三家分内存

在AMD和英伟达这两家GPU厂商争锋相对之际,三家领先的内存厂商也没闲着,开始了在HBM市场的你追我赶的历程。

2013年,SK海力士宣布成功研发HBM1,定义了这一显存标准,但它和AMD一样,好不容易得来的优势却没保持得太久.

2016年1月,三星宣布开始量产4GB HBM2 DRAM,并在同一年内生产8GB HBM2 DRAM,后来者居上,完成了对本国同行的赶超,与HBM1相比,显存带宽实现了翻倍。

2017年下半年,SK海力士的HBM2姗姗来迟,终于宣布量产;2018年1月,三星宣布开始量产第二代8GB HBM2“Aquabolt”。

2018年末,JEDEC推出HBM2E规范,以支持增加的带宽和容量。当传输速率上升到每管脚3.6Gbps时,HBM2E可以实现每堆栈461GB/s的内存带宽。此外,HBM2E支持最多12个DRAM的堆栈,内存容量高达每堆栈24GB。与HBM2相比,HBM2E具有技术更先进、应用范围更广泛、速度更快、容量更大等特点。

2019年8月,SK海力士宣布成功研发出新一代“HBM2E”;2020年2月,三星也正式宣布推出其16GB HBM2E产品“Flashbolt”,于2020年上半年开始量产。

2022年1月,JEDEC组织正式发布了新一代高带宽内存HBM3的标准规范,继续在存储密度、带宽、通道、可靠性、能效等各个层面进行扩充升级,其传输数据率在HBM2基础上再次翻番,每个引脚的传输率为6.4Gbps,配合1024-bit位宽,单颗最高带宽可达819GB/s。

而SK海力士早在2021年10月就发布了全球首款HBM3,并于2022年6月正式量产,供货英伟达,击败了三星,再度于HBM上拿到了技术和市场优势。

三星自然也不甘示弱,在它发布的路线图中,2022年HBM3技术已经量产,2023年下半年开始大规模生产,预计2024年实现接口速度高达7.2Gbps的下一代HBM技术——HBM3p,将数据传输率进一步提升10%,从而将堆叠的总带宽提升到5TB/s以上。

讲到这里,大家不免会心生疑问,都说了是三家分内存,这三星和海力士加一块就两家啊,还都是韩国的,另外一家跑哪去了呢?

身在美国的美光当然没有忽视显存市场,作为尔必达的收购者,它对于3D堆叠的TSV技术怎么也不会陌生,甚至在HBM发布之前,还有不少TSV技术方面的优势。

但是美光却没跟着AMD或英伟达去鼓捣HBM技术,而是回头选择了英特尔,搞出了HMC(混合内存)技术,虽然也使用了TSV,但它有自己的控制器芯片,并且完全封装在PCB基板之上,和HBM截然不同,也完全不兼容。

2011年9月,美光正式宣布了第一代HMC,并在2013年9月量产了第二代HMC,但响应者却寥寥无几,第一个采用 HMC 内存的处理器是富士通的SPARC64 XIfx,其搭载于2015 年推出的富士通PRIMEHPC FX100 超算,而后就鲜见于各类产品中。

随着2018年8月,美光宣布正式放弃HMC后,才匆匆忙忙转向GDDR6和HBM产品的研发,幸好3D堆叠技术的底子还在那里,不至于说完全落后于两个韩厂。2020年,美光正式表示将开始提供HBM2产品,用于高性能显卡,服务器处理器等产品,其在财报中预计,将在2024年第一季度量产HBM3产品,最终赶上目前领先的竞争对手。

AI大潮仍然席卷全球,而英伟达H100和A100显卡依旧火热,HBM作为内存市场的新蛋糕,却是最鲜美的一块。芯片行业咨询公司 SemiAnalysis 表示,HBM 的价格大约是标准 DRAM 芯片的五倍,为制造商带来了更大的总利润。目前,HBM 占全球内存收入的比例不到 5%,但 SemiAnalysis 项目预计到 2026 年将占到总收入的 20% 以上。

这块鲜美的蛋糕大部分留给了先行者,集邦咨询调查显示,2022年三大原厂HBM市占率分别为SK海力士50%、三星约40%、美光约10%,十成里面占一成,美光自认为产品不逊于韩厂,但市场却从不会为某个自恃技术领先的厂商网开一面。

总结

当初尔必达的坂本幸雄认为日本半导体输人不输阵,时任美光CEO莫罗特亚在接受采访时也表示,AI 领域不光有 HBM,还包含高密度 DDR5、美光定制LP DRAM以及一部分图形内存,概括来说,就是输了HBM但还没在AI上认输。

倘若让这俩CEO总结失败的教训,恐怕只能发出一句“时也,命也,运也,非吾之所能也”之泪的感慨吧,输当然是不可能输的,美光和尔必达即使倒闭也不会说技术不行,把过错归咎于市场,落了个一身轻松。

再回过头来看,AMD 在2015年发布R9 Fury X时的判断错了吗?当然没错,内存带宽的的确确到了瓶颈,从GDDR5到GDDR6X几乎没有进步,但在游戏显卡,可以采用大型缓存作为帧缓冲区,让成本较低的GDDR接着上路,但数据中心和AI加速卡的带宽问题却非HBM不可,成本在这一领域反倒成了最不起眼的问题。

如今AMD调转船头,再战AI领域,希望HBM能让他们在这个市场腾飞。

-

处理器

+关注

关注

68文章

20148浏览量

247133 -

HBM

+关注

关注

2文章

426浏览量

15698 -

AI芯片

+关注

关注

17文章

2063浏览量

36567

原文标题:HBM的崛起!

文章出处:【微信号:IC学习,微信公众号:IC学习】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

AI大算力的存储技术, HBM 4E转向定制化

HBM技术在CowoS封装中的应用

传英伟达自研HBM基础裸片

突破堆叠瓶颈:三星电子拟于16层HBM导入混合键合技术

HBM应用在手机上,可行吗?

SK海力士HBM技术的发展历史

Cadence推出HBM4 12.8Gbps IP内存系统解决方案

简要分析HBM人体放电模型

三星电子将供应改良版HBM3E芯片

美光新加坡HBM内存封装工厂破土动工

AI兴起推动HBM需求激增,DRAM市场面临重塑

AEC-Q102之静电放电测试(HBM)

HBM的崛起!

HBM的崛起!

评论