电子发烧友网报道(文/周凯扬)当下服务器市场在内存上面临的一大挑战就是成本,截至今日,我们在选择云服务容器时,内存依然占了很大一部分,往往内存用量扩大一倍后,价格也随之上涨了一倍。这其实与内存本身的扩展性有关,目前服务器上更大的存储已经成为常态,但要想实现更大的内存始终存在瓶颈。因此,从2013年开始,每bit内存的价格基本趋于平缓了。

但服务器CPU的核心数增加的速度可没有因此减缓下来,加上AI等新型工作负载的引入,更大的内存容量、更大的内存带宽,都成了当下服务器内存面临的痛点。为此,业界开始考虑从系统层级上来解决这些问题,比如为CPU增加DDR通道,好让其支持更大的带宽和容量。

但这就又引入了一系列新问题,为了满足新增的DDR通道,需要更多的引脚,也提高了成本降低了可靠性,PCB的层数也开始增加。这也造就了整个服务器主板的尺寸变得异常大,甚至难以放进1U标准尺寸的机柜里。

CXL的灵活性和延迟

这时对于内存媒介无限制的CXL,就提供了一个灵活的内存接口,让设计者可以从持久性、延迟、带宽等各个参数特性上灵活选择,让服务器CPU不止可以使用常用的DDR内存,也能支持LPDDR5和持久内存等等。我们此前已经多次介绍过CXL了,这次就来讲下作为内存扩展,CXL有哪些优势。

比如一个80核的CPU,应用要求每个核心配置2GB的DDR5内存,也就是需要160GB的DDR5内存。如果采用16GB DIMM x8的配置明显满足不了,32GB x 8多出了96GB内存,徒增了近乎500美元的成本,使用32GB x 5这样不跑满通道的配置虽然容量对了,但是会降低带宽和性能。

而这时我们反观CXL,CXL可以在配置了原生DDR通道配置了8个16GB DIMM的情况下,再加入32GB的CXL内存,如此一来不仅满足了内存容量的需求,还增加了额外的带宽,况且我们已经提到了CXL并没有内存媒介的限制,所以可以用上LPDDR5之类的CXL扩展内存进一步降低成本。

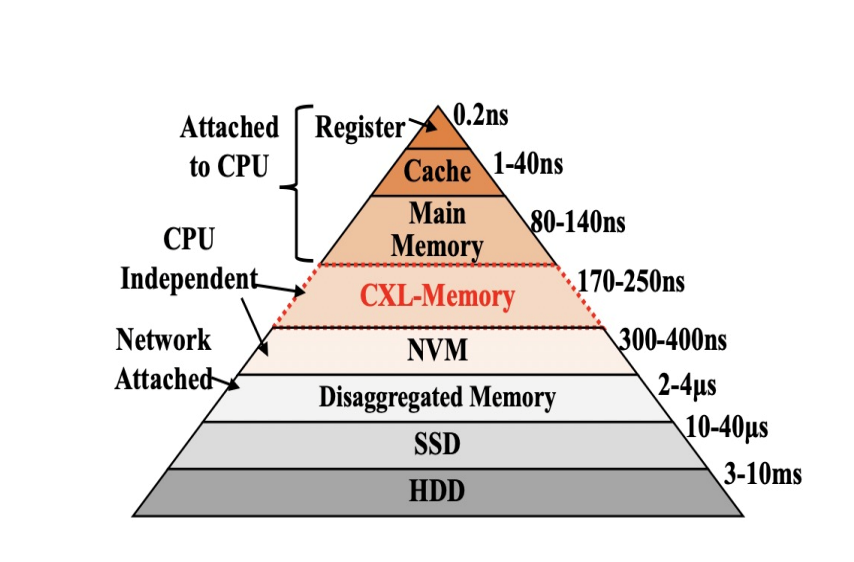

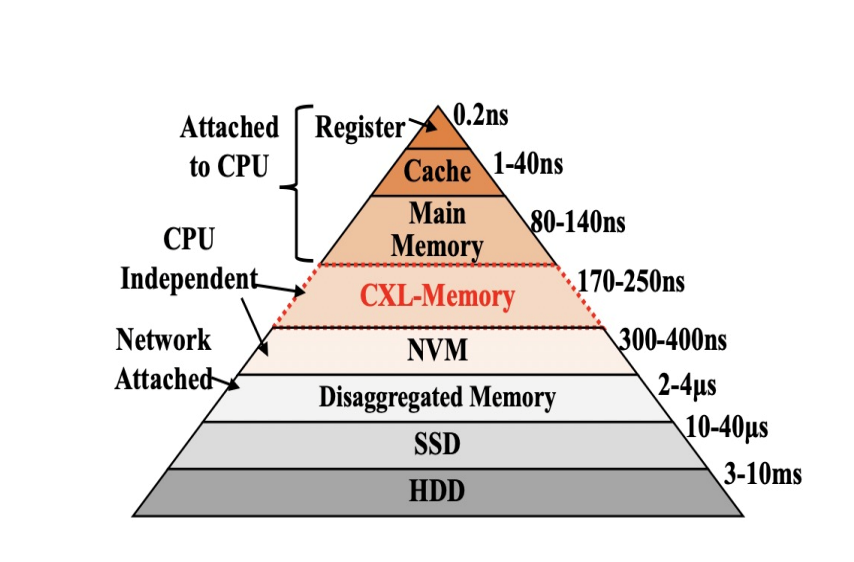

各种缓存、内存和存储的延迟对比 / CXL联盟

作为一个分布式内存,尽管CXL主打的是低延迟,但要说与CPU的内存、缓存和寄存器比起来,延迟还是有一定差距的。今年的Hot Chips上,CXL联盟就给出了CXL在延迟上的具体数字。独立于CPU外的CXL内存延迟在170-250ns左右,高过独立于CPU的NVM、网络连接的解构内存、SSD和HDD等。

虽然在我们看来这个数字已经很小了,但相较原生的主要内存,还是把延迟扩大了两倍。来自Meta和AMD的两位专家提出了一个概念,也就是对内存进行分层,分为用于实时分析等关键任务的“热”内存、访问不那么频繁的“暖”内存和用于庞大数据的“冷”内存。“热”内存页面放在原生DDR内存里,而“冷”内存页面则交给CXL内存。

然而在当前的软件眼里,它们才分不清楚什么是“热”内存和“冷”内存,原生内存用完后,就开始去占用CXL内存,如此一来原本作为“冷”内存的CXL,也开始变成“热”内存。所以目前最大的挑战就是在操作系统和软件层面,如何检测到“冷”内存页面,将其主动转入CXL内存里,为原生内存留出空间。Meta和AMD的两位专家表示,他们已经在开发相应的软硬件技术。

CXL或许不会成为HPC和AI应用的宠儿

固然CXL对于云服务厂商和诸多数据中心拥有不错的吸引力,然而这种形式的内存可能并不适用于HPC与超算应用。“富岳之父”松冈聪教授表示CXL这种内存解构方案还存在不少技术问题,使其不能在主流的HPC甚至是AI负载中物尽其用。松冈聪教授并没有给出具体的细节,但他给出了一个例子,那就是多年前SGI的NUMALINK系统也是采用了分布式内存解构的方式,但我们也都知道如今市面上的NUMALINK产品基本已经销声匿迹了。

但他并没有彻底否认内存解构这种思路,就连富岳超算本身也用这一技术,从而将MPI进行put/get运算时的远程内存访问延迟降低至亚微秒级。但加入一个单独的UMA内存池,已经在历史中证明了这对HPC来说收效甚微。

首先,这需要更高硬件交换机成本,再者,在超算这种大型配置规模的系统上,缺乏对应的编程标准。因此,对于目前的HPC大型系统来说,CXL内存或许会先出现在一小部分节点上,比如一些需要近存或存内计算AI负载,而不会普及到整个系统。

写在最后

其实对于CXL的担心也没必要那么多,对于服务器市场来说,低核心数的CPU依然会继续使用原生DDR通道来配置DIMM内存。到了高核心数CPU上,再根据系统成本、容量、功耗和带宽等参数来灵活应用CXL内存,而这才是CXL带来的最大优势,灵活性。况且目前CXL内存还没有大规模量产出来,自然也没有普及开来,大家对其实际性能表现还没有个大致了解,也许引入CXL的延迟后,对性能的损失不会那么糟糕。

但服务器CPU的核心数增加的速度可没有因此减缓下来,加上AI等新型工作负载的引入,更大的内存容量、更大的内存带宽,都成了当下服务器内存面临的痛点。为此,业界开始考虑从系统层级上来解决这些问题,比如为CPU增加DDR通道,好让其支持更大的带宽和容量。

但这就又引入了一系列新问题,为了满足新增的DDR通道,需要更多的引脚,也提高了成本降低了可靠性,PCB的层数也开始增加。这也造就了整个服务器主板的尺寸变得异常大,甚至难以放进1U标准尺寸的机柜里。

CXL的灵活性和延迟

这时对于内存媒介无限制的CXL,就提供了一个灵活的内存接口,让设计者可以从持久性、延迟、带宽等各个参数特性上灵活选择,让服务器CPU不止可以使用常用的DDR内存,也能支持LPDDR5和持久内存等等。我们此前已经多次介绍过CXL了,这次就来讲下作为内存扩展,CXL有哪些优势。

比如一个80核的CPU,应用要求每个核心配置2GB的DDR5内存,也就是需要160GB的DDR5内存。如果采用16GB DIMM x8的配置明显满足不了,32GB x 8多出了96GB内存,徒增了近乎500美元的成本,使用32GB x 5这样不跑满通道的配置虽然容量对了,但是会降低带宽和性能。

而这时我们反观CXL,CXL可以在配置了原生DDR通道配置了8个16GB DIMM的情况下,再加入32GB的CXL内存,如此一来不仅满足了内存容量的需求,还增加了额外的带宽,况且我们已经提到了CXL并没有内存媒介的限制,所以可以用上LPDDR5之类的CXL扩展内存进一步降低成本。

各种缓存、内存和存储的延迟对比 / CXL联盟

作为一个分布式内存,尽管CXL主打的是低延迟,但要说与CPU的内存、缓存和寄存器比起来,延迟还是有一定差距的。今年的Hot Chips上,CXL联盟就给出了CXL在延迟上的具体数字。独立于CPU外的CXL内存延迟在170-250ns左右,高过独立于CPU的NVM、网络连接的解构内存、SSD和HDD等。

虽然在我们看来这个数字已经很小了,但相较原生的主要内存,还是把延迟扩大了两倍。来自Meta和AMD的两位专家提出了一个概念,也就是对内存进行分层,分为用于实时分析等关键任务的“热”内存、访问不那么频繁的“暖”内存和用于庞大数据的“冷”内存。“热”内存页面放在原生DDR内存里,而“冷”内存页面则交给CXL内存。

然而在当前的软件眼里,它们才分不清楚什么是“热”内存和“冷”内存,原生内存用完后,就开始去占用CXL内存,如此一来原本作为“冷”内存的CXL,也开始变成“热”内存。所以目前最大的挑战就是在操作系统和软件层面,如何检测到“冷”内存页面,将其主动转入CXL内存里,为原生内存留出空间。Meta和AMD的两位专家表示,他们已经在开发相应的软硬件技术。

CXL或许不会成为HPC和AI应用的宠儿

固然CXL对于云服务厂商和诸多数据中心拥有不错的吸引力,然而这种形式的内存可能并不适用于HPC与超算应用。“富岳之父”松冈聪教授表示CXL这种内存解构方案还存在不少技术问题,使其不能在主流的HPC甚至是AI负载中物尽其用。松冈聪教授并没有给出具体的细节,但他给出了一个例子,那就是多年前SGI的NUMALINK系统也是采用了分布式内存解构的方式,但我们也都知道如今市面上的NUMALINK产品基本已经销声匿迹了。

但他并没有彻底否认内存解构这种思路,就连富岳超算本身也用这一技术,从而将MPI进行put/get运算时的远程内存访问延迟降低至亚微秒级。但加入一个单独的UMA内存池,已经在历史中证明了这对HPC来说收效甚微。

首先,这需要更高硬件交换机成本,再者,在超算这种大型配置规模的系统上,缺乏对应的编程标准。因此,对于目前的HPC大型系统来说,CXL内存或许会先出现在一小部分节点上,比如一些需要近存或存内计算AI负载,而不会普及到整个系统。

写在最后

其实对于CXL的担心也没必要那么多,对于服务器市场来说,低核心数的CPU依然会继续使用原生DDR通道来配置DIMM内存。到了高核心数CPU上,再根据系统成本、容量、功耗和带宽等参数来灵活应用CXL内存,而这才是CXL带来的最大优势,灵活性。况且目前CXL内存还没有大规模量产出来,自然也没有普及开来,大家对其实际性能表现还没有个大致了解,也许引入CXL的延迟后,对性能的损失不会那么糟糕。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

服务器

+关注

关注

13文章

10093浏览量

90890 -

2cxl

+关注

关注

0文章

5浏览量

6522

发布评论请先 登录

相关推荐

热点推荐

服务器数据恢复—服务器断电导致raid模块损坏的数据恢复案例

某品牌服务器中有12块硬盘,组建了一组raid5磁盘阵列,服务器内存储的是普通文件。

机房供电不稳定导致服务器断电,管理员重启服务器后发现

澜起科技推出CXL® 3.1内存扩展控制器,助力下一代数据中心基础设施性能升级

下一代数据中心服务器提供更高带宽、更低延迟的内存扩展和池化解决方案。 澜起科技CXL 3.1内存扩展控制器采用PCIe® 6.2物理层接口,

高通SoC阵列服务器

高通SoC阵列服务器是基于高通系统级芯片(SoC)构建的高密度计算解决方案,核心特点为低功耗、高算力集成与模块化设计,主要应用于边缘计算和云服务场景。以下是其技术特性和应用方向的综合分析: 一

DeepSeek企业级部署服务器资源计算 以raksmart裸机云服务器为例

以RakSmart裸机云服务器为例,针对DeepSeek企业级部署的服务器资源计算指南,涵盖GPU/CPU/内存/存储/网络等核心维度的详细计算方法与配置推荐,主机推荐小编为您整理发布以raksmart裸机云

SMART Modular CXL AIC内存扩充卡获CXL联盟认证

近日,全球领先的整合型内存与储存解决方案提供商SMART Modular世迈科技(隶属于Penguin Solutions™集团)宣布,其4-DIMM和8-DIMM CXL®(Compute

SMART Modular世迈科技CXL内存扩充卡获CXL联盟认证

SMART Modular世迈科技近日宣布其4-DIMM和8-DIMM CXL®(Compute Express Link®)内存扩充卡已成功通过CXL 2.0认证测试,并正式被列入CXL

澜起科技CXL®内存扩展控制器芯片通过CXL 2.0合规性测试

近日,澜起科技在CXL(Compute Express Link)技术领域取得了又一重要里程碑。其自主研发的CXL®内存扩展控制器(MXC)芯片成功通过了

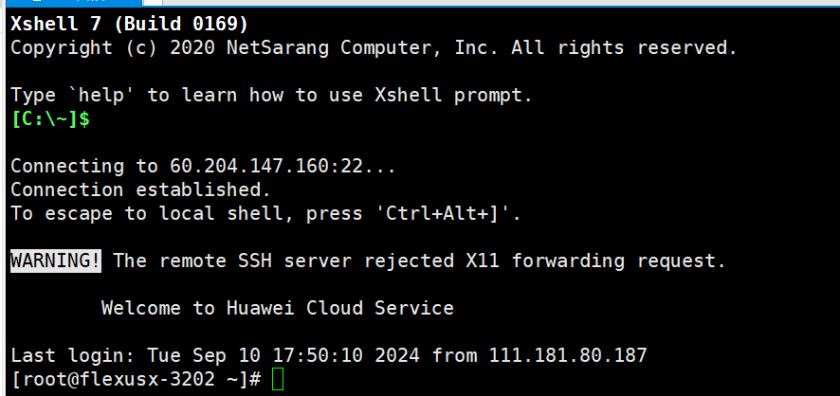

云服务器 Flexus X 实例,镜像切换与服务器压力测试

云服务器 Flexus X 压力测试 1、购买华为云 Flexus X 实例 Flexus云服务器X实例-华为云 (huaweicloud.com) 2、xshell 远程连接服务器 3、安装

Jtti:新加坡服务器的性能如何评估

支持高达16GB的DDR3内存配置,为运行多个应用程序和处理大量工作负载提供充足的内存。同时,服务器配备了500GB SSD,提供快速的读写速度,显著提高了系统性能和应用程序响应速度。 网络性能 :Jtti新加坡

救场服务器内存的CXL

救场服务器内存的CXL

评论