对话式 AI 是一种综合运用多种技术的复杂的人工智能形式,能够使人机间实现类似于真人的交互。复杂系统能够识别语音和文本、理解意图、识别特定语言的习语和格言,并且能够以适当的自然语言做出回应。

什么是对话式 AI?

对话式 AI 是应用机器学习来开发基于语言的应用程序,使人们能够通过语音与设备、机器和计算机进行自然交互。

无论是虚拟助手在早上唤醒您,还是您询问通勤路线,或者您在网购时与聊天机器人进行交流,这些情况中您均在使用对话式 AI。您用正常的声音说话,而设备可以理解并找到适当答案,然后用听起来自然的声音回复您。

对话式 AI 的应用程序有多种形式。最简单的是 FAQ 机器人,它们经过训练,可以从具有预先格式化答案的定义数据库中回复查询(通常是以书面形式表达)。一种更复杂的对话式 AI 形式是虚拟个人助理,例如 Amazon 的 Alexa、Apple 的 Siri 和 Microsoft 的 Cortana。这些工具设备经过调节,可以回应简单的请求。

虚拟客户助理是一种更专业的个人助理版本,它能够理解上下文,从一个互动到下一个互动进行对话。另一种专门的对话式 AI 形式是虚拟员工助理,它可以了解员工与软件应用程序和工作流程之间的互动情况,并提出改进建议。虚拟员工助理广泛用于机器人流程自动化这一热门的新软件类别。

为何选择对话式 AI?

对话式 AI 是人类与智能机器和应用程序(从机器人和汽车到家庭助理和移动应用)互动的基本构建块。让计算机理解人类语言及所有细微差别,并做出适当的反应,这是 AI 研究人员长期以来的追求。但是,在采用加速计算的现代 AI 技术出现之前,构建具有真正自然语言处理 (NLP) 功能的系统是无法实现的。

在过去几年中,深度学习改进了对话式 AI 的技术水平,并且在某些任务上提供了超人的准确性。深度学习还降低了构建语言服务时,对语言学和基于规则的技术的深度知识的需求,从而在零售、医疗健康和金融等行业中得到了广泛采用。

现如今,人们对高级对话式 AI 工具的需求日益增加。预计到 2020 年,50% 的搜索结果将由语音执行,且到 2023 年,将有 80 亿个数字语音助手投入使用。

对话式 AI 的工作原理是什么?

回答问题的步骤如下:将用户语音转换为文本,理解文本含义,搜索符合上下文的适当应答,最后使用文本转语音工具提供应答。对话式 AI 流程通常由三个阶段组成:

自动语音识别 (ASR)

自然语言处理 (NLP) 或自然语言理解 (NLU)

带有语音合成的文本转语音 (TTS)

每一步都需要运行多个 AI 模型,因此每个单独网络的可用执行时间约为 10 毫秒或更短。

自动语音识别 (ASR) 会收录人类语音,然后将其转换为可读文本。深度学习在识别音素时具有更高的准确性,已经取代了传统的统计方法,如隐马尔可夫模型和高斯混合模型。

自然语言理解 (NLU) 会录入文本,理解上下文和意图,然后生成智能回复。深度学习模型能对众多上下文和语言准确进行泛化处理,因此应用于 NLU。Transformer 深度学习模型,如 BERT(Transformer 双向编码器表征模型),是时间递归神经网络的一个替代方案,它应用了一种注意力技术—通过将注意力集中在前后最相关的词上来解析一个句子。BERT 通过在问答 (QA)、实体识别、意图识别、情感分析等基准上提供与人类基准相媲美的准确性,彻底改变了 NLU 的进展。

对话式 AI 流程的最后一个阶段是将 NLU 阶段生成的文本响应改为自然发音的语音。声清晰度是通过使用深度神经网络实现的,生成类似人类的语调和清晰的单词发音。此步骤是通过两个网络完成的:一个根据文本生成频谱图的合成网络,一个从频谱图生成波形的声码器网络。

GPU:对话式 AI 的关键

对话式 AI 背后的技术十分复杂,涉及多步骤过程,需要大量的功耗计算,并要在 300 毫秒内完成大量计算,才能提供优质的用户体验。

一个由数百个核心组成的 GPU,可以并行处理数千个线程。这使得 GPU 成为训练深度学习模型和执行推理的首选平台,因为它们的性能比纯 CPU 平台高 10 倍。

借助 NVIDIA GPU 和 NVIDIA® CUDA-X AI™ 库,可快速训练和优化大量的先进语言模型,从而在几毫秒或几千分之一秒内运行推理。这是一项重大进步,可以结束快速 AI 模型与大型复杂 AI 模型之间的权衡。

此外,像 BERT 这样的基于 Transformer 深度学习模型不需要按顺序处理连续数据,与递归神经网络相比,可以在 GPU 上实现更多的并行化,并减少训练时间。

NVIDIA GPU 助力加速先进的对话式 AI 技术:

自动语音识别 (ASR):Kaldi 是一种 C++ 工具包,支持传统方法以及用于 ASR 的热门深度学习模型。GPU 加速的 Kaldi 解决方案的执行速度比实时音频快 3500 倍,比只用 CPU 的方案快 10 倍。

自然语言理解 (NLU):在与复杂语言模型协作时,NVIDIA GPU 的并行处理能力和 Tensor Core 架构可实现更高的吞吐量和可扩展性,从而为 BERT 的训练和推理提供突破性的性能。利用 NVIDIA T4,GPU 加速的 BERT-base 进行推理的速度比单纯的 CPU 解决方案快 17 倍。BERT 使用无监督式学习方法的能力、使用预训练模型进行迁移学习的能力,以及使用 GPU 进行加速的能力,均使其在行业中得到广泛应用。为实现真正的对话式 AI,语言模型变得越来越大。未来的模型将比现在使用的大很多倍,因此 NVIDIA 构建并开源了迄今为止最大的基于 Transformer 的 AI:GPT-2 8B,这是一种内含 83 亿参数的语言处理模型,比 BERT 大 24 倍。

文字转语音 (TTS):热门文本转语音深度学习模型(GPU 加速的 Tacotron2 和 Waveglow)使用 NVIDIA T4 GPU 执行推理的速度比仅使用 CPU 的 解决方案快 9 倍。

对话式 AI 用例

GPU 优化的语言理解模型可集成到医疗健康、零售和金融服务等行业的 AI 应用程序中,为智能扬声器和客户服务领域中的高级数字语音助手提供支持。通过使用这些高质量的对话式 AI 工具,各个领域的企业在与客户交流时,均可实现前所未有的个性化服务标准。

医疗健康

医疗健康面临的困难之一是难以获得。打医生办公室电话并一直等待的情况十分常见,与索赔代表联系可能同样困难。通过实施自然语言处理 (NLP) 来训练聊天机器人是医疗健康行业的一项新兴技术,可以解决医疗专业人员的短缺问题,并开创与患者的沟通渠道。

NLP 的另一个重要的医疗健康应用程序是生物医学文本挖掘(或 BioNLP)。鉴于生物文献数量众多,以及生物医学出版速度不断提高,自然语言处理是一个关键的工具,可以在已发表的研究中提取信息,推动生物医学领域的知识进步,协助药物研发和疾病诊断。

金融服务

自然语言处理 (NLP) 是为金融服务公司构建更好的聊天机器人和 AI 助理的关键组成部分。在众多用于基于 NLP 的应用程序的语言模型中,BERT 已成为机器学习领域 NLP 的领军者及语言模型。借助 AI,NVIDIA 近期打破了 BERT 训练速度的记录,有助于释放未来几年内在线提供的数十亿预期对话式 AI 服务的潜力,使其达到人类水平的理解能力。例如,银行可以使用 NLP 来评估信用记录很少或没有信用记录的客户信誉。

零售

聊天机器人技术还常用于零售应用程序,能够准确分析客户查询,并生成回复或建议。这可简化客户流程,并提高商店运营效率。NLP 还用于文本挖掘客户反馈和情感分析。

对话式 AI 的优势

对此有许多答案。其中一点是人力成本很高。虽然成本差异很大,但根据 F.Curtis Barry 公司的数据,一个客服电话的全部成本介于 2.70 美元到 5.60 美元之间,其他公司估算的平均价格也要达到每分钟一美元左右。将人工操作员替换为机器人,这具有显著节约成本的优势。研究还表明,相较于销售或客户服务智能体,许多人更喜欢与电脑对话,这使得对话式 AI 成为客户自助服务的实现者。

在许多场景中,比如一个人正在开车或忙于其他事情,又或者在电梯中无法使用键盘时,对话式 AI 比键盘交互更加合适。

核心技术还可用于解释或完善模糊查询,或解释使用不同语言的人的查询。

Gartner 认为,85% 的客户与企业的关系无需人工交互即可处理,McKinsey 公司估计,全球约 60% 的职业中的有三分之一的活动可以使用这项技术。

NVIDIA GPU 加速的对话式 AI 工具

借助对话式 AI 部署服务似乎令人生畏,但 NVIDIA 拥有可以简化这一过程的工具,包括神经模组(简称 NeMo)和一项名为 NVIDIA Riva 的新技术。为节省时间,预训练模型、训练脚本和性能结果可在 NVIDIA GPU Cloud (NGC) 软件中心获得。

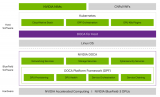

NVIDIA Riva 是一种 GPU 加速应用程序框架,允许公司使用视频和语音数据,为自己的行业、产品和客户定制最先进的对话式 AI 服务。

Riva 提供用于对话式 AI 的端到端深度学习流程。它包含先进的深度学习模型,例如用于自然语言理解的 NVIDIA Megatron BERT。企业可以利用 NVIDIA NeMo 进一步在数据上调优这些模型,利用 NVIDIA TensorRT™ 优化推理,并利用 NGC(NVIDIA 的 GPU 优化软件目录)上提供的 Helm 图表在云端和边缘进行部署。

使用 Riva 构建的应用程序可以利用新款 NVIDIA A100 Tensor Core GPU 中的创新技术进行 AI 计算,并利用 NVIDIA TensorRT 的新型优化技术进行推理。这使得使用功能强大的视觉和语音模型能够运行整个多模态应用程序,并且速度比实时交互的 300 毫秒阈值还要快。

NVIDIA GPU 加速的端到端数据科学

基于 CUDA 构建的 RAPIDS™ 开源软件库套件使您能够完全在 GPU 上执行端到端数据科学和分析流程,同时仍然使用 Pandas 和 Scikit-Learn API 等熟悉的界面。

NVIDIA GPU 加速的深度学习框架

GPU 加速深度学习框架为设计和训练自定义深度神经网络带来灵活性,并为 Python 和 C/C++ 等常用编程语言提供编程接口。MXNet、PyTorch、TensorFlow 等广泛使用的深度学习框架依赖于 NVIDIA GPU 加速库,能够提供高性能的多 GPU 加速训练。

对话式 AI 在 NVIDIA 平台的未来

推动基于 Transformer 语言网络(如 BERT 和 GPT-2 8B)的大规模性能的要求,即其纯粹的复杂性以及对庞大数据集的预训练。这种组合需要一个可靠的计算平台来处理所有必要的计算,以推动快速执行和准确性。这些模型可以在大量无标记数据集上工作,这使得它们成为现代 NLP 的创新中心,而且,对于即将在众多用例中采用对话式 AI 应用程序的新一波智能助手来说,这是一个强有力的选择。

带有 Tensor Core 体系架构的 NVIDIA 平台提供可编程性,以加速各种不同的现代 AI,包括基于 Transformer 的模型。此外,数据中心规模设计和 DGX SuperPOD™ 的最优化,与软件库和先进 AI 框架的直接支持相结合,为开发者提供了无缝的端到端平台,以承担艰巨的 NLP 任务。

NGC(NVIDIA 加速软件中心)免费提供持续优化,以便加速 BERT 和 Transformer 在多个框架上的 GPU 训练。

NVIDIA TensorRT 包括对 BERT 和基于 Transformer 的大型模型运行实时推理的优化。如需了解更多信息,请查看我们的“对话式 AI 实时 BERT 推理”博客。NVIDIA 的 BERT GitHub 仓库今天也有代码,可以重现本博客中引用的单节点训练性能,在不久的将来,该仓库将更新必要的脚本,以重现大规模训练性能的数字。

-

NVIDIA

+关注

关注

14文章

5496浏览量

109045 -

gpu

+关注

关注

28文章

5097浏览量

134415 -

AI

+关注

关注

89文章

38077浏览量

296303 -

软件库

+关注

关注

0文章

15浏览量

7938

发布评论请先 登录

NVIDIA RTX PRO 2000 Blackwell GPU性能测试

通过NVIDIA Jetson AGX Thor实现7倍生成式AI性能

NVIDIA全栈加速代理式AI应用落地

NVIDIA技术助力企业创建主权AI智能体

NVIDIA携手诺和诺德借助AI加速药物研发

NVIDIA携手微软加速代理式AI发展

使用NVIDIA RTX PRO Blackwell系列GPU加速AI开发

英伟达GTC2025亮点:Oracle与NVIDIA合作助力企业加速代理式AI推理

Oracle 与 NVIDIA 合作助力企业加速代理式 AI 推理

利用NVIDIA DPF引领DPU加速云计算的未来

NVIDIA GPU助力加速先进对话式AI技术

NVIDIA GPU助力加速先进对话式AI技术

评论