近期外网爆出传闻,AMD下一代Zen 4核心的EPYC Genoa处理器可能会配备HBM内容,以求与英特尔的下一代服务器CPU Xeon Sapphire Rapids争雄。巧合的是,近日Linux内核补丁中也透露了消息,AMD下一代基于CDNA 2核心的Instinct MI200 GPU也将用到HBM2e,显存更是高达128GB。这意味着AMD很可能会在服务器市场全面拥抱HBM。

已与消费显卡市场无缘的HBM

HBM作为一种高带宽存储器,其实是由AMD最先投入研发的高性能DRAM。为了实现这一愿景,AMD找来了有3D堆叠工艺生产经验的SK海力士,并借助互联和封装厂商的帮助,联合开发出了HBM存储器。

AMD也是首个将其引入GPU市场的厂商,并应用在其Fiji GPU上。随后2016年,三星率先开始了HBM2的量产,AMD被英伟达抢了风头,后者率先将这一新标准的存储器应用在其Tesla P100加速卡上。

当时HBM的优缺点都十分明显了,从一开始以来的带宽优势正在被GDDR6迎头赶上,设计难度和成本又是一道难以迈过的坎。虽然高端显卡上这些成本并不占大头,但中低端显卡用到HBM就比较肉疼了。但AMD并没有因此放弃HBM2,而是在Vega显卡上继续引入了HBM2。

不过,这可能也就是我们最后一次在消费级GPU上见到HBM了,AMD在之后的RDNA架构上再也没有使用HBM,仅仅只有基于CDNA架构且用于加速器的GPU上还在使用HBM。

为什么是服务器市场?

HBM是如何在服务器市场扎根的呢?这是因为HBM最适合的应用场景之一就是功率受限又需要最大带宽的环境,完美达到HPC集群中进行人工智能计算,或是大型密集计算的数据中心的要求。

这也就是这些包含数据中心业务的公司持续使用HBM的原因,英伟达在性能强大的服务器GPU A100中依然在使用HBM2和HBM2e,甚至可能会在下一代Hopper结构继续沿用下去。据传,英特尔尚未面世的Xe-HP和Xe-HPC GPU也将使用HBM。

不过这两家厂商的消费级GPU都不约而同的避过了HBM,选择了GDDR6和GDDR6X,可想而知他们都不想走AMD的弯路。

至于AMD在CPU上率先使用HBM也并非空穴来风,在AMD去年公布的一份专利中,就在芯片设计上出现了HBM。英特尔推出的竞品Xeon Sapphire Rapids服务器CPU也正式宣布将使用HBM,不过量产要等到2023年。这些可以看出HBM在服务器市场有多“香”,他们都开始将HBM向CPU上发展。

下一代HBM

虽然制定标准的JEDEC尚未推出HBM3的相关规范,但一直在研究下一代HBM的SK海力士在今年6月透露了HBM3的最新情报,HBM将迎来进一步的性能提升。

HBM2E的带宽可达460GB/s,I/O速率可达3.6Gbps,而HBM3的带宽可以达到665GB/s以上,I/O速率超过5.2Gbps。这还是只是速率的下限而已,要知道SiFive与OpenFive今年流片的5nm RISC-V SoC也加入了HBM3的IP,最高支持的数据传输率达到7.2Gbps。

SK海力士能做到如此高的性能提升,很可能得益于去年与Xperi签订的专利许可协议。这些协议中包含了DBI Ultra 2.5D/3D互联技术,可以用于3DS、HBM2、HBM3及后续DRAM产品的创新开发。传统的铜柱互联只能做到每平方毫米625个互联,而DBI Ultra可以在同样的面积下做到10万个互联。

结语

从JEDEC2018年宣布HBM2E标准以来,HBM已经近3年没有更新了。三星更是在今年2月宣布开发带有人工智能引擎的HBM-PIM,未来HBM3是否能在服务器领域继续称雄,相信当前几大厂商规划的服务器产品中HBM占比已经给出了答案。

已与消费显卡市场无缘的HBM

HBM作为一种高带宽存储器,其实是由AMD最先投入研发的高性能DRAM。为了实现这一愿景,AMD找来了有3D堆叠工艺生产经验的SK海力士,并借助互联和封装厂商的帮助,联合开发出了HBM存储器。

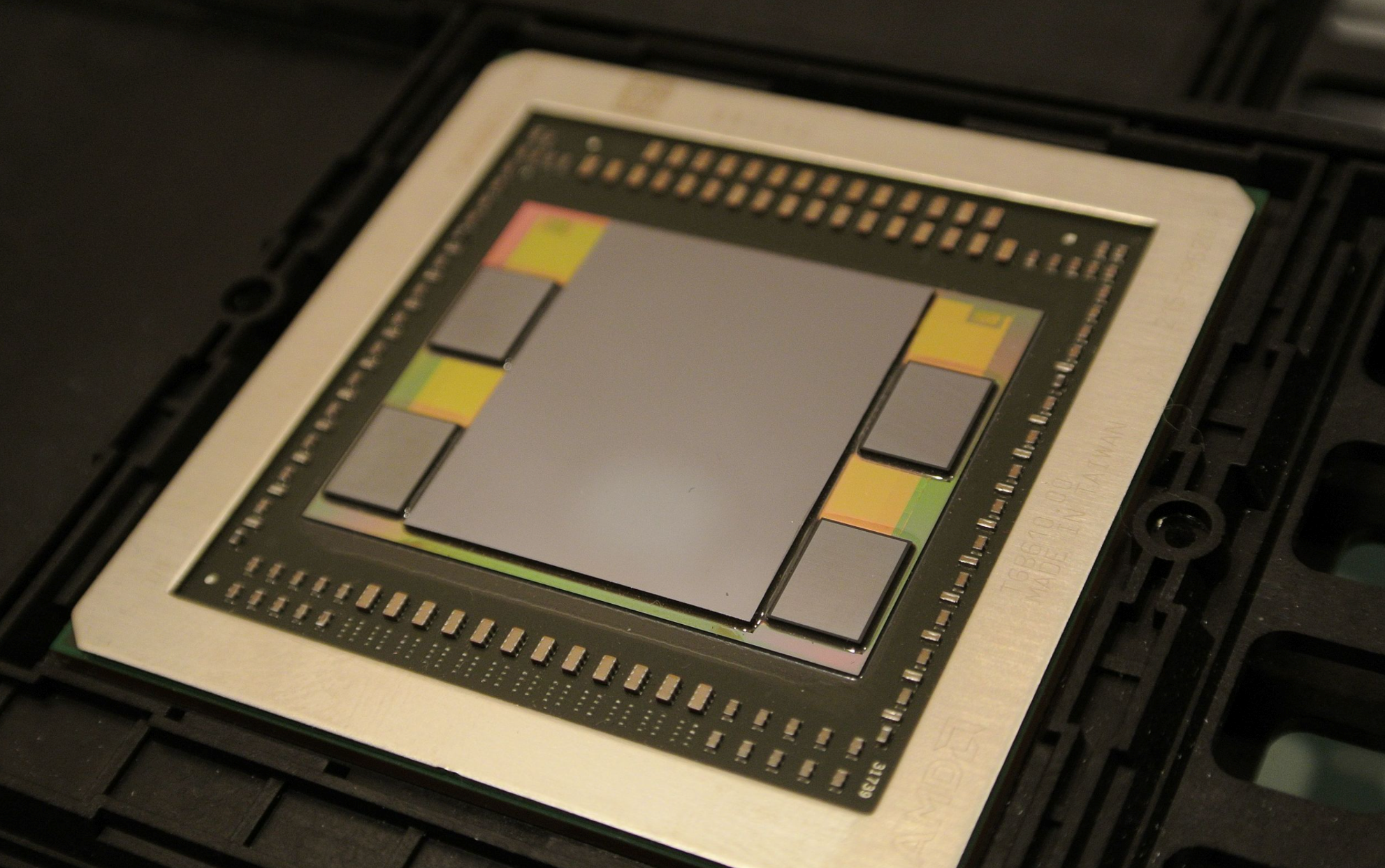

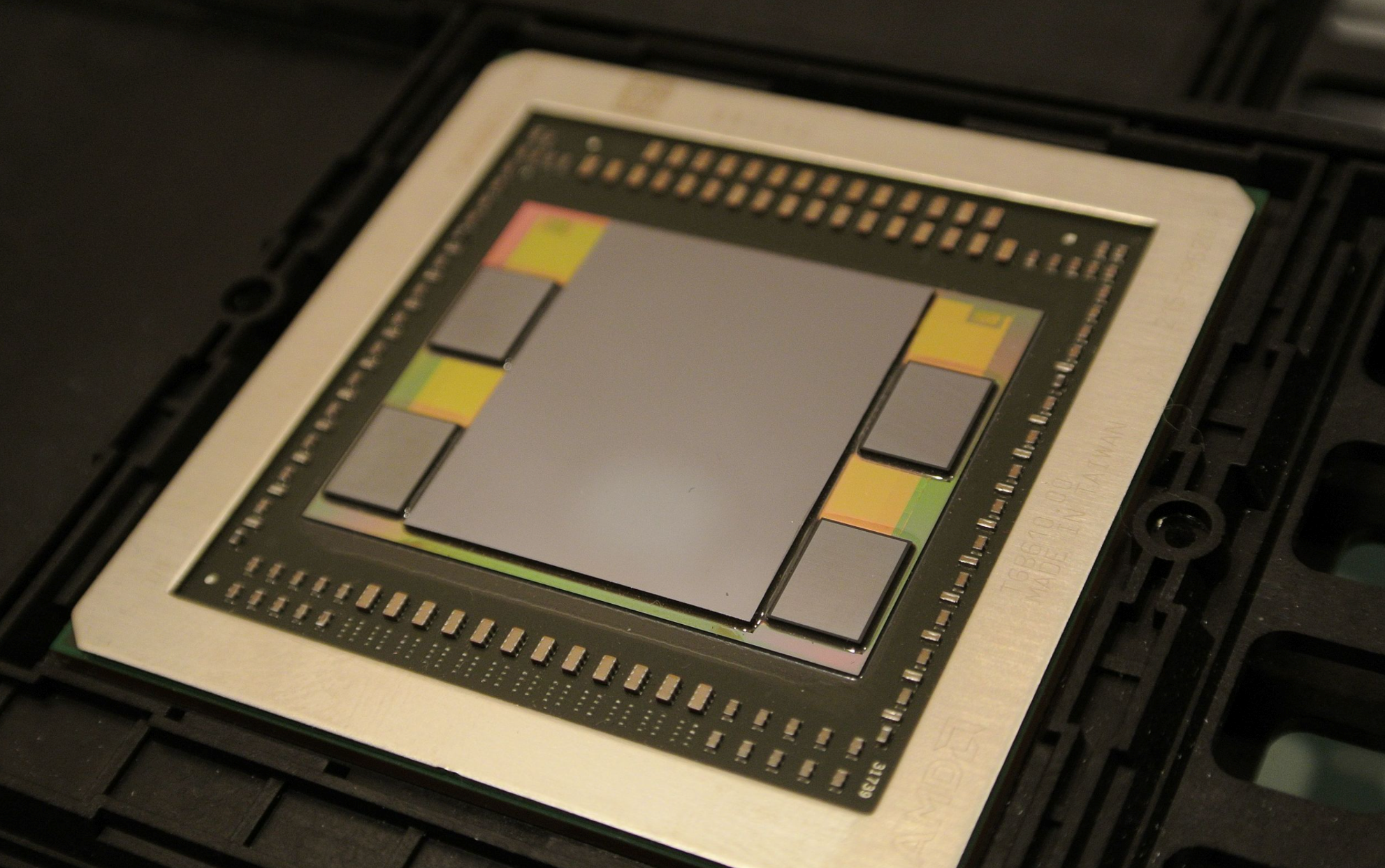

Fiji GPU / AMD

AMD也是首个将其引入GPU市场的厂商,并应用在其Fiji GPU上。随后2016年,三星率先开始了HBM2的量产,AMD被英伟达抢了风头,后者率先将这一新标准的存储器应用在其Tesla P100加速卡上。

当时HBM的优缺点都十分明显了,从一开始以来的带宽优势正在被GDDR6迎头赶上,设计难度和成本又是一道难以迈过的坎。虽然高端显卡上这些成本并不占大头,但中低端显卡用到HBM就比较肉疼了。但AMD并没有因此放弃HBM2,而是在Vega显卡上继续引入了HBM2。

不过,这可能也就是我们最后一次在消费级GPU上见到HBM了,AMD在之后的RDNA架构上再也没有使用HBM,仅仅只有基于CDNA架构且用于加速器的GPU上还在使用HBM。

为什么是服务器市场?

HBM是如何在服务器市场扎根的呢?这是因为HBM最适合的应用场景之一就是功率受限又需要最大带宽的环境,完美达到HPC集群中进行人工智能计算,或是大型密集计算的数据中心的要求。

A100不同规格的显存对比 / Nvidia

这也就是这些包含数据中心业务的公司持续使用HBM的原因,英伟达在性能强大的服务器GPU A100中依然在使用HBM2和HBM2e,甚至可能会在下一代Hopper结构继续沿用下去。据传,英特尔尚未面世的Xe-HP和Xe-HPC GPU也将使用HBM。

不过这两家厂商的消费级GPU都不约而同的避过了HBM,选择了GDDR6和GDDR6X,可想而知他们都不想走AMD的弯路。

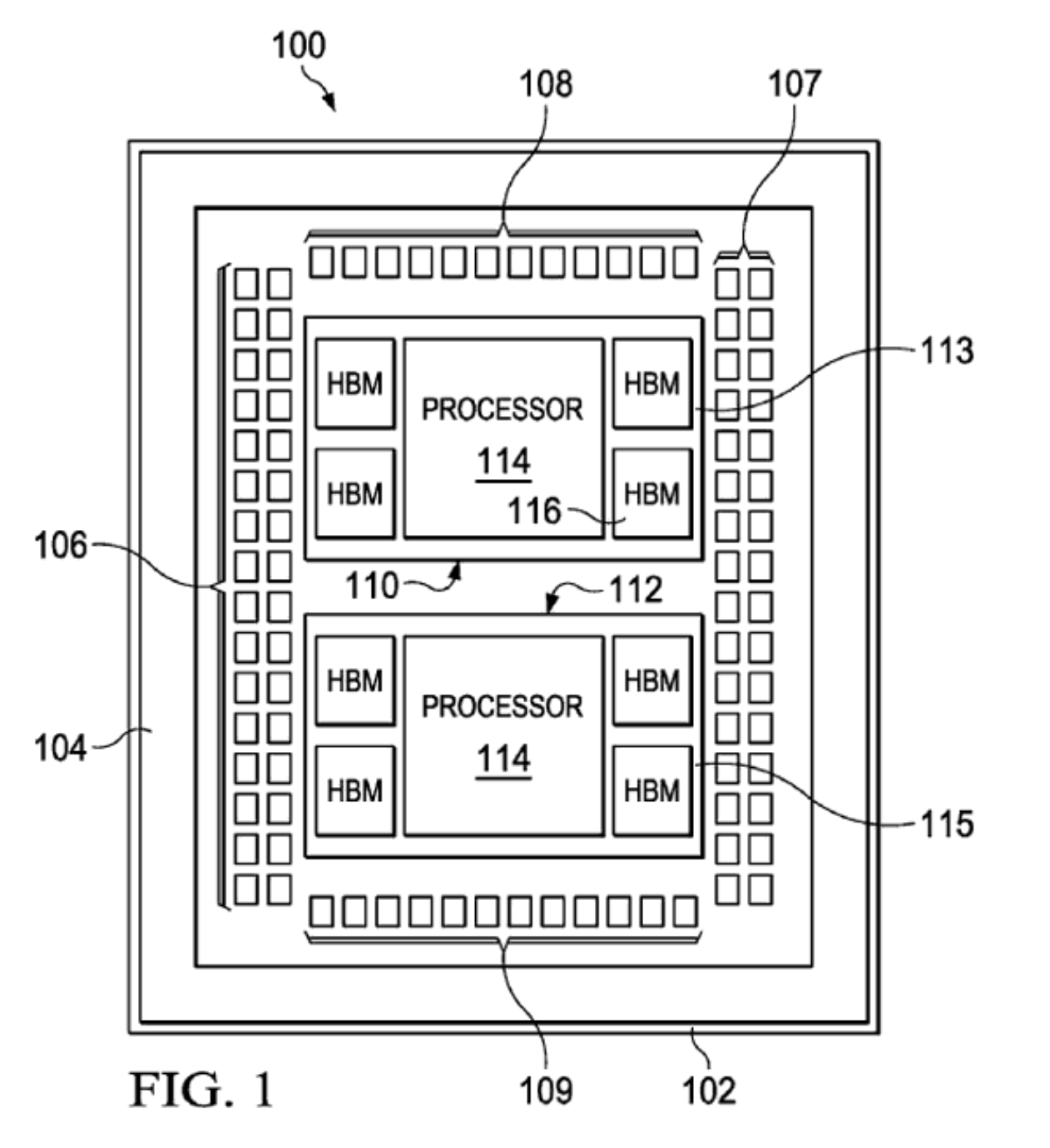

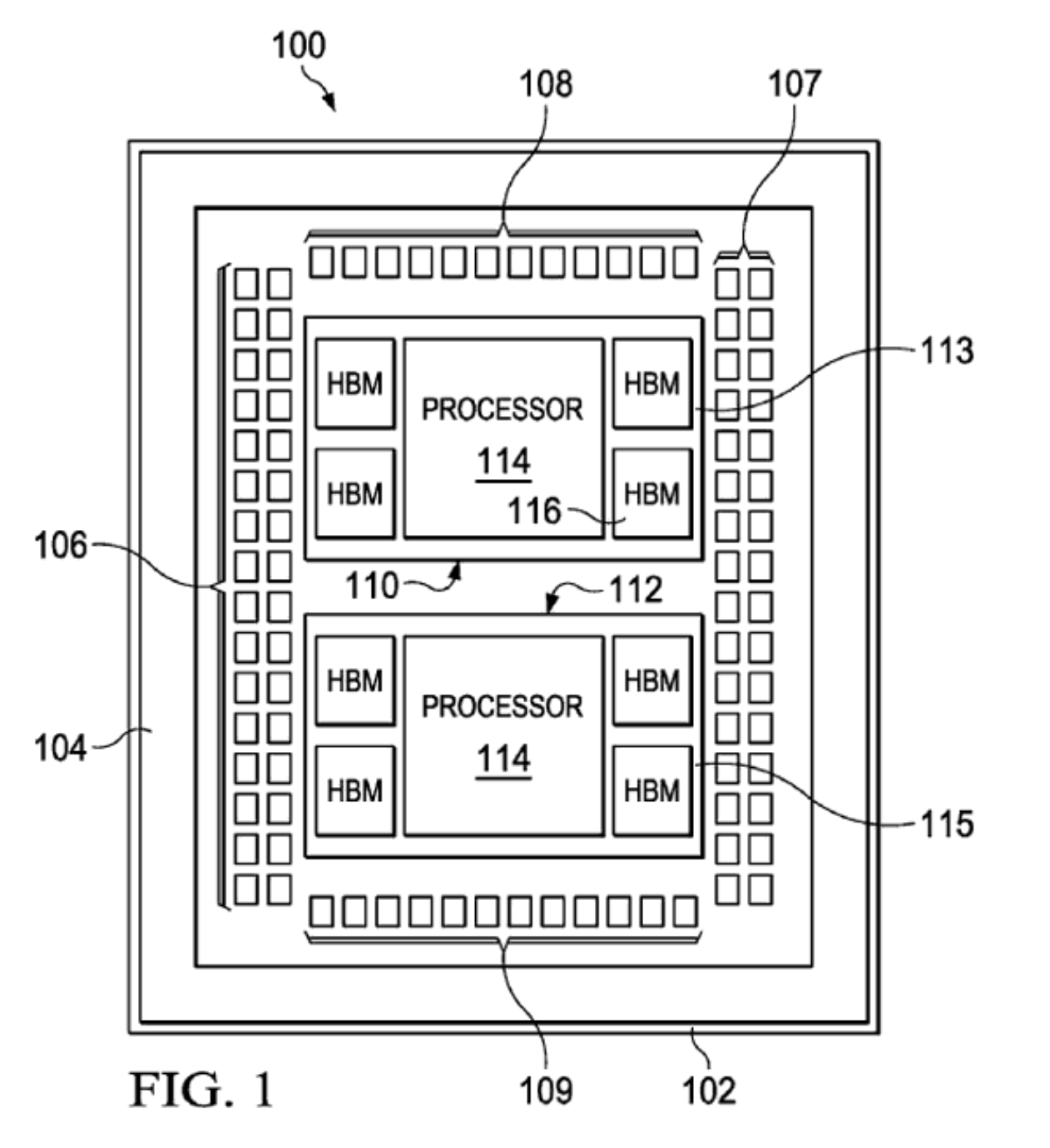

AMD专利 / AMD

至于AMD在CPU上率先使用HBM也并非空穴来风,在AMD去年公布的一份专利中,就在芯片设计上出现了HBM。英特尔推出的竞品Xeon Sapphire Rapids服务器CPU也正式宣布将使用HBM,不过量产要等到2023年。这些可以看出HBM在服务器市场有多“香”,他们都开始将HBM向CPU上发展。

下一代HBM

虽然制定标准的JEDEC尚未推出HBM3的相关规范,但一直在研究下一代HBM的SK海力士在今年6月透露了HBM3的最新情报,HBM将迎来进一步的性能提升。

HBM2E和HBM3性能对比 / SK海力士

HBM2E的带宽可达460GB/s,I/O速率可达3.6Gbps,而HBM3的带宽可以达到665GB/s以上,I/O速率超过5.2Gbps。这还是只是速率的下限而已,要知道SiFive与OpenFive今年流片的5nm RISC-V SoC也加入了HBM3的IP,最高支持的数据传输率达到7.2Gbps。

SK海力士能做到如此高的性能提升,很可能得益于去年与Xperi签订的专利许可协议。这些协议中包含了DBI Ultra 2.5D/3D互联技术,可以用于3DS、HBM2、HBM3及后续DRAM产品的创新开发。传统的铜柱互联只能做到每平方毫米625个互联,而DBI Ultra可以在同样的面积下做到10万个互联。

结语

从JEDEC2018年宣布HBM2E标准以来,HBM已经近3年没有更新了。三星更是在今年2月宣布开发带有人工智能引擎的HBM-PIM,未来HBM3是否能在服务器领域继续称雄,相信当前几大厂商规划的服务器产品中HBM占比已经给出了答案。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

amd

+关注

关注

25文章

5647浏览量

139029 -

cpu

+关注

关注

68文章

11218浏览量

222962 -

gpu

+关注

关注

28文章

5099浏览量

134468

发布评论请先 登录

相关推荐

热点推荐

历史首次!AMD服务器CPU市占率达50%

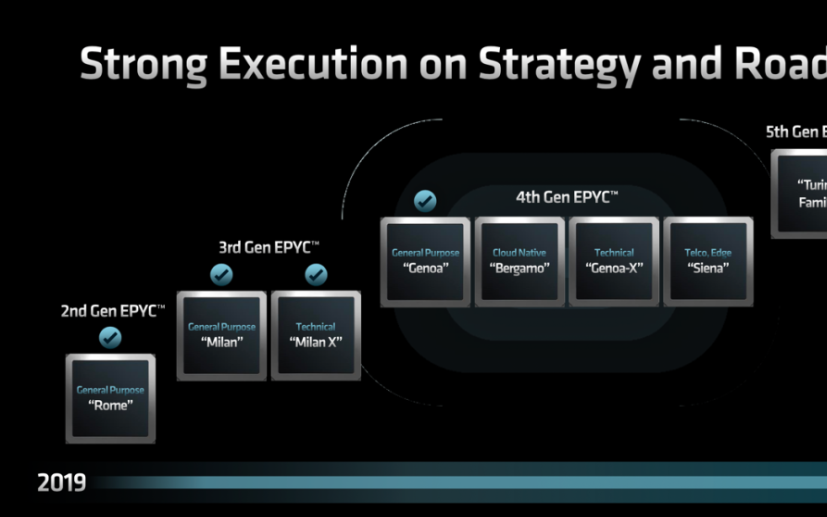

英特尔持平。根据AMD的数据显示,自EPYC CPU推出以来,其在服务器领域的市场份额由2018年的2%提升到2024年上半年的34%。在持平之后未来竞争将变得更加激烈。 回看每一代

GPU猛兽袭来!HBM4、AI服务器彻底引爆!

电子发烧友网报道(文/黄晶晶)日前,多家服务器厂商表示因AI服务器需求高涨拉高业绩增长。随着AI服务器需求旺盛,以及英伟达GPU的更新换代,势必带动HBM供应商的积极产品推进。三星方面HBM

AI大算力的存储技术, HBM 4E转向定制化

电子发烧友网报道(文/黄晶晶)如今英伟达GPU迭代速度加快至每年一次,HBM存储速率如何跟上GPU发展节奏。越来越多的超大规模云厂商、GPU厂商开始转向定制化

从 CPU 到 GPU,渲染技术如何重塑游戏、影视与设计?

渲染技术是计算机图形学的核心内容之一,它是将三维场景转换为二维图像的过程。渲染技术一直在不断演进,从最初的CPU渲染到后来的GPU渲染,性能和质量都有了显著提升。从CPU到

传英伟达自研HBM基础裸片

"后的下一代AI GPU "Feynman"。 有分析指出,英伟达此举或是将部分GPU功能集成到基础裸片中,旨在提高HBM和GPU的整体

aicube的n卡gpu索引该如何添加?

请问有人知道aicube怎样才能读取n卡的gpu索引呢,我已经安装了cuda和cudnn,在全局的py里添加了torch,能够调用gpu,当还是只能看到默认的gpu0,显示不了gpu1

发表于 07-25 08:18

专访AMD王启尚 从RDNA 4到FSR 4,AMD GPU技术创新引领行业新发展

产品的芯片系统开发。在加入 Synaptics 之前,他曾在 AMD 担任公司副总裁,负责 AMD 处理器产品(包括 GPU、CPU 和

从CPU到GPU:渲染技术的演进和趋势

渲染技术是计算机图形学的核心内容之一,它是将三维场景转换为二维图像的过程。渲染技术一直在不断演进,从最初的CPU渲染到后来的GPU渲染,性能和质量都有了显著提升。一、从CPU到

三星电子将供应改良版HBM3E芯片

三星电子在近期举行的业绩电话会议中,透露了其高带宽内存(HBM)的最新发展动态。据悉,该公司的第五代HBM3E产品已在2024年第三季度实现大规模生产和销售,并在第四季度成功向多家GPU厂商及数据中心供货。与上一代

GPU渲染才是大势所趋?CPU渲染与GPU渲染的现状与未来

技术的不断进步,尤其是GPU性能的显著提升,越来越多的行业专家和从业者开始预测未来的渲染工作将逐步转向GPU渲染。然而,CPU渲染真的会被GPU

AMD将DeepSeek-V3模型集成至Instinct MI300X GPU

AMD近日宣布了一项重要进展,成功将全新的DeepSeek-V3模型集成到其Instinct MI300X GPU上。这一举措标志着AMD在AI推理优化方面迈出了重要一步。 据了解

AMD集成DeepSeek-V3模型至Instinct MI300X GPU

AMD近日宣布了一项重要的技术进展,即将全新的DeepSeek-V3模型成功集成到其旗舰级GPU产品——Instinct MI300X上。这一举措标志着AMD在人工智能推理领域迈出了坚实的一步

2024年GPU出货量增长显著,超越CPU

6%的同比增长,总量超过2.51亿颗,这一数据不仅彰显了GPU市场的繁荣,也反映了当前市场对于图形处理能力的巨大需求。 尤为值得一提的是,与同样作为计算机核心部件的CPU相比,GPU在2024年的出货量上占据了明显优势。据JPR

《CST Studio Suite 2024 GPU加速计算指南》

的各个方面,包括硬件支持、操作系统支持、许可证、GPU计算的启用、NVIDIA和AMD GPU的详细信息以及相关的使用指南和故障排除等内容。

1. 硬件支持

- NVIDIA GPU

发表于 12-16 14:25

AMD或将全面拥抱HBM,CPU和GPU都要用?

AMD或将全面拥抱HBM,CPU和GPU都要用?

评论