要说自然语言处理在18年最夺目闪耀的是什么事情,那当属 BERT 刷新各个任务的记录了,至今已经过去了近两年半的时间,但其影响力未曾衰减,无论学术界还是工业界,很多的工作与部署都围绕其展开,对很多的下游任务都有举足轻重的作用,真的是里程碑啊。

相信大家都有过BERT、ALBERT等预训练语言模型应用在自己任务上的实践经历,可能是情感分析、分类、命名实体识别、阅读理解、相似度计算等等,使用的方法也无非是在自己任务上 fine-tune 或者作为预训练Embedding,使用的预训练模型大多是公开的,大佬们(财大气粗、资源无数)训练好的。(有钱真好)

在用预训练模型的时候,根据任务的不同,用到信息也不同,有的需要是词表示,比如命名实体识别、词性标注等任务,有的需要的是句子表示,比如分类、句子语意匹配等。这里我要说的句子表示这一类的任务,大家经常会用到的 [CLS] 特征信息作为句子向量表示,CLS 作为 BERT/ALBERT序列信息中特殊的一个存在,在最开始设计模型的时候便考虑将其作为后续文本分类的表示,然而直接使用 CLS 的效果真的会满足我们的预期嘛?相信大家在实践的过程中都有所体会~,另外 ALBERT 和 BERT 在下游任务应用上面孰好孰坏,是否有一个定论?

我最近看到了一篇 Arxiv 的文章,题目是 《Evaluation of BERT and ALBERT Sentence Embedding Performance on Downstream NLP Tasks》,这篇文章在 BERT/ALBERT 提取信息作为句子信息表示应用在下游任务,对其效果进行了评测,或许会解答我们实践中的疑惑,也或者会给我们一些预训练模型在下游任务应用的启发,让我们来看下~

评测对比

有一系列的对比实验,来看在下游任务上面的效果~

[CLS] embeddings

CLS 通过 Self-Attention 机制来获取句子级别的信息表示,在不同的任务上 Fine-tune 之后,CLS 会捕捉特定环境下的上下文信息表示。

Pooled embeddings

将文本中的所有词做 Avg-pooling 或者 max-pooling。

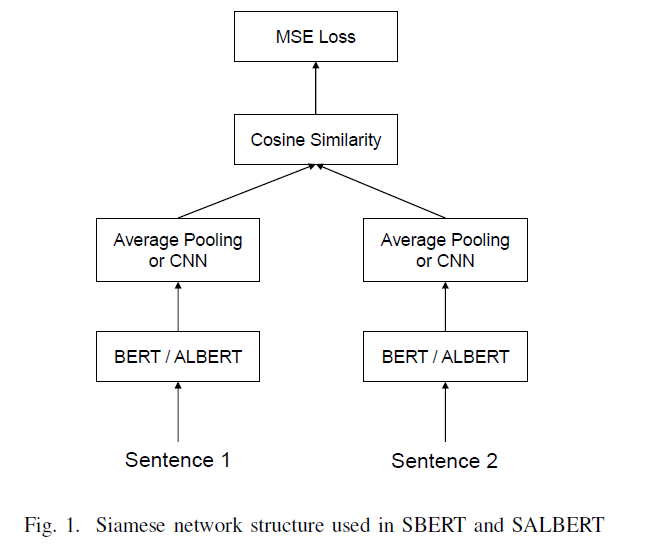

Sentence-X(SBERT/ALBERT)

BERT 在语义相似度任务上面也取得了很不错的效果,然后其内部的结构在计算过程中会导致非常耗时,不适合做语义相似度匹配任务,特别是在工业界,BERT 的耗时无法满足上线的需要。针对这个问题,有人提出 Sentence-BERT,采用孪生网络模型框架,将不同的句子输入到参数共享的两个BERT模型中,获取句子信息表示,用于语义相似度计算,最终相比BERT效率大大提升,满足工业界线上需要。SBERT 从65小时降到5秒,具体详见参考资料2。

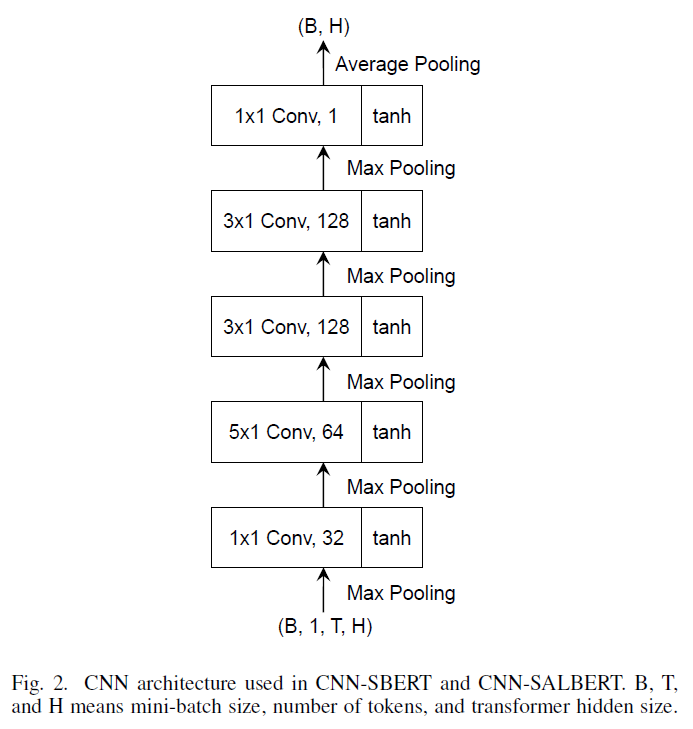

CNN-SBERT/SALBERT

在上图中,SBERT 采用 Avg-pooling 获取句子向量表示,本文将其替换成 CNN 网络结构获取句子向量表示。

结果分析

评测任务

STS:Semantic Textual Similarity

NLI:Natural Language Inference

评测指标

Pearson and Spearman’s rank coefficients(皮尔逊和斯皮尔曼相关系数)

评测数据

Semantic Textual Similarity benchmark(STSb)

Multi-Genre Natural Language Inference(MultiNLI)

Stanford Natural Language Inference(SNLI)

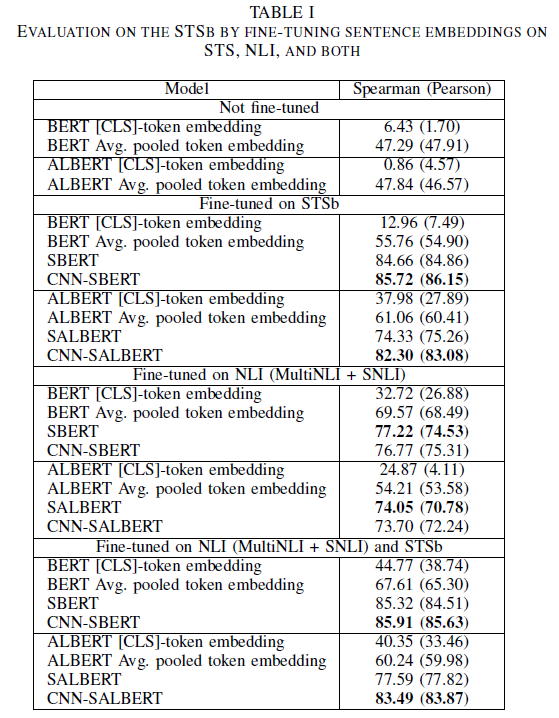

上面列出来相关的评测任务、评测指标以及评测所用到的数据,下面先给出一张结果表,然后再详细分析~

详细分析

微调有效:这个是符合我们认知的,肯定是微调的效果要好。

CLS 效果:CLS 的效果要逊色很多,无论是在微调上面,还是不微调上面,CLS的效果都要远逊色于平均池化操作或者其他方法。

不同方法效果:总体上来看,CNN-BERT > SBERT > Avg pooling > CLS

BERT 与 ALBERT:从上图中大概能够看出,不微调的情况下,两者的效果差不多,但是微调之后,ALBERT的效果要比BERT差很多,仅仅在STSb上微调的时候,CLS 和平均池化的方法要好于BERT。

CNN的效果

从上图来看,最好的结果是采用了 CNN 网络结构,说明 CNN 起到了正向的作用,仔细观察发现,CNN 对 ALBERT 的改进要远大于对 BERT 的改善提高。ALBERT 由于内部参数共享,可能存在不稳定性,CNN 网络结构或许可以减缓这种不稳定性。

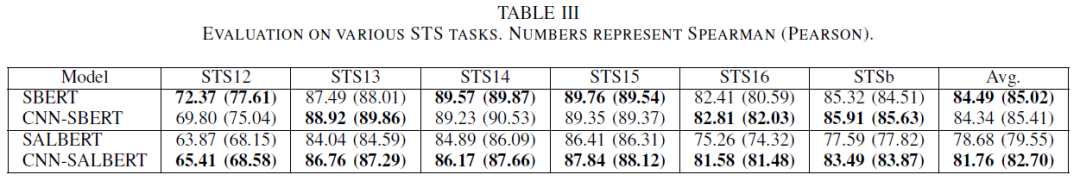

下图也进行了一些对比,在几个不同的数据集上验证 CNN 的有效性,从最终的 Avg 结果来看,CNN 网络结构对 ALBERT 有改善提升。

以上是根据实验结果进行的简单分析,其中有一些结论和对比可以在我们日常的实践中借鉴并尝试,说不定会有不错的效果~

原文标题:【BERT】BERT中CLS效果真的好嘛?这篇文章告诉你答案

文章出处:【微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

责任编辑:haq

-

人工智能

+关注

关注

1813文章

49765浏览量

261703 -

自然语言

+关注

关注

1文章

292浏览量

13926

原文标题:【BERT】BERT中CLS效果真的好嘛?这篇文章告诉你答案

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

Neway电机方案在实际应用中效果如何?

LCD屏幕无法正确显示效果如何解决?

HarmonyOSAI编程自然语言代码生成

【HZ-T536开发板免费体验】5- 无需死记 Linux 命令!用 CangjieMagic 在 HZ-T536 开发板上搭建 MCP 服务器,自然语言轻松控板

超声波清洗设备的清洗效果如何?

云知声四篇论文入选自然语言处理顶会ACL 2025

自然语言处理的发展历程和应用场景

自然语言提示原型在英特尔Vision大会上首次亮相

VLM(视觉语言模型)详细解析

智慧路灯的照明效果如何?

中科驭数DPU助力大模型训练和推理

自然语言处理BERT中CLS的效果如何?

自然语言处理BERT中CLS的效果如何?

评论