来源:ST社区

GPU和NNA(神经网络加速器)正在迅速成为AI应用的关键要素。随着不同企业开始挖掘神经网络在各种任务(比如自然语言处理、图片分类)中的潜力,集成人工智能元素的产品数量正在稳步的增长。与此同时,对于这些任务的处理也正在从传统的云端架构转移到设备本身上来,嵌入式芯片中集成了专用的神经网络加速器,可支持本地化AI处理。例如先进的驾驶辅助系统(ADAS)能够实时监控前方道路,还有集成语音识别类功能的消费电子产品,比如虚拟助理。基于神经网络的AI应用正在多个细分市场不断扩大。

Imagination公司的业务是为芯片设计提供必要的内核组件,我们在嵌入式图形处理器(GPU)和神经网络加速器(NNA)技术方面闻名,我们将这些技术授权给世界领先的芯片供应商。他们的产品被广泛应用在多个产品和服务中,因此Imagination在市场上占有着独特的位置,我们使得整个生态系统都能够参与到AI的发展中来。

不可否认,AI在很多应用中都是至关重要的,但是也有很多的挑战。其中之一就是协调好终端设备和云服务器之间的处理负载,将AI处理操作放在最佳的位置来完成。例如在消费者终端设备上进行本地化AI语音识别;对于“唤醒”指令或其他简单指令,因为本地设备无法存储庞大的知识数据库,要利用这些数据就必须在云服务器中实现很大一部分AI处理操作。目前的情况是很多市场上销售的产品都带有AI功能,但实际上它们只是在本地进行简单的模式匹配和识别,然后依赖云服务器完成进一步的AI处理。

这种情况将会逐渐改变,随着芯片工艺技术变得更加普遍,嵌入式神经网络加速器(NNA)将会变得几乎和CPU一样无处不在,这为在终端设备中提高人工智能处理能力创造了机会。例如我们希望看到智能安防摄像头能够熟练的监控特定事件,不再局限于简单的录像,使用终端设备AI功能来处理识别视野内的一些特征,比如道路上的车辆或人群中的面孔。这也会衍生一些其他功能,比如确定车辆的制造商和型号、或者是某些人获得授权。输入结果可能不是可识别的视频内容,可能只是描述这些结果的原始数据。将人工智能嵌入到安防摄像头中甚至可以减少不靠谱情况的发生从而降低成本,因为摄像头内的AI功能可以识别正常行为与可疑行为之间的区别。

虽然人工智能的应用数量在不断增加,但这并不意味着集成神经网特性的单个SoC是所有应用场景的发展方向。如果我们考虑让人工智能涉及大部分细分市场,由于使用该技术的产品在加工要求上有很大的不同,自然会出现多样化。分散的市场很难与通用的应用处理器一起结合使用,例如那些集成了NNA器件和GPU的处理器,事实上,“一刀切”的方式并不总是适用的。

虽然一些市场为SoC供应商提供了大量的机会,比如智能手机、汽车ADAS等,但是许多以使用AI为目标的市场需求量并不是很大。值得注意的是,一些产品可能需要人工智能来进行语音处理或图像识别,但并非两者都需要:智能照明系统供应商不太可能使用最初为智能手机而设计的SoC,仅仅是为了将人工智能引入到其应用中,这并不符合成本效益。解决这个问题的方法是创建专门的人工智能芯片,与主应用处理器一起作为配套芯片使用,这些器件可以承担原来由主应用处理器上的NNA核心来处理的AI任务,这具有明显的优势:SoC供应商可以提供一系列具有不同性能水平的终端AI器件;此外,OEM厂商还可以根据他们的期望在特定应用中处理AI任务,提供多个选项来适当的扩展或缩减产品解决方案。

那么人工智能市场将走向何方?我预计人们对人工智能的兴趣和需求都将继续增长,事实上,支撑这一目标的技术不断变得成熟。相反,几乎可以肯定的是,人们会意识到人工智能并不是解决所有问题的答案,炒作现象可能会有所减弱,许多公司也会转移注意力。他们将会利用人工智能的潜力来增强系统的能力,但是人工智能未必是这些系统的运行核心。

更进一步说,真正的人工智能——机器拥有意识,能够基于认知推理作出决策——这还需要10年或更长的时间。这意味着云互连在未来很多年都将至关重要,它不仅能提供必要的大规模并行计算资源(可能是通过量子机器),还能提供巨大的数据存储,人工智能依靠这些数据来理解周围的世界。更高带宽的通信技术有望在2019年问世,尤其是5G和802.11ax标准,因此相信云AI架构和互连带宽都将相应扩大。

PowerVR Series2NX架构

对于真正处于前沿的人工智能,我们需要构想出创新的方法来提高晶体管在硅片上的封装密度,同时使其既具有通过学习获得知识的能力又具备所需的推理技能,从而设计全新的SoC器件。

Imagination公司希望为芯片供应商提供关键的核心技术,从而构建世界领先的人工智能解决方案。PowerVR GPU提供了高性能的GPU计算能力,用于处理AI中的可视化操作,比如图像识别和排序、手势识别驱动接口以及实时视频分析等。PowerVR NNA(神经网络加速器)是任何前沿人工智能解决方案的核心,为高级推理和边缘数据处理提供必要的硬件加速。我们的GPU和NNA能够为高性能的AI处理提供一切必要的技术并使硅芯片获得优势。

人工智能的未来正在变得清晰…但是当它完成某些任务花费的时间比我们预期的时间要长时大家不要感到惊讶。

审核编辑 黄昊宇

-

芯片

+关注

关注

462文章

53534浏览量

459107 -

嵌入式

+关注

关注

5186文章

20146浏览量

328818

发布评论请先 登录

NMSIS神经网络库使用介绍

SNN加速器内部神经元数据连接方式

CICC2033神经网络部署相关操作

【「AI芯片:科技探索与AGI愿景」阅读体验】+第二章 实现深度学习AI芯片的创新方法与架构

Andes晶心科技推出新一代深度学习加速器

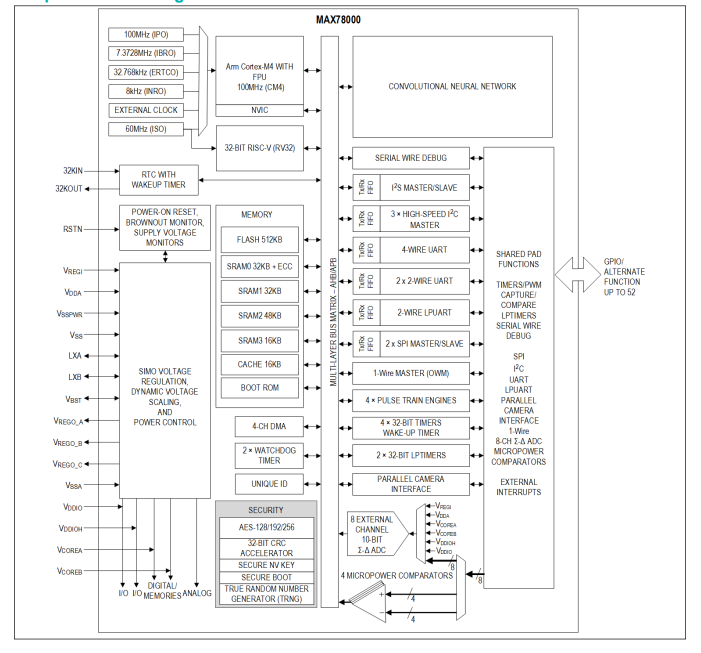

MAX78000采用超低功耗卷积神经网络加速度计的人工智能微控制器技术手册

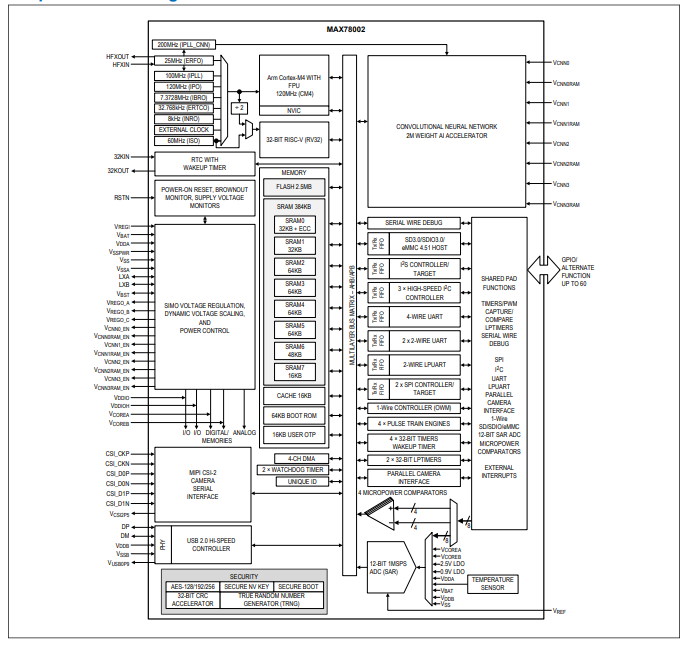

MAX78002带有低功耗卷积神经网络加速器的人工智能微控制器技术手册

ETAS全新的嵌入式AI解决方案

嵌入式芯片中神经网络加速器如何支持本地化AI处理

嵌入式芯片中神经网络加速器如何支持本地化AI处理

评论