近日,中国原子能科学研究院与北京航空航天大学、中山大学、意大利帕多瓦大学/莱尼亚罗利国家实验室、深圳大学、苏州大学有关科研人员合作,在意大利莱尼亚罗利国家实验室,利用重离子熔合蒸发反应对212Rn(氡212)的能级结构进行研究,并取得新进展。该研究结果在线发表于国际核物理研究领域著名学术期刊Physics Review C(《物理评论C》), 题目为《New level scheme and shell model description of 212Rn》(《212Rn的新能级结构研究及壳模型描绘》),文章第一作者为原子能院李聪博副研究员,通讯作者为北京航空航天大学教授张高龙。

原子核是由几个到几百个核子(包括质子、中子)组成的复杂体系。当质子数或中子数为2、8、20、28、50、82和中子数为126时,原子核最稳定,在自然界的丰度也最高。上世纪50年代,核物理理论学家建立了数学模型(即壳模型),用于解释上述类别原子核稳定的原因,带来了核结构研究的飞跃。该模型将原子核分为不同壳层,把每一个表示质子或中子的数字称为“幻数”。几十年来,尽管壳模型几经改进,但其中依然存在大量假设和近似,不能全面解释原子核性质,只能指出原子核内部运动的部分特点。

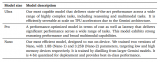

212Rn核由86个质子、126个中子组成,是最重的幻数核之一(N=126),实验上很难观察到其能级信息。研究人员利用6Li(锂6)重离子束轰击209Bi(铋209)靶,使212Rn处于能量较低状态,发现了29条新的γ跃迁和16条新的能级。中山大学利用大规模的壳模型对新发现的能级结构进行计算后,结果与实验观测值总体相符。此次研究的新结果对进一步认识大组态空间的壳模型提供了帮助,为未来开展更大规模壳模型计算提供了重要参考。

212Rn部分能级纲图,标红色为本工作新发现。

该工作获得了国家自然科学基金、中核集团和基金委的核技术创新联合基金、财政部稳定支持研究经费等项目的支持。

责任编辑:pj

-

模型

+关注

关注

1文章

2709浏览量

47712 -

质子

+关注

关注

0文章

11浏览量

7655

发布评论请先 登录

相关推荐

【大语言模型:原理与工程实践】探索《大语言模型原理与工程实践》

【书籍评测活动NO.30】大规模语言模型:从理论到实践

商汤科技与库醇科技达成合作 为垂域大模型构建高质量大规模的领域微调数据

AGI时代的奠基石:Agent+算力+大模型是构建AI未来的三驾马车吗?

壳模型为未来开展更大规模壳模型计算提供了重要参考

壳模型为未来开展更大规模壳模型计算提供了重要参考

评论