AI芯片哪家强?现在,有直接的对比与参考了。

英国一名资深芯片工程师James W. Hanlon,盘点了当前十大AI训练芯片。

并给出了各个指标的横向对比,也是目前对AI训练芯片最新的讨论与梳理。

其中,华为昇腾910是中国芯片厂商唯一入选的芯片,其性能如何,也在这一对比中有了展现。

Cerebras Wafer-Scale Engine

这一芯片于今年8月份正式面世,被称为“史上最大AI芯片”,名为“晶圆级引擎”(Cerebras Wafer Scale Engine,简称WSE)。

其最大的特征是将逻辑运算、通讯和存储器集成到单个硅片上,是一种专门用于深度学习的芯片。

一举创下4项世界纪录:

1、晶体管数量最多的运算芯片:总共包含1.2万亿个晶体管。虽然三星曾造出2万亿个晶体管的芯片,却是用于存储的eUFS。

2、芯片面积最大:尺寸约20厘米×23厘米,总面积46225平方毫米。

3、片上缓存最大:包含18GB的片上SRAM存储器。

4、运算核心最多:包含410,592个处理核心

之所以能够有如此亮眼的数据,直接得益于其集成了84个高速互连的芯片,单个芯片在FP32上的峰值性能表现为40 Tera FLOPs,芯片功率达15千瓦,与AI集群相当。

片上缓存也达到了18GB,是GPU缓存的3000倍;可提供每秒9PB的内存带宽, 比GPU快10,000倍。

晶片规模集成,并不是一个新的想法,但产量、功率传输和热膨胀相关的问题使其很难商业化。在这些方面,Cerebras都给出了相应的解决办法:

1、为了解决缺陷导致良率不高的问题,Cerebras在设计的芯片时候考虑了1~1.5%的冗余,添加了额外的核心,当某个核心出现问题时将其屏蔽不用,因此有杂质不会导致整个芯片报废。

2、Cerebras与台积电合作发明了新技术,来处理具有万亿加晶体管芯片的刻蚀和通讯问题。

3、在芯片上方安装了一块“冷却板”,使用多个垂直安装的水管直接冷却芯片。

Cerebras公司由Sean Lie(首席硬件架构师)、Andrew Feldman(首席执行官)等人于2016年创立。后者曾创建微型服务器公司SeaMicro,并以3.34亿美元的价格出售给AMD。

该公司在加州有194名员工,其中包括173名工程师,迄今为止已经从Benchmark等风投机构获得了1.12亿美元的投资。

Google TPU(v1、v2、v3)

Google TPU系列芯片正式发布于2016年,第一代芯片TPU v1只用于推理,而且只支持整数运算。

通过在PCIe-3之间发送指令来执行矩阵乘法和应用激活函数,从而为主机CPU提供加速,节省了大量的设计和验证时间。其主要数据为:

1、芯片面积331平方毫米,28nm制程

2、频率为700 MHz,功耗28-40W

3、片上存储为28 MB SRAM:24MB 用于激活,4MB 用于累加器

4、芯片面积比例:35%用于内存,24%用于矩阵乘法单元,剩下的41%面积用于逻辑。

5、256x256x8b收缩矩阵乘法单元(64K MACs/cycle)

6、Int8和 INT16算法(峰值分别为92和23 TOPs/s)

IO数据:

可以通过两个接口访问8 GB DDR3-2133 DRAM,速度为34 GB/s

1、PCIe-3x16 (14 GBps)

2017年5月,Google TPU v2发布,改进了TPU v1的浮点运算能力,并增强了其内存容量、带宽以及HBM 集成内存,不仅能够用于推理,也能够用于训练。其单个芯片的数据如下:

2、20nm制程,功耗在200-250W(推测)

3、BFloat16上性能表现为45 TFLOPs,也支持 FP32

4、具有标量和矩阵单元的双核

5、集成4块芯片后,峰值性能为180 TFLOPs

单核数据:

1、128x128x32b收缩矩阵单元(MXU)

2、8GB专用HBM,接入带宽300 GBps

3、BFloat16上的最大吞吐量为22.5 TFLOPs

IO数据:

4、16Gb HBM集成内存,600 GBps带宽(推测)

5、PCIe-3 x8 (8 GBps)

6、Google TPU v2发布一年之后,Google再度发布新版芯片——TPU v3。

但关于TPU v3的细节很少,很可能只是对TPU v2一个渐进式改版,性能表现翻倍,增加了HBM2内存使容量和带宽翻倍。其单个芯片的数据如下:

1、16nm或12nm制程,功耗估计在200W

2、BFloat16的性能为105 TFLOPs,可能是MXUs的2倍到4倍

3、每个MXU都能访问8GB的专用内存

4、集成4个芯片后,峰值性能420 TFLOPs

IO数据:

32GB的HBM2集成内存,带宽为1200GBps (推测)

PCIe-3 x8 (8 GBps)(推测)

Graphcore IPU

Graphcore成立于成立于2016年,不仅备受资本和业界巨头的青睐,还颇受业内大佬的认可。

2018年12月,宣布完成2亿美元的D轮融资,估值17亿美元。投资方有宝马、微软等业界巨头,还有著名的风投公司Sofina、Atomico等。

AI巨头Hinton、DeepMind创始人哈萨比斯,都直接表达了赞美。

Graphcore IPU是这家公司的明星产品,其架构与大量具有小内存的简单处理器高度并行,通过一个高带宽的“交换”互连连接在一起。

其架构在一个大容量同步并行(BSP)模型下运行,程序的执行按照一系列计算和交换阶段进行。同步用于确保所有进程准备好开始交换。

- BSP模型是一个强大的编程抽象,用于排除并发性风险,并且BSP的执行,允许计算和交换阶段充分利用芯片的能源,从而更好地控制功耗。可以通过链接10个IPU间链路来建立更大的IPU芯片系统。其核心数据如下:

- 16nm制程,236亿个晶体管,芯片面积大约为800平方毫米,功耗为150W,PCIe卡为300 W

- 1216个处理器,在FP32累加的情况下,FP16算法峰值达到125 TFLOPs

- 分布在处理器核心之间有300 MB的片上内存,提供45 TBps的总访问带宽

- 所有的模型状态保存在芯片上,没有直接连接DRAM

IO数据:

- 2x PCIe-4的主机传输链接

- 10倍的卡间IPU链接

- 共384GBps的传输带宽

单核数据:

- 1、混合精度浮点随机算法

- 2、最多运行六个线程

Habana Labs Gaudi

Habana Labs同样成立于2016年,是一家以色列AI芯片公司。

2018年11月,完成7500万美元的B轮募资,总募资约1.2亿美元。

Gaudi芯片于今年6月亮相,直接对标英伟达的V100。

其整体的设计,与GPU也有相似之处,尤其是更多的SIMD并行性和HBM2内存。

芯片集成了10个100G 以太网链路,支持远程直接内存访问(RDMA)。与英伟达的NVLink或OpenCAPI相比,这种数据传输功能允许使用商用网络设备构建大型系统。其核心数据如下:

- TSMC 16 nm制程(CoWoS工艺),芯片尺寸大约为500平方毫米

- 异构架构:GEMM操作引擎、8个张量处理核(TPCs)

- SRAM内存共享

- PCIe卡功耗为200W,夹层卡为300W

- 片上内存未知

TPC核心数据:

- VLIW SIMD并行性和一个本地SRAM内存

- 支持混合精度运算:FP32、 BF16,以及整数格式运算(INT32、INT16、INT8、UINT32、UINT8)

- 随机数生成、超越函数:Sigmoid、Tanh、GeLU

IO数据:

- 4x 提供32 GB的HBM2-2000 DRAM 堆栈, 整体达1 TBps

- 芯片上集成10x 100GbE 接口,支持融合以太网上的 RDMA (RoCE v2)

- PCIe-4 x16主机接口

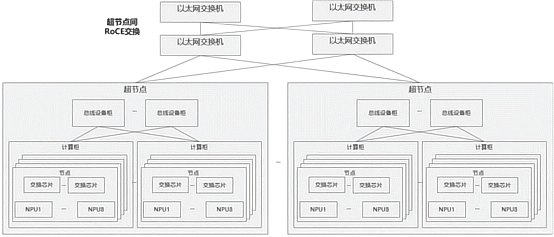

Huawei Ascend 910

华为昇腾910,同样直接对标英伟达V100,于今年8月份正式商用,号称业内算力最强的AI训练芯片。主打深度学习的训练场景,主要客户面向AI数据科学家和工程师。

其核心数据为:

- 7nm+EUV工艺,456平方毫米

- 集成4个96平方毫米的 HBM2栈和 Nimbus IO处理器芯片

- 32个达芬奇内核

- FP16性能峰值256TFLOPs (32x4096x2) ,是 INT8的两倍

- 32 MB的片上 SRAM (L2缓存)

- 功耗350W

互联和IO数据:

- 内核在6 x 4的2d网格封包交换网路中相互连接,每个内核提供128 GBps 的双向带宽

- 4 TBps的L2缓存访问

- 1.2 TBps HBM2接入带宽

- 3x30GBps 芯片内部 IOs

- 2 x 25 GBps RoCE 网络接口

单个达芬奇内核数据:

- 3D 16x16x16矩阵乘法单元,提供4,096个 FP16 MACs 和8,192个 INT8 MACs

- 针对 FP32(x64)、 FP16(x128)和 INT8(x256)的2,048位 SIMD 向量运算

- 支持标量操作

- Intel NNP-T

这是Xeon Phi之后,英特尔再次进军AI训练芯片,历时4年,壕购4家创业公司,花费超过5亿美元,在今年8月份发布。

神经网络训练处理器NNP-T中的“T”指Train,也就是说这款芯片用于AI推理,处理器代号为Spring Crest。

NNP-T将由英特尔的竞争对手台积电(TSMC)制造,采用16nm FF+工艺。

NNP-T有270亿个16nm晶体管,硅片面积680平方毫米,60mmx60mm 2.5D封装,包含24个张量处理器组成的网格。

核心频率最高可达1.1GHz,60MB片上存储器,4个8GB的HBM2-2000内存,它使用x16 PCIe 4接口,TDP为150~250W。

每个张量处理单元都有一个微控制器,用于指导是数学协处理器的运算,还可以通过定制的微控制器指令进行扩展。

NNP-T支持3大主流机器学习框架:TensorFlow、PyTorch、PaddlePaddle,还支持C++ 深度学习软件库、编译器nGraph。

在算力方面,芯片最高可以达到每秒119万亿次操作(119TOPS),但是英特尔并未透露是在INT8还是INT4上的算力。

作为对比,英伟达Tesla T4在INT8上算力为130TOPS,在INT4上为260TOPS。

英伟达Volta架构芯片

英伟达Volta,2017年5月公布,从 Pascal 架构中引入了张量核、 HBM2和 NVLink 2.0。

- 英伟达V100芯片就是基于此架构的首款GPU芯片,其核心数据为:

- TSMC 12nm FFN工艺,211亿个晶体管,面积为815平方毫米

- 功耗为300W,6 MB L2缓存

- 84个SM,每个包含:64个 FP32 CUDA 核,32个 FP64 CUDA 核和8个张量核(5376个 FP32核,2688个 FP64核,672个 TCs)。

- 单个Tensor Core每时钟执行64个FMA操作(总共128 FLOPS),每个SM具有8个这样的内核,每个SM每个时钟1024个FLOPS。

- 相比之下,即使采用纯FP16操作,SM中的标准CUDA内核只能在每个时钟产生256个FLOPS。

- 每个SM,128 KB L1数据缓存 / 共享内存和4个16K 32位寄存器。

IO数据:

- 32 GB HBM2 DRAM,900 GBps带宽

- 300 GBps的NVLink 2.0

英伟达Turing架构芯片

Turing架构是对Volta架构的升级,于2018年9月发布,但 CUDA 和张量核更少。

因此,它的尺寸更小,功率也更低。除了机器学习任务,它还被设计用来执行实时射线追踪。其核心数据为:

- TSMC 12nm FFN工艺,面积为754平方毫米,186亿个晶体管,功耗260W

- 72个SM,每个包含:64个 FP32核,64个 INT32核,8个张量核(4608个 FP32核,4608个 INT32核和576个 TCs)

- 带有boost时钟的峰值性能:FP32上为16.3 TFLOPs、FP16上为130.5 TFLOPs、INT8上为261 TFLOPs、INT4上为522 TFLOPs

- 片上内存为24.5 MB,在6MB的 L2缓存和256KB 的 SM 寄存器文件之间

- 基准时钟为1455 MHz

IO数据:

- 12x32位 GDDR6存储器,提供672 GBps 聚合带宽

- 2x NVLink x8链接,每个链接提供多达26 GBps 的双向速度

本文来自转载自公众号「QbitAI」和「量子位」,本文作为转载分享。

-

Google

+关注

关注

5文章

1801浏览量

60266 -

gpu

+关注

关注

28文章

5099浏览量

134464 -

昇腾910

+关注

关注

0文章

14浏览量

7153

发布评论请先 登录

国产AI芯片真能扛住“算力内卷”?海思昇腾的这波操作藏了多少细节?

中软国际出席华为昇腾计算产业发展峰会

华为开发者大会2025(HDC 2025)亮点:华为云发布盘古大模型5.5 宣布新一代昇腾AI云服务上线

中软国际推出昇腾金融AI解决方案和一体机v1.0

软通动力入选2025十大DeepSeek部署典型案例

大华股份亮相华为中国合作伙伴大会2025 星汉×昇腾推动行业创新发展

迅龙软件出席华为昇腾APN伙伴大会,获昇腾APN钻石伙伴授牌及两项大奖

全球十大AI训练芯片大盘点:华为昇腾910是中国唯一入选

全球十大AI训练芯片大盘点:华为昇腾910是中国唯一入选

评论