M.2 SSD发热量越来越大,散热手段也不断升级,散热片越来越复杂、高级,有的甚至用上了热管、风扇,如今终于走到了水冷这一步。

Team Group最新发布的T-Force Cardea Liquid M.2就是目前已知第一款用上水冷(严格来说叫液冷)散热的SSD,不过比较简单,是个封闭式系统,内部分为两个腔室,紧挨闪存芯片、主控腔室内的液体被加热后,流到第二个腔室(外有铝质散热片),温度降低后返回,如此往复循环。

由于没有外接冷排之类的装置,实际散热效果不但要取决于冷却液,还要看散热片和周围环境。

官方宣称,用上水冷之后,SSD的温度可降低10℃。

另外需要注意的是,这款SSD出厂时没有冷却液,需要用户自行添加。

同时也要特别小心与X570主板的兼容性,因为该主板基本都有主动风扇散热,Team Group也贴心地给出了一份名单:

规格方面,这款M.2 2280 SSD使用群联PS5012-E12主控、不知来源3D TLC闪存,支持PCIe 3.0 x4、NVMe 1.3、SLC缓存加速,容量256GB、512GB、1TB,持续读写速度3GB/s、1-3GB/s,随机读写速度200-450K IOPS、200-400K IOPS。

最大写入量380TB、800TB、1665TB,平均故障间隔时间200万小时,质保时间3年,平均每天1.4-1.5次全盘写入。

价格没说,但作为一款“划时代”的产品,必然不会便宜。

-

SSD

+关注

关注

21文章

3061浏览量

121784 -

液冷

+关注

关注

5文章

146浏览量

5682

发布评论请先 登录

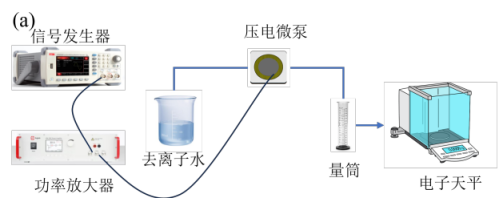

电压放大器在芯片散热驱动液冷系统实验中的应用

液冷散热时代:AI服务器如何重构磁元件设计

英特尔携本地生态伙伴发布双路冷板式全域液冷服务器,引领数据中心散热与能效革新

忆联首款商用消费级QLC SSD AE531深度评测

如何通过优化电能质量在线监测装置的散热系统来降低功耗?

伟创力重磅发布全球首款面向千兆瓦级数据中心的AI基础设施平台

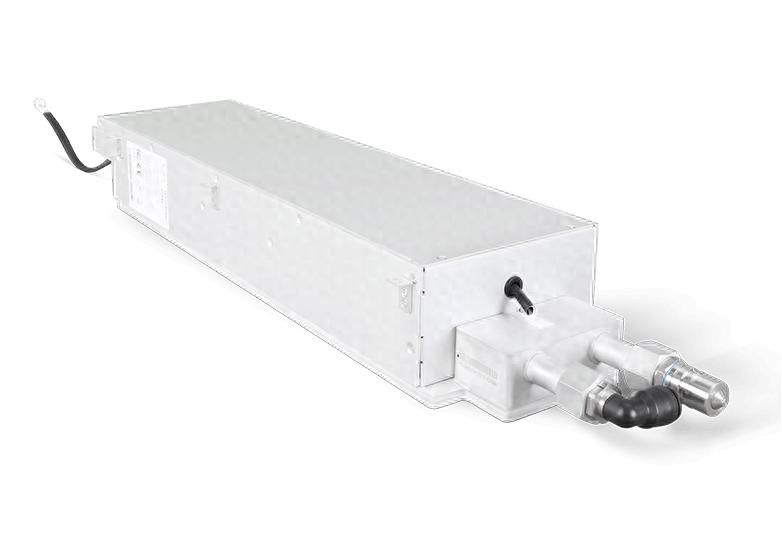

液冷板:液冷技术的关键角色

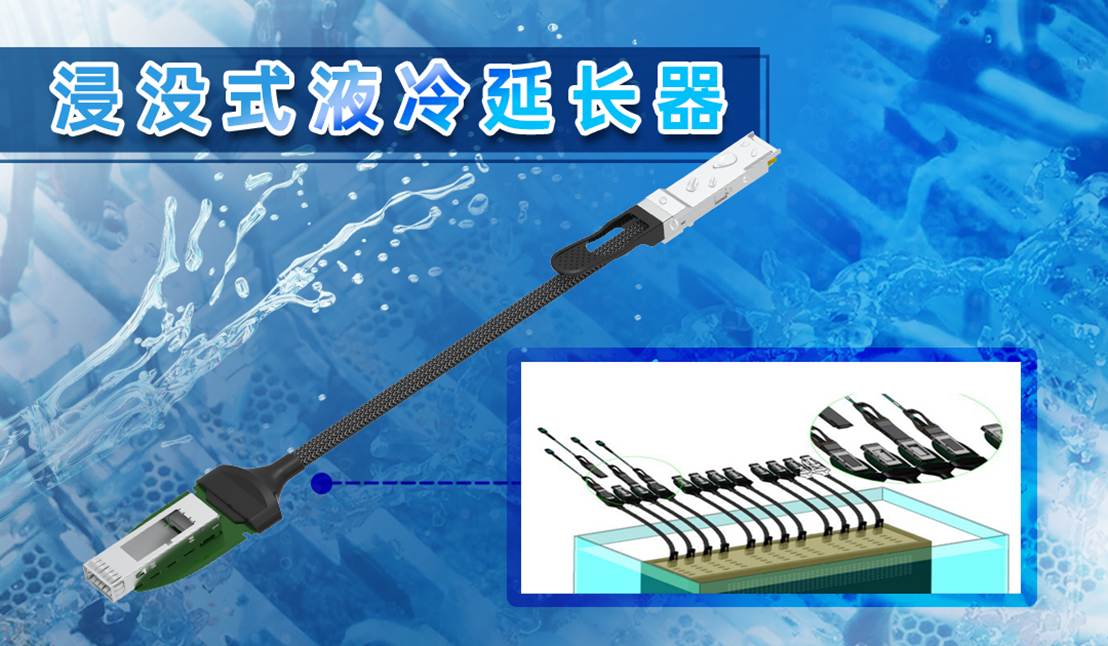

易飞扬浸没液冷延长器与硅光液冷光模块主题研究 ——液冷光互连技术的数据中心革命

可编程电源有哪些温度控制措施?

【技术贴】超低功耗黑科技!艾为AW86320 高压液冷驱动IC,散热新宠诞生

南芯科技推出190Vpp压电微泵液冷驱动芯片SC3601

英特尔引领液冷革新,与壳牌共筑数据中心高效冷却新范式

海瑞思重磅亮相深圳液冷散热峰会

AI服务器液冷散热如何实现动态平衡?

TeamGroup发布首款液冷散热SSD 可降低10℃

TeamGroup发布首款液冷散热SSD 可降低10℃

评论