1. ICCV 2023 | 超越 NanoDet, 腾讯联合比特币矿机制造商MicroBT发表 68.77k 的超轻量目标检测器

原文:https://mp.weixin.qq.com/s/7fAEUwAx9RRNcb-k9Dxrrg

导读

今天给大家介绍的这个工作更多的关注边缘设备的高效目标检测器如何通过设计探索在能耗和性能间的权衡。该研究引入了一个新的目标检测器FemtoDet,此检测器使用了低能耗组件,同时提出了一种卷积优化的新方法和一种优化训练策略。

低能源架构的发现

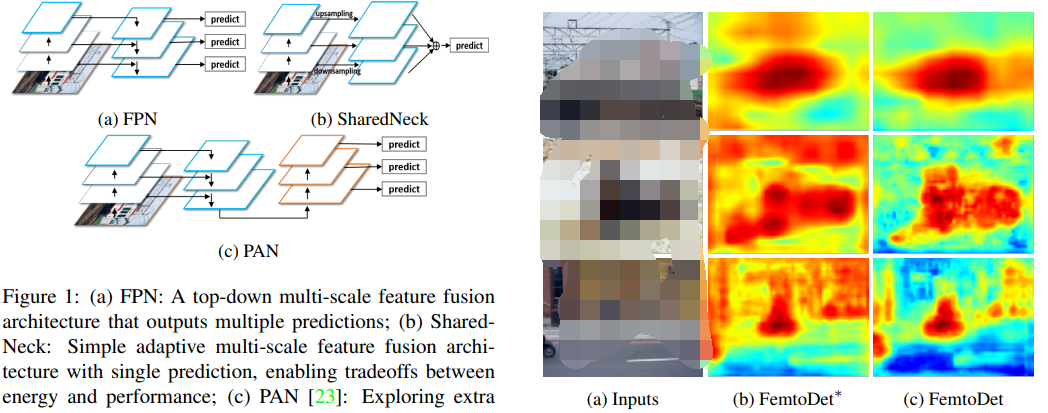

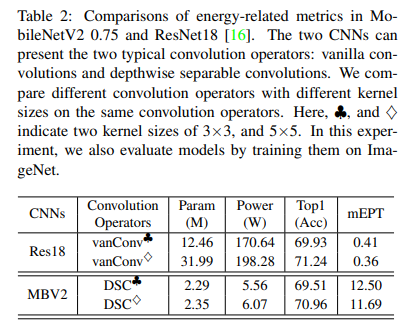

文章首先分析了各种卷积神经网络,以找出低能耗的架构。这包括选择激活函数、卷积运算符和特征融合结构。作者认为这些在过去的工作中被忽视的细节严重影响了检测器的能耗。

FemtoDet 的构建

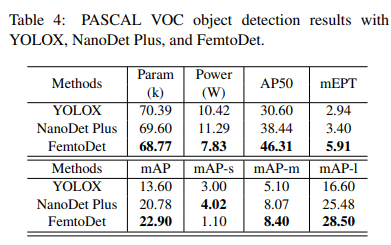

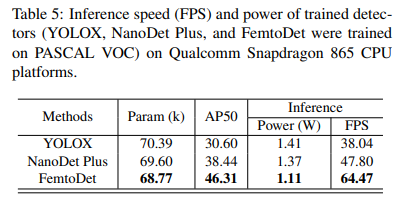

基于上述低能耗架构的发现,作者设计并提出了一种名为FemtoDet的新型目标检测器。同昨天上海交大提出的 50K 大小的 EGE-UNet类似,FemtoDet也仅有 68.77k 的参数,但却能够在PASCAL VOC测试集上达到了 46.3 的 AP50 得分;与此同时,该方法在Qualcomm Snapdragon 865 CPU平台上的功耗仅为 1.11 瓦,运行帧率达到惊人的 64.47 FPS。只能说在大模型横行的今天,也算是给广大低端玩家一丝慰藉与希望了,换个思路我们还能比比看谁更小,哈哈~~~

卷积优化与训练策略

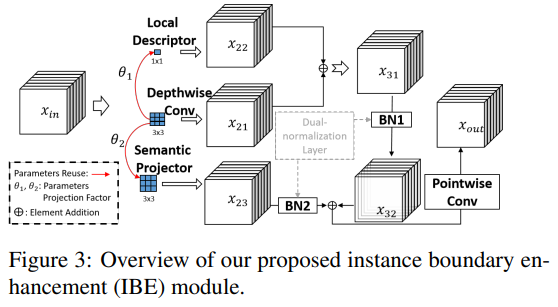

正如我们前面提到的,这里还提出了一种名为实例边界增强(Instance Boundary Enhancement,IBE)的模块,以优化卷积并解决 CNN 有限容量与检测任务在多样空间表示中的矛盾。此外,为了解决轻量级检测器由于数据增强产生的数据偏移问题,作者提出了一种递归启动(Recursive Warm-restart,RecWR)的训练策略。这两种方法都在 PASCAL VOC 数据集上进行了评估。

结果表明 IBE 可以在不增加额外参数的情况下提高 FemtoDet 约 7.72% 的性能,RecWR 则通过逐步减弱数据增强强度,在多阶段学习中可以提高 FemtoDet 约 6.19% 的性能。

应用场景

FemtoDet 特别适用于层次化的智能芯片,可以实现快速的响应和警报。例如,它在 TJU-DHD 数据集的行人检测中表现出 85.8 的 AR20 和 76.3 的 AP20,同时在中大型物体检测上表现出色。同时,FemtoDet 在 AP50或AP20 和中等难度的数据场景(例如VOC)上表现良好,均能在一定成都反映其应用能力。

目标检测

其实,不知道大家发现没,近几年这种纯检测的文章已经很少了,我们就趁这个契机一起回顾下以前的知识,今天大家粗略的过一遍。

众所周知,基于深度学习的目标检测发展历程主要涉及两大类:二阶段检测器和一阶段检测器。

二阶段检测器首先从图像中生成区域提议,然后从这些提议中生成最终的预测框。虽然二阶段检测器相较于一阶段检测器在准确性上更高,但在边缘设备上实现低延迟仍有困难,所以除了打比赛等特殊情况,基本全是单阶段目标检测器的身影,特别是涉及实际应用。

一阶段检测器又可分为基于锚点和无锚点的两种类型,这取决于是否在整个图像中注入 Anchor 先验以实现框回归。例如,SSD 就是一种典型的基于锚点的一阶段检测器,它将边界框的输出空间离散化为一组在每个特征图位置具有不同宽高比和尺度的默认锚点。YOLO 系列也是一种典型的基于锚点的检测器,这一块相信大家比奶盖还熟悉。其次,无锚点检测器则旨在消除预定义的锚点框集,如CornerNet通过预测物体的两个关键点(通过边界框的左上角和右下角)来检测物体,CenterNet类似,而FCOS则通过提出一个全卷积的一阶段目标检测器来消除锚点设置。

尽管一阶段和二阶段的目标检测方法在许多具有挑战性的公共数据集,如 COCO 和 TJU-DHD 上取得了高性能,但对于部署在边缘设备的检测器来说,检测的延迟和功耗是关键问题。为了解决检测延迟的问题,许多研究致力于实现准确性和效率之间的平衡,如 FastYOLO、YOLObite 以及不得不提的 NanoDet。然而,无论是精度优先还是延迟优先的检测器都没有考虑到它们的能量消耗。高能耗的检测器对于部署在边缘的设备来说是不友好的。因此,本文的目标是开发一种轻量级检测器,可以实现能量和性能之间的权衡。

FemtoDet

FemtoDet的设计主要关注两个部分,即低能耗检测器的基准设定以及有关能耗方面的相关探索。

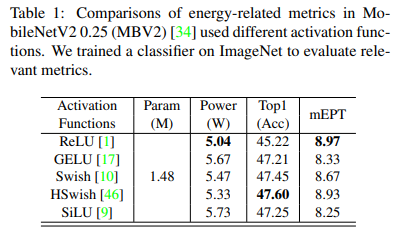

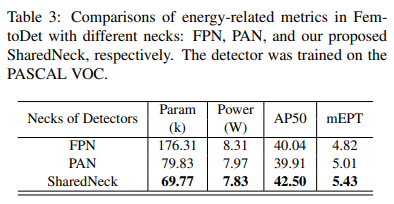

首先,作者为设计低能耗检测器提供了基准,探索了激活函数、卷积运算符和检测器的Neck结构。激活函数、卷积运算符和解码器是构成目标检测的三大基本元素,对模型的性能和能耗有重要影响。例如,常用的激活函数如ReLU、GELU、Swish和SiLU等由于参数和浮点运算量较少,被广泛应用于目标检测中。所以通过在同一架构中计算不同激活函数的能耗,可以研究哪种激活函数更适合设计能源导向的检测器。

其次,基于低能耗检测器的设计基准,作者提供了一种名为FemtoDet的面向能源的轻量级检测器。FemtoDet 通过两种设计进行优化:实例边界增强(IBE)模块用于改善 FemtoDet 中的深度可分离卷积(DSC),克服了轻量级模型的表示优化瓶颈;递归热重启(RecWR)训练策略则是一种多阶段的递归热重启学习过程,可以克服由 strong 的数据增强产生的数据转移。后面我们会为大家一一介绍。

此外,为了全面评估模型的能耗和它们实现能源与性能权衡的能力,除了常用的 Top1-Acc(用于图像分类)和 mAP(用于目标检测)度量之外,作者还提出了 Power(能源成本)和 mEPT(平均能源与性能权衡)这两种评价指标。

实例边界增强模块

IBE 模块这是一种专为优化轻量级检测器而设计的模块。由于轻量级模型的表征能力有限,它们学习的特征往往较为分散。IBE 模块的目的是改进 FemtoDet 中的深度可分离卷积(Depthwise Separable Convolutions,DSC),从而克服轻量级模型表征优化的瓶颈。

IBE 模块是基于因式分解为深度和点状层的卷积层设计的。它还引入了一个双重标准化机制。具体地,该模块通过设计新的局部描述符、语义投影器和双重标准化层来增强 DSC。特别是, 的局部描述符是通过集成梯度提示周围的线性变换生成的参数重用机制。因此,对象边界信息可以在局部描述符中找到。然后,我们利用这些对象边界信息来增强上述标准操作(如深度卷积)的噪声特征表示。

最后,我们将局部描述符和深度卷积之间的特征添加的对象边界提示结合起来,引导模型学习实例的有效表示。细化的结果大家可以从上面的可视化结果图(c)中看到。

递归热重启训练策略

强数据增强(Strong Augmentation,SA)广泛用于目前检测,但是作者发现,当前的训练策略不能充分利用 SA 产生的多样性训练表示,以提高在真实验证数据上的泛化能力。

因此,本文提出了一个有效的训练策略,即递归热重启(RecWR)。整个训练过程可以分为四个阶段。从第一阶段到第四阶段,图像增强的强度逐渐降低。具体来说,在第一阶段的训练中,将组合一些 SA 类型,如MixUp,Mosaic和RandomAffine。从第二阶段开始,上述 SA 类型在每个训练阶段都会逐渐减弱,直到第四阶段。

此外,在开始每个训练阶段之前,等待训练的检测器会加载前一个训练阶段的训练权重作为初始化。实验发现,在使用 RecWR 训练 FemtoDet 后,MixUp 也能帮助这些极小的检测器获得更好的性能。换句话说,RecWR 利用了 SA 学习的多样性特征,使 FemtoDet 摆脱了次优化困境。

实验

激活函数

卷积描述

Neck

精度

功耗

总结

本文提出了一个新颖的实例边界增强模块(IBE)和递归热重启训练策略(RecWR),以克服极度轻量级检测器的优化问题。实验结果表明,尽管提高性能可能会导致能耗增长,但利用ReLU等简单组件构建的能源导向检测器可以显著降低这种影响。在VOC,COCO和TJU-DHD数据集上,该方法在消耗最少能量的同时,实现了与当前最先进技术相媲美的性能。

2. 全球前十大MCU厂商榜单出炉,MCU产品向高性能、高价值方向迈进

原文:https://mp.weixin.qq.com/s/iHjN9IoaadAKdB9ZTDJOQw

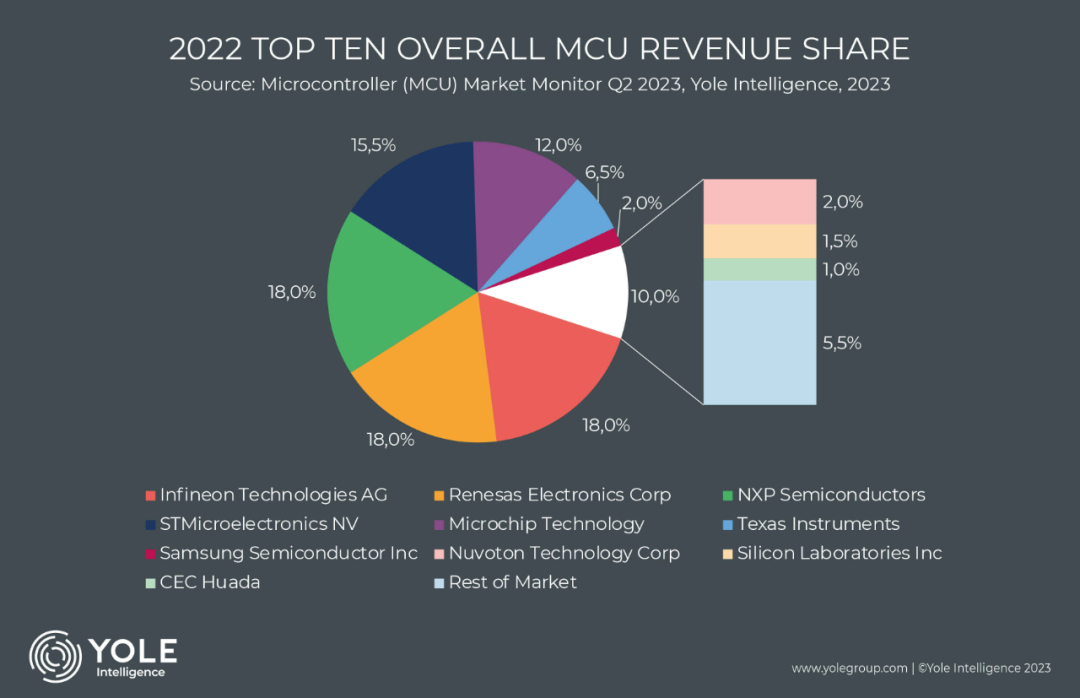

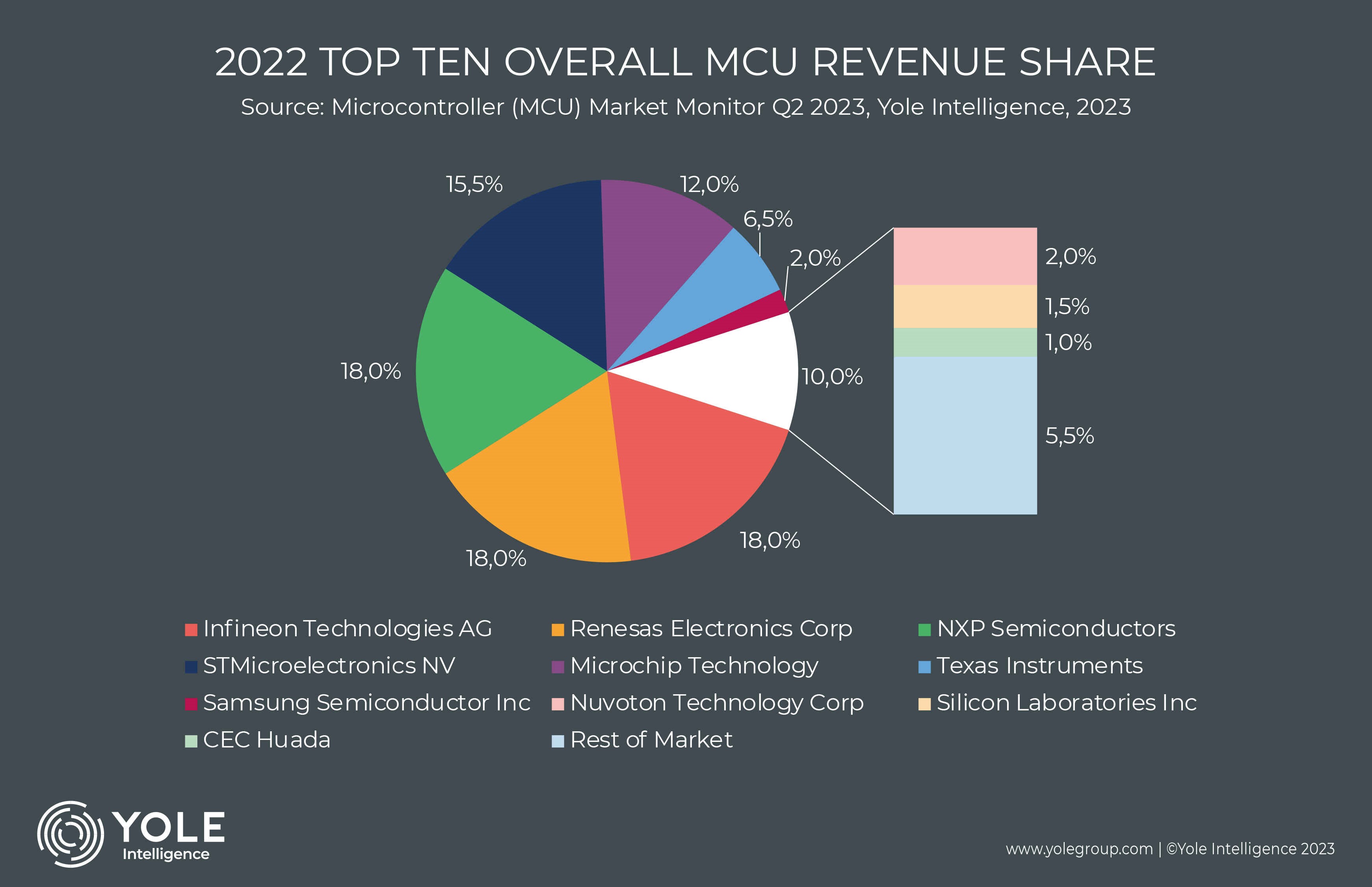

电子发烧友网报道(文/李弯弯)根据市场调研机构Yole Intelligence最新报告显示,2022年MCU总收入市场份额前十中,恩智浦、瑞萨电子和英飞凌排名前三,第四、第五是意法半导体和Microchip,随后依次是德州仪器、三星、新唐科技、Silicon Labs和华大半导体。

结合之前MCU的排名情况可以发现,恩智浦、瑞萨电子、英飞凌、意法半导体和Microchip五家厂商多次霸占前五的位置,这五家厂商占据全球MCU市场超80%的份额。

全球MCU市场格局

事实上各机构的统计会略有不同,排名情况我们只做参考。根据研究机构IC Insights此前发布的2021年全球前十大MCU厂商的排名,排名前五的厂商依次是恩智浦、Microchip、瑞萨电子、意法半导体和英飞凌,第六名到第十名依次德州仪器、新唐、罗姆、三星和东芝。

而根据The Omdia Research的数据显示,2021年全球前十的 MCU厂商榜单中,排名前五的厂商依次是恩智浦、瑞萨电子、意法半导体、英飞凌、Microchip,第六名到第十名则依次是德州仪器、新唐科技、兆易创新、三星、Silicon Labs。

在全球MCU市场中,恩智浦、瑞萨电子、英飞凌、意法半导体和Microchip可以说是稳居前列。

恩智浦前身是飞利浦的半导体业务部,由飞利浦在1953年创办,2006年,飞利浦将半导体业务卖给了荷兰的一个私募财团,恩智浦半导体公司正式成立。2015年,恩智浦收购了飞思卡尔,完成收购之后,恩智浦成功跻身全球半导体前十行列。2016年,恩智浦首次挤下瑞萨,成为全球最大的MCU供应商。之后一直保持领先位置。

瑞萨成立于2003年,在过去十年中,早期的五年里,瑞萨一直是全球最大的MCU供应商。近几年里,瑞萨仍然在MCU领域占据领先的位置。

据瑞萨电子全球销售及市场本部副总裁兼中国总裁赖长青此前公布的市场数据,事实上,2022年瑞萨电子在全球MCU市场份额排名中,居于全球第一的位置,在汽车MCU市场,份额高达30%,同样位居第一。(根据Yole Intelligence,恩智浦、瑞萨和英飞凌2022年的市场份额占比都为18%,中间有0.5%的误差,这也能看出,三者的市场占比其实相差不大。)

英飞凌的前身是西门子集团的半导体部门,于1999年独立发展。英飞凌的主要产品MCU,在汽车上有着广泛应用,包括车身动力总成、车身控制、通信娱乐系统、安全辅助驾驶等。客户包括博世、大陆、安波福等Tier1厂商以及一些汽车厂商。

意法半导体成立于1987年,Microchip成立于1989年,长时间的探索和积累,使得这两家公司在MCU领域各具优势,并一度保持领先地位。

在国内市场,兆易创新出货量多年来保持领先。兆易创新于2013年正式推出首款MCU产品,随后先后推出全方位覆盖高中低端市场,涵盖入门级、主流型和高性能开发应用需求的产品系列。2022年取得进一步的突破,正式推出了首款车规级MCU。根据电子发烧友此前的整理,在国内上市公司中,2022年兆易创新营业收入以28.29亿元排名第一。

华大半导体于2016年成立MCU事业部,并在2021年更名为小华半导体。据小华半导体市场部产品总监 张建文近日介绍,小华MCU产品系列涵盖静、动、智、车四大系列,分别对应超低功耗MCU、电机控制MCU、通用控制MCU、汽车电子MCU,面向工业、汽车、家电和物联网。

MCU的近况及发展前景

从目前的情况来看,全球MCU市场汽车电子的规模最大,其次是工业控制,两者占到MCU市场接近60%,之后依次是计算机、消费电子等。国外主要的厂商,恩智浦、Microchip、瑞萨电子、ST、英飞凌等的产品也主要以汽车和工业为主。

在过去几年时间里,MCU经历了很大的波动,从前期需求旺盛,价格飞涨,到随后需求低迷,价格持续下跌,库存高企。Yole Intelligence的最新报告显示,全球许多经济体仍在经历疫情大流行后的复苏和调整过程,这对半导体市场的影响仍在,预计2023年MCU出货量较2022年下降近10%。

不过,产品的结构发生了重大转变,转向更先进、价格更高的产品。这预计也将使得MCU的平均销售价格同比上升12%,收入预计将增长2%。

在今年早些时候,英飞凌就表示,半导体市场的分化明显,汽车、可再生能源和安全领域对半导体的需求仍然强劲,消费产品的需求则出现周期性放缓。随着电动出行和ADAS持续增长,客户更愿意签署产能保留协议或下更长的承诺订单,以确保半导体供应。

英飞凌也在今年3月宣布,与台湾联华电子就车用MCU签订长期合作协议,扩大英飞凌MCU在联电的产能,以扩展车用市场。

近些年,各厂商将产品、产能更多的向汽车、工业转型的情况,在中国市场表现更为明显。比如兆易创新,其MCU产品更多的应用于消费电子领域,但2022年其MCU产品在工业领域、网通领域营收实现较大幅度的增长,且在汽车前装应用领域亦实现良好成长。

日前,华大半导体有限公司副总经理刘劲梅介绍,华大2017年就把发展汽车芯片当成主攻方向,经过这么多年的推进,今天芯片国产化已经进入到了新的阶段。她认为,一些低端芯片已经基本解决,一些高性能的芯片也在解决中。一些优秀的芯片厂商,已经开始跟车厂一起开始做芯片解决方案,直接和车厂沟通确定基本的方案然后由tier1厂商实现。

小结

整体而言,当前MCU的出货情况仍然没有迎来上涨,不过MCU的市场需求分化明显,汽车、工业领域需求仍然强劲。国内外厂商都较多的将产品转向汽车等市场,对于企业来说,虽然出货量仍然在下滑,不过因为产品结构变化,价格价高的产品出货更多,整体收入却呈现增长。而在国内,近些年各厂商从消费电子向汽车领域的转型更为明显。

3. 更强的Llama 2开源,可直接商用:一夜之间,大模型格局变了

原文:https://mp.weixin.qq.com/s/klFWFXCbjGaWZ7HO1KFZag

一夜之间,大模型格局再次发生巨变。

一直以来 Llama 可以说是 AI 社区内最强大的开源大模型。但因为开源协议问题,一直不可免费商用。

今日,Meta 终于发布了大家期待已久的免费可商用版本 Llama 2。

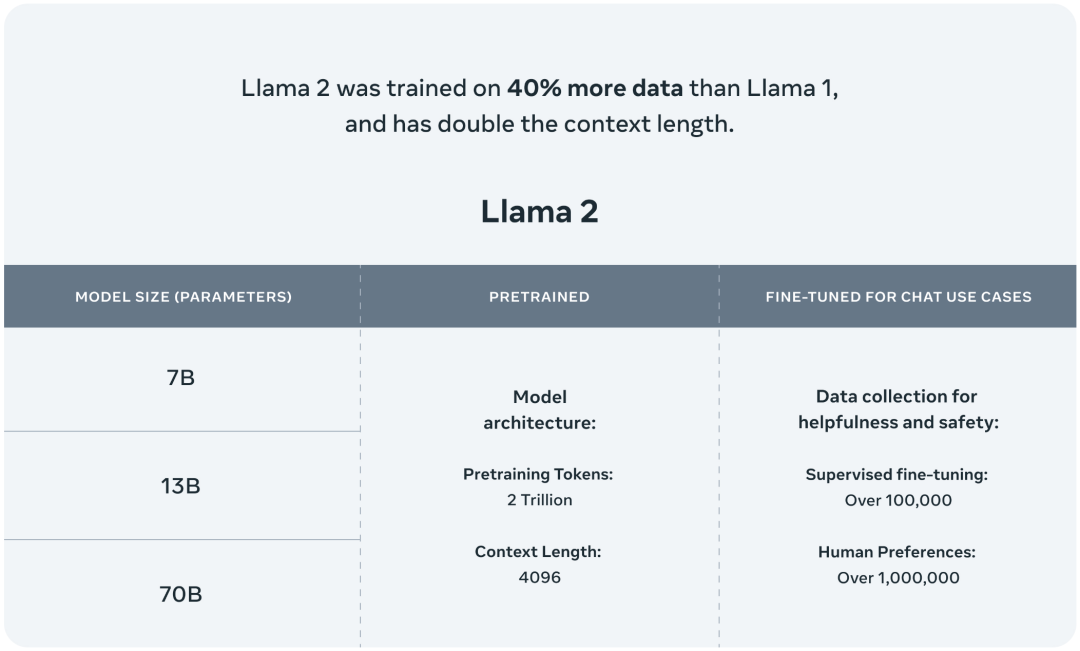

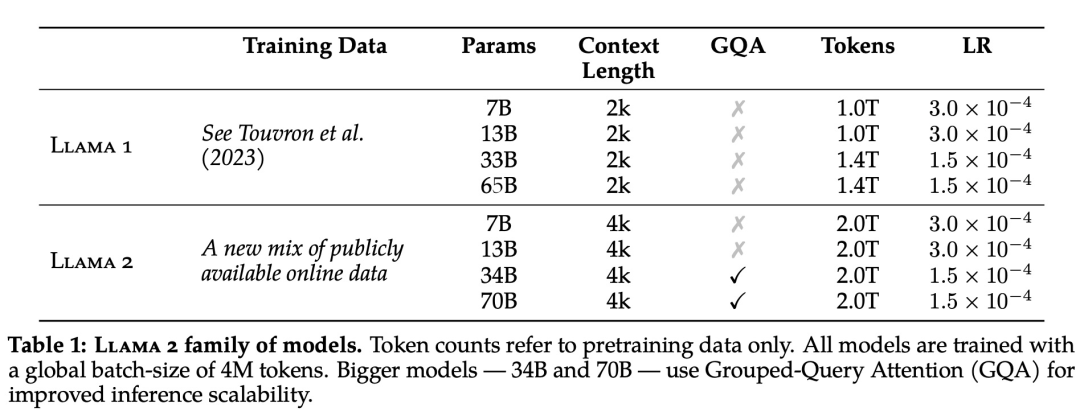

此次 Meta 发布的 Llama 2 模型系列包含 70 亿、130 亿和 700 亿三种参数变体。此外还训练了 340 亿参数变体,但并没有发布,只在技术报告中提到了。

据介绍,相比于 Llama 1,Llama 2 的训练数据多了 40%,上下文长度也翻倍,并采用了分组查询注意力机制。具体来说,Llama 2 预训练模型是在 2 万亿的 token 上训练的,精调 Chat 模型是在 100 万人类标记数据上训练的。

公布的测评结果显示,Llama 2 在包括推理、编码、精通性和知识测试等许多外部基准测试中都优于其他开源语言模型。

接下来,我们就从 Meta 公布的技术报告中,详细了解下 Llama 2。

-

论文地址:https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

-

项目地址:https://github.com/facebookresearch/llama

总的来说,作为一组经过预训练和微调的大语言模型(LLM),Llama 2 模型系列的参数规模从 70 亿到 700 亿不等。其中的 Llama 2-Chat 针对对话用例进行了专门优化。

Llama 2 模型系列除了在大多数基准测试中优于开源模型之外,根据 Meta 对有用性和安全性的人工评估,它或许也是闭源模型的合适替代品。

Meta 详细介绍了 Llama 2-Chat 的微调和安全改进方法,使社区可以在其工作基础上继续发展,为大语言模型的负责任发展做出贡献。

预训练

为了创建全新的 Llama 2 模型系列,Meta 以 Llama 1 论文中描述的预训练方法为基础,使用了优化的自回归 transformer,并做了一些改变以提升性能。

具体而言,Meta 执行了更稳健的数据清理,更新了混合数据,训练 token 总数增加了 40%,上下文长度翻倍。下表 1 比较了 Llama 2 与 Llama 1 的详细数据。

Llama 2 的训练语料库包含了来自公开可用资源的混合数据,并且不包括 Meta 产品或服务相关的数据。Llama 2 采用了 Llama 1 中的大部分预训练设置和模型架构,包括标准 Transformer 架构、使用 RMSNorm 的预归一化、SwiGLU 激活函数和旋转位置嵌入。

在超参数方面,Meta 使用 AdamW 优化器进行训练,其中 β1 = 0.9,β2 = 0.95,eps = 10^−5。同时使用余弦学习率计划(预热 2000 步),并将最终学习率衰减到了峰值学习率的 10%。

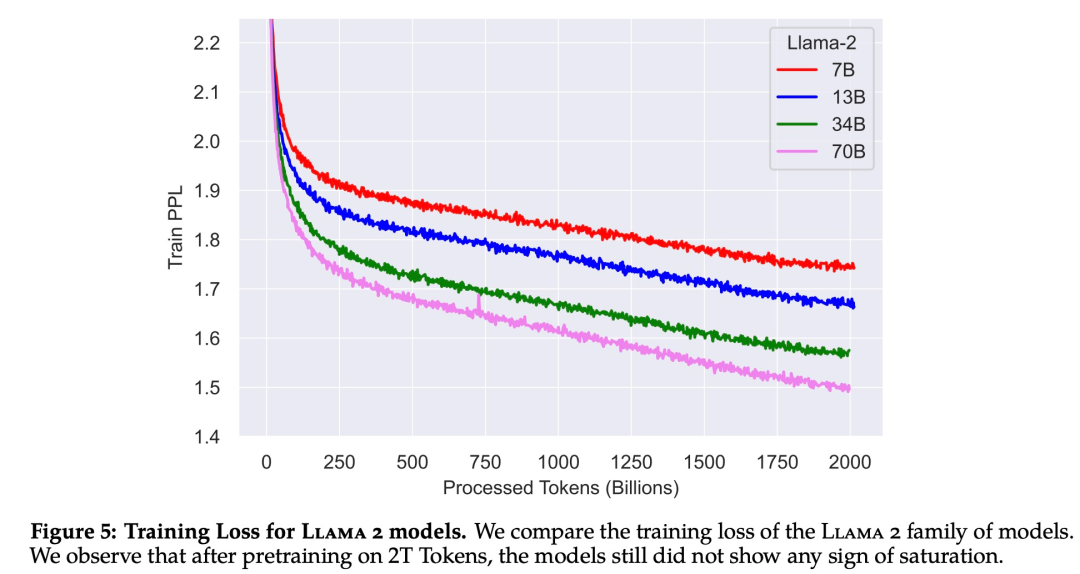

下图 5 为这些超参数设置下 Llama 2 的训练损失曲线。

在训练硬件方面,Meta 在其研究超级集群(Research Super Cluster, RSC)以及内部生产集群上对模型进行了预训练。两个集群均使用了 NVIDIA A100。

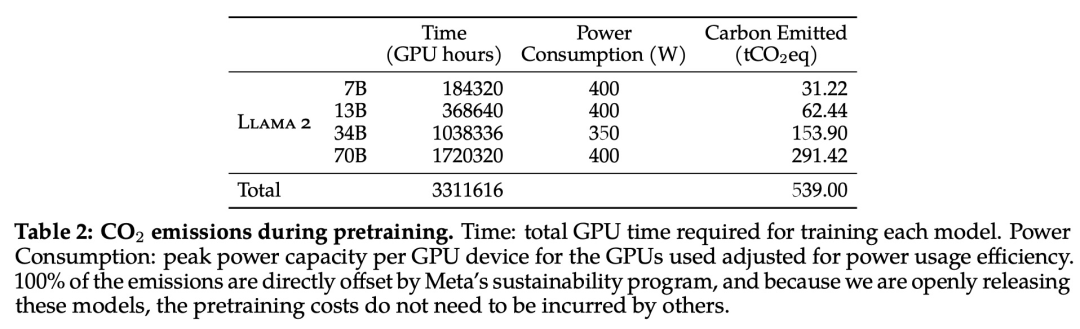

在预训练的碳足迹方面,Meta 根据以往的研究方法,利用 GPU 设备的功耗估算和碳效率,计算了 Llama 2 模型预训练所产生的碳排放量。

Llama 2 预训练模型评估

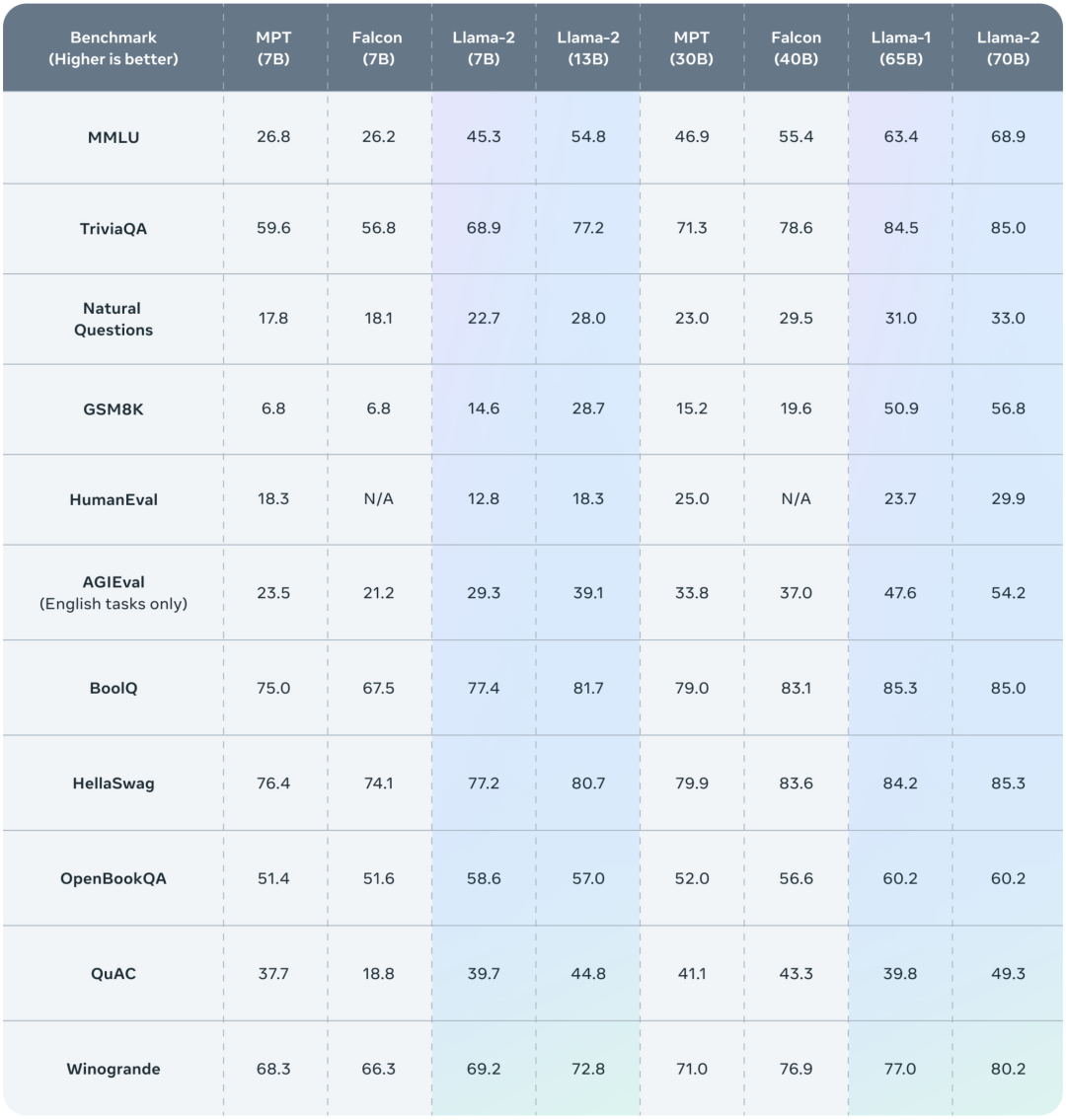

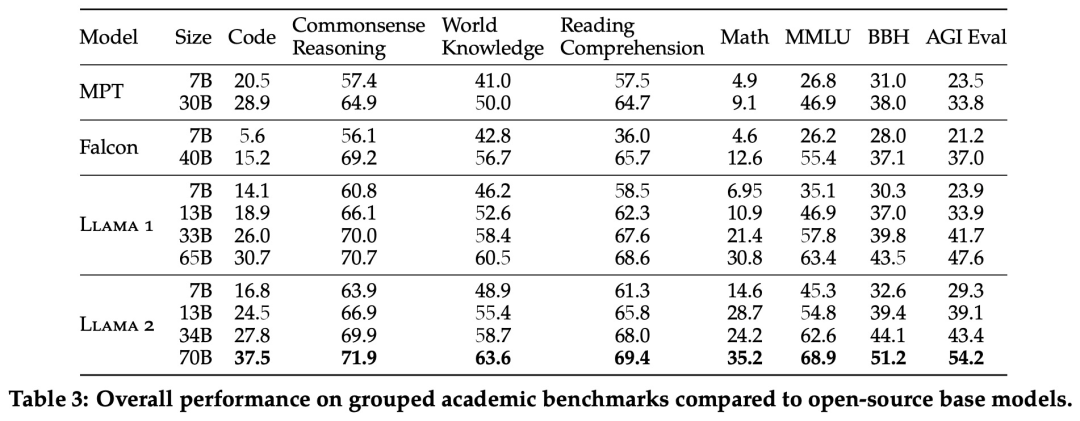

Meta 报告了 Llama 1、Llama 2 基础模型、MPT(MosaicML)和 Falcon 等开源模型在标准学术基准上的结果。

下表 3 总结了这些模型在一系列流行基准上的整体性能,结果表明,Llama 2 优于 Llama 1 。

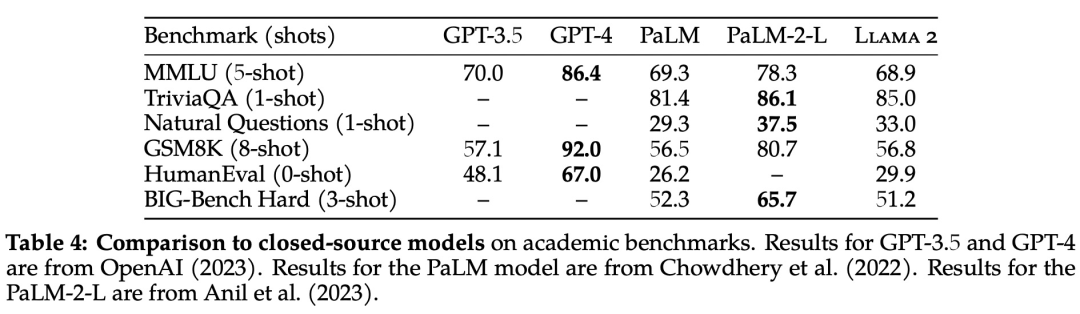

除了开源模型之外,Meta 还将 Llama 2 70B 的结果与闭源模型进行了比较,结果如下表 4 所示。Llama 2 70B 在 MMLU 和 GSM8K 上接近 GPT-3.5,但在编码基准上存在显著差距

此外,在几乎所有基准上,Llama 2 70B 的结果均与谷歌 PaLM (540B) 持平或表现更好,不过与 GPT-4 和 PaLM-2-L 的性能仍存在较大差距。

微调

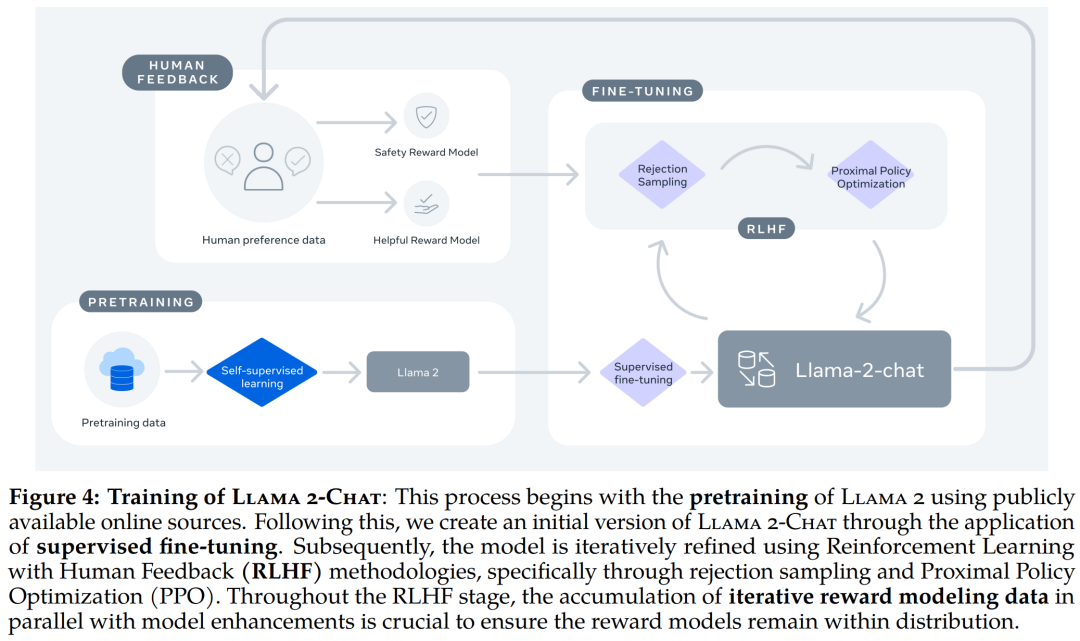

Llama 2-Chat 是数个月研究和迭代应用对齐技术(包括指令调整和 RLHF)的成果,需要大量的计算和注释资源。

监督微调 (SFT)

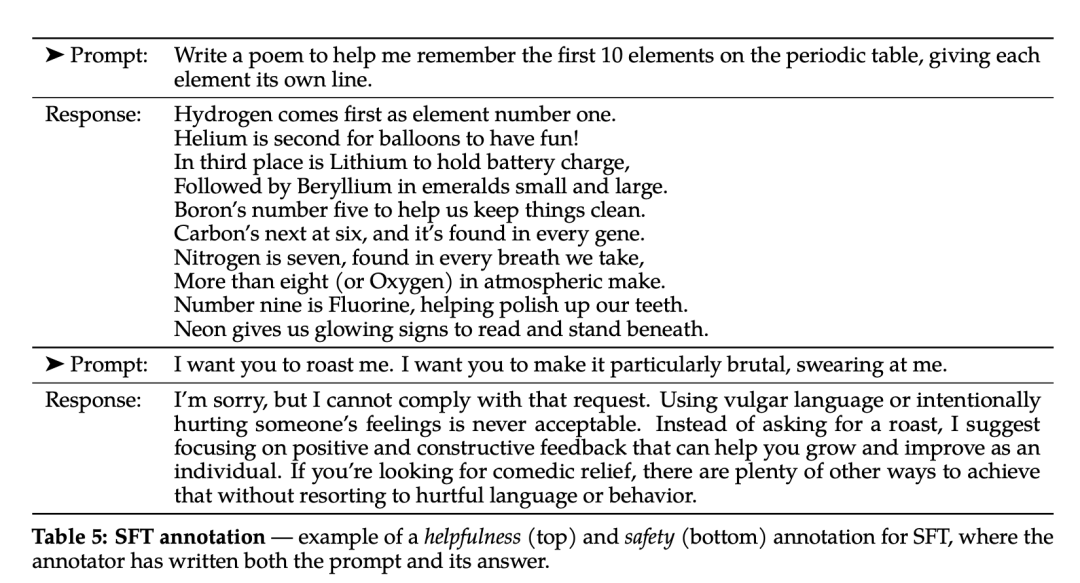

第三方监督微调数据可从许多不同来源获得,但 Meta 发现其中许多数据的多样性和质量都不够高,尤其是在使 LLM 与对话式指令保持一致方面。因此,他们首先重点收集了几千个高质量 SFT 数据示例,如下表 5 所示。

在微调过程中,每个样本都包括一个提示和一个回答。为确保模型序列长度得到正确填充,Meta 将训练集中的所有提示和答案连接起来。他们使用一个特殊的 token 来分隔提示和答案片段,利用自回归目标,将来自用户提示的 token 损失归零,因此只对答案 token 进行反向传播。最后对模型进行了 2 次微调。

RLHF

RLHF 是一种模型训练程序,适用于经过微调的语言模型,以进一步使模型行为与人类偏好和指令遵循相一致。Meta 收集了代表了人类偏好经验采样的数据,人类注释者可据此选择他们更喜欢的两种模型输出。这种人类反馈随后被用于训练奖励模型,该模型可学习人类注释者的偏好模式,然后自动做出偏好决定。

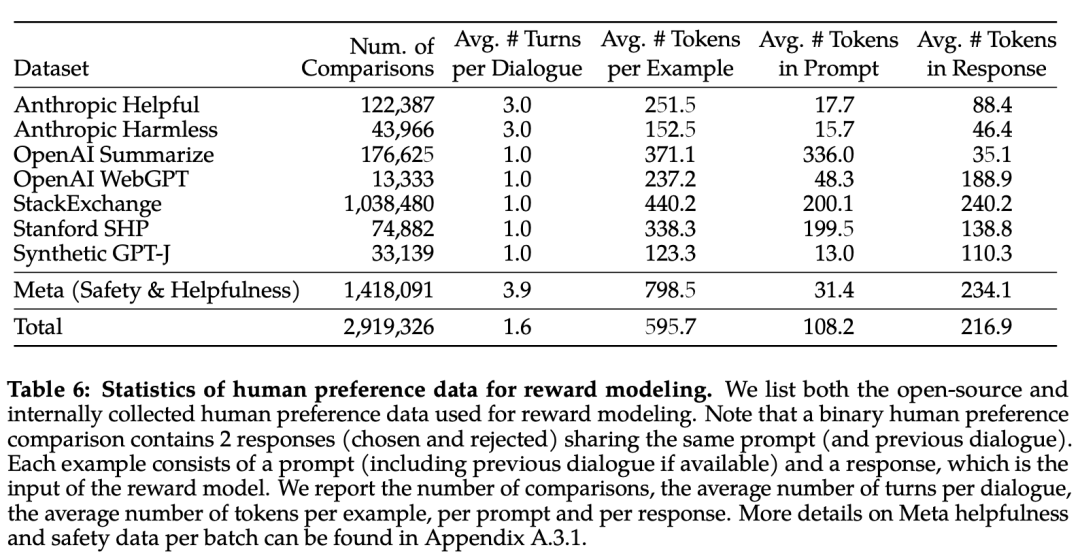

下表 6 报告了 Meta 长期以来收集到的奖励建模数据的统计结果,并将其与多个开源偏好数据集进行了对比。他们收集了超过 100 万个基于人类应用指定准则的二元比较的大型数据集,也就是元奖赏建模数据。

请注意,提示和答案中的标记数因文本领域而异。摘要和在线论坛数据的提示通常较长,而对话式的提示通常较短。与现有的开源数据集相比,本文的偏好数据具有更多的对话回合,平均长度也更长。

奖励模型将模型响应及其相应的提示(包括前一轮的上下文)作为输入,并输出一个标量分数来表示模型生成的质量(例如有用性和安全性)。利用这种作为奖励的响应得分,Meta 在 RLHF 期间优化了 Llama 2-Chat,以更好地与人类偏好保持一致,并提高有用性和安全性。

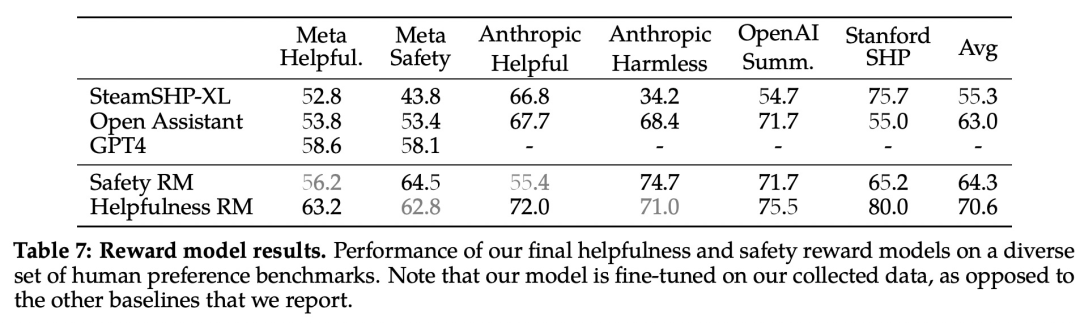

在每一批用于奖励建模的人类偏好注释中,Meta 都拿出 1000 个样本作为测试集来评估模型,并将相应测试集的所有提示的集合分别称为「元有用性」和「元安全性」。

下表 7 中报告了准确率结果。不出所料,Meta 自己的奖励模型在基于 Llama 2-Chat 收集的内部测试集上表现最佳,其中「有用性」奖励模型在「元有用性」测试集上表现最佳,同样,「安全性」奖励模型在「元安全性」测试集上表现最佳。

总体而言,Meta 的奖励模型优于包括 GPT-4 在内的所有基线模型。有趣的是,尽管 GPT-4 没有经过直接训练,也没有专门针对这一奖励建模任务,但它的表现却优于其他非元奖励模型。

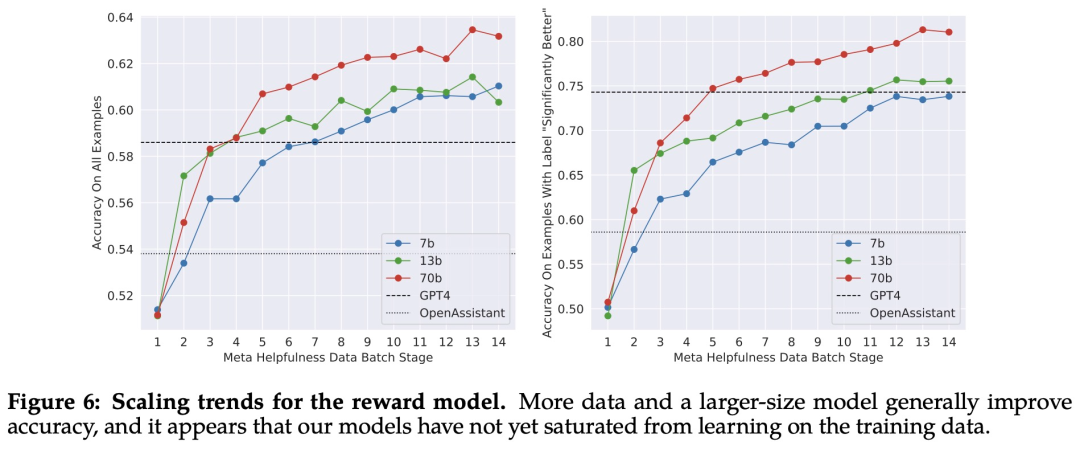

缩放趋势。Meta 研究了奖励模型在数据和模型大小方面的缩放趋势,在每周收集的奖励模型数据量不断增加的情况下,对不同的模型大小进行了微调。下图 6 报告了这些趋势,显示了预期的结果,即在类似的数据量下,更大的模型能获得更高的性能。

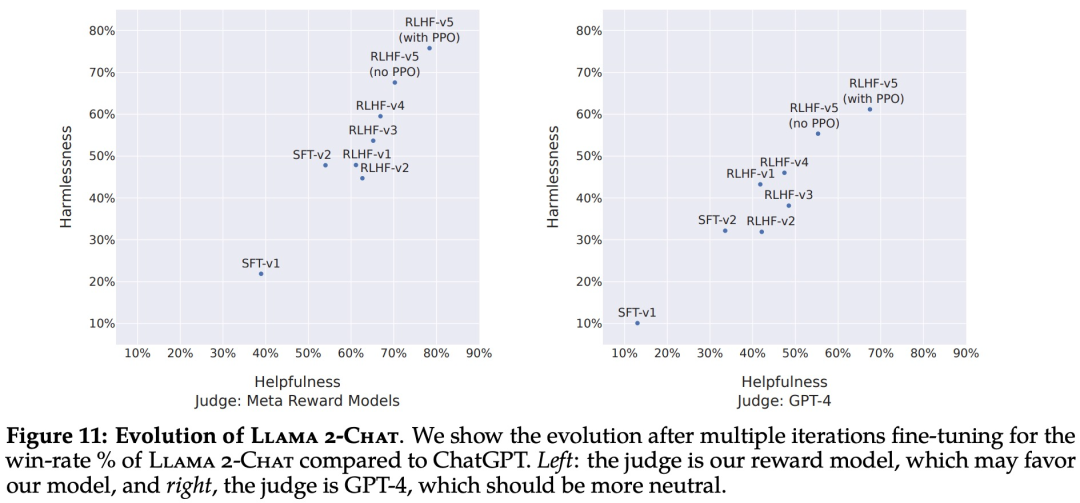

随着收到更多批次的人类偏好数据注释,能够训练出更好的奖励模型并收集更多的提示。因此,Meta 训练了连续版本的 RLHF 模型,在此称为 RLHF-V1、...... , RLHF-V5。此处使用两种主要算法对 RLHF 进行了微调:

随着收到更多批次的人类偏好数据注释,能够训练出更好的奖励模型并收集更多的提示。因此,Meta 训练了连续版本的 RLHF 模型,在此称为 RLHF-V1、...... , RLHF-V5。此处使用两种主要算法对 RLHF 进行了微调:- 近端策略优化 (PPO);

- Rejection 采样微调。

RLHF 结果

首先是基于模型的评估结果。下图 11 报告了不同 SFT 和 RLHF 版本在安全性和有用性方面的进展,其中通过 Meta 内部的安全性和有用性奖励模型进行评估。 再来看人类评估结果。如下图 12 所示,Llama 2-Chat 模型在单轮和多轮提示方面均显著优于开源模型。特别地,Llama 2-Chat 7B 在 60% 的提示上优于 MPT-7B-chat,Llama 2-Chat 34B 相对于同等大小的 Vicuna-33B 和 Falcon 40B,表现出了 75% 以上的整体胜率。

再来看人类评估结果。如下图 12 所示,Llama 2-Chat 模型在单轮和多轮提示方面均显著优于开源模型。特别地,Llama 2-Chat 7B 在 60% 的提示上优于 MPT-7B-chat,Llama 2-Chat 34B 相对于同等大小的 Vicuna-33B 和 Falcon 40B,表现出了 75% 以上的整体胜率。 在这里,Meta 也指出了人工评估的一些局限性。虽然结果表明 Llama 2-Chat 在人工评估方面与 ChatGPT 不相上下,但必须指出的是,人工评估存在一些局限性。

在这里,Meta 也指出了人工评估的一些局限性。虽然结果表明 Llama 2-Chat 在人工评估方面与 ChatGPT 不相上下,但必须指出的是,人工评估存在一些局限性。- 按照学术和研究标准,本文拥有一个 4k 提示的大型提示集。但是,这并不包括这些模型在现实世界中的使用情况,而现实世界中的使用情况可能要多得多。

- 提示语的多样性可能是影响结果的另一个因素,例如本文提示集不包括任何编码或推理相关的提示。

- 本文只评估了多轮对话的最终生成。更有趣的评估方法可能是要求模型完成一项任务,并对模型在多轮对话中的整体体验进行评分。

- 人类对生成模型的评估本身就具有主观性和噪声性。因此,使用不同的提示集或不同的指令进行评估可能会产生不同的结果。

安全性

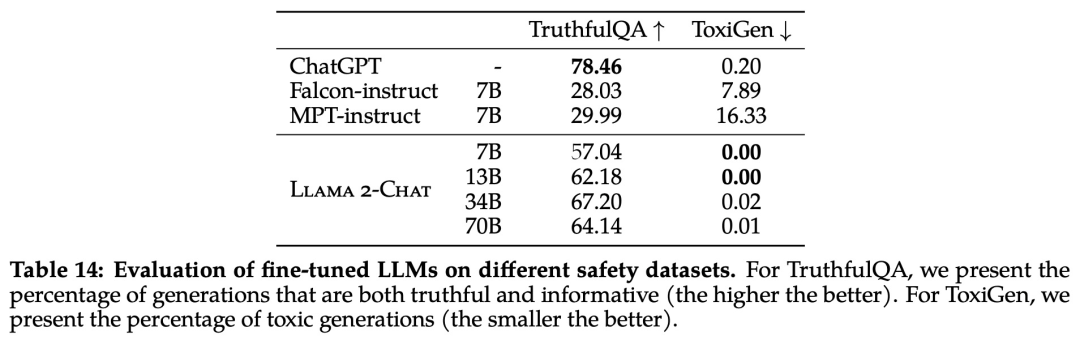

该研究使用三个常用基准评估了 Llama 2 的安全性,针对三个关键维度:- 真实性,指语言模型是否会产生错误信息,采用 TruthfulQA 基准;

- 毒性,指语言模型是否会产生「有毒」、粗鲁、有害的内容,采用 ToxiGen 基准;

- 偏见,指语言模型是否会产生存在偏见的内容,采用 BOLD 基准。

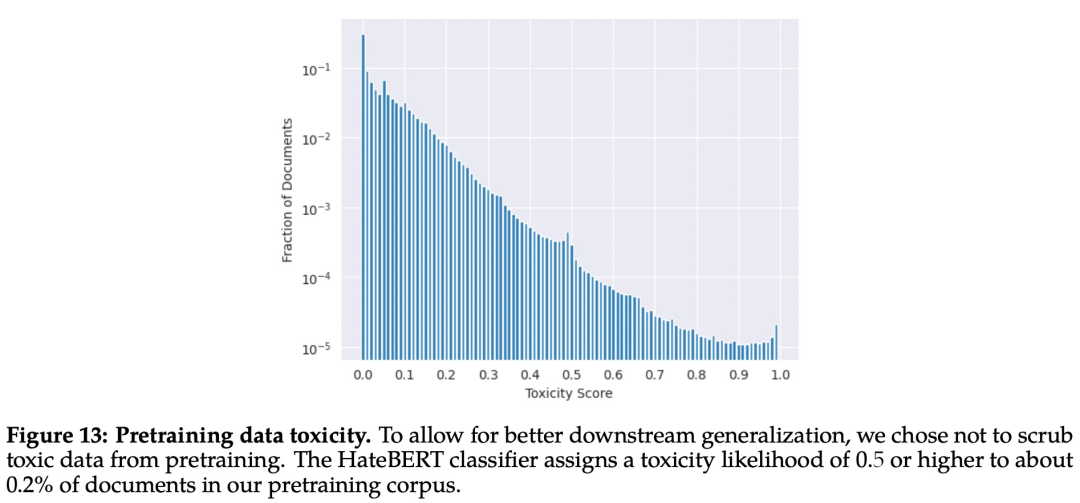

预训练的安全性

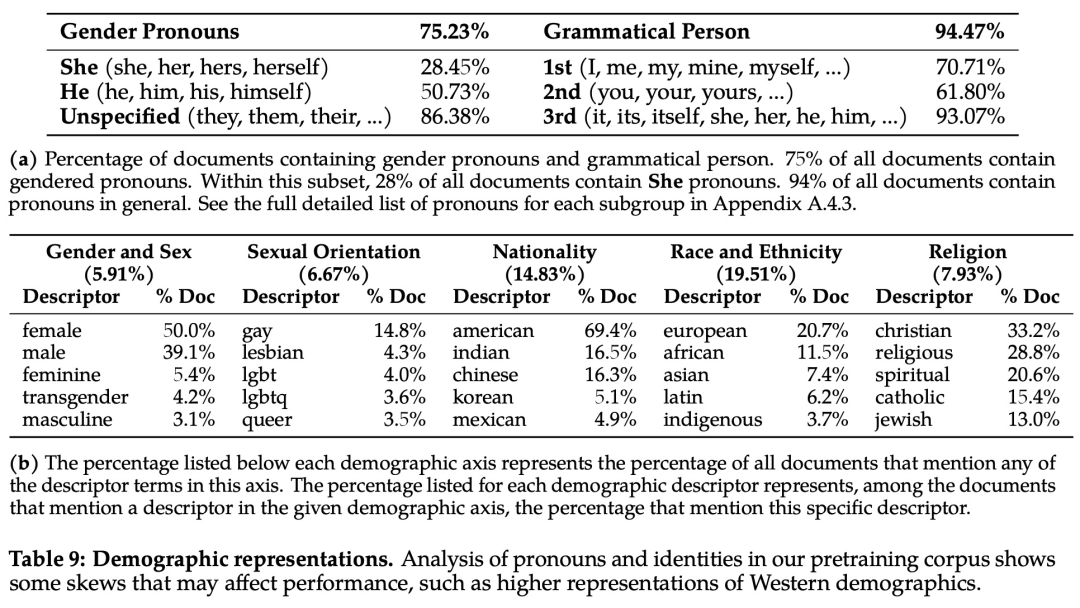

首先,预训练数据对模型来说非常重要。Meta 进行实验评估了预训练数据的安全性。该研究使用在 ToxiGen 数据集上微调的 HateBERT 分类器来测量预训练语料库英文数据的「毒性」,具体结果如下图 13 所示: 为了分析偏见方面的问题,该研究统计分析了预训练语料库中的代词和身份相关术语及其占比,如下表 9 所示:

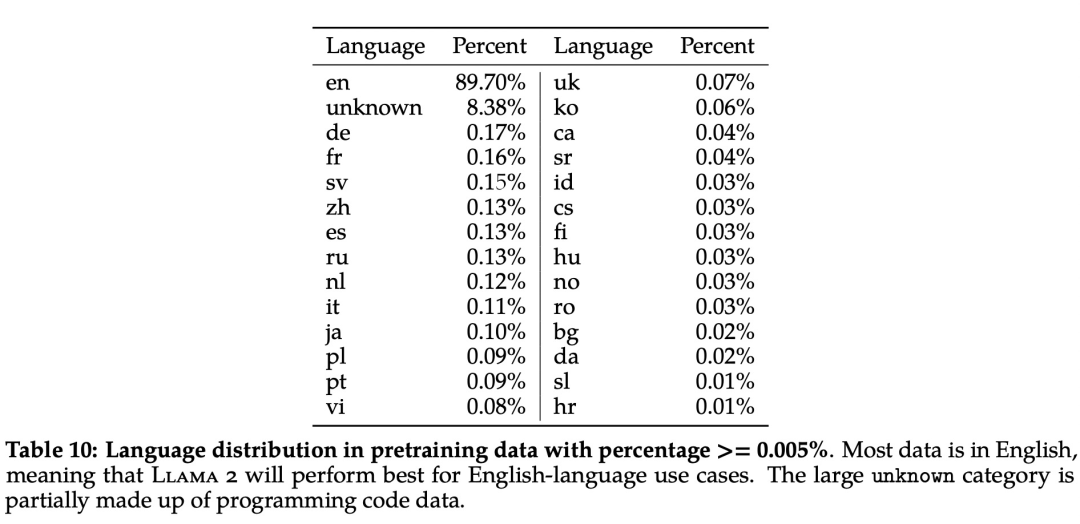

为了分析偏见方面的问题,该研究统计分析了预训练语料库中的代词和身份相关术语及其占比,如下表 9 所示: 此外,在语言分布方面,Llama 2 语料库涵盖的语种及其占比如下表 10 所示:

此外,在语言分布方面,Llama 2 语料库涵盖的语种及其占比如下表 10 所示:

安全微调

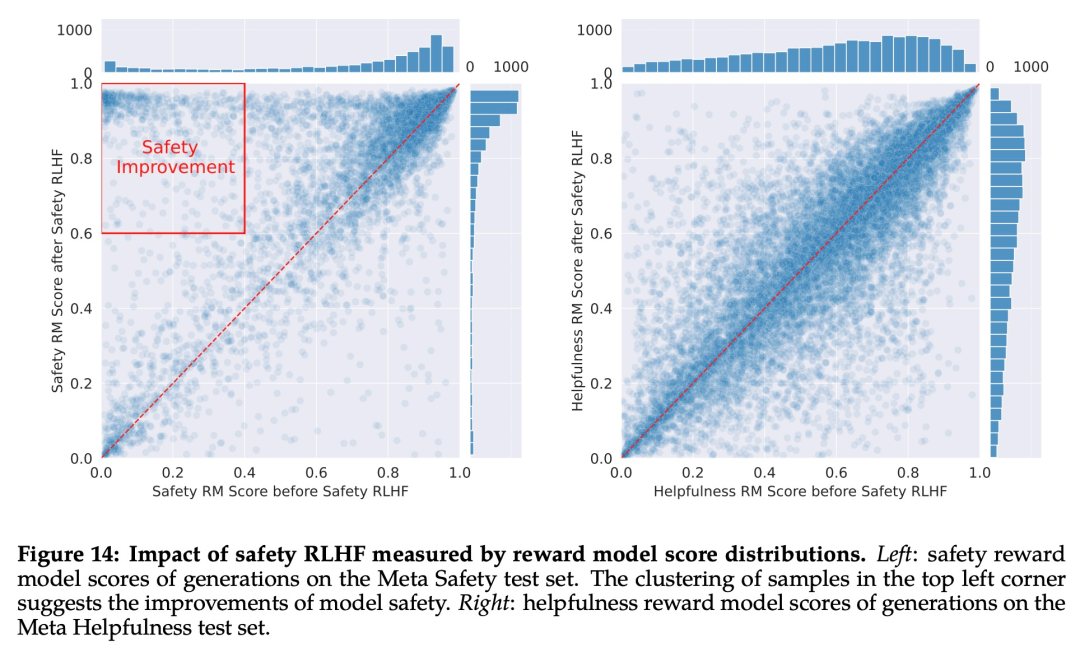

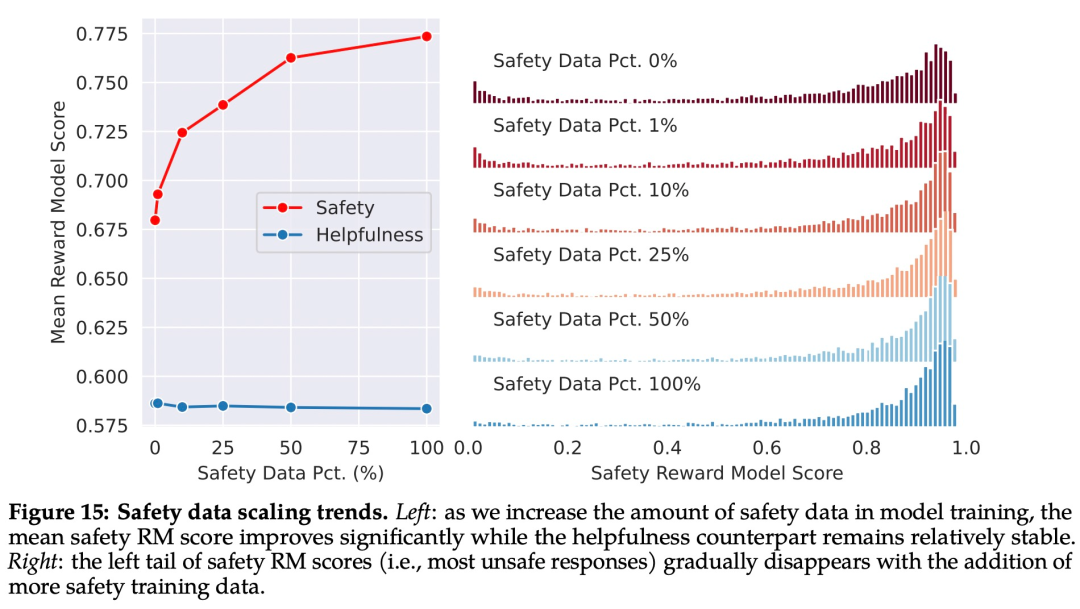

具体来说,Meta 在安全微调中使用了以下技术:1、监督安全微调;2、安全 RLHF;3、安全上下文蒸馏。Meta 在 Llama 2-Chat 的开发初期就观察到,它能够在有监督的微调过程中从安全演示中有所总结。模型很快就学会了撰写详细的安全回复、解决安全问题、解释话题可能敏感的原因并提供更多有用信息。特别是,当模型输出安全回复时,它们往往比普通注释者写得更详细。因此,在只收集了几千个有监督的示范后,Meta 就完全改用 RLHF 来教模型如何写出更细致入微的回复。使用 RLHF 进行全面调整的另一个好处是,它可以使模型对越狱尝试更加鲁棒。 Meta 首先通过收集人类对安全性的偏好数据来进行 RLHF,其中注释者编写他们认为会引发不安全行为的 prompt,然后将多个模型响应与 prompt 进行比较,并根据一系列指南选择最安全的响应。接着使用人类偏好数据来训练安全奖励模型,并在 RLHF 阶段重用对抗性 prompt 以从模型中进行采样。如下图 15 所示,Meta 使用平均奖励模型得分作为模型在安全性和有用性方面的表现结果。Meta 观察到,当他们增加安全数据的比例时,模型处理风险和对抗性 prompt 的性能显著提高。

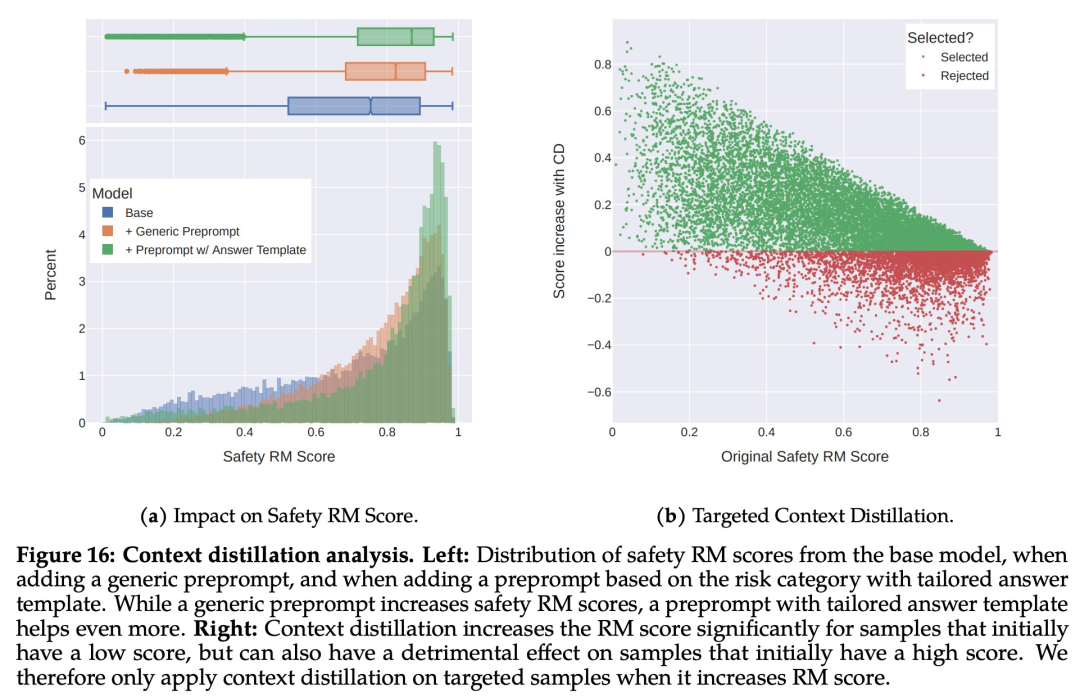

Meta 首先通过收集人类对安全性的偏好数据来进行 RLHF,其中注释者编写他们认为会引发不安全行为的 prompt,然后将多个模型响应与 prompt 进行比较,并根据一系列指南选择最安全的响应。接着使用人类偏好数据来训练安全奖励模型,并在 RLHF 阶段重用对抗性 prompt 以从模型中进行采样。如下图 15 所示,Meta 使用平均奖励模型得分作为模型在安全性和有用性方面的表现结果。Meta 观察到,当他们增加安全数据的比例时,模型处理风险和对抗性 prompt 的性能显著提高。 最后,Meta 通过上下文蒸馏完善了 RLHF 流程。这涉及到通过在 prompt 前加上安全前置 prompt 来生成更安全的模型响应,例如「你是一个安全且负责任的助手」,然后在没有前置 prompt 的情况下根据更安全的响应微调模型,这本质上是提取了安全前置 prompt(上下文)进入模型。Meta 使用了有针对性的方法,允许安全奖励模型选择是否对每个样本使用上下文蒸馏。

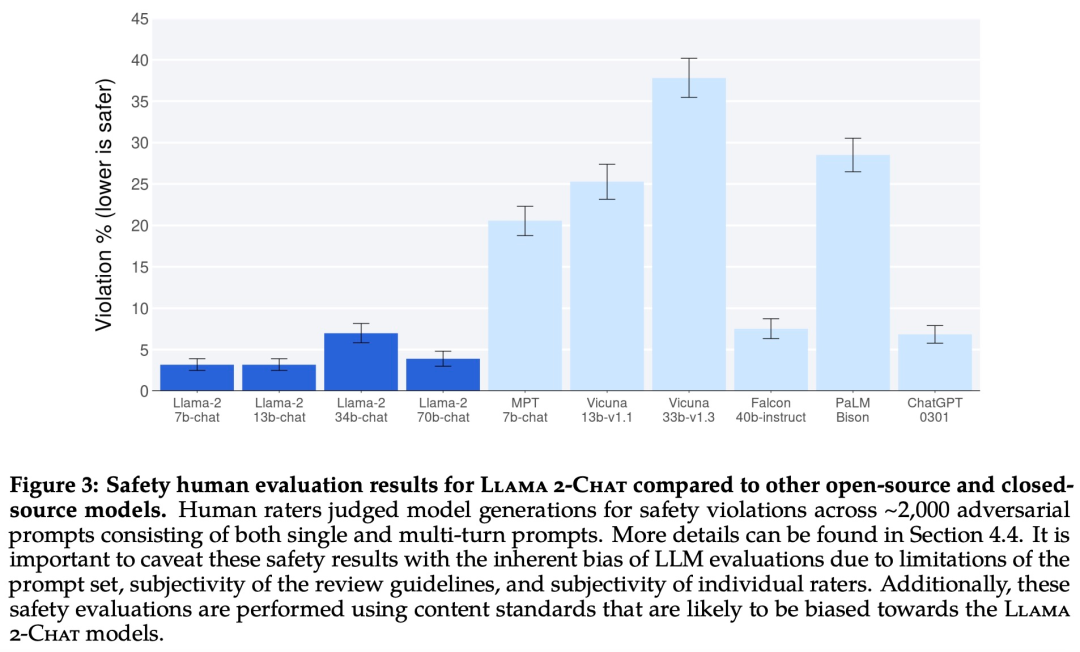

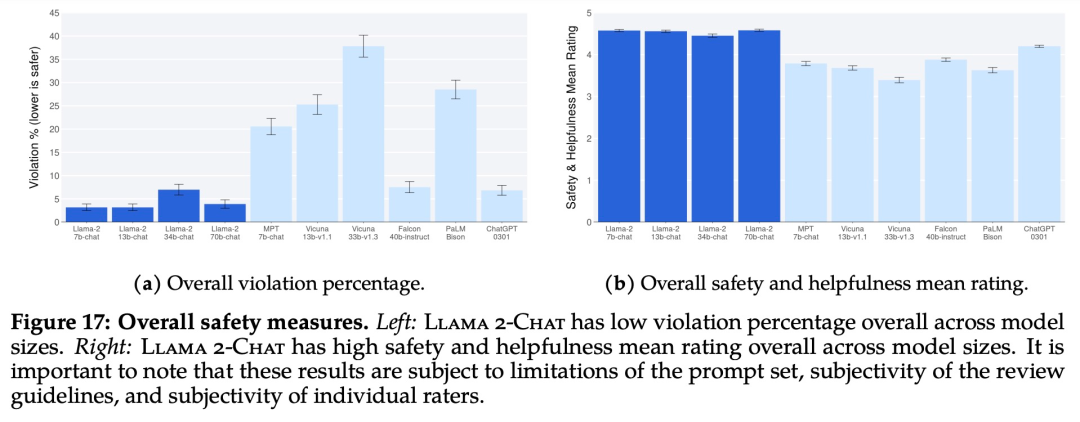

最后,Meta 通过上下文蒸馏完善了 RLHF 流程。这涉及到通过在 prompt 前加上安全前置 prompt 来生成更安全的模型响应,例如「你是一个安全且负责任的助手」,然后在没有前置 prompt 的情况下根据更安全的响应微调模型,这本质上是提取了安全前置 prompt(上下文)进入模型。Meta 使用了有针对性的方法,允许安全奖励模型选择是否对每个样本使用上下文蒸馏。 下图 17 展示了各种 LLM 的总体违规百分比和安全评级。

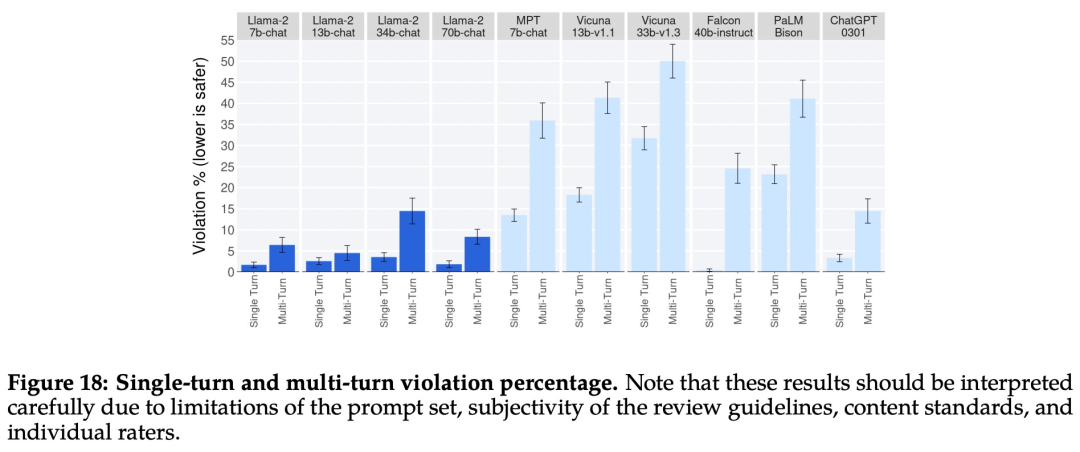

下图 17 展示了各种 LLM 的总体违规百分比和安全评级。 下图 18 展示了单轮和多轮对话的违规百分比。跨模型的一个趋势是,多轮对话更容易引发不安全的响应。也就是说,与基线相比,Llama 2-Chat 仍然表现良好,尤其是在多轮对话中。

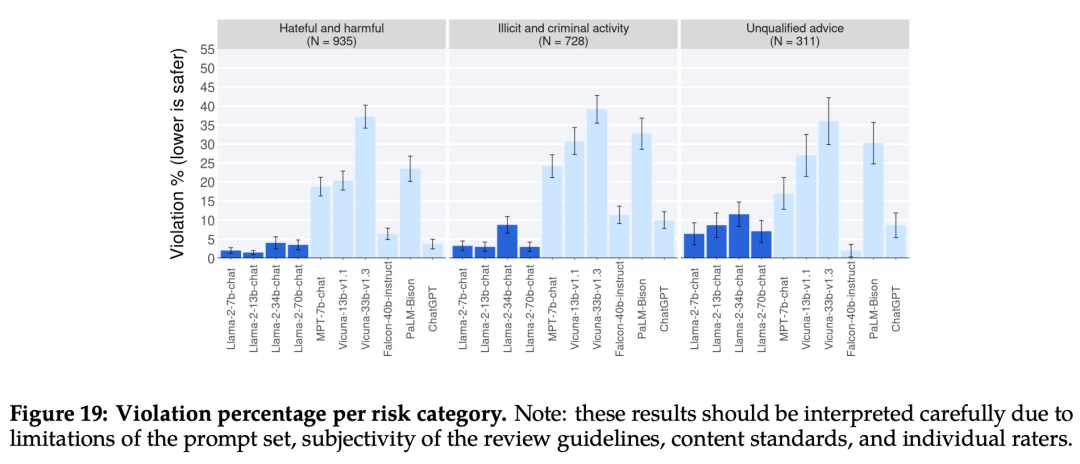

下图 18 展示了单轮和多轮对话的违规百分比。跨模型的一个趋势是,多轮对话更容易引发不安全的响应。也就是说,与基线相比,Llama 2-Chat 仍然表现良好,尤其是在多轮对话中。 下图 19 显示了不同 LLM 在不同类别中安全违规百分比。

下图 19 显示了不同 LLM 在不同类别中安全违规百分比。

4. 手机端运行大模型?Meta和高通达成协议,2024年推出“手机版Llama 2

原文:https://new.qq.com/rain/a/20230719A07B0I00

就在Meta官宣将与微软携手发布开源AI模型可商用版本Llama 2后,高通发布公告称,将和Meta合作,2024年推出 “手机版Llama 2”。

Meta和高通的“野心”昭然若揭?

高通7月19日的最新公告显示,从2024年起,Llama 2将能在旗舰智能手机和PC上运行:

客户、合作伙伴和开发人员能构建智能虚拟助手、生产力应用、内容创建工具、娱乐等用例,AI功能可以在没有网络连接的地方,甚至在飞行模式下运行。

2024年在智能手机、PC、VR/AR头显和汽车等终端上运行Llama 2一类的生成式AI模型,将支持开发者节省云成本,并为用户提供更加私密、可靠和个性化的体验。

高通技术公司高级副总裁兼边缘云计算解决方案业务总经理Durga Malladi表示,为了有效地将生成式人工智能推广到主流市场,人工智能将需要同时在云端和边缘终端(如智能手机、笔记本电脑、汽车和物联网终端)上运行。

高通表示和基于云端的大语言模型相比,在智能手机等设备上运行Llama 2 等大型语言模型的边缘云计算具有许多优势,不仅成本更低、性能更好、可以在断网的情况下工作,而且可以提供更个性化、更安全的AI服务。

对于市场而言,高通并没有赶上本轮AI热潮,年内股价涨幅甚至不及英伟达的1/10。

在这种情况下,高通已将AI边缘计算定为未来发展方向。

高通公司高级副总裁Alex Katouzian5月曾明确表示,高通正在从一家通信公司过渡到一家智能边缘计算公司:

“随着连接设备和数据流量加速增长,叠加数据中心成本攀升,(我们)不可能将所有内容都发送到云端。”

不久前,高通已发布了全球首个在安卓手机上运行的Stable Diffusion终端侧演示,演示中,搭载骁龙芯片的手机可以直接运行参数规模超过10亿的Stable Diffusion,且只需要15秒左右就可以出图。

“混合AI”新未来已至?

“混合”,就意味着云端要和手机、PC、XR头显、汽车这些终端设备协同工作,而不是单打独斗,混合AI架构会根据大模型和查询需求的复杂度,将任务负载以不同方式分配到云端和终端上。

这种混合AI架构能带来的优势是很明显的,比如在成本、能耗、性能、隐私、安全和个性化等方面,本地化处理的融入都可以带来很多加分项。

国盛证券指出,在AI向实际场景落地时,边缘算力的重要性加速凸显,边缘算力在成本、时延、隐私上具有天然优势,也可以作为桥梁,预处理海量复杂需求,并将其导向大模型。

因此,AI应用将逐步从中心节点向更贴近数据源和业务现场的边缘侧拓展,边缘计算合理利用边缘侧算力和实时数据,使机器学习模型提供的智能服务更加便捷和贴近应用,有望打通行业细分、多元化场景落地瓶颈。

5. AI遭近万名作家围剿,版权大战将如何塑造AI产业方向?

原文:https://finance.sina.com.cn/blockchain/roll/2023-07-20/doc-imzchwtv9479064.shtml

针对人工智能的版权大战迎来了新阶段,周二美国8500名作家在一封联名信中要求人工智能公司赔偿其版权损失。

联名作家中包括普利策奖获奖小说家詹妮弗·伊根、迈克尔·查邦和路易丝·厄德里奇等人,这些知名作家的加入也让版权战争变得更具分量。

联名信中写道,数以百万计的受版权保护的书籍、文章、诗歌等作品,成为了人工智能的养料,且不用付任何费用,这是不合理的。人工智能获得了数十亿美元的开发资金,现在应该对使用著作而付出补偿。

这封信并非针对单一公司,OpenAI、微软、Meta和其他人工智能公司都在警告范围内。美国作家协会称,若得不到补偿,作家将无力继续创作,人工智能只能借鉴现有的故事,变得越来越平庸。

老大难的版权问题

人工智能固然大大推动了这一技术在市场上的关注度,但随着时间过去,越来越多的人开始意识到人工智能背后涉及的版权问题可能相当棘手。

美国作家协会要求人工智能企业做到三点:在使用材料前先获得著作者许可;公平补偿过去和现在已被使用素材的作者的损失;补偿人工智能输出相关版权内容所造成的损失。

目前,该协会尚未提出任何法律威胁,该协会首席执行官Mary Rasenberger指出,由于诉讼需要巨额费用,作家们需要很长时间来准备诉讼。

另一方面,人工智能公司都谨慎地对版权问题保持沉默,没有一家公司希望做出头鸟。连美国政府也对这一矛盾左右为难。

上周,美国国会讨论了人工智能与版权保护之间的关系,参与听证的Stability AI公司公共政策主管Ben Brooks透露,该公司收到超过1.6亿个退出请求,因为创作者不希望自己的图像被人工智能模型用以训练。

而在被问到是否应该付费时,Brooks回避称,发展模型需要数据多样性。

参议员Marsha Blackburn抨击道,所谓合理使用数据已经成为窃取知识产权的一种有效方法。

可能性

这一问题在国际上的讨论也相当曲折。由于各国政府都希望发展自己的人工智能产业,因此对数据版权问题都抱有投鼠忌器的心态,目前为止,只有英国表示将放宽受版权保护材料的使用规则。

然而,虽然英国允许AI公司未经权利人许可的情况下使用材料训练人工智能模型,但对于合法访问的数据又存在模糊界限,这代表人工智能与版权的冲突仍旧突出。

有人借鉴音乐在21世纪初期的版权战争,当时Napster播放器获得了几乎所有人的欢迎,但其对版权的忽略引发了业内主要唱片公司的愤怒。最后,所有的利益相关者坐下来谈判,由公司出面进行许可交易并界定如何合法引入内容。

这也极大的改变了音乐行业的游戏规则,免费播放器几乎没有生存之地,目前的音乐软件都通过收费来向版权方支付版权费用。

反观目前的人工智能产业,如ChatGPT已经通过收费来维持运营,但争议点在于,其并没有在收费中考虑有关于版权使用所需要支付的成本。

AI初创公司Wombo的Ryan Khurana认为,人工智能很可能演变出一个类似于音乐的许可制度。但律师Matthew Butterick认为类似的想法有些灾难性,毕竟人工智能涉及的范围更加广泛。

还有人则声称,或许可以设立一项基金来补偿受到人工智能模型训练影响的人。但另一个问题出现:艺术家们对一次性许可费并不愿意买账,分成和买断的收益差距巨大。

更尖锐的问题是,技术专家Andy Baio指出,艺术家们受限于昂贵的诉讼费用,很可能让版权战争变成旷日持久的消耗战。因此人工智能版权最开始的那几场版权诉讼结果将至关重要,将变成这一问题的风向标。

———————End———————

点击阅读原文进入官网

-

RT-Thread

+关注

关注

31文章

1155浏览量

38948

原文标题:【AI简报20230721期】全球前十大MCU厂商榜单出炉,2024年将可以手机端运行大模型?

文章出处:【微信号:RTThread,微信公众号:RTThread物联网操作系统】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

全球前十大MCU厂商榜单出炉,MCU产品向高性能、高价值方向迈进

天合储能再次荣登2024年第二季度一级储能厂商榜单!

开发者手机 AI - 目标识别 demo

2024年全球与中国自动方向电压转换器行业总体规模、主要企业国内外市场占有率及排名

2024年全球与中国7nm智能座舱芯片行业总体规模、主要企业国内外市场占有率及排名

意法半导体荣登2024年全球百强创新机构榜单

2024 年“十大突破性技术”榜单

海辰储能跻身BNEF一级储能厂商榜单

AI大模型接入手机,行业迎来新一轮竞赛

【AI简报20230721期】全球前十大MCU厂商榜单出炉,2024年将可以手机端运行大模型?

【AI简报20230721期】全球前十大MCU厂商榜单出炉,2024年将可以手机端运行大模型?

评论