据证交所传媒报道,英特尔中国区技术总监高宇先生在中国闪存市场峰会上发表观点,AI PC行业全面普及32GB内存,16GB内存即将被淘汰,2025年64GB PC将开始批量交付。此外,他强调AI PC对于固态硬盘性能及储存空间的要求极高。

随着人工智能技术突飞猛进,AI PC将成为个人电脑发展新趋势,用户们可在本地进行深度的人工智能计算,不再依赖于云端服务。这无疑对PC的硬件性能有着更为严格的要求。目前各大CPU企业已针对AI PC推出“CPU+GPU+NPU”的全新架构处理器。

IT门户网站注意到,市场研究公司TrendForce曾在今年1月宣布,微软已将AI PC的内存基础值设定为16GB。长期以来,该公司预测AI PC将刺激PC内存年均需求上升,消费者升级浪潮也将推动这一需求的增长。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

cpu

+关注

关注

68文章

11216浏览量

222928 -

PC

+关注

关注

9文章

2164浏览量

158494 -

人工智能

+关注

关注

1813文章

49734浏览量

261492

发布评论请先 登录

相关推荐

热点推荐

英特尔可变显存技术让32GB内存笔记本流畅运行Qwen 30B大模型

英特尔® 酷睿™ Ultra 200H处理器和32GB内存的AI PC上,英特尔可变显存技术(Intel Variable VRAM Technology)可以

继HBM之后,英伟达带火又一AI内存模组!颠覆AI服务器与PC

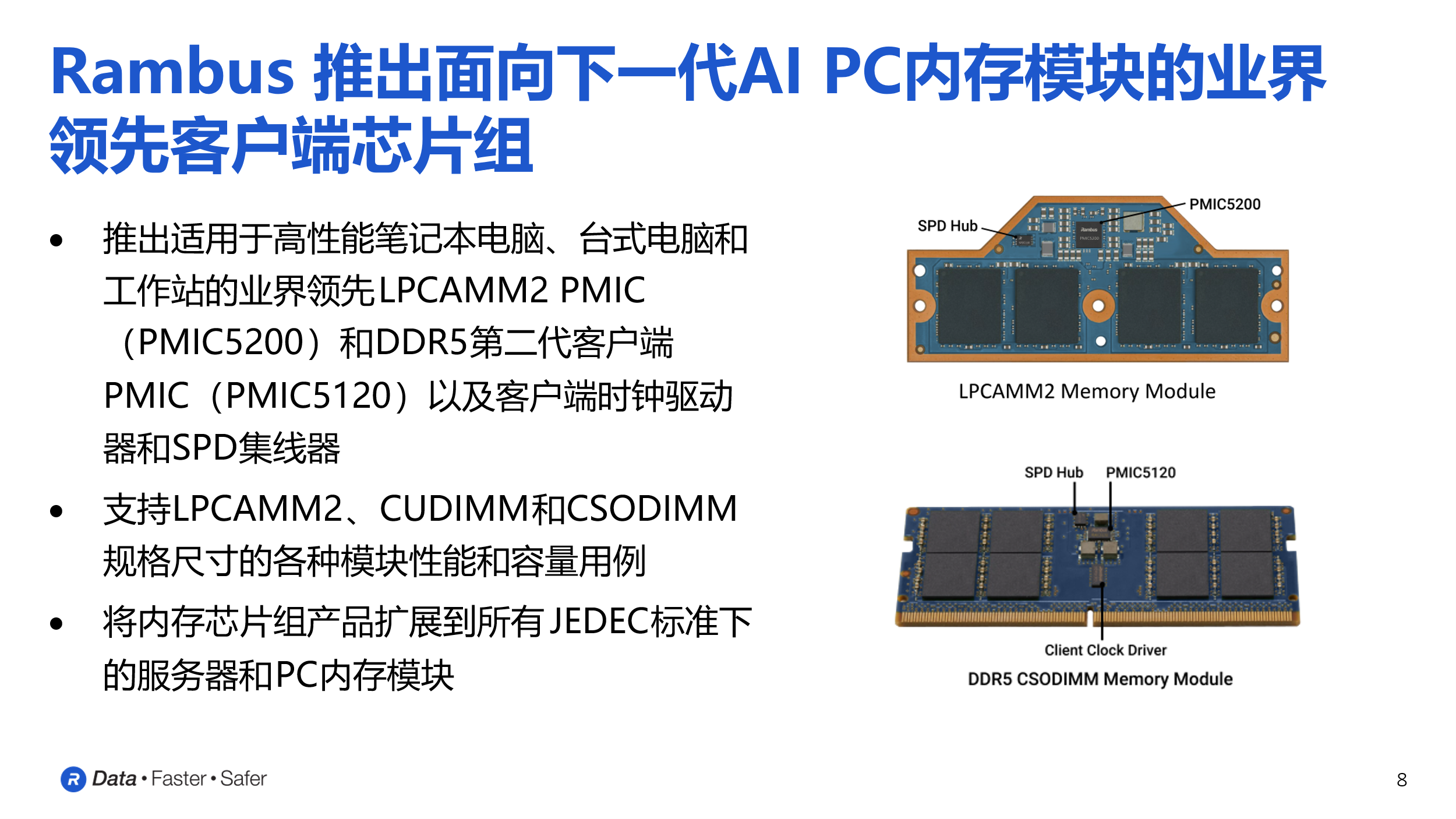

,不仅将用于数据中心AI服务器,也将有望应用于PC。这一举措将对内存市场以及相关产业链产生深远影响。 SOCAMM SOCAMM 全称为 Small Outline Compression

AI PC爆发年!2025出货量将破亿,科技巨头引领产业变革

的投入,将其视为未来科技竞争的核心战场。 市场研究机构Canalys预测,2025年全球AI PC出货量将超过1亿台,占PC总

美光12层堆叠36GB HBM4内存已向主要客户出货

随着数据中心对AI训练与推理工作负载需求的持续增长,高性能内存的重要性达到历史新高。Micron Technology Inc.(美光科技股份有限公司,纳斯达克股票代码:MU)宣布已向多家主要客户送样其12层堆叠36

比肩HBM,SOCAMM内存模组即将商业化

参数规模达数百亿甚至万亿级别,带来巨大内存需求,但HBM内存价格高昂,只应用在高端算力卡上。SOCAMM则有望应用于AI服务器、高性能计算、AI

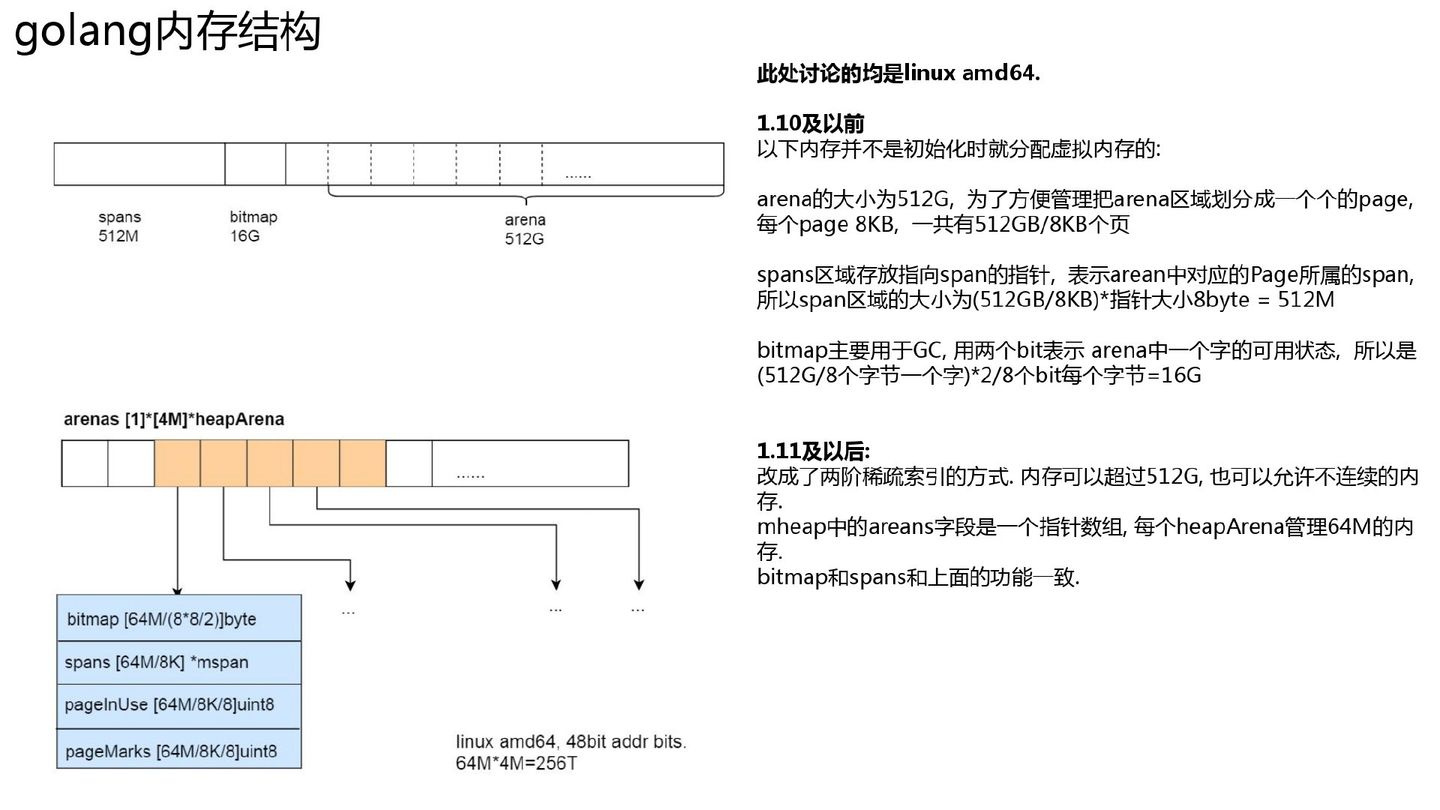

golang内存分配

作者:钱文 Go 的分配采用了类似 tcmalloc 的结构.特点: 使用一小块一小块的连续内存页, 进行分配某个范围大小的内存需求. 比如某个连续 8KB 专门用于分配 17-24 字节,以此减少

DeepSeek推动AI算力需求:800G光模块的关键作用

随着人工智能技术的飞速发展,AI算力需求正以前所未有的速度增长。DeepSeek等大模型的训练与推理任务对算力的需求持续攀升,直接推动了服务器、光通信设备以及数据中心基础设施的

发表于 03-25 12:00

Banana Pi 发布 BPI-AI2N & BPI-AI2N Carrier,助力 AI 计算与嵌入式开发

高效连接

BPI-AI2N 标配 8GB LPDDR4X 内存、32GB eMMC 存储及 64MB QSPI Flash,确保数据存取高效

发表于 03-19 17:54

美光宣布 1γ DRAM 开始出货:引领内存技术突破,满足未来计算需求

β(1-beta)DRAM 节点的领先优势,1γ DRAM 节点的这一新里程碑将推动从云端、工业、消费应用到端侧 AI 设备(如

发表于 02-26 13:58

•477次阅读

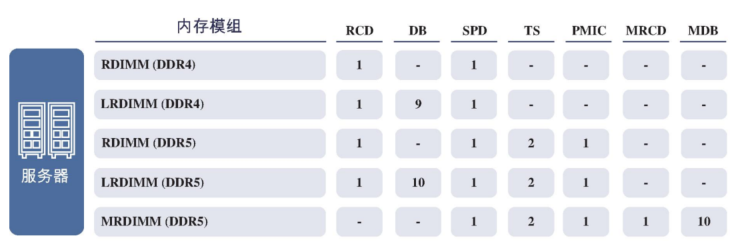

嘉合劲威研发新一代AI专用内存MRDIMM

。 据了解,MRDIMM在内存容量和性能上进行了全面升级。相较于传统内存产品,MRDIMM能够大幅提升AI运算的规模和效能,使得AI算法能够

Omdia预测:今年前三季度PC、服务器、移动DRAM内存价格将下滑15%

%。进入第三季度,价格下滑趋势将进一步加剧,预计再降5%。这意味着,在整个前三季度,PC、服务器及移动DRAM内存价格将累计下滑15%。 值得注意的是,此前价格相对坚挺的服务器级DRAM也将

德明利DDR5内存助力AI PC时代存储性能与市场增长

2024年作为AIPC元年伴随异构算力(CPU+GPU+NPU)需求高涨及新处理器平台推出DDR5内存以高速率、大容量低延迟与高带宽有效满足高性能算力要求加速本地AI大模型运行效率推动

AI PC需求推动内存升级,64GB内存将开始出货

AI PC需求推动内存升级,64GB内存将开始出货

评论