关于 LLaMA 2 的全部资源,如何去测试、训练并部署它。

LLaMA 2 是一个由 Meta 开发的大型语言模型,是 LLaMA 1 的继任者。LLaMA 2 可通过 AWS、Hugging Face 等提供商获取,并免费用于研究和商业用途。LLaMA 2 预训练模型在 2 万亿个标记上进行训练,相比 LLaMA 1 的上下文长度增加了一倍。它的微调模型则在超过 100 万个人工标注数据下完成。

这篇博客包含了所有的相关资源,以帮助您快速入门。包括以下跳转:

LLaMA 2 是什么?

在 LLaMA 游乐场试玩

模型背后的研究工作

模型的性能有多好,基准测试

如何正确地去提示聊天模型

如何使用 PEFT 训练模型

如何部署模型进行推理

和其他资源

来自 Meta 官方的公告可以在这里找到: https://ai.meta.com/llama/

LLaMA 2 是什么?

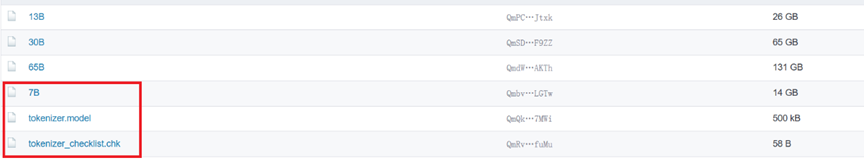

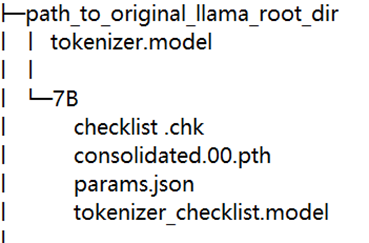

Meta 发布的 LLaMA 2,是新的 sota 开源大型语言模型 (LLM)。LLaMA 2 代表着 LLaMA 的下一代版本,并且具有商业许可证。LLaMA 2 有 3 种不同的大小——7B、13B 和 70B 个可训练参数。与原版 LLaMA 相比,新的改进包括:

在 2 万亿个标记的文本数据上进行训练

允许商业使用

默认使用 4096 个前后文本视野 (可以被扩展)

70B 模型采用了分组查询注意力 (GQA)

可由此获取 Hugging Face Hub

在 LLaMA 游乐场试玩

有几个不同的游乐场供与 LLaMA 2 来测试聊天:

HuggingChat 允许你通过 Hugging Face 的对话界面与 LLaMA 2 70B 模型聊天。这提供了一个简洁的方法来了解聊天机器人的工作原理。

Hugging Face Spaces 有三种大小的 LLaMA 2 模型 7B、13B 和 70B 可供测试。交互式演示可以让您比较不同的大小模型的区别。

Perplexity 他们的对话 AI 演示提供 7B 和 13B 的 LLaMA 2 模型。你可以与模型聊天并且反馈模型响应的不足。

LLaMA 2 背后的研究工作

LLaMA 2 是一个基础大语言模型,它由网络上公开可获取到的数据训练完成。另外 Meta 同时发布了它的 CHAT 版本。CHAT 模型的第一个版本是 SFT (有监督调优) 模型。在这之后,LLaMA-2-chat 逐步地经过人类反馈强化学习 (RLHF) 来进化。RLHF 的过程使用了拒绝采样与近端策略优化 (PPO) 的技术来进一步调优聊天机器人。Meta 目前仅公布了模型最新的 RLHF(v5) 版本。若你对此过程背后的过程感兴趣则请查看:

Llama 2: 开源并已微调的聊天模型

Llama 2: 一个超赞的开源大语言模型

Llama 2: 全面拆解

LLaMA 2 的性能有多好,基准测试?

Meta 声称 “Llama 2 在众多外部基准测试中都优于其他开源的语言模型,包括推理、编程、熟练程度与知识测验” 关于其性能你可以在这里找到更多信息:

Hugging Face 开源大语言模型排行榜

Meta 官方公告

如何提示 LLaMA 2 Chat

LLaMA 2 Chat 是一个开源对话模型。想要与 LLaMA 2 Chat 进行高效地交互则需要你提供合适的提示词、问题来得到合乎逻辑且有帮助的回复。Meta 并没有选择最简单的提示词结构。以下是单轮、多轮对话的提示词模板。这个模板遵循模型的训练过程,在此详细描述 LLaMA 2 论文. 你也可以看一看 LLaMA 2 提示词模板.

单轮对话

[INST]<> {{system_prompt}} < > {{user_message}}[/INST]

多轮对话

[INST]<> {{system_prompt}} < > {{user_msg_1}}[/INST]{{model_answer_1}}[INST]{{user_msg_2}}[/INST]{{model_answer_2}}[INST]{{user_msg_3}}[/INST]

如何训练 LLaMA 2

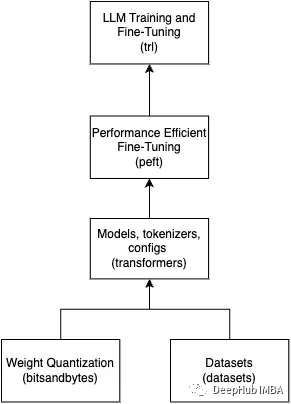

因 LLaMA 2 为开源模型,使得可以轻易的通过微调技术,比如 PEFT,来训练它。这是一些非日适合于训练你自己版本 LLaMA 2 的学习资源:

扩展指引: 指令微调 Llama 2

在 Amazon SageMaker 上微调 LLaMA 2 (7-70B)

使用 PEFT 技术微调

Meta 提供的 Llama 模型示例以及方案

在本地机器上微调 LLAMA-v2 最简单的方法 !

如何部属 LLaMA 2

LLaMA 2 可以在本地环境中部署 (llama.cpp),使用这样已管理好的服务 Hugging Face Inference Endpoints 或通过 AWS, Google Cloud, and Microsoft Azure 这样的服务器平台.

使用文本生成接口与推理终端来部署 LLama 2

使用 Amazon SageMaker 部署 LLaMA 2 70B (即将完成)

在你的 M1/M2 Mac 上通过 GPU 接口来本地部署 Llama-2-13B-chat

原文作者: Philschmid

译者: Xu Haoran

审核编辑:黄飞

-

AI

+关注

关注

87文章

26485浏览量

264116 -

聊天机器人

+关注

关注

0文章

279浏览量

12108

原文标题:LLaMA 2 - 你所需要的一切资源

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

【飞腾派4G版免费试用】仙女姐姐的嵌入式实验室之五~LLaMA.cpp及3B“小模型”OpenBuddy-StableLM-3B

基于LLAMA的魔改部署

LLaMA生态中的各个模型梳理

Llama2的技术细节探讨分析

Llama 2性能如何

Meta推出Llama 2 免费开放商业和研究机构使用

关于Llama 2的一切资源,我们都帮你整理好了

Meta发布一种Code Llama工具 用于生成新代码和调试人工编写工作

Meta推出最强开源模型Llama 3 要挑战GPT

Llama 3 王者归来,Airbox 率先支持部署

LLaMA 2是什么?LLaMA 2背后的研究工作

LLaMA 2是什么?LLaMA 2背后的研究工作

评论