求解大型COMSOL模型需要多少内存?

COMSOL是一种非常强大的跨学科有限元分析软件,可以用于解决各种复杂的问题,包括流体力学、电磁学、热传递、结构力学等。但是,在处理大型模型时,COMSOL需要非常大的内存,否则模拟可能会卡死或者失败。

需要多少内存?

COMSOL模型的内存需求取决于多个因素,如模型的大小、复杂程度、所选择的求解器和网格大小等。一般来说,更大和更复杂的模型需要更多的内存来运行。

对于一个简单的模型,使用典型的求解器和网格,例如2D的电磁场模拟,一般需要1-2GB的内存就可以运行。

但是,当模型变得更加复杂时,例如3D的热传递模拟或者流体力学模拟等,内存需求就会显著地增加,可能需要10GB或以上的内存。实际上,当处理非常大的模型时,内存需求可能会达到数百GB。

如何节省内存?

当处理大型模型时,节省内存非常重要,否则模拟可能无法运行。以下是一些可以帮助您节省内存的技巧:

1. 精简模型:如果可能的话,删除模型中不必要的部分。这将减少求解器需要处理的区域,从而减少内存需求。

2. 优化网格:使用更优化的网格可以减少内存需求。例如,使用较少的单元或较大的网格单元可以显著减少内存需求。

3. 选择合适的求解器:COMSOL提供了多种求解器,每种都有其优缺点。选择最适合您模型的求解器可以显著减少内存需求。

4. 升级硬件:当您需要处理非常大的模型时,可能需要将计算机的内存升级到更大的容量。这将允许COMSOL更好地处理大型模型。

总结

在解决大型模型时,COMSOL需要非常大的内存。内存需求取决于多个因素,包括模型的大小、复杂度、所选择的求解器和网格大小等。为了最大限度地减少内存需求,您可以精简模型、优化网格、选择合适的求解器或升级计算机硬件等。这些技巧将有助于保障模型的有效运行。

-

电磁场

+关注

关注

0文章

802浏览量

49019 -

COMSOL

+关注

关注

35文章

94浏览量

57828

发布评论请先 登录

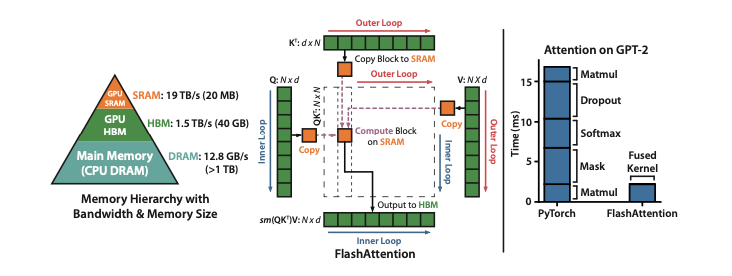

小白学大模型:大模型加速的秘密 FlashAttention 1/2/3

科普:什么AI 内存技术

当仿真计算总是不收敛,你的模型可能需要Abaqus非线性分析

DeepSeek 引领边缘 AI 芯片向更高性能、更低功耗、更强泛化能力的方向演进

KaihongOS操作系统FA模型与Stage模型介绍

COMSOL Multiphysics V4.x操作手册丛书后处理用户指南

无法在OVMS上运行来自Meta的大型语言模型 (LLM),为什么?

从Open Model Zoo下载的FastSeg大型公共预训练模型,无法导入名称是怎么回事?

小白学大模型:训练大语言模型的深度指南

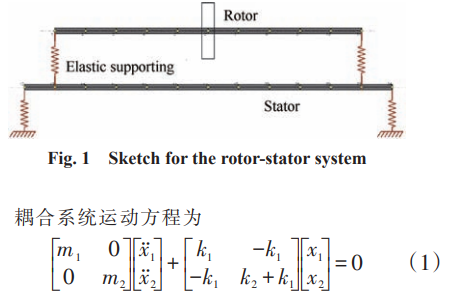

航空发动机整机动力学有限元模型建立方法

大语言模型的解码策略与关键优化总结

求解大型COMSOL模型需要多少内存?

求解大型COMSOL模型需要多少内存?

评论