最近在华尔街举行的 HPC + AI展会上举办了一场小组讨论,汇聚了主要供应商来讨论当前的 GPU Squeeze(短缺)问题。“挤压”是由于生成型人工智能/ LLM的快速持续增长造成的,现在已将 GPU 的需求推向前所未有的水平,并对 GPU 的可用性造成了“挤压”。

下面是主要讨论内容。

GPU到底有多缺货?

根据我们报道的消息,我认为 HPC 用户访问 GPU(购买的或在云中)会遇到一些挑战。我想检查我的假设,并从贵公司的角度询问“GPU 挤压”问题有多大。

Supermicro 的 Thomas Jorgensen 分享了一个有趣的数据点。“我可以告诉你,由于缺乏 H100 GPU,我们有数以万计的系统缺货。但是,我还要说,市场上有很多替代品,例如,我们有一组更新的 CPU,用于 HPC 工作负载,而传统上这些工作负载是由 GPU 提供服务的。”

Thomas 提到了带有 64 GB 嵌入式 HBM2 内存的新型 Intel Max Xeon CPU,极大地增强了一些 HPC 工作负载。他建议,如果无法获得 Nvidia GPU,本地 HPC 是缓解这种情况的方法之一。作为硬件中立的供应商,他还提到英特尔和 AMD 的其他 GPU 都很容易获得。

Thomas还提到了重要的一点,“很多人都说我们依赖CUDA,但如果你要等NVidia GPUS一年,那段时间你可以转换很多代码。因此,市场上其他一些 GPU 绝对有生命力,其中一些可以在很短的等待时间内被黑客攻击。”

他最后还提到了 Nvidia L40 GPU,他认为这是一个很好的替代品,或者至少是你可以购买的东西。此外,Thomas还提到,“所以,我想说,对于我们的本地客户来说,有很多替代方案,客户现在正在探索这一点。我想补充一点,为了取得巨大成功。”

英特尔的 Kiran Agrahara 补充道:“这取决于用例。当您查看短缺时,这取决于您正在研究的用例。” 他继续说道,“还有其他选择,并且大多数学习和推理现在都可以使用 Xeon Gen 4 处理器来完成。” 他提到英特尔有针对不同用例的基准测试。他还指出,每个人都认为每个用例都需要 NVidia GPU。

Kiran 还指出,英特尔拥有 Gaudi 2,它更像是一个推理处理器,而不是学习处理器,并且可以在本地和云端使用。他继续提到 Datacenter GPU Max 系列可以作为 A100 的替代品或替代品。最后,他呼吁大家关注英特尔的 OpenVINO(开放式视觉推理和神经网络优化)——所有英特尔 HPC 和人工智能产品之上的软件层。

Nvidia 全球合作伙伴成功经理Prabhu Ramamoorthy 指出,人们认为 GPU 短缺是最近才发生的,但我们已经看到这种情况好几年了。例如,三年前,GPU 在云端运行进行 NLP(自然语言处理)。许多对冲基金都在运行所有这些工作负载。生成式人工智能就像 NLP 的新的、美丽的、更性感的术语,现在对这些 GPU 的需求要大得多。正如Thomas所指出的,我们希望客户选择正确的用例。他还提醒大家,NVidia 雇佣的软件工程师比硬件工程师更多。作为这些努力的结果,他提到 TensorRT-LLM 等 Nvidia 软件可以优化应用程序并确保更有效地利用 GPU。

Google Cloud HPC 和 AI 基础设施解决方案经理Wyatt Gorman 总结道,他认为长期规划 GPU 需求非常重要。现在,看看替代方案,不要超出你的应用程序太多。考虑一下现在有哪些可能性,并且有一些方法可以优化 GPU 使用,这是很好的替代方案。是很好的选择。

GPU 替代方案

有关短缺的报道可能还会持续 18 个月。是否有其他方法建议 HPC 用户运行应用程序(云、替代硬件、软件优化)?例如,NAMD(一种 HPC 分子动力学代码)将使用 CPU 和 MPI 和/或 GPU 运行。用户会恢复使用 MPI 吗?

Kiran Agrahara 回忆起一个较旧的示例,其中用户需要 20 个 GPU,而要完成相同的工作,他们需要大约 180 个 CPU。但他建议看看过去三年发生了什么变化。他继续说道:“CPU 已经取得了长足的进步。那时我们还没有硬件加速器。如果你看看下一代 Xeon 处理器,我们有一个称为 RMX 的先进矩阵架构。所以今天,CPU 已经取得了长足的进步。你看到的是 128 个核心,然后你就有了 RMX 架构,我可以说它就像是增强版的 AVX512。所以答案是肯定的,你可以用 CPU 来实现这一点。”

Wyatt Gorman 补充说,让人们意识到较小的 GPU 非常重要。现在每个人都在考虑 A100 和 H100。速度较慢的 Nvidia T4、L4 和 L40 GPU 有足够的容量,并且可以在 Google Cloud 上使用,因为目前对它们的需求并不高。如果您对这些 GPU 进行一些调整和优化,您可以看到代码的加速。

HPC 和数据中心融合

通常,HPC 位于其自己的孤岛中,然后您可以在另一个正在开发的孤岛中使用快速增长的 GenAI 和类似的硬件。当人们开始认识到我们可以将这两种资源整合在一起时,您是否认为这可能会使 HPC 受益?您如何看待在数据中心运行的 HPC 应用程序与在具有单独硬件的研发实验室中运行的 HPC 应用程序的融合?

Wyatt Gorman 表示,谷歌在 HPC RFP 中看到了更多人工智能功能。他认为,随着这些问题类型的出现,随着 HPC 和 AI 的融合,我们会看到 AI 技术被引入传统的 HPC 问题解决应用程序中,并且我们将看到越来越多的此类技术以及越来越多的资源。正如我提到的,Slurm 现在支持 Google TPU,现在或将来您不一定需要 Kubernetes 来运行 HPC。你知道,即使它是一种选择,也没有必要。

Supermicro 的 Thomas Jorgensen 提到,英特尔第五代路线图显示,未来的某些 CPU 上将有多达 288 个核心。当然,CPU 平台上也发生了一些事情,这些事情将带来比传统 CPU 平台更高的性能。还有一点是Intel打造的Max GPU是HPC+AI GPU。我们在 Supermicro 所做的第一次测试展示了使用该 GPU 的 HPC 的真实性能。

从硬件的角度来看, Supermicro 试图成为中立者,与 Nvidia、AMD 和 Intel 合作。

Thomas 继续说道:“与英特尔 AMD 平台一样,我们拥有非常高的核心数量 Epyc 处理器,并与 Nvidia 进行了科学实验。在此测试中,我们可以在单个系统中放置十个 GPU。HPC 基准测试以及我们从 HPC 上的一个系统中获得的性能令人震惊。但这是一种前进的方式,至少,我的意思是,它对挤压没有帮助,对吧,因为使用 H100,但那里的一些性能显示出 HPC 工作负载的真正前景。因此,我对硬件和我们看到的一些优化非常充满希望,这些优化可以从现有硬件中发挥更多作用。”

此外,一些用户可能会发现传统 HPC 和 GenAI 之间的界限有点模糊。对快速 GPU 的需求表明这两种类型的应用程序都在进行大量的数字运算,但传统的 HPC 蒙特卡罗风险分析是否类似于经过训练进行风险分析的 GenAI?换句话说,您如何看待GenAI和HPC?它们属于同一大类还是代表两个不同的市场?它们相辅相成吗?

NVidia 的 Prabhu Ramamoorthy 立即提到,他看到这种融合现在正在发生,他们看到客户在致力于最终用例时混合使用 HPC 和 AI 解决方案。

Google Cloud 的 Wyatt Gorman 回答说,他看到人们将机器学习技术引入不同级别的 HPC 流程中。因此,请将其视为 HPC 中的一个子集、一个域。他认为,它可能会分拆出来,变得更加孤立,就像大数据从 HPC 中分离出来一样。但就目前而言,他认为情况正在趋同。

编辑:黄飞

-

处理器

+关注

关注

68文章

20148浏览量

247126 -

嵌入式

+关注

关注

5186文章

20146浏览量

328807 -

NVIDIA

+关注

关注

14文章

5496浏览量

109090 -

gpu

+关注

关注

28文章

5099浏览量

134456 -

HPC

+关注

关注

0文章

342浏览量

24825

原文标题:GPU到底有多缺货?有替代者吗?

文章出处:【微信号:TenOne_TSMC,微信公众号:芯片半导体】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

MD6639高速DAC芯片替代TI、ADI

MPN12AD160-MQ:替代ADI/TI/TOREX电源芯片

如何看懂GPU架构?一分钟带你了解GPU参数指标

LWH12060YAH国产电源模块完美替代TI PTH12060YAH方案

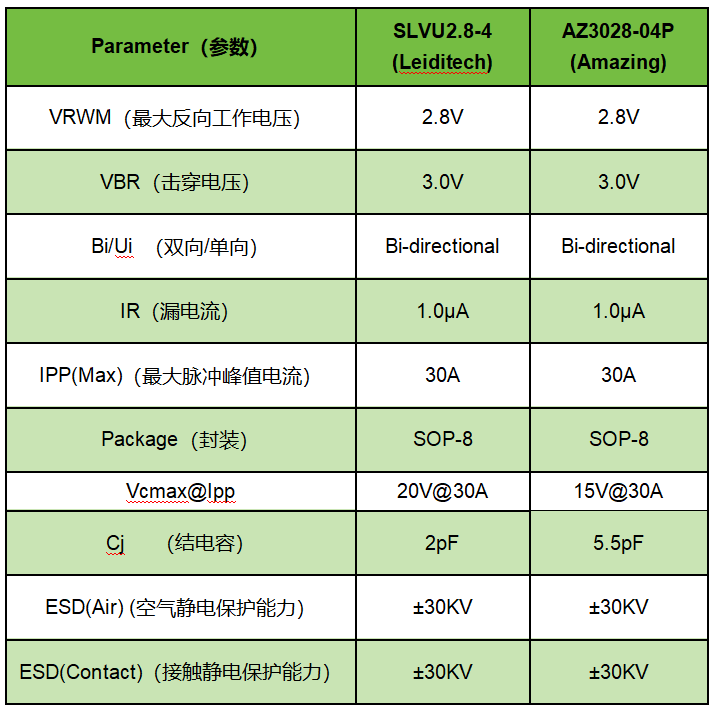

雷卯SLVU2.8-4替代AZ3028-04P实现国产化

GPU是否有替代方案?

GPU是否有替代方案?

评论