自ChatGPT发布以来,生成式AI在全球引起了新的浪潮,它影响着各行各业,为世界带来智能化的发展。然而,类ChatGPT的大语言模型极度依赖算力巨大的服务器,导致目前大部分应用只能通过集中调用API的方式来应用,很难本地化部署。

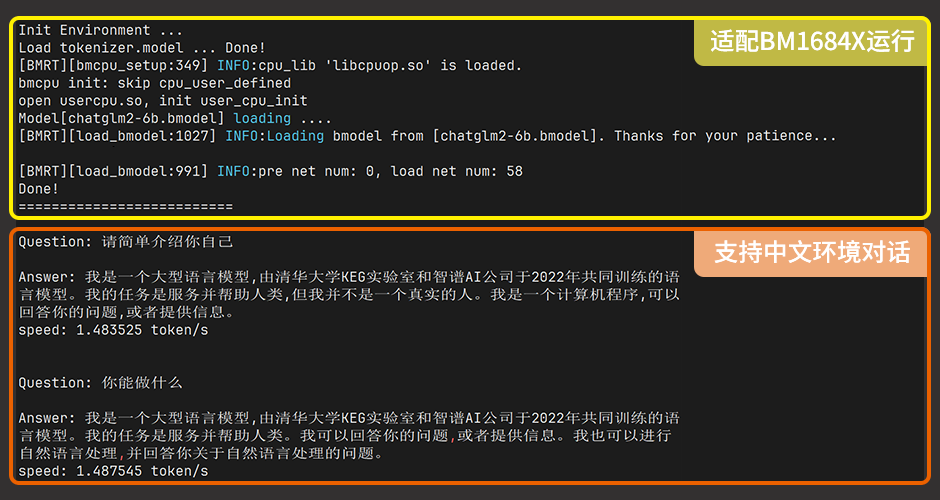

随着大模型适用领域的扩展,大模型登陆边缘设备的需求凸显,越来越多的行业需要把大语言模型应用在专业的领域上。在这个背景下,Firefly推出了基于BM1684X平台的大语言模型本地部署的方案,让边缘设备可配置上一颗真正的“智慧”大脑,应用于各行各业。

本地化的ChatGLM-6B大语言模型

(1)具有 62 亿参数

采用了由清华大学的ChatGLM-6B大语言模型,基于 General Language Model (GLM) 架构,具有 62 亿参数, 使用了和 ChatGPT 相似的先进技术,以达到优质的效果。

(2)优化中文对话

支持中英双语的对话语言模型,并且针对中文问答和对话进行了优化,其开源的训练数据量达到1万亿字符的模型。

AI边缘计算主机EC-A1684XJD4

ChatGLM-6B可部署在Firefly旗下产品AI嵌入式主机EC-A1684XJD4中,主机配置了16GB大内存,适用于部分大模型的量化部署,可运行Ubuntu20.04操作系统,并集成最新的SOPHONSDK 3.0.0,可充分发挥BM1684X集成TPU的AI加速能力。

-

AI

+关注

关注

89文章

38085浏览量

296319 -

人工智能

+关注

关注

1813文章

49734浏览量

261395 -

语言模型

+关注

关注

0文章

570浏览量

11251 -

ChatGPT

+关注

关注

30文章

1596浏览量

10065

发布评论请先 登录

发布元服务配置本地化基础信息(应用名称、图标)

Qwen3-VL 4B/8B全面适配,BM1684X成边缘最佳部署平台!

AI+能源数字化破局者故事5:斯伦贝谢 x IBM 咨询之 “全球化经营与本地化适配”

施耐德电气与奇安信共建技术本地化创新中心

本地化ChatGPT?Firefly推出基于BM1684X的大语言模型本地部署方案

本地化ChatGPT?Firefly推出基于BM1684X的大语言模型本地部署方案

评论