导语:大模型在手机端的落地,不仅仅是AI进入人类生活的开始,也是行业发生颠覆,新老巨头进行更替的时刻。

将大模型变小,再塞进手机,会给人们的生活带来怎样的影响?

最近,荣耀成为了国内率先的破局者。

7月12日,荣耀了发布一款“革命性”的大模型手机Magic V2。成为全球首个实现大模型与手机系统融合的厂商。

在荣耀的宣传中,更加个性化、更注重隐私,并且具备多模态功能的大模型,将会给用户带来全新的体验。

实际上,不只是荣耀,身为手机芯片龙头企业的高通,也在近期发布了自身的大模型。

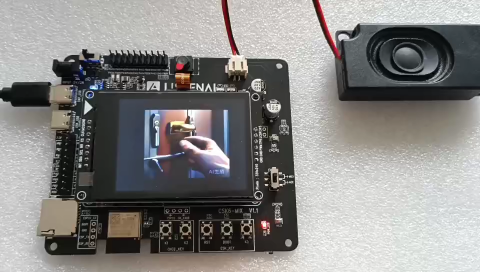

在7月初召开的上海WAIC上,人们看到搭载高通第二代骁龙8芯片的安卓手机直接运行参数规模超过10亿的Stable Diffusion,且只需要15秒左右就可以出图。

更重要的是,这样的运行,是完全本地化的,只依赖手机本身的算力。

从GPT-3.5到GPT-4.0,曾经需要高昂算力,或者只能跑在云端的AI大模型,也开始在智能终端设备中落地。

不过,在兴奋之余,冷静的人总不免会问:我真的需要一个在部署在手机大模型么?还是说这只是手机厂商为挽救疲软的市场而制造的噱头?

打破APP的壁垒

在人们讨论“大模型手机”之前,一个不可忽略的事实是:当今的各类大模型AI,如chatGPT、新必应等,实际上早已推出了各自的手机版APP。

通过这一个个APP,在手机上运行大模型,早已不是什么难事,且与本地部署的方式相比,这些调用云端算力的APP,并不会对手机配置造成额外负担。

那既然如此,那人们为什么还要费尽心机地开发一个专用的“手机版”大模型呢?

对于这个问题,谷歌之前的做法似乎给出了一个可能的答案。

今年5月,在ChatGPT 3.5发布半年后,Google终于公布了全新一代大语言模型PaLM2,用以对抗ChatGPT。作为一种差异化竞争,PaLM2可以被部署在智能手机上。

当时,PaLM2包含四个大模型,按照参数规模从大到小,分别命名为:独角兽(Unicorn)、野牛(Bison)、水獭(Otter)和壁虎(Gecko)。

只有参数最小的“壁虎”可以在手机上运行,Google称,它的运行速度足够快,不联网也能正常工作。

但问题是:人们为什么要以牺牲参数、性能为代价,在手机上使用这样一个“缩水版”的小模型呢?

一个最重要的原因是:与那些以APP形态出现在手机上的大模型相比,一个融入手机系统中的大模型,可以打破各应用之间的壁垒,让其他App也自带大模型特性。

例如,融入手机中壁虎(Gecko),可以通过Gmail,实现自动写邮件的功能。

用户只需在Gmail的“Help me write”(帮我写)中输入需求,它就会结合此前邮件中的信息,写出完整的邮件。

通过这样与手机系统深入融合的大模型,人们不仅可以实现AI对各类APP的赋能,甚至还能将大模型作为通用接口,像“胶水”一样,将各类APP的能力实现组合,实现更多具有想象力的扩展。

例如,倘若人们在一个陌生的地点出行,想寻找某个罕见、偏僻,在地图上并不显眼的位置,这时,手机上的大模型,就可以调用语音+识图+导航的多模态功能,十分接地气地告诉你:“在前面的兰州拉面往左拐,看到城市便捷酒店后再右拐300米”,而不是简单地说出“直行”、“右拐”等机械的回答。

然而,要实现这样的组合,一个难以绕开的问题,就是算力。

同样的,开始在手机上部署大模型的高通,也意识到了这个问题。在高通日前发布的《混合AI是AI的未来》技术白皮书中,首次提出了混合AI架构的概念。

而这一概念,简而言之,就是让AI能够在云端和终端侧进行分布式处理,并根据不同的模型和需求灵活分配负载。

改造现实的肢体

也许有人认为,与在手机上部署大模型的做法相比,在云端进行计算的方法,才是既省力又划算的。

然而,实际上随着日活用户数量及其使用频率的增长,云端推理的成本会显著增加,而这样的高成本,也会让生成式AI的规模化扩展陷入瓶颈。

毕竟,单个AI超算的服务器带宽,以及消耗的电力,终归是有上限的,而用户的增长却并没有一个固定的上限。

这就是为什么混合AI架构,即在云端和终端侧进行分布式处理的AI,会成为AI的未来趋势,因为它能够利用终端侧的计算能力,降低云端推理的依赖和成本。

而在混合A架构的基础上,高通还提到,为实现生成式AI的规模化扩展,AI处理的重心正在向边缘转移。

也就是说,将来会有越来越多的AI数据,会在手机、摄像头、传感器等终端侧进行处理。

那这对大模型的发展来说意味着什么?

截至目前为止,大部分大模型所能处理的任务,仍旧停留在文字生成、绘制图片、编写代码这些工作上。

这样的任务,本质上都是属于出不了办公室的“案头工作”。

而AI如果要真正地走进社会,为更多的行业、群体带来改变,而不仅仅是一个存在于网页中的“秘书”,那它就必须具有改造现实世界的“肢体”。

而这样的“肢体”,正是一个个嵌入各个行业的边缘端设备。

举例来说,在医疗领域,AI可以通过智能摄像头,评估帕金森患者的状态;

在工业行业,边缘化的AI可以提高生产过程的智能化和自动化,高效地完成零部件瑕疵检测等任务。

在农业领域,边缘化的AI可以通过智能传感器或无人机,实现对农作物的精准种植和管理,如实现农业病虫害识别、农作物品质评估等任务。

所有这一切,都是仅存在于网页中的大模型所无法完成的。

也正因如此,大模型“边缘化”所带来的显著后果,就是AI横向应用范围的极大扩展。

如何让GPT助力农业,已经成为人们思考的方向之一

而随着边缘化的到来,联邦计算等与之匹配的模型训练方式,也将打破原本数据中心化的格局。

因为到了那时,数据并不总是在某一个云端服务器完成计算,而是由多个参与方在本地训练机器学习模型,之后再将模型参数或梯度上传到中心服务器进行聚合。

但诡异的是,依据科技行业发展的逻辑,这样一种去中心化的、可以实现跨行业或跨领域数据共享的技术,非但不会弱化原有的垄断行为,甚至还会进一步将其强化。

新巨头的崛起

在前网络时代,人们认为个人网站可以消解大传统媒体的信息垄断,但后来互联网霸主的规模,早已传统媒体的市值的天花板。

如果将这些科技巨头的市值,换算成国家的GDP,那么在2022年,微软的市值就超过了五常之一的俄罗斯(1.7万亿),全球能与之匹敌的经济体屈指可数。

究其原因,是因为任何“技术平权”的进行,在让科技变得更加低廉化、平民化的同时,都会反向地催生出一批技术壁垒更高,集中性更强的超级巨头。

因为正是有了这些“高壁垒”的技术进行支撑,巨头们的规模扩张才成为可能。

例如Meta正是通过一系列数据、算法的优势,才能对众多用户投其所好,并构筑了Facebook和Twitter等庞大的社交帝国。

而英伟达也正是通过自身核心的GPU技术,和壁垒颇高的CUDA生态,才让今天的大模型得以完成海量的计算,才得以让AI成为人人触手可及的技术。

而同样的,当混合计算的AI,通过云端与终端侧相结合的方式,降低了大模型的推理的成本后,其造成的“技术平权”,至少会造就两个方向上的巨头。

其一,就是边缘化芯片的提供者。

因为芯片层的AI运算处理能力,是AI落地终端的必要条件。

虽然在边缘化时代,AI的算力场景是多样化的,例如工业、医疗、娱乐等,但其中最重要的“七寸”,仍然是在用户量最多的手机端。

谁若是能围绕手机端的大模型,形成一套从设计、生产、到软件生态一体化的完整体系,谁就将成为新一代的巨头。

在这方面,身为行业龙头的高通,早已开始了提前布局。

目前,搭载骁龙平台的已发布XR终端已经超过65款,其中Meta、PICO等头部厂商的旗舰产品均采用的是高通芯片。

第二个方向的巨头,就是能为行业提供全套解决方案的玩家。

毕竟AI在终端侧的落地,需要的不仅是硬件,还有软件端的优化。

在同样的硬件基础上,谁的AI引擎能比其他竞品具有更高的效能,能更快地完成计算,谁就将在软件栈方面更具优势。

而要想实现这点,就必须在大模型的量化、压缩、条件计算、神经网络架构搜索和编译方面进行突破,在不牺牲太多精度的前提下对AI模型进行缩减。

因此,谁能在大模型的压缩、小型化技术上取得突破,谁就能率先构建起自身基于终端的软件生态。

综上所述,大模型在手机端的落地,不仅仅是AI真正具备“肢体”,进入人类生活的开始,也是行业发生颠覆,新老巨头进行更替的时刻。

在这样的时代,变革的风暴远比我们想象的要猛烈。

审核编辑:刘清

-

传感器

+关注

关注

2526文章

48110浏览量

740145 -

手机芯片

+关注

关注

9文章

349浏览量

48077 -

机器学习

+关注

关注

66文章

8126浏览量

130571 -

AI芯片

+关注

关注

17文章

1656浏览量

34393 -

ChatGPT

+关注

关注

27文章

1409浏览量

4762 -

AI大模型

+关注

关注

0文章

197浏览量

92

原文标题:AI大模型会如何颠覆手机?

文章出处:【微信号:alpworks,微信公众号:阿尔法工场研究院】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

开发者手机 AI - 目标识别 demo

防止AI大模型被黑客病毒入侵控制(原创)聆思大模型AI开发套件评测4

使用cube-AI分析模型时报错的原因有哪些?

是德科技如何赋能医疗AI大模型应用呢?

AI大模型接入手机,行业迎来新一轮竞赛

AI大模型会颠覆手机吗?AI大模型会如何颠覆手机?

AI大模型会颠覆手机吗?AI大模型会如何颠覆手机?

评论