今年3月末,我们在arXiv网站发布了大语言模型综述文章《A Survey of Large Language Models》的第一个版本V1,该综述文章系统性地梳理了大语言模型的研究进展与核心技术,讨论了大量的相关工作。自大语言模型综述的预印本上线以来,受到了广泛关注,收到了不少读者的宝贵意见。

在发布V1版本后的3个月时间内,为了提升该综述的质量,我们在持续更新相关的内容,连续进行了多版的内容修订(版本号目前迭代到V11),论文篇幅从V1版本的51页、416篇参考文献扩增到了V11版本的85页、610篇参考文献。V11版本是我们自五月中下旬开始策划进行大修的版本,详细更新日志请见文章结尾,已于6月末再次发布于arXiv网站。相较于V1版本,V11版本的大语言模型综述有以下新亮点:

在发布V1版本后的3个月时间内,为了提升该综述的质量,我们在持续更新相关的内容,连续进行了多版的内容修订(版本号目前迭代到V11),论文篇幅从V1版本的51页、416篇参考文献扩增到了V11版本的85页、610篇参考文献。V11版本是我们自五月中下旬开始策划进行大修的版本,详细更新日志请见文章结尾,已于6月末再次发布于arXiv网站。相较于V1版本,V11版本的大语言模型综述有以下新亮点:- 新增了对LLaMA模型及其衍生模型组成的LLaMA家族介绍;

- 新增了具体实验分析,包括指令微调数据集组合方式实验以及部分模型综合能力评测;

- 新增了大语言模型提示设计提示指南以及相关实验,总结了提示设计的原则、经验;

- 新增了参数高效适配和空间高效适配章节,总结了大语言模型相关的轻量化技术;

- 增加了对于规划(planning)的相关工作介绍;

- 增补了许多脉络梳理内容,以及大量最新工作介绍;

- 论文链接:https://arxiv.org/abs/2303.18223

- GitHub项目链接:https://github.com/RUCAIBox/LLMSurvey

- 中文翻译版本链接:https://github.com/RUCAIBox/LLMSurvey/blob/main/assets/LLM_Survey__Chinese_V1.pdf

1. 引言

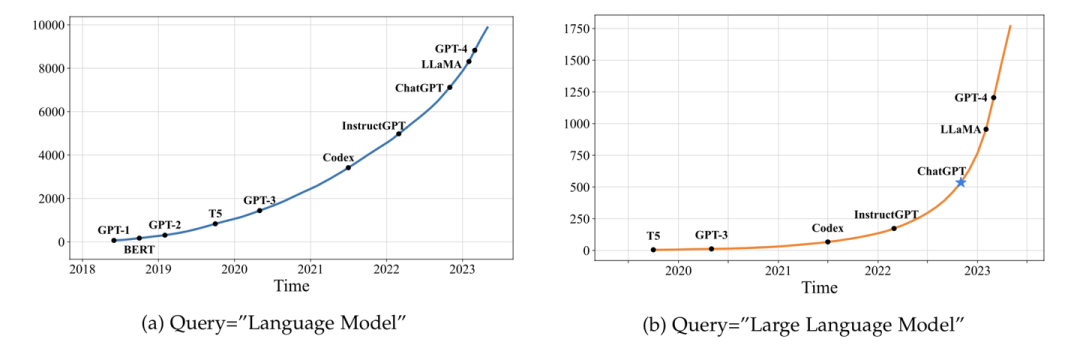

大语言模型目前已经成为学界研究的热点。我们统计了arXiv论文库中自2018年6月以来包含关键词"语言模型"以及自2019年10月以来包含关键词"大语言模型"的论文数量趋势图。结果表明,在ChatGPT发布之后,相关论文的数量呈现出爆发式增长,这充分证明大语言模型在学术界的影响力日益凸显,吸引了越来越多的研究者投入到这一领域。

2. 总览

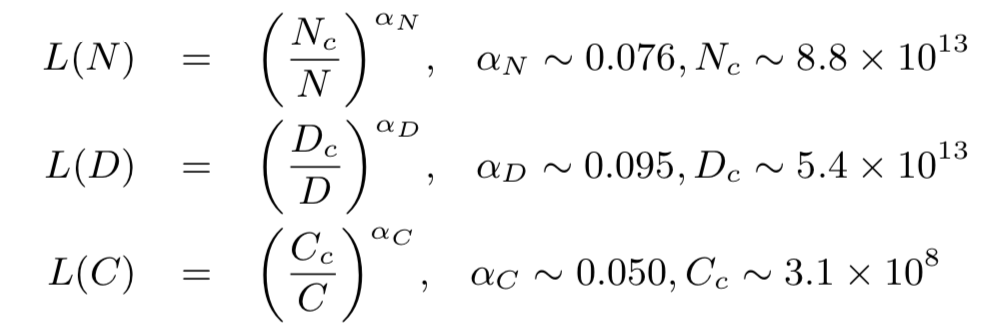

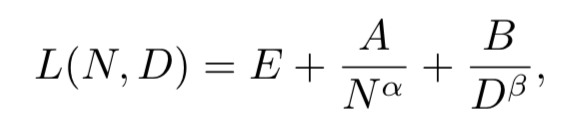

相较于小模型,大模型扩展了模型大小、训练数据大小和总计算量,显著提升了语言模型的能力。在总览章节中,我们新增了扩展法则(scaling law)的讨论,其中重点介绍了KM扩展法则和Chinchilla扩展法则,这两个法则对于理解大语言模型的性能提升提供了重要参考。- KM 扩展法则

-

Chinchilla扩展法则

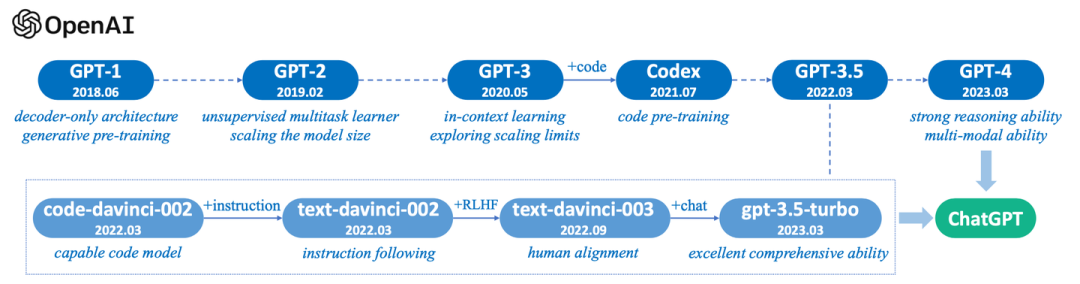

此外,我们新增了一部分关于OpenAI GPT系列语言模型的技术演进阶段的介绍(并附图)。这一部分将帮助读者了解GPT系列模型如何从最初的GPT开始,逐步演变成例如ChatGPT和GPT-4等更先进的大语言模型。

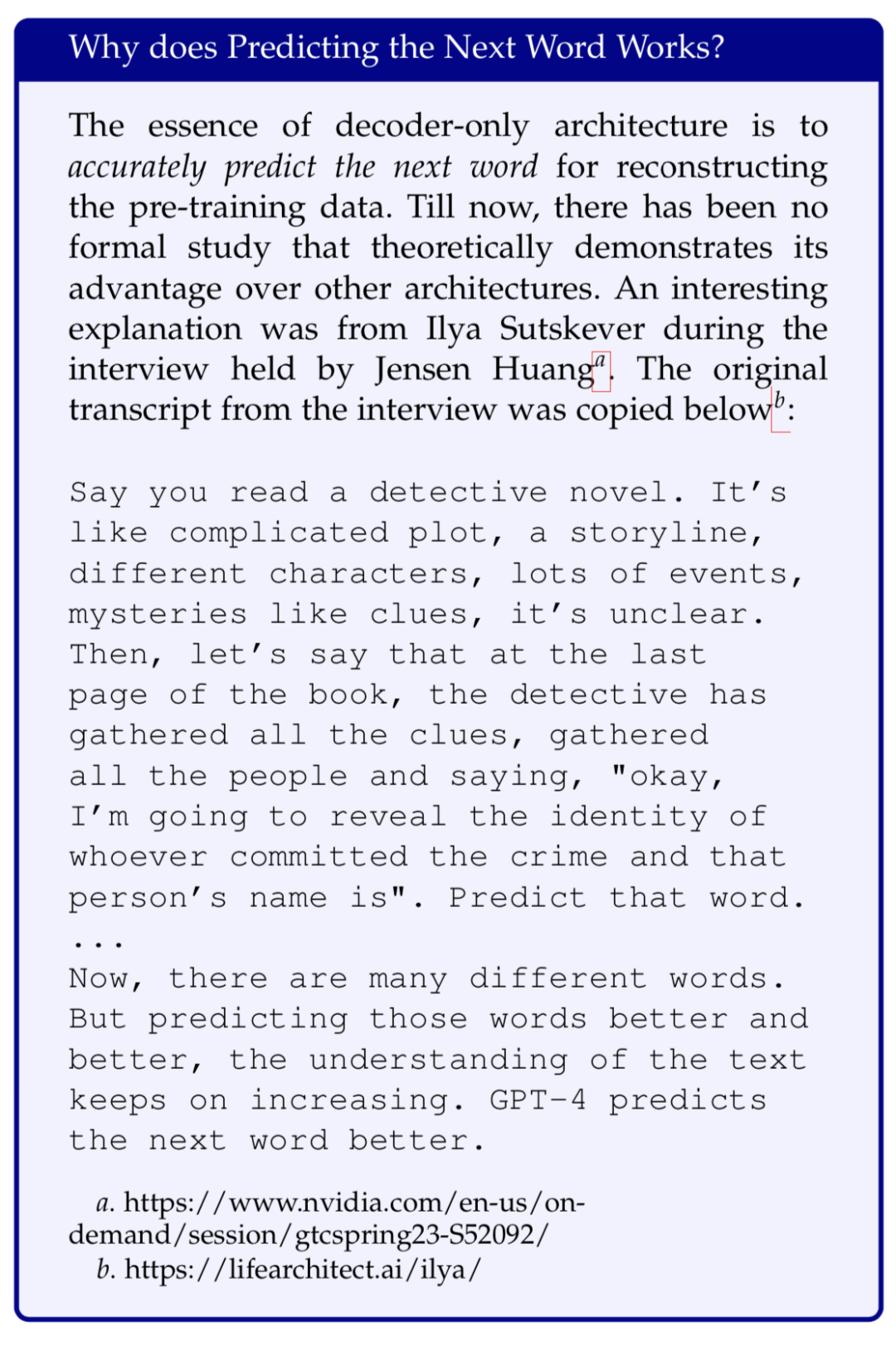

此外,我们新增了一部分关于OpenAI GPT系列语言模型的技术演进阶段的介绍(并附图)。这一部分将帮助读者了解GPT系列模型如何从最初的GPT开始,逐步演变成例如ChatGPT和GPT-4等更先进的大语言模型。 针对GPT系列的核心“预测下一个词”,还进一步加入了一些Ilya Sutskever的采访记录:

针对GPT系列的核心“预测下一个词”,还进一步加入了一些Ilya Sutskever的采访记录:

3. 大语言模型相关资源

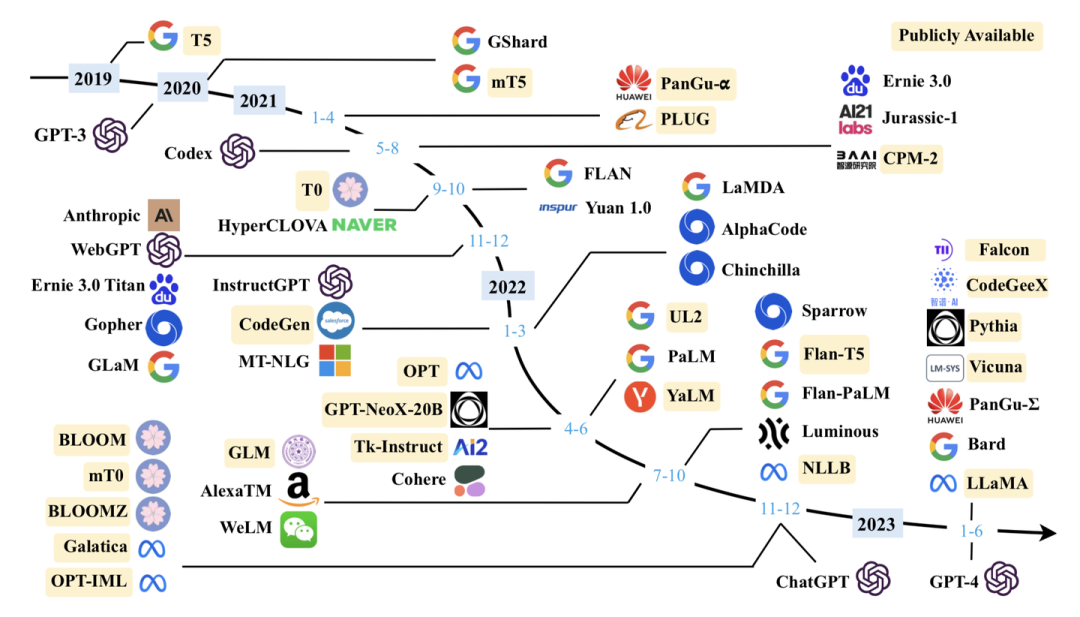

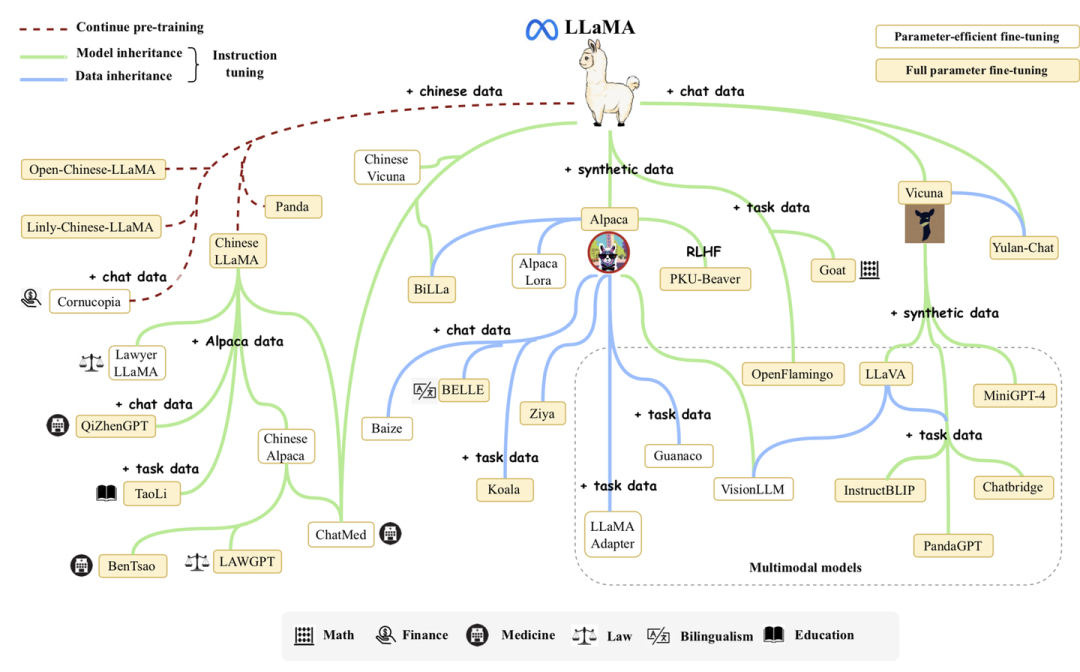

我们对于最新符合条件的模型进行了补充,持续更新了现有的10B+的模型图: 2023年2月,Meta发布了LLaMA大语言模型。受益于其强大的基座能力,LLaMA的发布引起了开源社区的对其进行扩展的热潮,大量的研究人员基于LLaMA进行指令微调或者继续预训练,从而催生了大量高质量的开源大语言模型。为了帮助读者了解LLaMA家族模型的发展脉络,我们增加了LLaMA家族模型的发展介绍,并绘制了一个简要的LLaMA家族演化图来展示LLaMA家族模型的发展历程,以及各个衍生模型之间的关联。

2023年2月,Meta发布了LLaMA大语言模型。受益于其强大的基座能力,LLaMA的发布引起了开源社区的对其进行扩展的热潮,大量的研究人员基于LLaMA进行指令微调或者继续预训练,从而催生了大量高质量的开源大语言模型。为了帮助读者了解LLaMA家族模型的发展脉络,我们增加了LLaMA家族模型的发展介绍,并绘制了一个简要的LLaMA家族演化图来展示LLaMA家族模型的发展历程,以及各个衍生模型之间的关联。

4. 大语言模型预训练技术

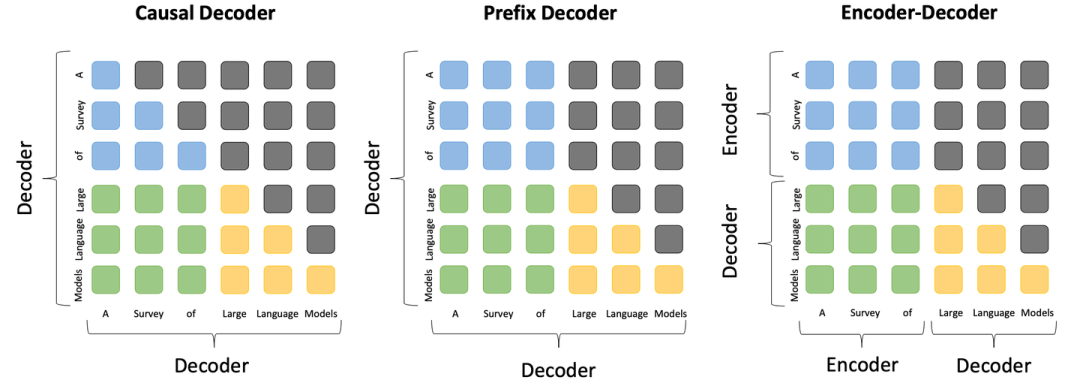

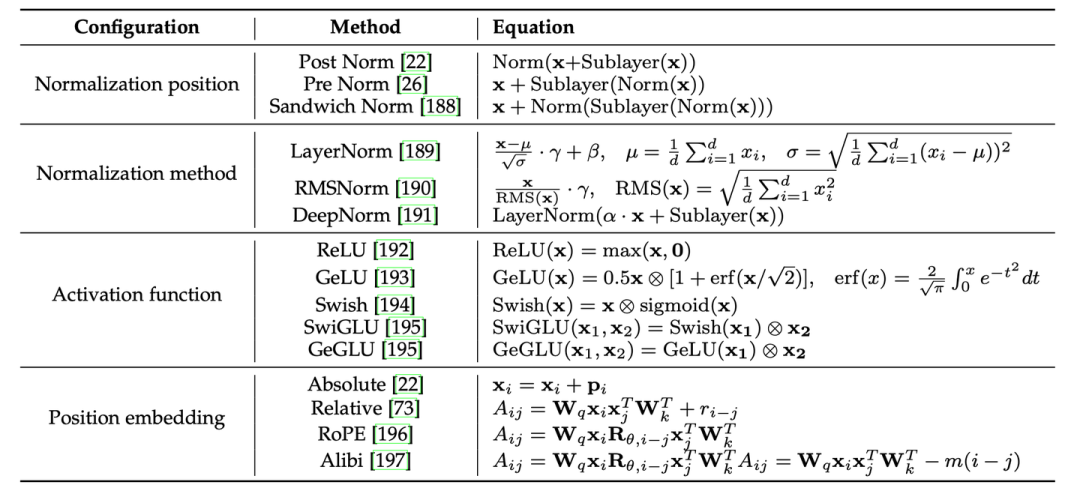

在预训练技术章节,我们大幅补充了大模型预训练各方面的技术细节。在模型架构部分,我们补充了三种主流模型架构的对比图,包括因果编码器、前缀解码器和编码器-解码器架构,从而直观的展示这三种架构的差异和联系。 此外,我们详细补充了模型架构的各组件细节,包括分词、归一化方法、归一化位置、位置编码、注意力与偏置等等,并提供了Transformer架构多种配置的详细公式表。在最后的讨论章节,我们针对研究者广泛关注的长文本编码与生成挑战进行了讨论。

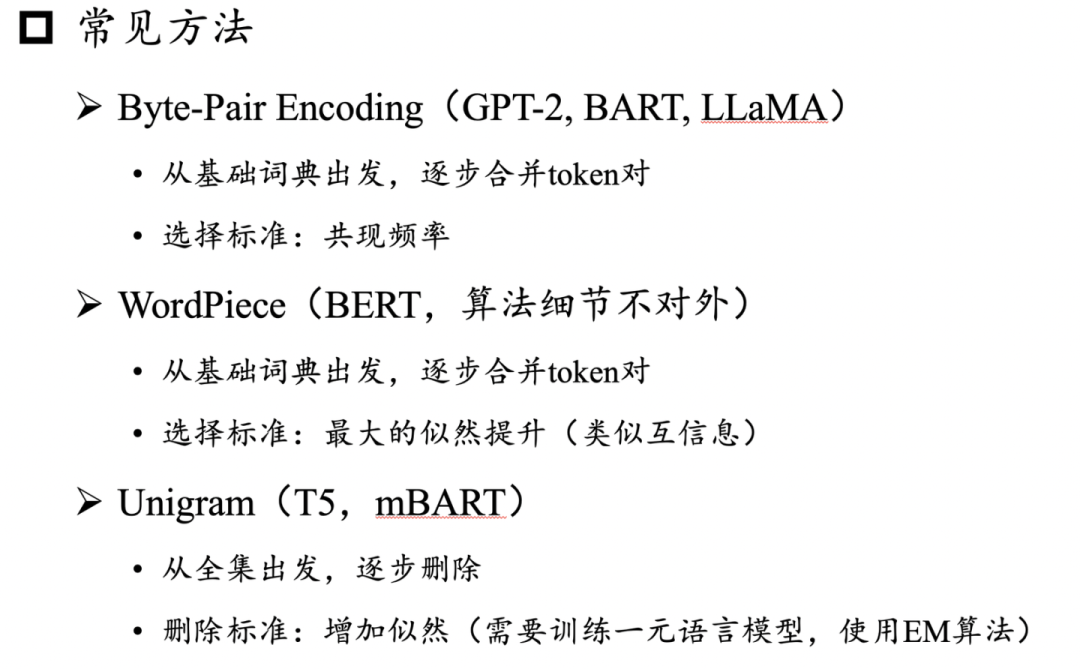

此外,我们详细补充了模型架构的各组件细节,包括分词、归一化方法、归一化位置、位置编码、注意力与偏置等等,并提供了Transformer架构多种配置的详细公式表。在最后的讨论章节,我们针对研究者广泛关注的长文本编码与生成挑战进行了讨论。 针对预训练数据的词元化问题(tokenization),我们补充介绍了BPE、WordPiece和Unigram三种常用算法:

针对预训练数据的词元化问题(tokenization),我们补充介绍了BPE、WordPiece和Unigram三种常用算法:

5. 大语言模型适配技术

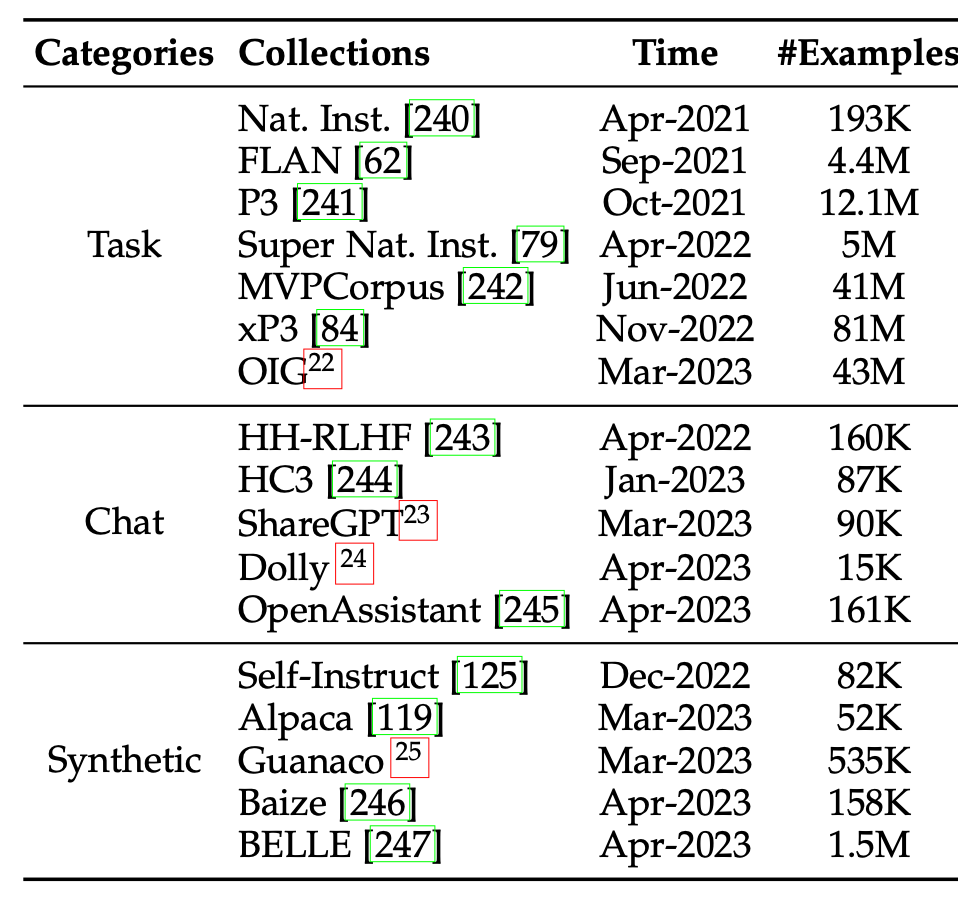

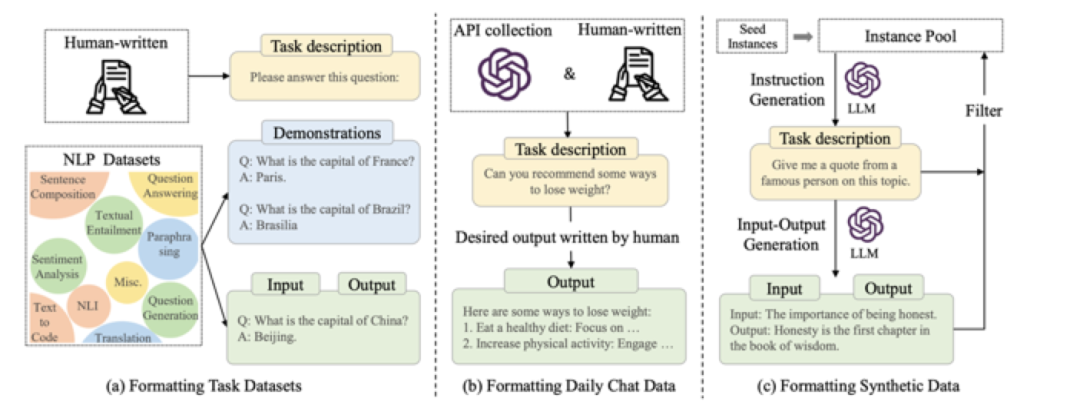

在适配技术章节,我们扩充了指令微调的技术细节,包括指令收集方法、指令微调的作用、指令微调的结果和对应分析。首先,我们按照任务指令、聊天指令、合成指令三类分别介绍了指令数据的收集方法,并收集了的指令集合。

并且更新了指令集合的创建方式示意图:

其次,为了探究不同指令数据对模型性能的影响,我们给出了不同数据混合策略下指令微调模型的实验结果供读者参考。为了让读者更好地上手指令微调,还给出了指令微调大模型的资源参考表,并给出了指令微调的实用建议。

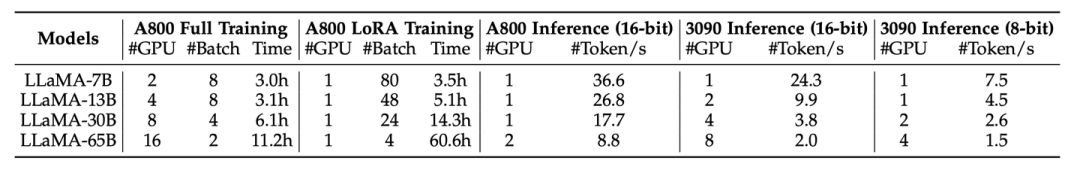

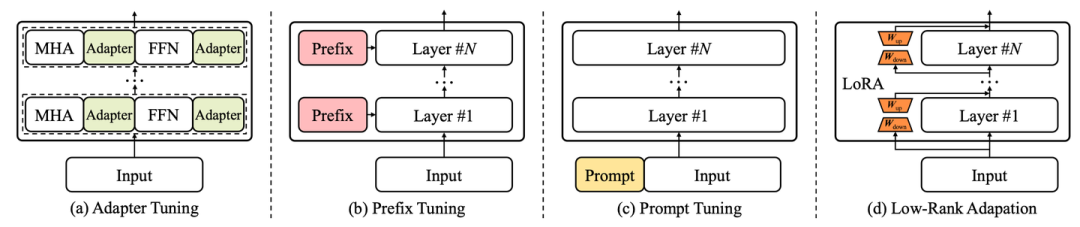

其次,为了探究不同指令数据对模型性能的影响,我们给出了不同数据混合策略下指令微调模型的实验结果供读者参考。为了让读者更好地上手指令微调,还给出了指令微调大模型的资源参考表,并给出了指令微调的实用建议。 随着大语言模型的关注度日渐上升,如何更轻量地微调和使用大语言模型也成为了业界关注的热点,为此,我们新增参数高效适配章节和空间高效适配章节。在参数高效适配章节,我们介绍了常见的参数高效适配技术,包括Adapter Tuning、Prefix Tuning、Prompt Tuning、LoRA等等,并列举了近期结合这些技术在大模型上的具体实践。

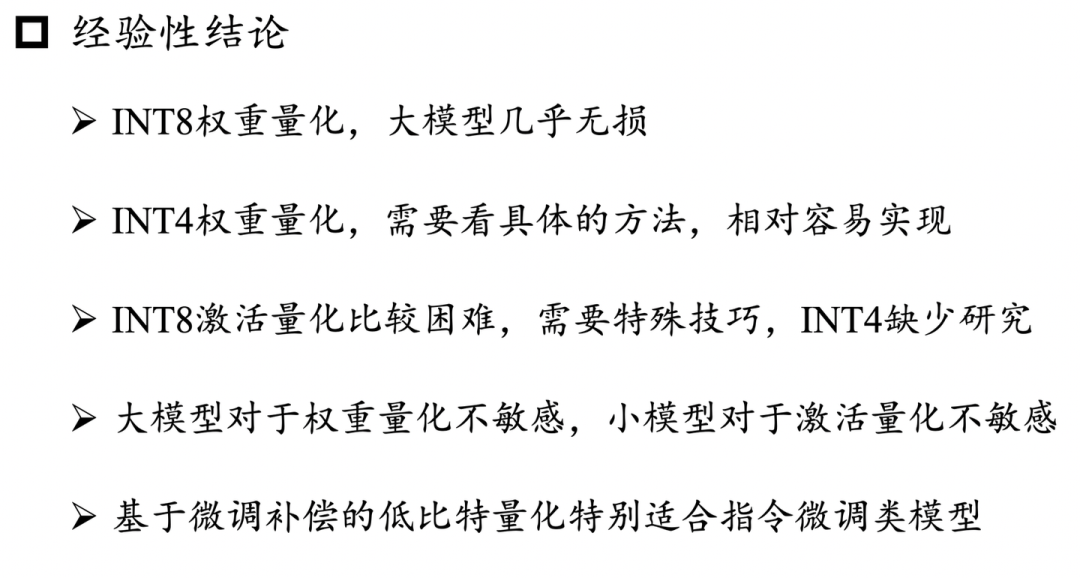

随着大语言模型的关注度日渐上升,如何更轻量地微调和使用大语言模型也成为了业界关注的热点,为此,我们新增参数高效适配章节和空间高效适配章节。在参数高效适配章节,我们介绍了常见的参数高效适配技术,包括Adapter Tuning、Prefix Tuning、Prompt Tuning、LoRA等等,并列举了近期结合这些技术在大模型上的具体实践。 同时由于大语言模型参数量巨大,在推理时需要占用大量的内存(显存),导致它们在实际应用中部署成本较高。为此,我们介绍了空间高效适配技术,讨论了如何通过模型压缩方法(模型量化)来减少大语言模型的内存占用,从而使其可以在资源有限的情况下使用。下面总结了我们讨论的一些核心结论:

同时由于大语言模型参数量巨大,在推理时需要占用大量的内存(显存),导致它们在实际应用中部署成本较高。为此,我们介绍了空间高效适配技术,讨论了如何通过模型压缩方法(模型量化)来减少大语言模型的内存占用,从而使其可以在资源有限的情况下使用。下面总结了我们讨论的一些核心结论:

6. 大语言模型使用技术

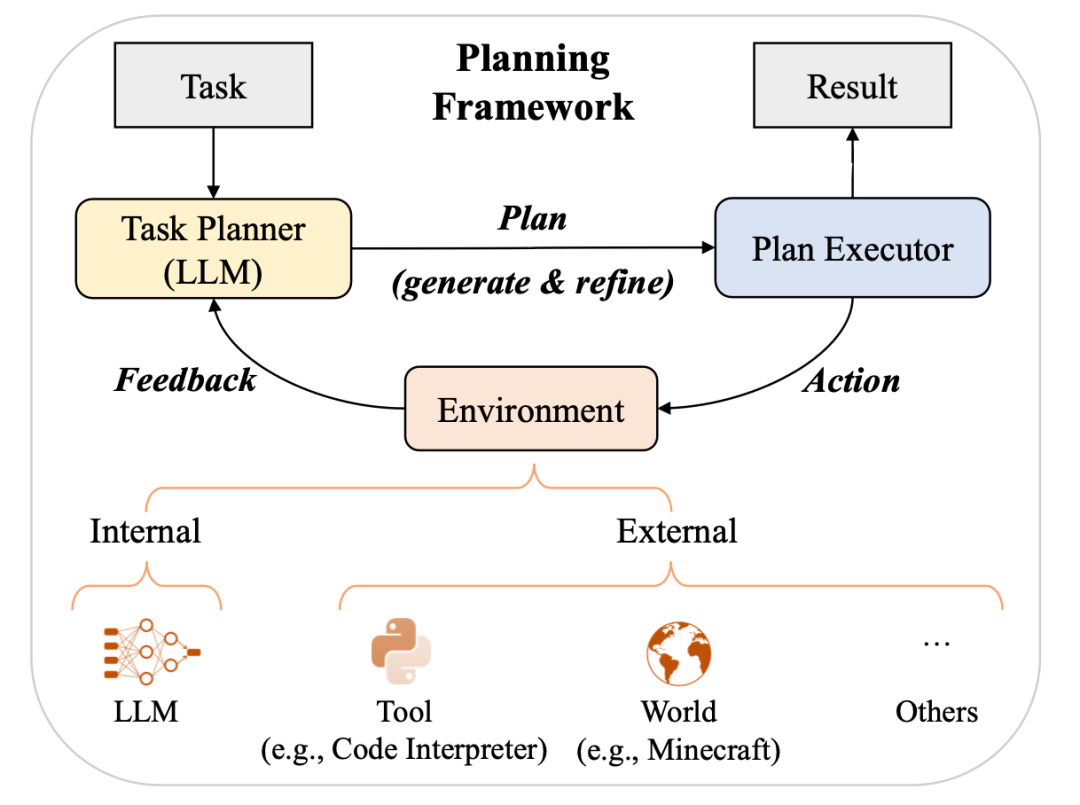

我们将大语言模型在推理阶段如何执行上下文学习的机制分析划分为两类,即任务识别和任务学习。在任务识别部分,介绍了大语言模型如何从示例中识别任务并使用预训练阶段习得的知识加以解决;在任务学习部分,介绍了大语言模型如何从示例中学习解决新任务。除了上下文学习和思维链提示,我们还介绍了另一类使用大语言模型的重要范式,即基于提示对复杂任务进行规划。根据相关工作,我们总结出了基于规划的提示的总体框架。这类范式通常包含三个组件:任务规划者、规划执行者和环境。随后,我们从规划生成,反馈获取和规划完善三个方面介绍了这一范式的基本做法。

7. 大语言模型能力评估

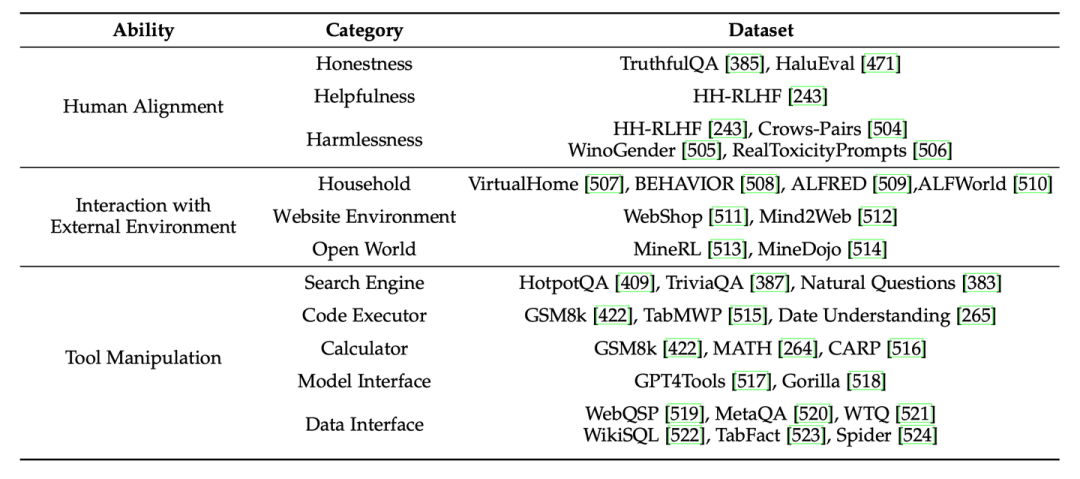

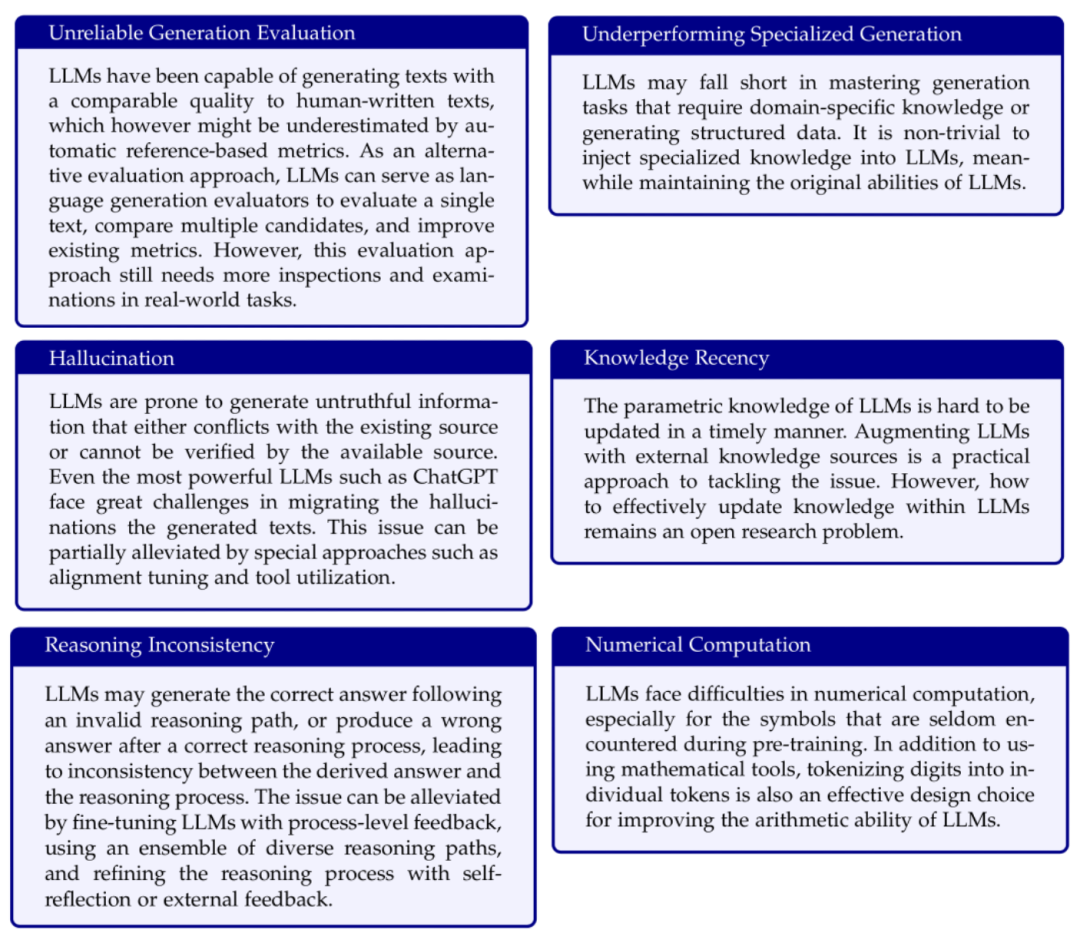

考虑到大语言模型的条件语言生成能力日益增长,我们介绍了已有工作对大语言模型时代语言生成自动评测可靠性问题的讨论。对于大语言模型的高级能力,我们增补了最新的相关工作,并总结了大语言模型高级能力评测的常用数据集供读者参考。此外,随着大语言模型通用能力的提升,一系列工作提出了更具挑战性的基于面向人类测试的综合评测基准来评测大语言模型,我们增加了这些代表性评测基准的介绍。 在大语言模型时代,开源和闭源的大语言模型不断涌现,我们对部分热门开源模型和闭源模型进行了细粒度的能力评测,涵盖了评测章节总结的8大基础和高级能力对应的27个代表性任务。进一步,我们对开源模型和闭源模型的评测结果进行了细致的分析。为了更好地说明大模型的现有问题,我们对于关键问题都进行了note形式的总结:

在大语言模型时代,开源和闭源的大语言模型不断涌现,我们对部分热门开源模型和闭源模型进行了细粒度的能力评测,涵盖了评测章节总结的8大基础和高级能力对应的27个代表性任务。进一步,我们对开源模型和闭源模型的评测结果进行了细致的分析。为了更好地说明大模型的现有问题,我们对于关键问题都进行了note形式的总结:

8. 大语言模型提示设计使用指南

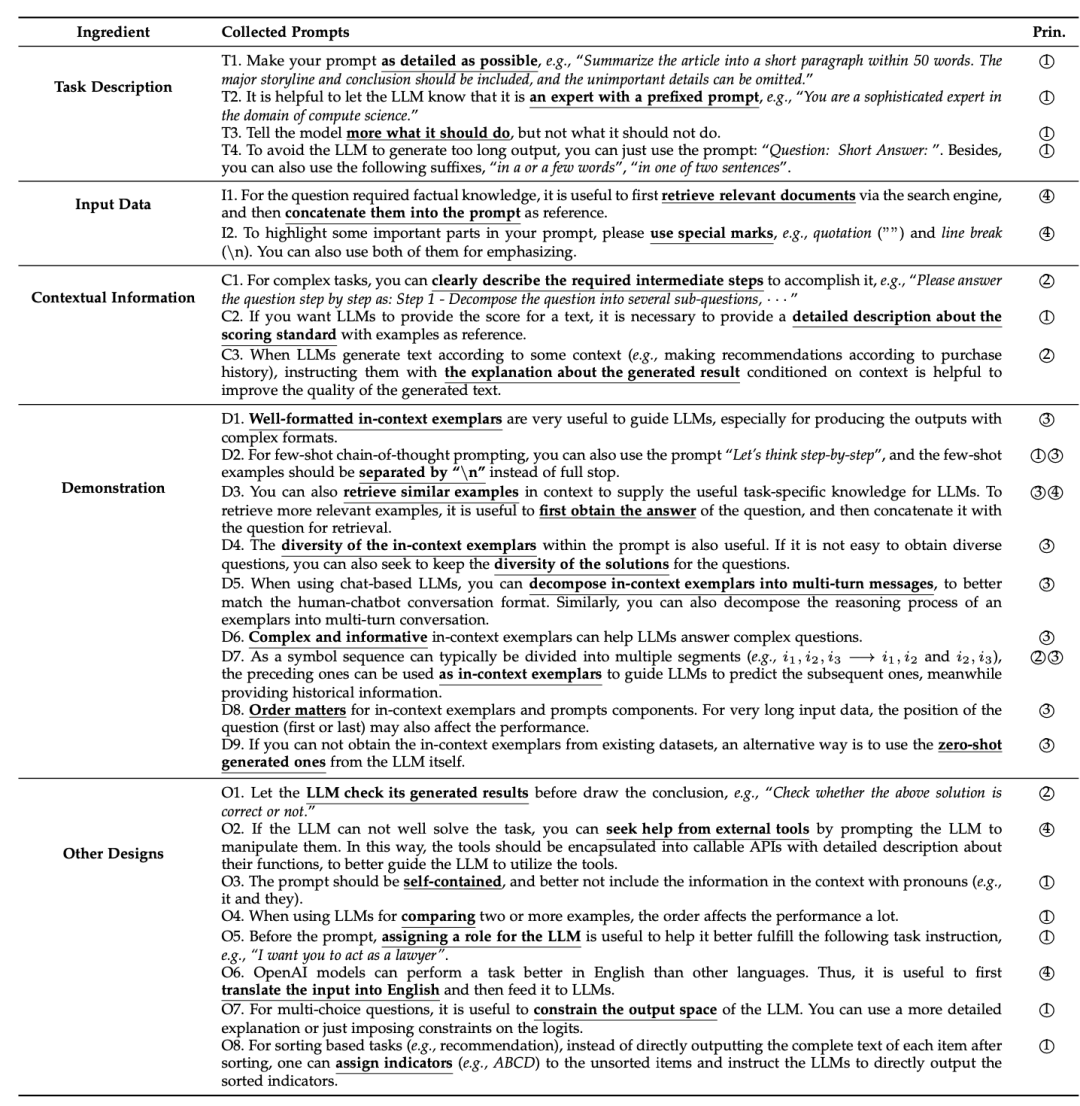

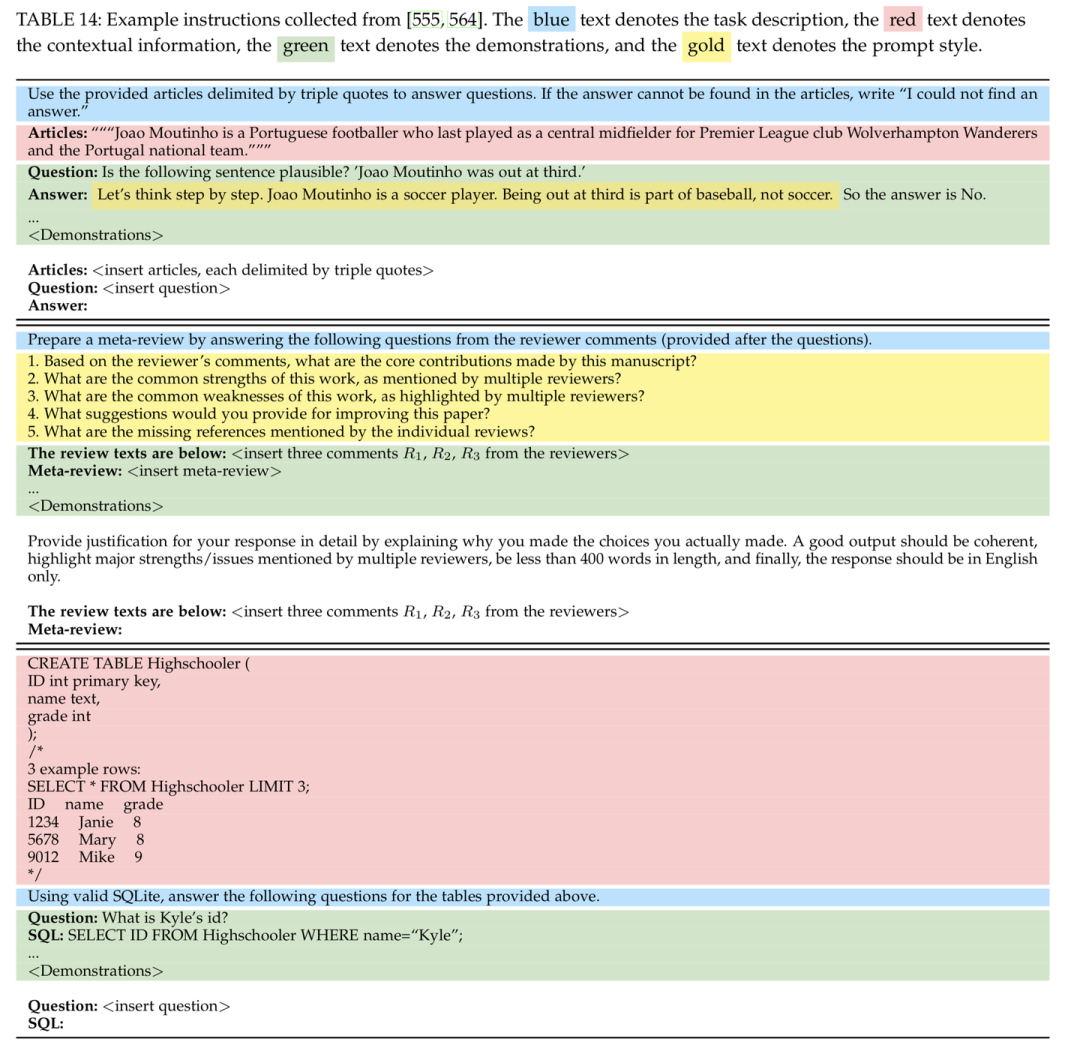

在大语言模型时代,提示成为了人与机器交互的重要形式。然而,如何编写好的提示是一门对技巧和经验要求很高的手艺。为了让读者能够快速上手大语言模型的提示设计,我们给出了一个实用的提示设计指南。我们详细介绍了提示的关键组件,并讨论了一些关键的提示设计原则。一个完整的提示通常包含四个关键组成因素,即任务描述、输入数据、上下文信息和提示风格。为了更好的展示这些组成因素,我们给出了直观的提示样例表。

增加了相关提示的示意图:

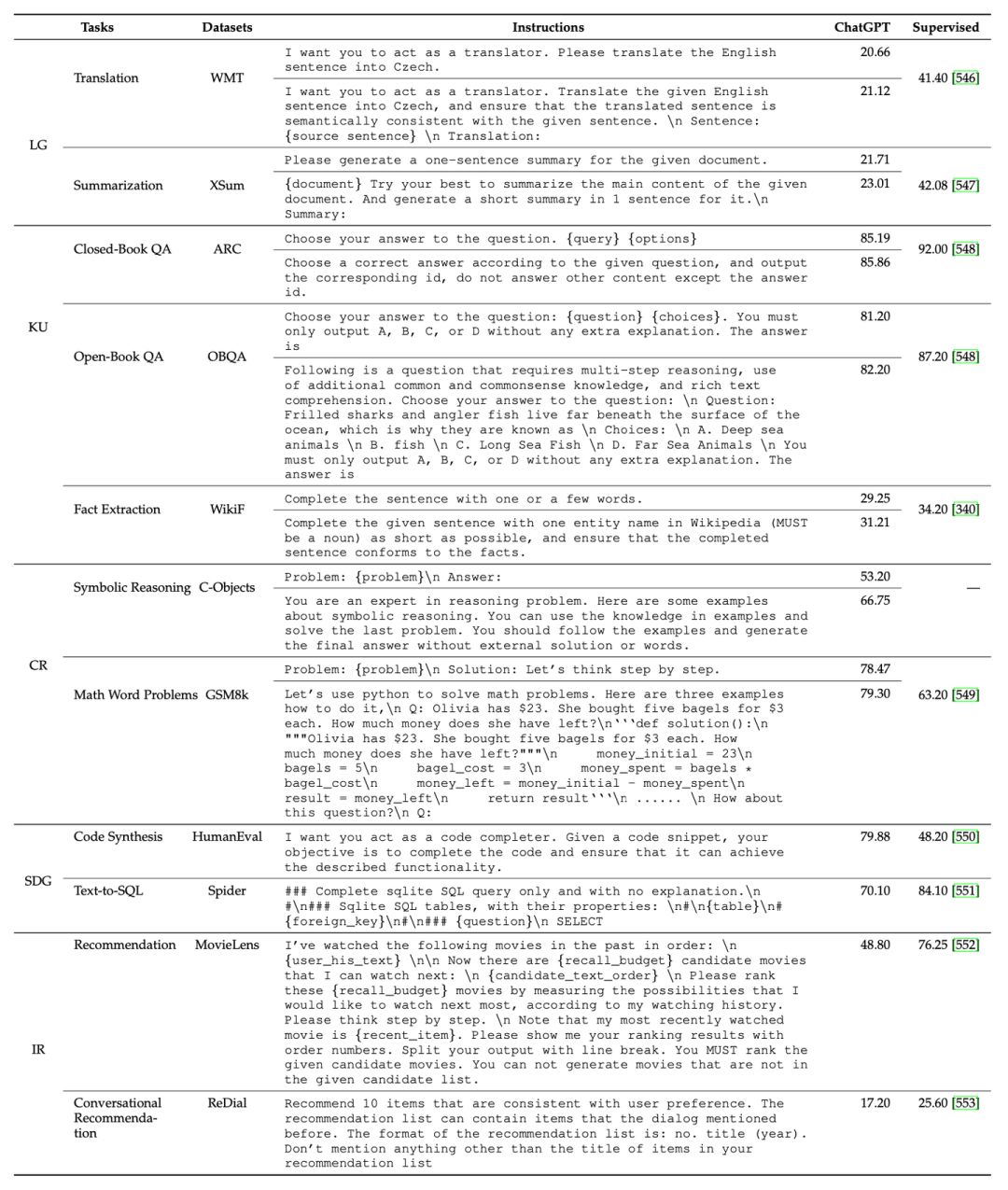

除此之外,我们还总结了一些关键的提示设计原则,包括清晰表述任务目标、将复杂任务进行分解以及使用模型友好的格式。进一步我们基于这些设计原则,展示了一系列有用的提示设计小贴士。最后,我们结合多种常见任务,基于ChatGPT具体实验了不同提示对模型性能的影响,供读者在使用提示执行具体任务时参考。

除此之外,我们还总结了一些关键的提示设计原则,包括清晰表述任务目标、将复杂任务进行分解以及使用模型友好的格式。进一步我们基于这些设计原则,展示了一系列有用的提示设计小贴士。最后,我们结合多种常见任务,基于ChatGPT具体实验了不同提示对模型性能的影响,供读者在使用提示执行具体任务时参考。

9. 大语言模型领域应用

随着大语言模型关注度的逐渐提升,研究者和工业界从业人员也尝试将大语言模型应用到各种专业领域中。为了系统地介绍这些应用实践,我们将综述中大语言模型的领域应用部分独立成了专门的章节。具体而言,我们扩充介绍了原有将大语言模型应用到医疗、教育、法律领域的相关研究,并新增了金融和科学研究领域的相关工作介绍。10. 寻求建议与算力

一篇高质量的长篇综述文章需要大量的时间投入,所参与的老师和学生为此付出了很多的时间。尽管我们已经尽力去完善这篇综述文章,但由于能力所限,难免存在不足和错误之处,仍有很大的改进空间。我们的最终目标是使这篇综述文章成为一个“know-how”的大模型技术指南手册,让大模型的秘密不再神秘、让技术细节不再被隐藏。尽管我们深知目前这篇综述离这个目标的距离还比较远,我们愿意在之后的版本中竭尽全力去改进。特别地,对于预训练、指令微调、提示工程的内在原理以及实战经验等方面,我们非常欢迎读者为我们贡献想法与建议,可以通过GitHub提交PR或者邮件联系我们的作者。对于所有被采纳的技术细节,我们都将在论文的致谢部分中“实名+实际贡献”进行致谢。同时,我们自己也在围绕大模型综述的部分内容开展相关的实验探索(如能力评测、指令微调等),以保证综述中的讨论能够有据可循。由于算力所限,目前能开展的实验局限于小尺寸模型和少量比较方法。在此,我们也向社会寻求算力支持,我们将承诺所获得的算力资源将完全用于该综述文章的编写,所有使用外部算力所获得的技术经验,将完全在综述文章中对外发布。我们将在综述的致谢部分和GitHub项目主页对于算力提供商进行致谢。针对本综述文章的算力资源支持事宜,烦请致信 batmanfly@qq.com 联系我们。我们的综述文章自发布以来,收到了广泛网友的大量修改意见,在此一并表示感谢。也希望大家一如既往支持与关注我们的大模型综述文章,您们的点赞与反馈将是我们前行最大的动力。11. 本次修订的参与学生名单

学生作者:周昆(添加了指令微调实验的任务设置与结果分析,具体安排了实验细节,添加了能力评测实验的实验设置与结果分析,协助整理code,添加了提示指南部分的实验设置与结果分析,添加了表13)、李军毅(添加了指令微调实验的数据集、改进策略和实验设置和实验表8,添加了能力评测实验的模型、任务和数据集,以及实验表11,添加了提示指南的设计原则和表12表14)、唐天一(添加第五章文字细节,添加图1、3、10,表6、7)、王晓磊(添加第六章6.1文字细节,新增6.3)、侯宇蓬(添加第四章文字细节)、闵映乾(添加第三章少数模型,LLaMA相关讨论,图4)、张北辰(添加第七章、第九章文字细节,添加表10)、董梓灿(添加图7表、4和第四章文字细节)、陈昱硕(表7实验)、陈志朋(添加第七章、第九章文字细节,表11实验)、蒋锦昊(更新图8)学生志愿者:成晓雪(表11实验)、王禹淏(表11实验)、郑博文(表11实验)、胡译文(中文校对)、侯新铭(中文校对)、尹彦彬(中文校对)、曹展硕(中文校对)附件:更新日志

| 版本 | 时间 | 主要更新内容 |

|---|---|---|

| V1 | 2023年3月31日 | 初始版本 |

| V2 | 2023年4月9日 | 添加了机构信息。修订了图表 1 和表格 1,并澄清了大语言模型的相应选择标准。改进了写作。纠正了一些小错误。 |

| V3 | 2023年4月11日 | 修正了关于库资源的错误 |

| V4 | 2023年4月12日 | 修订了图1 和表格 1,并澄清了一些大语言模型的发布日期 |

| V5 | 2023年4月16日 | 添加了关于 GPT 系列模型技术发展的章节 |

| V6 | 2023年4月24日 | 在表格 1 和图表 1 中添加了一些新模型。添加了关于扩展法则的讨论。为涌现能力的模型尺寸添加了一些解释(第 2.1 节)。在图 4 中添加了用于不同架构的注意力模式的插图。在表格 4 中添加了详细的公式。 |

| V7 | 2023年4月25日 | 修正了图表和表格中的一些拷贝错误 |

| V8 | 2023年4月27日 | 在第 5.3 节中添加了参数高效适配章节 |

| V9 | 2023年4月28日 | 修订了第 5.3 节 |

| V10 | 2023年5 月7 日 | 修订了表格 1、表格 2 和一些细节 |

| V11 | 2023年6月29日 | 第一章:添加了图1,在arXiv上发布的大语言论文趋势图;第二章:添加图3以展示GPT的演变及相应的讨论;第三章:添加图4以展示LLaMA家族及相应的讨论;第五章:在5.1.1节中添加有关指令调整合成数据方式的最新讨论, 在5.1.4节中添加有关指令调整的经验分析, 在5.3节中添加有关参数高效适配的讨论, 在5.4节中添加有关空间高效适配的讨论;第六章:在6.1.3节中添加有关ICL的底层机制的最新讨论,在6.3节中添加有关复杂任务解决规划的讨论;第七章:在7.2节中添加用于评估LLM高级能力的代表性数据集的表格10,在7.3.2节中添加大语言模型综合能力pint测;第八章:添加提示设计;第九章:添加关于大语言模型在金融和科学研究领域应用的讨论。 |

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

语言模型

+关注

关注

0文章

436浏览量

10059 -

大模型

+关注

关注

2文章

1555浏览量

1148

原文标题:人大发表迄今为止最大最全的大模型综述

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

35亿美元!诺基亚获迄今为止数额最大5G合同

们手下的高额订单。据外媒最新公布的消息,来自芬兰的诺基亚公司日前获得了迄今为止数额最大的5G合同,价值高达35亿美元。

努比亚Z18S将于10月31日发布 官方称迄今为止最全面的全面屏

近日,努比亚手机总经理倪飞在微博宣布了一个重磅消息,努比亚将于10月31日举办新品发布会,并表示:“6周年诚意之作,迄今为止,最全面的全面屏!”而倪飞的微博小尾巴变成了“努比亚X 护眼双屏”可见届时将发布新手机努比亚X,该机搭载两个屏幕,它就是此前曝光的努比亚Z18S。

小米宣布将于12月8日在纽约举办迄今为止最大的聚会

近日,据外媒Phonearena报道,经过Reddit确认,小米宣布将于当地时间12月8日在纽约举办活动,活动的具体时间和地址尚未确定,不过这家中国厂商声称,这将是它“迄今为止最大的聚会”。小米还表示将在活动中展示它最新和最伟大的产品,与会者能够见到美国团队、特别嘉宾,甚

努比亚红魔Mars是迄今为止跑分最高的骁龙845游戏手机

努比亚红魔Mars电竞手机将正式在努比亚官网、京东商城等平台开售。红魔Mars电竞手机是真正为游戏而生的手机,搭载高通骁龙845处理器,配备最高10GB+256GB超大内存组合,其安兔兔评分高达32万分以上,是迄今为止跑分最高的骁龙845游戏手机。

发表于 12-05 16:25

•3702次阅读

骁龙865没有集成却是迄今为止最先进的5G移动平台

高通表示,骁龙865没有集成并不影响其性能,反而骁龙865是迄今为止最先进的5G移动平台,单以集成与否来衡量芯片强弱是没道理的。

发表于 12-05 09:19

•1149次阅读

Intel全力打磨的独立显卡 将是迄今为止印度打造的最大硅片

Intel正全力打磨“三进宫”的独立显卡产品,首席架构师Raja Koduri本周发推文确认,Xe HP(高性能Xe核心)由印度团队设计,已达成里程碑,预计将是迄今为止印度打造的最大硅片,甚至是世界最大的硅片,堪称“爸爸级”。

比亚迪拿下荷兰巨额订单 是迄今为止欧洲最大的纯电动大巴订单

据国内媒体报道,12月6日,比亚迪中标荷兰259台纯电动大巴订单,与欧洲公交运营商凯奥雷斯(Keolis)荷兰分公司签署协议。据比亚迪介绍,此次订单涉及比亚迪巴士家族多款车型,并且这也是迄今为止欧洲最大的纯电动大巴订单。

发表于 12-09 13:35

•1230次阅读

5G将是迄今为止最安全的无线传输技术

来自Light Reading的报道称,无线行业人士认为,5G将是迄今为止最安全的无线传输技术。但是不断有研究报告称,研究人员持续在5G标准中发现漏洞。

发表于 12-09 14:43

•1182次阅读

霍尼韦尔宣布将在2020年年中发布迄今为止功能最强大的量子计算机

3月4日消息,霍尼韦尔正式宣布:到2020年年中(一般指六月或七月),我们将发布迄今为止功能最强大的量子计算机。

iPhone13缺芯减产?供应商辟谣 今年迄今为止没有削减订单

苹果组件供应商声称今年迄今为止没有削减订单,但是由于芯片短缺问题,苹果产品的生产的确会面临挑战。

发表于 10-14 10:56

•1991次阅读

人大发表迄今为止最大最全的大模型综述

人大发表迄今为止最大最全的大模型综述

评论