电子发烧友网报道(文/周凯扬)自研芯片在当下似乎已经成了一种潮流,无论是消费电子厂商、互联网公司还是汽车厂商,都在拿自研芯片做文章。作为时刻都在与计算打交道的云端,自然也参与其中,甚至是先进工艺自研芯片的主力军。

自研芯片能省下多少钱?

早在芯片产业有布局,或者以收购来掌握芯片设计实力的云服务厂商,几乎都选择了自研服务器芯片这条路线,比如亚马逊、谷歌、阿里巴巴等等。自研芯片的范围也从网络芯片到通用计算的CPU,再到用于AI计算的ASIC芯片。

亚马逊就靠着自研芯片省下了一大笔成本,这也是其他云服务厂商目前都没能复制的成功。首先自研芯片通过架构上的创新,为其定制化实例提供了更高的性能,比如Nitro芯片靠卸载任务可以多省出两个CPU内核;其次,对于某些特定的工作负载来说,自研芯片带来了更容易把握的战略控制以及硬件锁定;最后,自然也省去了找第三方fabless设计公司的成本。

考虑到云服务厂商在硬件投入上的规模,以及亚马逊作为全球第一大云服务厂商的体量,其中省下的成本还是相当庞大的。这也是亚马逊走自研芯片可行的原因,其他云服务厂商或许能通过自研把设计成本压下去,但制造成本绝对没法像亚马逊一样压这么低,这也是为何AWS过去能做到频繁降价。

AI时代下自研芯片优势有,但不多

亚马逊在收购后,接连推出了Trainium和Inferentia这两大训练和推理加速器,并将其集成到自己的云端实例中去,以优异的性能为客户提供高性价比的AI硬件方案。但这似乎并没有为其在最近的AI热潮中带来优势,反倒是微软凭借英伟达的GPU率先以ChatGPT开启了这场恶战,谷歌的Bard也紧随其后。

亚马逊则选择了与Hugging Face合作,作为其首选云供应商,用户可以借助AWS上的先进工具,比如SageMaker托管服务,以及Trainium和Inferentia硬件,去训练、微调和部署模型,从而为社区创造更加开放易用的AI。

但事实上是,这一合作激起的水花很快就被淹没在了如倾盆大雨般落地的AI应用中。而且对于Hugging Face来说,他们想要打造的是开放式的生成式AI模型,也就是说其他厂商也都能从中获益,也就是两家共同提到的机器学习民主化。

况且在部署上,早在与亚马逊合作之前,Hugging Face就已经在2022年与微软Azure达成合作,在Azure的ML终结点上部署Hugging Face的机器学习推理服务。所以这次合作即便充分利用了亚马逊的自研AI芯片,但给其带来的优势并不算大。无论是在性能还是在软件生态上,现有的自研芯片都存在如鲠在喉的地方,而这不仅局限于亚马逊这样的大厂,不少初创AI芯片公司也都或多或少面临这样的困境。

结语

其实自研芯片也并非真的毫无灵活性可言,比如亚马逊的Graviton和阿里的倚天710,虽说是自研芯片,但用到的毕竟还是Arm的Neoverse公版方案,还有不少第三方方案也是如此,比如英伟达的Grace、Ampere Computing的Altra等等。

这样一来其实开发灵活性依然很高,比如英伟达为了给Grace做铺垫,也对同类产品的软件栈提供了支持。比如英伟达的HPC SDK全面支持AWS的Graviton 3,也支持对SVE和NEON的自动矢量化。而英伟达推出的Arm HPC开发套件,也是由Ampere的Altra Q80-30 CPU与A100 GPU组合打造的,与Grace芯片共用同一套软件环境。

只不过在AI领域,这样的自研路线优势会更小一点,毕竟现在AI模型与算法发展迅速,自研GPU有着各种难以突破的专利壁垒,自研ASIC又存在迭代适应和软件生态移植的问题。而这对于云服务厂商这种为客户赋能更快产品上市速度的企业来说,或许在AI仍在快速演进的当下,GPU会是更优解,这也是云服务厂商即便选择了自研AI芯片,主打的却依然是GPU实例的原因。

自研芯片能省下多少钱?

早在芯片产业有布局,或者以收购来掌握芯片设计实力的云服务厂商,几乎都选择了自研服务器芯片这条路线,比如亚马逊、谷歌、阿里巴巴等等。自研芯片的范围也从网络芯片到通用计算的CPU,再到用于AI计算的ASIC芯片。

亚马逊就靠着自研芯片省下了一大笔成本,这也是其他云服务厂商目前都没能复制的成功。首先自研芯片通过架构上的创新,为其定制化实例提供了更高的性能,比如Nitro芯片靠卸载任务可以多省出两个CPU内核;其次,对于某些特定的工作负载来说,自研芯片带来了更容易把握的战略控制以及硬件锁定;最后,自然也省去了找第三方fabless设计公司的成本。

考虑到云服务厂商在硬件投入上的规模,以及亚马逊作为全球第一大云服务厂商的体量,其中省下的成本还是相当庞大的。这也是亚马逊走自研芯片可行的原因,其他云服务厂商或许能通过自研把设计成本压下去,但制造成本绝对没法像亚马逊一样压这么低,这也是为何AWS过去能做到频繁降价。

AI时代下自研芯片优势有,但不多

亚马逊在收购后,接连推出了Trainium和Inferentia这两大训练和推理加速器,并将其集成到自己的云端实例中去,以优异的性能为客户提供高性价比的AI硬件方案。但这似乎并没有为其在最近的AI热潮中带来优势,反倒是微软凭借英伟达的GPU率先以ChatGPT开启了这场恶战,谷歌的Bard也紧随其后。

亚马逊则选择了与Hugging Face合作,作为其首选云供应商,用户可以借助AWS上的先进工具,比如SageMaker托管服务,以及Trainium和Inferentia硬件,去训练、微调和部署模型,从而为社区创造更加开放易用的AI。

但事实上是,这一合作激起的水花很快就被淹没在了如倾盆大雨般落地的AI应用中。而且对于Hugging Face来说,他们想要打造的是开放式的生成式AI模型,也就是说其他厂商也都能从中获益,也就是两家共同提到的机器学习民主化。

况且在部署上,早在与亚马逊合作之前,Hugging Face就已经在2022年与微软Azure达成合作,在Azure的ML终结点上部署Hugging Face的机器学习推理服务。所以这次合作即便充分利用了亚马逊的自研AI芯片,但给其带来的优势并不算大。无论是在性能还是在软件生态上,现有的自研芯片都存在如鲠在喉的地方,而这不仅局限于亚马逊这样的大厂,不少初创AI芯片公司也都或多或少面临这样的困境。

结语

其实自研芯片也并非真的毫无灵活性可言,比如亚马逊的Graviton和阿里的倚天710,虽说是自研芯片,但用到的毕竟还是Arm的Neoverse公版方案,还有不少第三方方案也是如此,比如英伟达的Grace、Ampere Computing的Altra等等。

这样一来其实开发灵活性依然很高,比如英伟达为了给Grace做铺垫,也对同类产品的软件栈提供了支持。比如英伟达的HPC SDK全面支持AWS的Graviton 3,也支持对SVE和NEON的自动矢量化。而英伟达推出的Arm HPC开发套件,也是由Ampere的Altra Q80-30 CPU与A100 GPU组合打造的,与Grace芯片共用同一套软件环境。

只不过在AI领域,这样的自研路线优势会更小一点,毕竟现在AI模型与算法发展迅速,自研GPU有着各种难以突破的专利壁垒,自研ASIC又存在迭代适应和软件生态移植的问题。而这对于云服务厂商这种为客户赋能更快产品上市速度的企业来说,或许在AI仍在快速演进的当下,GPU会是更优解,这也是云服务厂商即便选择了自研AI芯片,主打的却依然是GPU实例的原因。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

服务器

+关注

关注

13文章

10094浏览量

90870

发布评论请先 登录

相关推荐

热点推荐

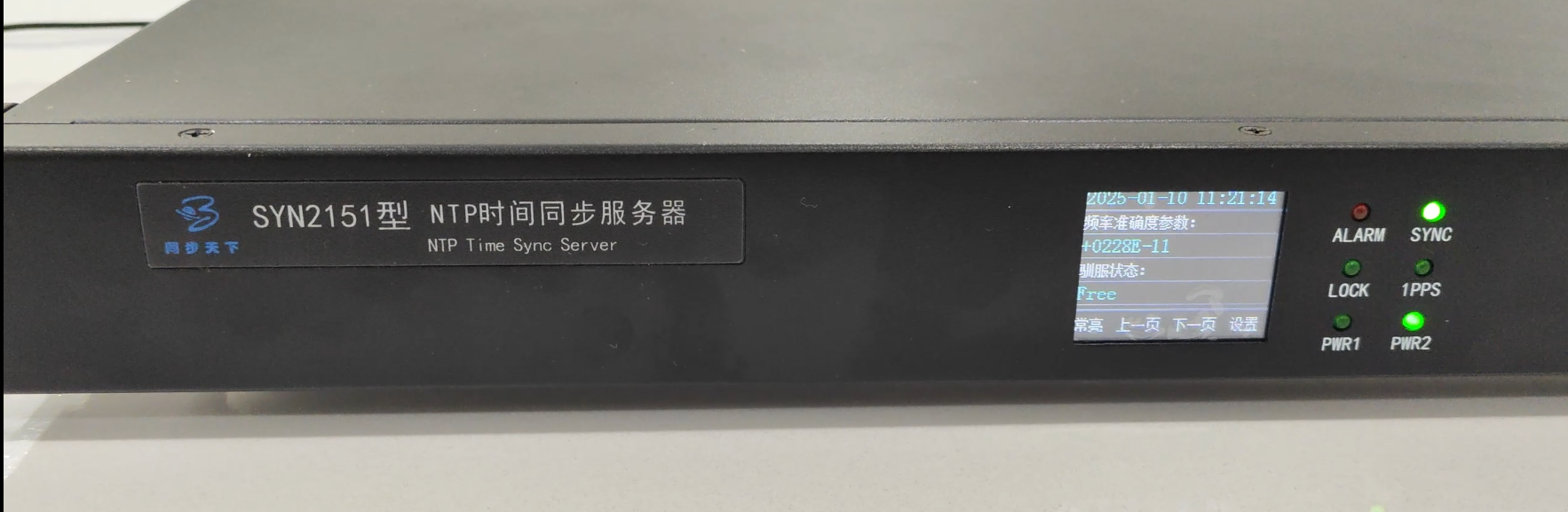

NTP自动校时服务器的核心优势介绍

NTP自动校时服务器是一种基于网络的时间同步设备,它通过与高精度时间源(如GPS、原子钟或国家授时中心)进行通信,获取准确的时间信息,并将其分发到网络中的各个设备。其核心优势在于能够实现毫秒级甚至

什么是服务器虚拟化?一文读懂原理、优势与实战部署

什么是服务器虚拟化?当企业服务器CPU利用率长期低于15%,却仍需不断采购新硬件应对业务增长时,一场基础设施领域的革命早已悄然发生——服务器虚拟化。这项技术通过将物理服务器划分为多个独

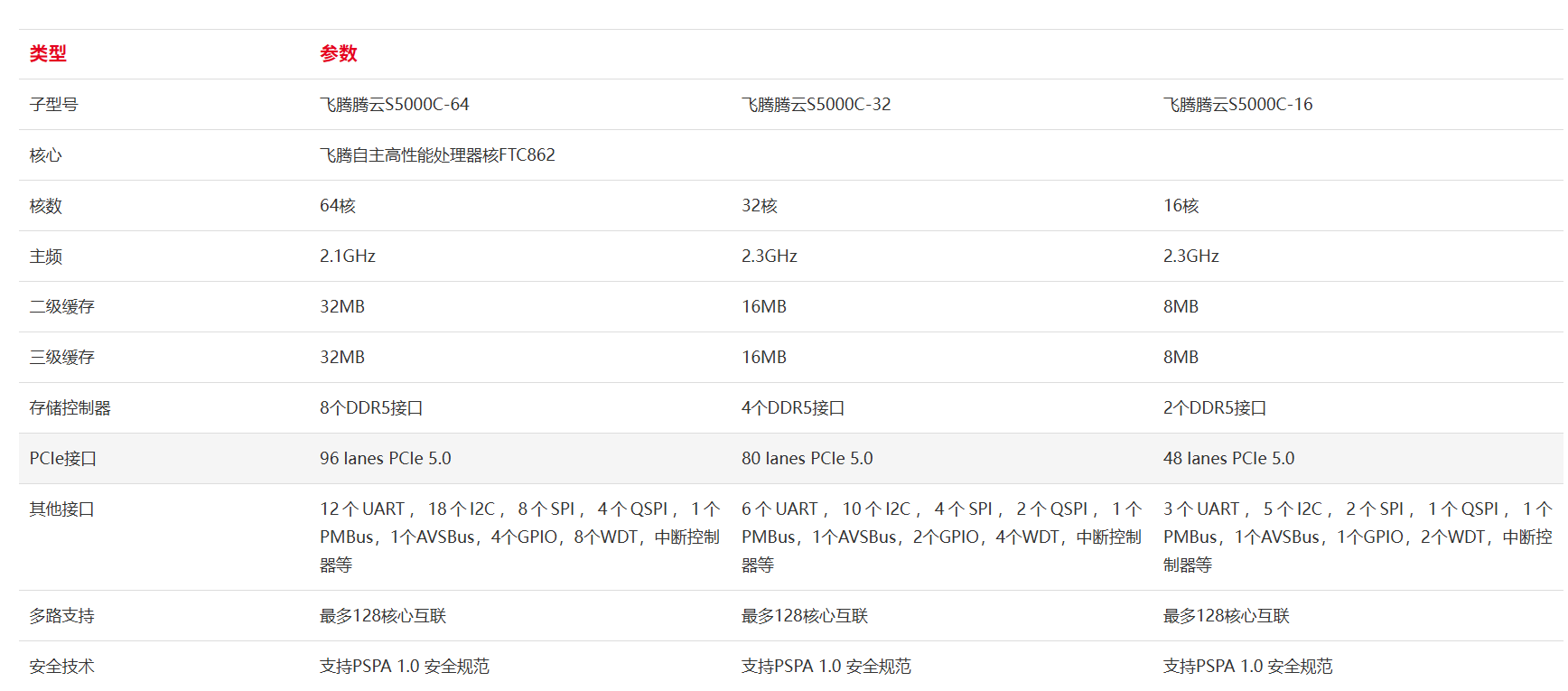

高端芯片自研,服务器芯片传来好消息!

电子发烧友网报道(文/黄晶晶)当前,自研处理器已经跨过了能用的阶段,逐渐走向好用,但无论是消费级还是服务器级都面临着如何在性能上接近国外高端产品,以及生态上如何更加完善的问题。国内厂商

RAKsmart服务器SEO优化优势分析

在RAKsmart服务器上搭建SEO网站,可以借助其基础设施和服务特性,从技术层面优化搜索引擎排名。以下是具体优势及分析,主机推荐小编为您整理发布RAKsmart服务器SEO优化

利用RAKsmart服务器托管AI模型训练的优势

AI模型训练需要强大的计算资源、高效的存储和稳定的网络支持,这对服务器的性能提出了较高要求。而RAKsmart服务器凭借其核心优势,成为托管AI模型训练的理想选择。下面,AI部落小编为您具体分享。

云服务器对比空间有什么优势和劣势?

云服务器相比空间,优势在于提供更高管理权限、灵活可扩展的资源配置、卓越性能及更强安全性,适合有特定需求和技术背景的用户。然而,云服务器成本较高,技术门槛也相对较高,且依赖稳定互联网连接。相比之下

双北斗校时服务器、双北斗授时服务器、双北斗对时服务器、双北斗NTP服务器

双北斗时间服务器具有许多优势,使其成为时间同步领域的佼佼者。首先,北斗卫星导航系统具有高精度、高稳定性和高实时性的特点,为北斗时间服务器提供了可靠的时间源。其次,北斗时间服务器采用了先

进迭时空服务器芯片发布:64 位RISC-V架构、12nm

。据介绍,V100服务器芯片采用了公司自研的RISC-VCPU核心X100、支持中断虚拟化的AIA和APLIC、支持内存虚拟化的IOMMU、支持安全功能的IOPMP、支

国外多ip服务器核心优势

国外多IP服务器是指配备有多个独立IP地址的服务器,这些服务器通常位于国外。主机推荐小编为您整理发布国外多ip服务器核心优势,以下是对国外多

服务器托管好还是云服务器好一些?

服务器托管和云服务器各有优势,选择取决于业务需求、预算和长远规划。服务器托管提供稳定性能和高安全性,适合对性能有严格要求的场景,但成本较高且扩展性有限。云

自研服务器芯片或许没有那么大优势

自研服务器芯片或许没有那么大优势

评论