关键词:人工智能、高性能计算、HPC、GPU、CPU、服务器、人工智能服务器、人工智能工作站、深度学习、机器学习、液冷散热、冷板式液冷、水冷工作站、液冷服务器、AI服务器

如今,市场上有越来越多熟悉的AI服务场景,如小爱同学、天猫精灵、小度等。当人类进入人工智能时代时,AI服务器也融入到社会行业的各个方面,那么AI服务器和普通服务器有什么区别呢?为什么AI服务器可以在人工智能时代取代大多数普通服务器?

众所周知,普通服务器是以CPU为计算能力的提供者,采用串行架构,擅长逻辑计算和浮点计算。由于逻辑判断需要大量的分支跳转,使得CPU的结构复杂,计算能力的提高主要靠堆积更多的核心数来实现。

然而,在大数据、云计算、人工智能、元宇宙、数据孪生和物联网等网络技术的应用中,互联网上的数据呈现出几何倍数的增长,这对以CPU为主要计算能力来源的传统服务是巨大的考验。目前,CPU的制程工艺和单个CPU的核心数接近极限,但数据的增加仍在继续,因此有必要提高服务器的数据处理能力。在这种环境下,AI服务器应运而生。

目前市场上的AI服务器普遍采用CPU + GPU,由于GPU和CPU形式不同所以AI服务器采用并行计算模式,善于梳理图形渲染、机器学习等密集数据操作。在GPU上,NVIDIA优势明显,GPU单卡核心数可达近千个,如配置16张NVIDIA Tesla V100 Tensor Core 32GB GPUs核心数可超过10240个,计算性能高达每秒2千万亿次。而且经过近几年市场的发展,也证实了CPU +GPU异构服务器在当前环境下确实有很大的发展空间。

一、AI服务器应用场景有哪些?

基于AI服务器的优势,AI服务器广泛应用于深度学习、高性能计算、医疗、搜索引擎、游戏、电子商务、金融、安全等行业。

1、医学图像智能分析

通过机器视觉、知识地图、深度学习等人工智能技术,模拟医学专家思维、推理诊断,帮助医生定位疾病,协助诊断

2、人脸识别、语音识别、指纹识别

图片、视频等图像数据可以通过深度学习、机器学习等技术进行训练

3、安全监控

可应用于人体分析、图像分析、车辆分析、行为分析等安全场景

4、零售预测

通过机器学习,基于商店历史销售数据,可以准确预测未来销售数据,为运营商提供更准确的决策分析。此外,在零售业中,还有无人驾驶销售、人脸支付等常见的应用场景

5、金融服务

通过语音、唇形、表达合成技术和深度学习技术,克隆人工智能视频面试官等真实面试官,可以准确地与客户进行多轮面试。

此外,还有微表情识别系统的应用场景

二、AI服务器与普通服务器的区别是什么?

1、服务器的硬件架构

AI服务器是异构服务器,可以根据应用范围采用不同的组合方式,如CPU + GPU、CPU + TPU、CPU + 其他加速卡等。与普通服务器相比,内存、存储、网络没有区别,主要是大数据、云计算、人工智能等方面需要更多的内存,满足各种数据的收集整理

2、卡数量不一致

普通GPU服务器一般是单卡或者双卡,AI服务器需要承担大量计算,一般配置四块以上的GPU卡,甚至搭建一个AI服务器集群

3、独特的设计

由于AI服务器有多个GPU卡,需要对系统结构、散热和拓扑进行专门设计,以满足AI服务器长期稳定运行的要求

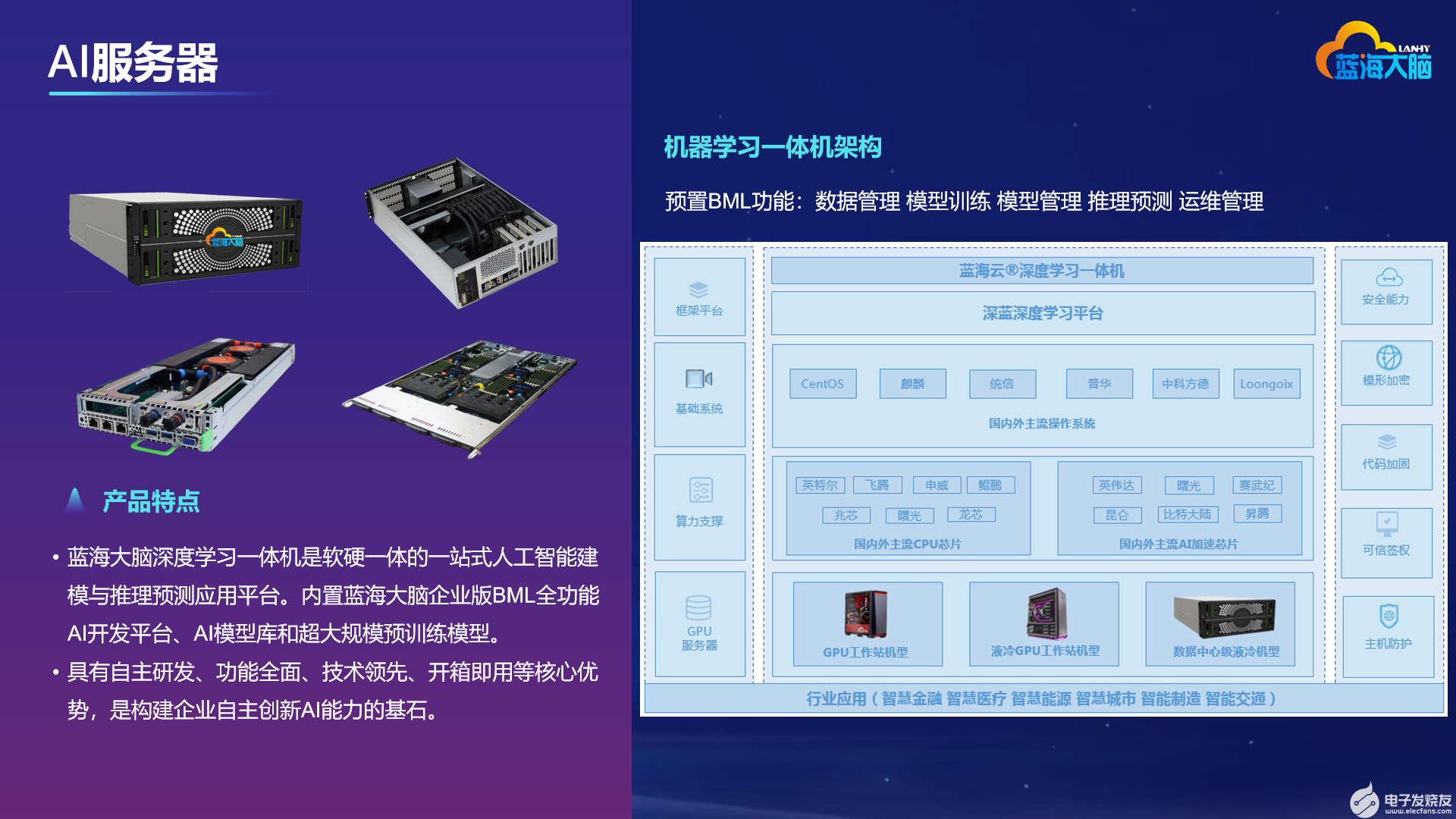

三、蓝海大脑AI服务器

1、应用场景

物理模型、3D建模、机器学习、深度学习、人工智能、CFD、CAE、DCC、数据分析、卫星成像等高性能计算场景

2、强大的性能

蓝海大脑AI服务器是一款搭建 Intel 可扩展系列处理器的高性能计算平台,支持4个NVIDIA GPU加速器,单精度浮点计算112TFLOPS、双精度浮点计算56TFLOPS, 让用户体验强大的计算性能

3、灵活的配置

为更加贴切的满足各种应用需求,网络选择多样化,可选择支持双千兆、四千兆、双千兆+双万兆搭配,所有网络支持管理复用,满足各种不同的网络应用场景

4、液冷散热

蓝海大脑AI服务器突破传统风冷散热模式,采用风冷和液冷混合散热模式——服务器内主要热源 CPU 利用液冷冷板进行冷却,其余热源仍采用风冷方式进行冷却。通过这种混合制冷方式,可大幅提升服务器散热效率,同时,降低主要热源 CPU 散热所耗电能,并增强服务器可靠性。经检测,采用液冷服务器配套基础设施解决方案的数据中心年均 PUE 值可降低至 1.2 以下

5、合理的扩展

在支持4块GPU卡的同时还有PCI-E插槽可用,可扩展100Gb infiniband HCA、Nvme SSD等、具有非常好的灵活性和兼容性

6、支持热插拔技术

采用分体式引流技术,在出现某一块GPU、CPU卡损坏后可继续使用,不耽误服务器正常工作

7、便捷的管理

具备远程管理功能,实现非现场即可监控管理服务器要求,具有监控系统各部件的运行状况、远程安装操作系统、故障报警等功能。极大的缩减了维护开销

审核编辑黄宇

-

cpu

+关注

关注

68文章

11216浏览量

222860 -

服务器

+关注

关注

13文章

10093浏览量

90856 -

AI

+关注

关注

89文章

38085浏览量

296325

发布评论请先 登录

结合AI算法的边缘计算服务器,在城市管理场景有什么作用?

对话|AI服务器电源对磁性元件提出的新需求

工控机 vs 服务器:核心区别与应用场景深度解析

AI 服务器电源如何迭代升级?

云存储服务器租用的好处有哪些?

RAKsmart服务器如何赋能AI开发与部署

AI运算服务器工控机特点与应用

AI 推理服务器都有什么?2025年服务器品牌排行TOP10与选购技巧

AI服务器的应用场景有哪些?

AI服务器的应用场景有哪些?

评论