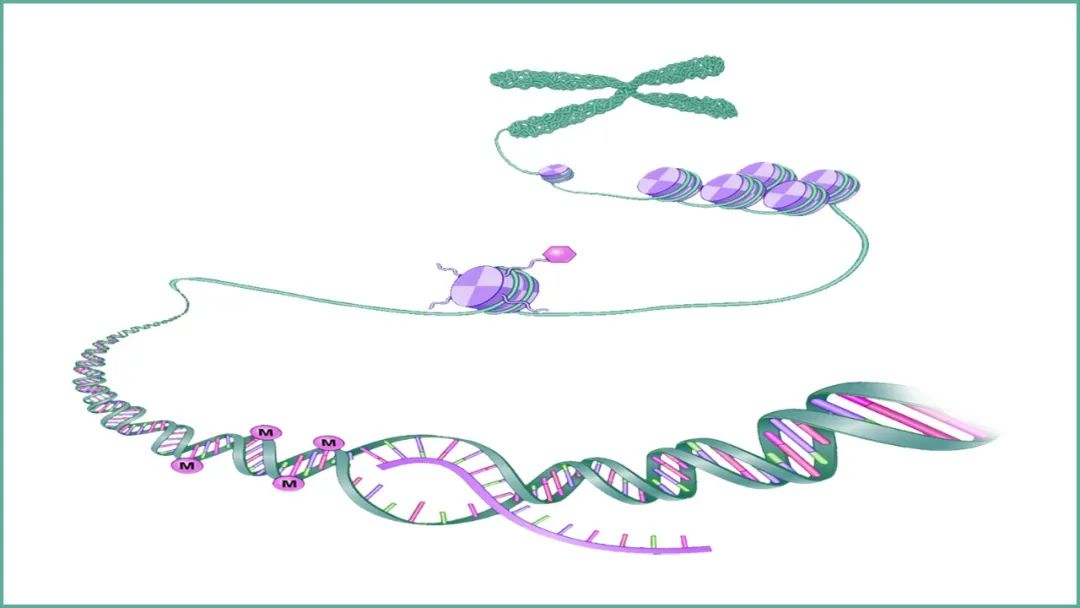

InstaDeep、慕尼黑工业大学(TUM)和 NVIDIA 之间的合作推动了面向基因组学的多超级计算规模的基础模型开发进程。这些模型在大量预测任务(例如启动子和增强子位点预测)中展示了最先进的性能。

这一联合团队的研究指出,经过基因组学训练的大型语言模型(LLM)可将应用扩展到大量基因组学任务。

该团队使用 NVIDIA 的超级计算机 Cambridge-1 来训练参数规模从 500M 到 2.5B 不等的各种大型语言模型(LLM)。这些模型在各种基因组数据集上进行了训练,以探索模型规模和数据多样性对下游任务性能的影响。

分类任务包括预测增强子和启动子序列以及转录因子结合位点。这些任务有助于了解 DNA 如何转录生成 RNA 和蛋白质,从而开启新的临床应用。

研究中明确了 20 项任务。对于每一项任务,性能都随着模型规模和数据集多样性的增加而单调递增。参照专门的最新模型基线,在多物种数据集上训练的具有最大参数规模(2.5B 参数)的大型语言模型在 19 项任务中的 15 项中取得了同等或更高的性能。

这些结果是通过利用参数轻量化微调实现的。然而,即使依靠从 Transformer 模型各层提取的预训练嵌入以及简单的浅层感知器(MLP)或逻辑回归,也足以在 11 个任务中实现同等乃至更高的性能。

在每个模型检查点和每个任务的所有层上应用这种探测策略,训练出了 120 万个 MLP 模型。该研究对大型语言模型的训练和使用等各方面进行了详细分析,例如不同层对下游任务性能的影响。

在固定模型规模下直接比较序列多样性,显示出具有重要意义的性能提升,增加模型规模也是如此。例如,对于一个 500M 参数模型,仅在人类参考基因组上训练的性能不如在 1000 基因组数据集上训练的性能。

同样,在 1000 基因组数据集上训练的 2.5B 参数模型的性能优于任何 500M 参数模型。而对于相同的模型,性能会逊于在自定义多物种数据集上训练的结果,即使下游性能是在仅涉及人类基因组的任务上测量的。

研究人员观察到,并非所有嵌入都是平等创建的。虽然通常的做法建议使用大型语言模型的最后一层进行下游预测。但耐人寻味的是,中间层产生的表征在下游任务中显示出明显更高的性能。研究人员发现,最佳层的选择取决于任务,表明不同类型的 DNA 特征被不同层的模型所捕获。

InstaDeep 首席执行官 Karim Beguir 表示:“我们相信这些结果首次清楚地证明了基因组学基础模型的可行性,这些模型能够真正地推广到多项任务中。这些结果从很多方面反映出了过去几年内适应性基础模型在自然语言处理方面的发展进程。如今,其应用于药物研发和人类健康等如此具有挑战性的问题,着实令人难以置信的兴奋。”

NVIDIA 的 Cambridge-1 对该项目的成功至关重要。该项目需要高性能计算基础设施来训练具有捕获基因组中远程相互作用所需感受域的大型模型。

研究人员尝试了多种方法、数据集大小、模型规模和分词器方案,最终使用在 16 个 NVIDIA DGX A100 节点(128 个 A100 80GB GPU)上训练的 2.5B 参数稀疏注意力模型,在多任务上实现了迄今公开发表的最佳性能。

在未来的研究工作中,该团队计划通过直接微调模型,探索进一步的下游任务性能改进,并将继续在应用于基因组学的大型语言模型的架构创新方面展开合作。InstaDeep 是首批使用 Cambridge-1 的 NVIDIA 初创加速计划成员之一。

扫描下方海报二维码,即可免费注册 GTC 23,切莫错过这场 AI 和元宇宙时代的技术大会!

原文标题:基因组学大型语言模型在多项任务中均展现出卓越的性能和应用扩展空间

文章出处:【微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

-

英伟达

+关注

关注

23文章

4044浏览量

97709

原文标题:基因组学大型语言模型在多项任务中均展现出卓越的性能和应用扩展空间

文章出处:【微信号:NVIDIA_China,微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

第十二届全国功能基因组学高峰论坛在京举办:聚焦人工智能与多组学融合发展

一文了解Mojo编程语言

中科曙光构建全国产化基因组学高性能计算平台

SMA接口:如何在有限空间内实现卓越射频连接

无法在OVMS上运行来自Meta的大型语言模型 (LLM),为什么?

NVIDIA使用加速计算与AI推动精准医学发展

添越智创基于 RK3588 开发板部署测试 DeepSeek 模型全攻略

【「基于大模型的RAG应用开发与优化」阅读体验】+大模型微调技术解读

NVIDIA 携手行业领先机构推动基因组学、药物发现及医疗健康行业发展

基因组学大型语言模型在多项任务中均展现出卓越的性能和应用扩展空间

基因组学大型语言模型在多项任务中均展现出卓越的性能和应用扩展空间

评论