香港中文大学(深圳)吴保元教授课题组和浙江大学秦湛教授课题组联合发表了一篇后门防御领域的文章,已顺利被ICLR2022接收。近年来,后门问题受到人们的广泛关注。随着后门攻击的不断提出,提出针对一般化后门攻击的防御方法变得愈加困难。该论文提出了一个基于分割后门训练过程的后门防御方法。本文揭示了后门攻击就是一个将后门投影到特征空间的端到端监督训练方法。在此基础上,本文分割训练过程来避免后门攻击。该方法与其他后门防御方法进行了对比实验,证明了该方法的有效性。

1 背景介绍

后门攻击的目标是通过修改训练数据或者控制训练过程等方法使得模型预测正确干净样本,但是对于带有后门的样本判断为目标标签。例如,后门攻击者给图片增加固定位置的白块(即中毒图片)并且修改图片的标签为目标标签。用这些中毒数据训练模型过后,模型就会判断带有特定白块的图片为目标标签(如下图所示)。

基本的后门攻击

模型建立了触发器(trigger)和目标标签(target label)之间的关系。

2 相关工作

2.1 后门攻击

现有的后门攻击方法按照中毒图片的标签修改情况分为以下两类,修改中毒图片标签的投毒标签攻击(Poison-Label Backdoor Attack),维持中毒图片原本标签的干净标签攻击(Clean-Label Backdoor Attack)。

投毒标签攻击: BadNets (Gu et al., 2019)是第一个也是最具代表性的投毒标签攻击。之后(Chen et al., 2017)提出中毒图片的隐身性应与其良性版本相似,并在此基础上提出了混合攻击(blended attack)。最近,(Xue et al., 2020; Li et al., 2020; 2021)进一步探索了如何更隐蔽地进行中毒标签后门攻击。最近,一种更隐形和有效的攻击,WaNet (Nguyen & Tran, 2021年)被提出。WaNet采用图像扭曲作为后门触发器,在变形的同时保留了图像内容。

干净标签攻击: 为了解决用户可以通过检查图像-标签关系来注意到后门攻击的问题,Turner等人(2019)提出了干净标签攻击范式,其中目标标签与中毒样本的原始标签一致。在(Zhao et al,2020b)中将这一思想推广到攻击视频分类中,他们采用了目标通用对抗扰动(Moosavi-Dezfooli et al., 2017)作为触发。尽管干净标签后门攻击比投毒标签后门攻击更隐蔽,但它们的性能通常相对较差,甚至可能无法创建后门(Li et al., 2020c)。

2.2 后门防御

现有的后门防御大多是经验性的,可分为五大类,包括

基于探测的防御(Xu et al,2021;Zeng et al,2011;Xiang et al,2022)检查可疑的模型或样本是否受到攻击,它将拒绝使用恶意对象。

基于预处理的防御(Doan et al,2020;Li et al,2021;Zeng et al,2021)旨在破坏攻击样本中包含的触发模式,通过在将图像输入模型之前引入预处理模块来防止后门激活。

基于模型重构的防御(Zhao et al,2020a;Li et al,2021;)是通过直接修改模型来消除模型中隐藏的后门。

触发综合防御(Guo et al,2020;Dong et al,2021;Shen et al,2021)是首先学习后门,其次通过抑制其影响来消除隐藏的后门。

基于中毒抑制的防御(Du et al,2020;Borgnia et al,2021)在训练过程中降低中毒样本的有效性,以防止隐藏后门的产生

2.3 半监督学习和自监督学习

半监督学习:在许多现实世界的应用程序中,标记数据的获取通常依赖于手动标记,这是非常昂贵的。相比之下,获得未标记的样本要容易得多。为了同时利用未标记样本和标记样本的力量,提出了大量的半监督学习方法(Gao et al.,2017;Berthelot et al,2019;Van Engelen & Hoos,2020)。最近,半监督学习也被用于提高模型的安全性(Stanforth et al,2019;Carmon et al,2019),他们在对抗训练中使用了未标记的样本。最近,(Yan et al,2021)讨论了如何后门半监督学习。然而,该方法除了修改训练样本外,还需要控制其他训练成分(如训练损失)。

自监督学习:自监督学习范式是无监督学习的一个子集,模型使用数据本身产生的信号进行训练(Chen et al,2020a;Grill et al,2020;Liu et al,2021)。它被用于增加对抗鲁棒性(Hendrycks et al,2019;Wu et al,2021;Shi et al,2021)。最近,一些文章(Saha et al,2021;Carlini & Terzis, 2021;Jia et al,2021)探索如何向自监督学习投入后门。然而,这些攻击除了修改训练样本外,它们还需要控制其他训练成分(例如,训练损失)。

3 后门特征

我们对CIFAR-10数据集(Krizhevsky, 2009)进行了BadNets和干净标签攻击。对有毒数据集进行监督学习以及对未标记数据集进行自监督学习SimCLR(Chen et al., 2020a)。

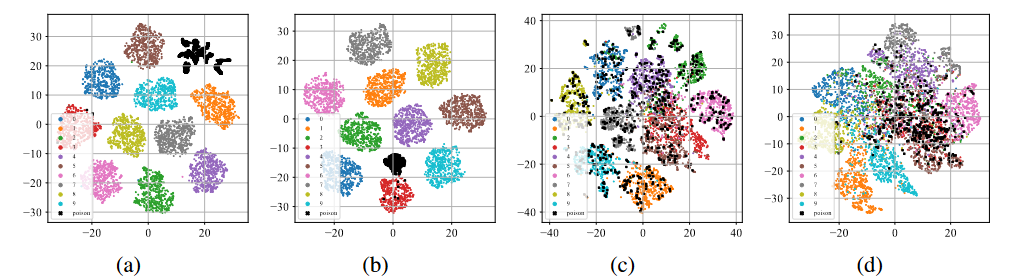

后门特征的t-sne展示

如上图(a)-(b)所示,在经过标准监督训练过程后,无论在投毒标签攻击还是干净标签攻击下,中毒样本(用黑点表示)都倾向于聚在一起形成单独的聚类。这种现象暗示了现有的基于投毒的后门攻击成功原因。过度的学习能力允许模型学习后门触发器的特征。与端到端监督训练范式相结合,模型可以缩小特征空间中中毒样本之间的距离,并将学习到的触发器相关特征与目标标签连接起来。相反,如上图(c)-(d)所示,在未标记的中毒数据集上,经过自监督训练过程后,中毒样本与带有原有标签的样本非常接近。这表明我们可以通过自监督学习来防止后门的产生。

4 基于分割的后门防御

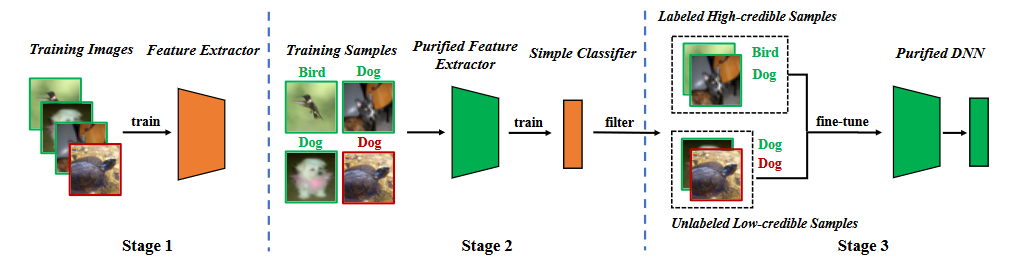

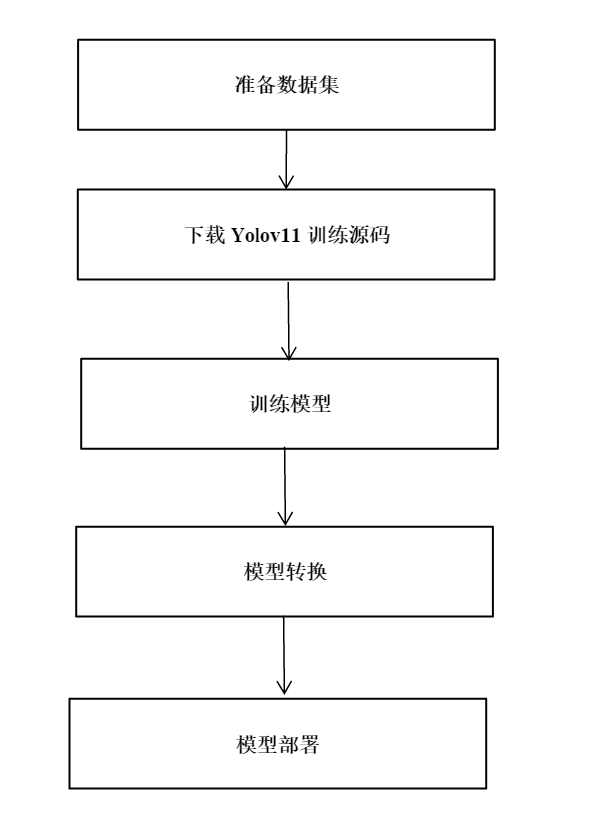

基于后门特征的分析,我们提出分割训练阶段的后门防御。如下图所示,它包括三个主要阶段,(1)通过自监督学习学习一个纯化的特征提取器,(2)通过标签噪声学习过滤高可信样本,(3)半监督微调。

方法流程图

4.1 学习特征提取器

我们用训练数据集 去学习模型。模型的参数 包含两部分,一部分是骨干模型(backbone model)的参数另一部分是全连接层(fully connected layer)的参数。我们利用自监督学习优化骨干模型的参数

其中是自监督损失(例如,NT-Xent在SimCLR (Chen et al,2020)). 通过前面的分析,我们可以知道特征提取器很难学习到后门特征。

4.2 标签噪声学习过滤样本

一旦特征提取器被训练好后,我们固定特征提取器的参数并用训练数据集进一步学习全连接层参数,

其中是监督学习损失(例如,交叉熵损失(cross entropy))。

虽然这样的分割流程会使得模型很难学到后门,但是它存在两个问题。首先,与通过监督学习训练的方法相比,由于学习到的特征提取器在第二阶段被冻结,预测干净样本的准确率会有一定的下降。其次,当中毒标签攻击出现时,中毒样本将作为“离群值”,进一步阻碍第二阶段的学习。这两个问题表明我们需要去除中毒样本,并对整个模型进行再训练或微调。

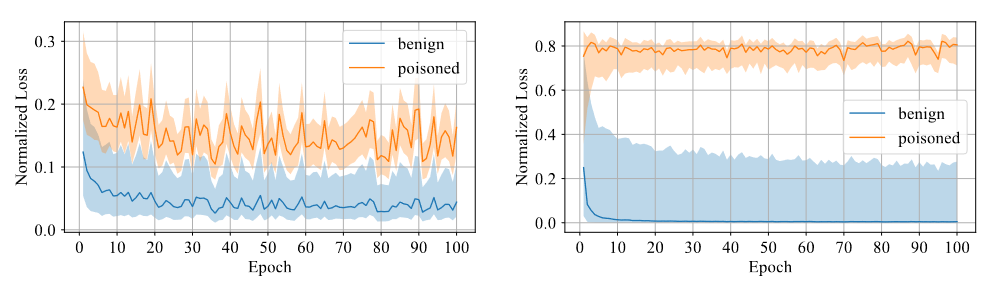

我们需要判断样本是否带有后门。我们认为模型对于后门样本难以学习,因此采用置信度作为区分指标,高置信度的样本为干净样本,而低置信度的样本为中毒样本。通过实验发现,利用对称交叉熵损失训练的模型对于两种样本的损失差距较大,从而区分度较高,如下图所示。

对称交叉熵损失和交叉熵损失对比

因此,我们固定特征提取器利用对称交叉熵损失训练全连接层,并且通过置信度的大小筛选数据集为高置信度数据和低置信度数据。

4.3 半监督微调

首先,我们删除低置信度数据的标签 。我们利用半监督学习微调整个模型 。

其中是半监督损失(例如,在MixMatch(Berthelot et al,2019)中的损失函数)。

半监督微调既可以避免模型学习到后门触发器,又可以使得模型在干净数据集上表现良好。

5 实验

5.1 数据集和基准

文章在两个经典基准数据集上评估所有防御,包括CIFAR-10 (Krizhevsky, 2009)和ImageNet (Deng等人,2009)(一个子集)。文章采用ResNet18模型 (He et al., 2016)

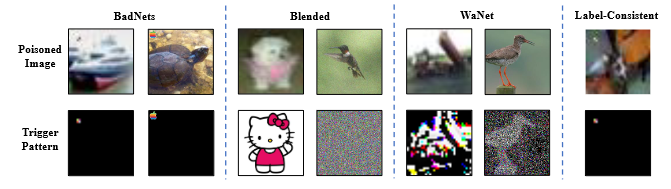

文章研究了防御四种典型攻击的所有防御方法,即badnets(Gu et al,2019)、混合策略的后门攻击(blended)(Chen et al,2017)、WaNet (Nguyen & Tran, 2021)和带有对敌扰动的干净标签攻击(label-consistent)(Turner et al,2019)。

后门攻击示例图片

5.2 实验结果

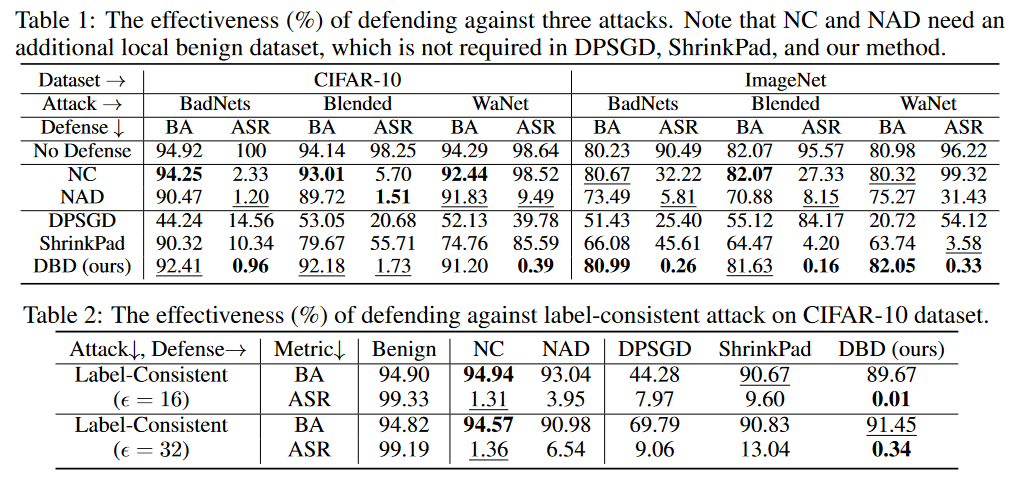

实验的判断标准为BA是干净样本的判断准确率和ASR是中毒样本的判断准确率。

后门防御对比结果

如上表所示,DBD在防御所有攻击方面明显优于具有相同要求的防御(即DPSGD和ShrinkPad)。在所有情况下,DBD比DPSGD的BA超过20%,而ASR低5%。DBD模型的ASR在所有情况下都小于2%(大多数情况下低于0.5%),验证了DBD可以成功地防止隐藏后门的创建。DBD与另外两种方法(即NC和NAD)进行比较,这两种方法都要求防御者拥有一个干净的本地数据集。如上表所示,NC和NAD优于DPSGD和ShrinkPad,因为它们采用了来自本地的干净数据集的额外信息。特别是,尽管NAD和NC使用了额外的信息,但DBD比它们更好。特别是在ImageNet数据集上,NC对ASR的降低效果有限。相比之下,DBD达到最小的ASR,而DBD的BA在几乎所有情况下都是最高或第二高。此外,与未经任何防御训练的模型相比,防御中毒标签攻击时的BA下降不到2%。在相对较大的数据集上,DBD甚至更好,因为所有的基线方法都变得不那么有效。这些结果验证了DBD的有效性。

5.3 消融实验

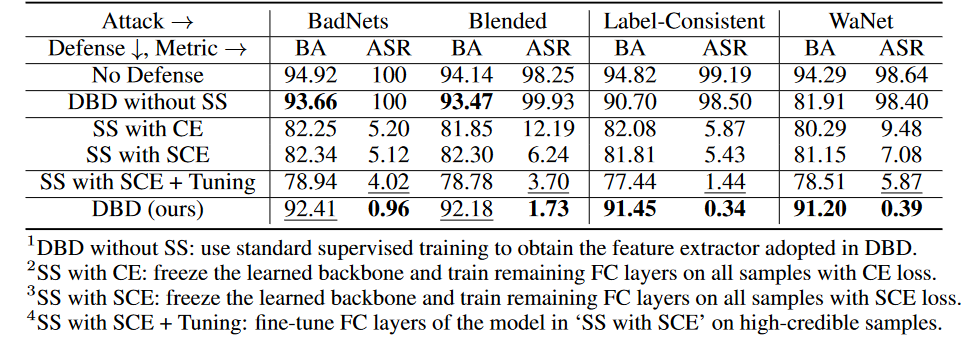

各阶段消融实验

在CIFAR-10数据集上,我们比较了提出的DBD及其四个变体,包括

DBD不带SS,将由自监督学习生成的骨干替换为以监督方式训练的主干,并保持其他部分不变

SS带CE,冻结了通过自监督学习学习到的骨干,并在所有训练样本上训练剩下的全连接层的交叉熵损失

SS带SCE, 与第二种变体类似,但使用了对称交叉熵损失训练。

SS带SCE + Tuning,进一步微调由第三个变体过滤的高置信度样本上的全连接层。

如上表所示,解耦原始的端到端监督训练过程在防止隐藏后门的创建方面是有效的。此外,比较第二个和第三个DBD变体来验证SCE损失对防御毒药标签后门攻击的有效性。另外,第4个DBD变异的ASR和BA相对于第3个DBD变异要低一些。这一现象是由于低可信度样本的去除。这表明,在采用低可信度样本的有用信息的同时减少其副作用对防御很重要。

5.4 对于潜在的自适应性攻击的抵抗

如果攻击者知道DBD的存在,他们可能会设计自适应性攻击。如果攻击者能够知道防御者使用的模型结构,他们可以通过优化触发模式,在自监督学习后,使中毒样本仍然在一个新的集群中,从而设计自适应性攻击,如下所示:

攻击设定

对于一个-分类问题,让代表那些需要被投毒的干净样本,代表原标签为的样本,以及是一个被训练的骨干。给定攻击者预定的中毒图像生成器,自适应性攻击旨在优化触发模式,通过最小化有毒图像之间的距离,同时最大化有毒图像的中心与具有不同标签的良性图像集群的中心之间的距离,即。

其中,是一个距离判定。

实验结果

自适应性攻击在没有防御的情况下的BA为94.96%,和ASR为99.70%。然而,DBD的防御结果为BA93.21%以及ASR1.02%。换句话说,DBD是抵抗这种自适应性攻击的。

6 总结

基于投毒的后门攻击的机制是在训练过程中在触发模式和目标标签之间建立一种潜在的连接。本文揭示了这种连接主要是由于端到端监督训练范式学习。基于这种认识,本文提出了一种基于解耦的后门防御方法。大量的实验验证了DBD防御在减少后门威胁的同时保持了预测良性样本的高精度。

审核编辑:郭婷

-

触发器

+关注

关注

14文章

2050浏览量

63033

原文标题:ICLR 2022 | DBD:基于分割后门训练过程的后门防御方法

文章出处:【微信号:CVer,微信公众号:CVer】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

你的手机在监听!国安部曝光境外芯片可能暗藏“后门”

单片机开发功能安全中编译器

在Ubuntu20.04系统中训练神经网络模型的一些经验

英伟达被约谈!“后门”风险阴影下,人脸识别终端为何选国产芯片

英伟达深夜发声:我们的芯片不存在后门,如何自证呢?

英伟达:我们的芯片不存监控软件 NVIDIA官方发文 NVIDIA芯片不存在后门、终止开关和监控软件

RK3576 yolo11-seg训练部署教程

国安部:境外产芯片或故意留“后门”

今日看点丨国安部:境外生产芯片可能留“后门” 摄像头被远程开启;英特尔终止了对 Clear Linux 的支持;宇

RK3576 yolov11-seg训练部署教程

数据标注服务—奠定大模型训练的数据基石

标贝数据标注服务:奠定大模型训练的数据基石

基于分割后门训练过程的后门防御方法

基于分割后门训练过程的后门防御方法

评论