AI 应用的部署正逐渐从服务器端走向移动终端和边缘端,覆盖了包括交通、医疗、巡检等等多个行业。从自动化业务流程和通过数据分析获得洞察力,AI 正在通过各种方式实现竞争优势。

如何让模型落地复杂的软硬件环境,并充分实现最优的推理效果,一直是 AI 从业者们追求和努力的方向。飞桨(PaddlePaddle)以百度多年的深度学习技术研究和业务应用为基础,集深度学习核心训练和推理框架、基础模型库、端到端开发套件、丰富的工具组件于一体,是中国首个自主研发、功能丰富、开源开放的产业级深度学习平台。

最近,NVIDIA 解决方案架构师张海军在百度飞桨 AI 部署月活动中发表了关于NVIDIA Jetson平台的演讲,接下来就让我们共同探索如何在 NVIDIA Jetson 平台上实现快速部署。

NVIDIA AI 平台和 Jetson 的力量

NVIDIA Jetson 平台适用于自主机器和其他嵌入式应用程序。该平台包括 Jetson 模组(外形小巧的高性能计算机)、用于加速软件的 NVIDIA JetPack SDK,以及包含传感器、SDK、服务和产品的生态系统,从而加快开发速度。Jetson 与其他 NVIDIA 平台上所用的相同 AI 软件和云原生工作流相兼容,并能为客户提供构建软件定义的自主机器所需的性能和能效。

-

Jetson Orin平台

借助功能强大的 AI 计算机,打造节能高效的新一代自主机器产品。与上一代相比,性能高达 8 倍,多个并发AI推理管道的 275 TOPS 算力,以及支持多个传感器的高速接口,是制造、物流、零售和医疗健康领域应用的理想解决方案。

-

Jetson Orin NX

Jetson Orin NX 以强大的功能和小巧的 Jetson 外形规格打造节能高效的自主机器。与 NVIDIA Jetson Xavier NX 相比,性能高达 5 倍,两倍的 CUDA 核心数,以及多个传感器的高速接口支持。Jetson Orin NX 具备支持多个并发 AI 推理管道的 100 TOPS 算力,外形紧凑,性能出色。

-

Jetson Orin Nano

NVIDIA Jetson Orin 系列模组外形小巧,但可提供高达 40 TOPS 的 AI 性能,功率可在 5 瓦到 15 瓦之间进行选择。这为您提供了高达 NVIDIA Jetson Nano 80 倍的性能,并为入门级边缘 AI 设定了新的基准。

-

Jetson 软件

所有的 Jetson 模组均由同一软件堆栈提供支持,因此只需一次开发,即可在任意地方部署。Jetson 平台由强大的 Jetson 软件堆栈提供支持,旨在为 AI 应用程序提供端到端加速,并加快上市速度。NVIDIA 提供强大的技术,赋能数据中心和从云到边缘的部署。

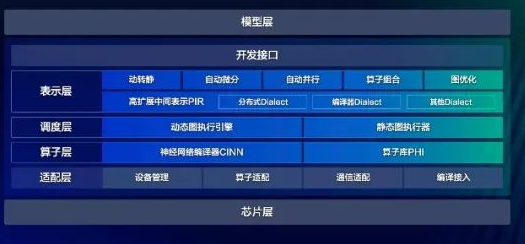

FastDeploy 及 Jetson 部署方案

FastDeploy是一款覆盖视觉、语言、语音全场景的 AI 推理部署套件,使深度学习推理部署更简单、更高效。FastDeploy 可以针对产业落地场景中的重要 AI 模型,在不同的硬件环境下,支持开发者下载已经预编译好的多种 SDK,开发者参考文档,简单几步即可完成 AI 模型的部署,大幅降低部署难度和时间成本。

-

全场景

FastDeploy支持 Paddle Inference、TensorRT、ONNX Runtime、Poros 等推理后端,覆盖常见的 NVIDIA GPU、Jetson Nano、Jetson TX2、Jetson AGX、Jetson Orin 等云边端场景全系列 NVIDIA 硬件部署。同时支持服务化部署、离线部署、端侧部署方式。针对不同硬件,统一 API 保证一套代码在数据中心、边缘部署和端侧部署无缝切换。

-

简单易用

FastDeploy 的 API 设计为确保不同语言的开发者能够享受到统一的 API 体验,不同语言的代码只都只需要 3 行核心代码,就可以实现预知模型的高性能推理,极大降低了 AI 模型部署难度和工作量。一行命令切换 TensorRT、Paddle Inference、ONNX Runtime、Poros 等不同推理后端和对应硬件,充分利用可推理引擎在 GPU 硬件上的优势。

-

极致高效

FastDeploy 集成自动压缩工具,在参数量大大减小的同时(精度几乎无损),推理速度大幅提升。使用 CUDA 加速优化预处理和后处理模块,端到端的优化策略,彻底解决 AI 部署落地中的性能难题。

在 FastDeploy 上快速部署 Jetson:

-

几行 Python 代码完成部署

-

几行 C++ 代码完成部署

-

OCR 模型部署

-

NLP 模型部署

-

编译和安装

-

编译选项,减小包体积

-

一行代码切换不同硬件/后端

-

一键压缩和量化 PTQ

-

一键压缩和量化 QAT

-

预处理优化

Jetson 生态环境及客户成功案例

每个 NVIDIA Jetson 都是一个完整的系统模组 (SOM),其中包括 GPU、CPU、内存、电源管理和高速接口等。不同性能、能效和外形规格的组合满足各类行业的客户所需。Jetson 生态系统合作伙伴提供软件、硬件设计服务以及涵盖载板到完整系统的现成兼容产品,因此可以借助 AI 嵌入式边缘设备更快地打入市场。

图为科技打造的 AI 边缘计算机系列产品采用图为 T906 边缘计算机和百度算法相结合,构建了多种场景的边缘计算解决方案。图为 T906是一款基于NVIDIA Jetson AGX Orin系列模块的边缘计算机,使用FastDeploy在图为 T906 边缘计算机上可实现快速部署,多种算法,超长 MTBF,稳定运行 7x24 小时不间断工作。

原文标题:百度飞桨AI部署月,看NVIDIA Jetson平台如何快速部署

文章出处:【微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

-

英伟达

+关注

关注

23文章

4040浏览量

97675

原文标题:百度飞桨AI部署月,看NVIDIA Jetson平台如何快速部署

文章出处:【微信号:NVIDIA_China,微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

百度世界大会亮点 五年五芯 百度宣布打造最硬AI云

如何在NVIDIA Jetson AGX Thor上通过Docker高效部署vLLM推理服务

百度世界2025进行中 百度昆仑芯超节点亮相 性能巨幅提升

BPI-AIM7 RK3588 AI与 Nvidia Jetson Nano 生态系统兼容的低功耗 AI 模块

如何在基于Arm架构的边缘AI设备上部署飞桨模型

百度智能云亮相第二十二届ChinaJoy

Arm方案 基于Arm架构的边缘侧设备(树莓派或 NVIDIA Jetson Nano)上部署PyTorch模型

百度地图重磅发布地图AI开放平台

百度在AI领域的最新进展

百度飞桨框架3.0正式版发布

百度飞桨AI部署月,看NVIDIA Jetson平台如何快速部署

百度飞桨AI部署月,看NVIDIA Jetson平台如何快速部署

评论