数据处理当然不是一个新概念,算法也不是。然而,算法被训练和运行的地方正在迅速发展。近年来,机器学习(ML)算法的训练基本上是在云环境中进行的,因为能够利用临时计算资源来执行这些数据密集型任务。

如今,人们大力推动尽可能靠近源头处理数据。这是由于物联网(IoT)和现在正在生成大量数据的各种技术的出现。所有这些数据都让组织争先恐后地以经济高效的方式充分利用它。组织需要考虑从原始源到处理位置的数据传输成本,以及存储和处理数据的成本,这通常是在资源密集型服务器/云环境中。

人工智能 (AI) 技术开始出现,可以在低计算功率设备(如基于 ESP32 和 Cortex M4 的微控制器单元 (MCU))上实现 ML 模型训练和执行,而不是更大的微处理器单元 (MPU)。这允许数据保持本地,并且仅在必要时在云中传输已处理的数据。

通过将训练和运行 ML 模型的总体占用空间要求降低到 100kb 以下,嵌入式计算中的 AI 正在进入一个新的领域。例如,与合并排序算法相比,嵌入式算法工程师更欢迎气泡排序算法,因为前者使用现有内存。尽管已经存在许多算法,但正在针对嵌入式环境开发和优化新的基于AI的时间序列预测算法。通过这种新方法,AI/ML模型在嵌入式板上进行训练。然后,这些模型用于在执行期间执行多变量统计推断。

这些新的基于AI的时间序列预测算法有三个优点:

该解决方案与网络延迟无关,因为计算是在本地板上进行的,因此性能得到了提高。

原始数据的安全/隐私得到保证,因为原始信号/数据只出现在本地。

对于每个嵌入式板,都会训练一个新的 ML/AI 模型。这可能是这种方法的核心优势,因为在典型的工业案例中,由于环境变体、传感器的缺陷和机器变体,不可能使用单个 ML/AI 模型来覆盖机器特征集群。使用云服务器为每个嵌入式板训练模型也不是负担得起的。

技术突破

算法在嵌入式计算中发挥着重要作用。通常,嵌入式设备执行的算法任务包括传感器数据清理/过滤、数据编码/解码和控制信号生成。由于内存容量、CPU 功率和架构不同,嵌入式计算环境中“最佳算法”的定义可能与 PC 和云服务器中“最佳算法”的定义大不相同。

在过去的几年里,AI/ML算法取得了突破和非常迅速的进步。许多努力都集中在将AI / ML模型(这些模型在其他地方训练)引入嵌入式上下文。换句话说,要成功部署 AI/ML 模型,需要优化算法的内存/CPU 使用率和功耗。

人工智能正在缩小,可以运行这些高级算法。技术进步现在允许人工智能和预测性维护从基于 MPU 的设备转向基于 MCU 的设备,占用空间小,价格显著降低。基于 MCU 的设备现在可以在网络边缘执行以前仅在 MPU 上提供的任务(例如预测性维护)。这一新功能使芯片制造商、原始设备制造商 (OEM) 和智能设备制造商能够降低成本并提供差异化的产品。

审核编辑:郭婷

-

处理器

+关注

关注

68文章

20148浏览量

247107 -

mcu

+关注

关注

147文章

18605浏览量

386965 -

物联网

+关注

关注

2939文章

47317浏览量

407813

发布评论请先 登录

【「AI芯片:科技探索与AGI愿景」阅读体验】+AI芯片到AGI芯片

【「AI芯片:科技探索与AGI愿景」阅读体验】+第二章 实现深度学习AI芯片的创新方法与架构

AI 边缘计算网关:开启智能新时代的钥匙—龙兴物联

边缘智能网关在水务行业中的应用—龙兴物联

超小型Neuton机器学习模型, 在任何系统级芯片(SoC)上解锁边缘人工智能应用.

海思SD3403边缘计算AI数据训练概述

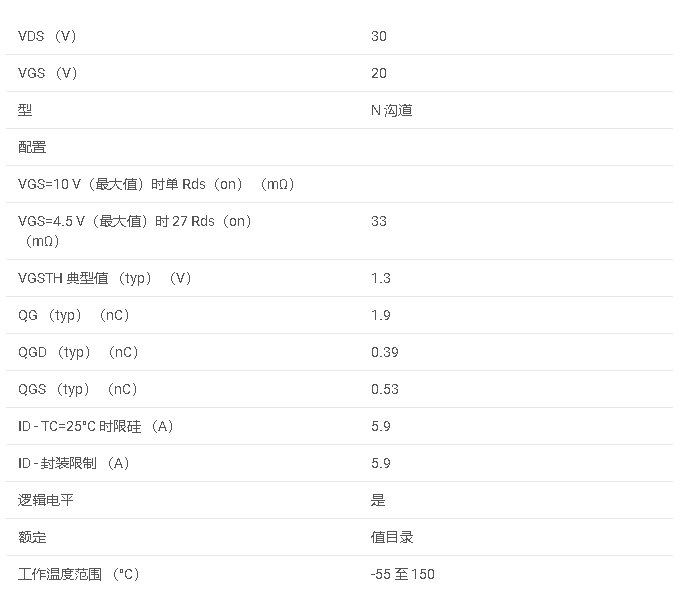

CSD17585F5 30V、N 通道 NexFET™ 功率 MOSFET、单个 LGA 0.8mm x 1.5mm、33mOhm、栅极 ESD 保护数据手册

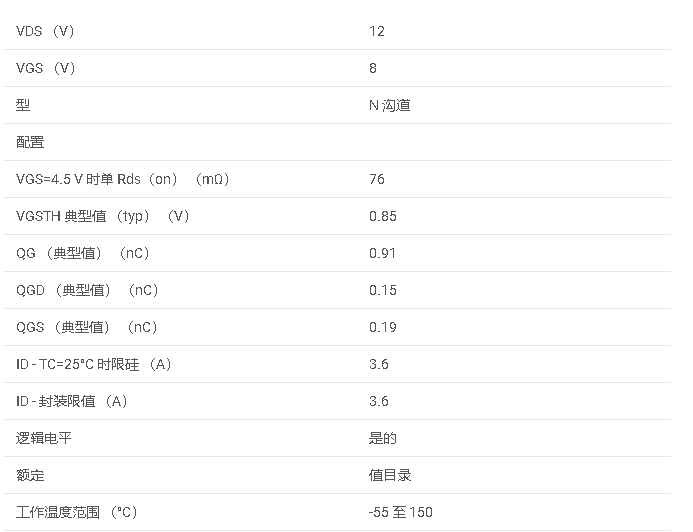

CSD13380F3 12V、N 通道 NexFET™ 功率 MOSFET、单个 LGA 0.6mm x 0.7mm、76mOhm、栅极 ESD 保护技术手册

适用于数据中心和AI时代的800G网络

AI赋能边缘网关:开启智能时代的新蓝海

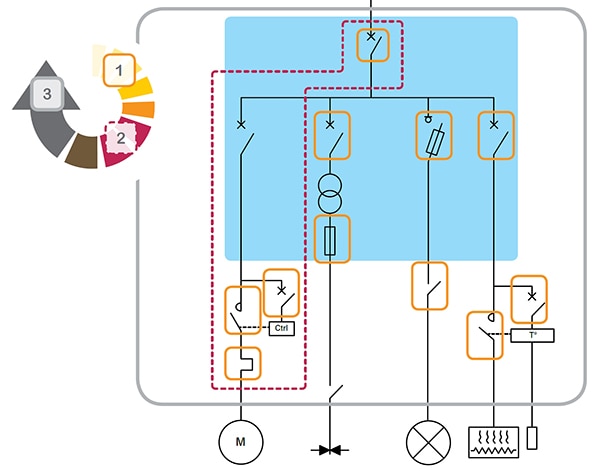

智能电机控制装置如何最大限度地提高恢复能力和正常运行时间

AN101-最大限度地减少线性稳压器输出中的开关稳压器残留

最大限度地减少算法占用空间并在AI网络边缘进行训练

最大限度地减少算法占用空间并在AI网络边缘进行训练

评论