在深度学习产业落地过程中,我们经常能听到一种说法——模型部署是打通AI应用的最后一公里!想要走通这一公里,看似简单,但是真正实践起来却困难重重:显卡利用率低、内存溢出、多线程调度奔溃、TensorRT加速算子不支持等等问题一直是深度学习模型最后部署的老大难问题。

在工业制造环境中,Windows系统有着广泛的应用。为了更好的帮助工业用户解决落地最后的一公里问题,飞桨联合产业用户,基于Windows系统,提供了工业级的部署Demo,支持图像分类、目标检测、实例分割和语义分割模型的部署,并提供了一键的TensorRT加速方式,极大的提升了部署的效率,同时支持多线程推理的方式,满足了用户多视频输入预测的需求!

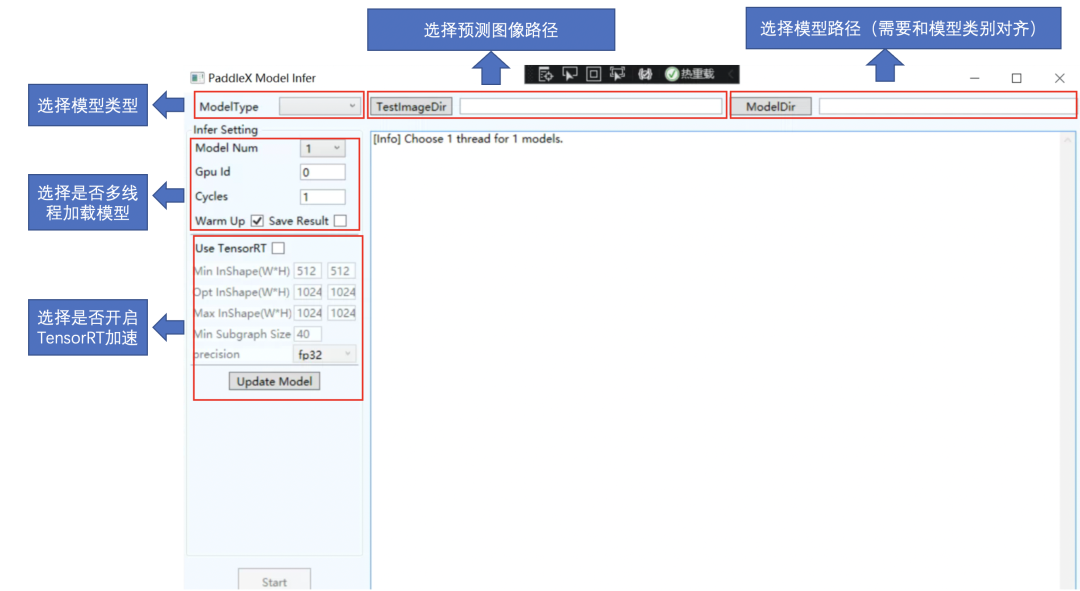

图1部署开发示例说明

部署Demo地址,欢迎大家star收藏。

https://github.com/PaddlePaddle/PaddleX/tree/develop/deploy/cpp/docs/csharp_deploy

支持多种类别模型部署

满足多种场景需求

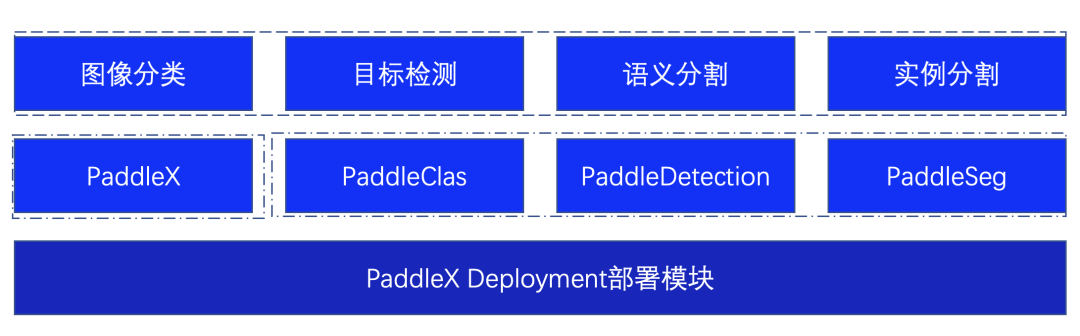

为了更好的满足用户多种视觉任务场景,部署Demo基于PaddleX的Deployment模块进行二次开发,不仅仅支持对PaddleX自身训练的模型进行推理,同时支持PaddleClas、PaddleDetection、PaddleSeg视觉开发套件的模型,满足多种场景需求。

图2 部署Demo支持模型说明

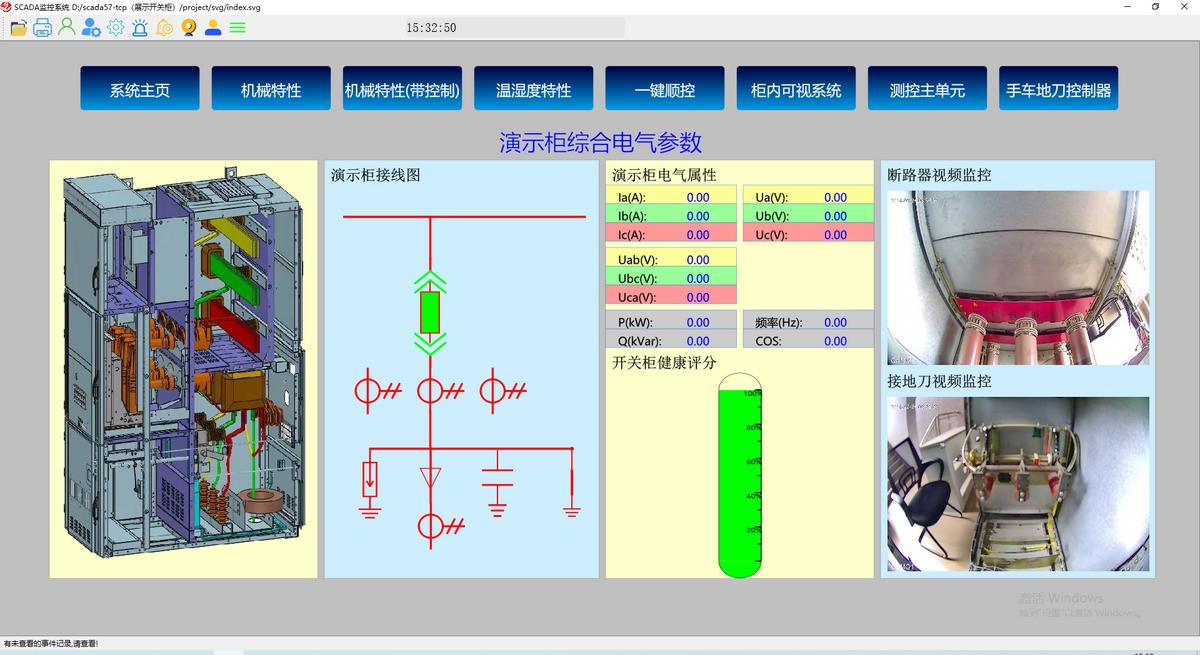

一键TensorRT加速

部署效率显著提升

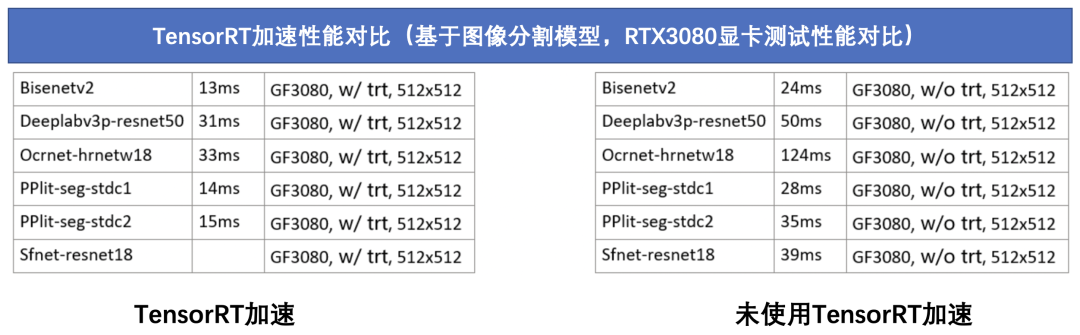

NVIDIA TensorRT 是一个高性能的深度学习预测库,可为深度学习推理应用程序提供低延迟和高吞吐量。在部署Demo中集成了TensorRT预测库,用户只需一键启动,即可进行高性能的部署。

图3 部署Demo性能对比说明

为了更好的帮助用户了解在工业制造场景部署的问题,飞桨邀请产业用户现场coding,一步步带着大家现场演示如何搭建部署开发示例,如何更高性能的应用在自己的产业落地中。

审核编辑 :李倩

-

多线程

+关注

关注

0文章

279浏览量

20913 -

工业制造

+关注

关注

0文章

438浏览量

28682

原文标题:TensorRT加速、多线程部署,打通工业高性能部署最后一公里

文章出处:【微信号:mcugeek,微信公众号:MCU开发加油站】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

DP1323EL的电动车解锁方案:超高速读写,提升电动车一键解锁体验

基于DP1323EL的电动车解锁方案:超高速读写,提升电动车一键解锁体验

一键开关机芯片GEK100,替代 ADI 的 MAX16169和MAX16054

如何在魔搭社区使用TensorRT-LLM加速优化Qwen3系列模型推理部署

LoRa无线一键报警安防建设方案

开关柜一键顺控在一键停电、一键送电中的作用

一键升降,智控热重!南京大展DZ-TGA201升降热重新品上市

设备管理系统如何实现一键智控?

如何保障10KV开关柜的一键顺控技术的安全性?

石油行业中,开关柜一键顺控的作用

一键的TensorRT加速方式,极大的提升了部署的效率

一键的TensorRT加速方式,极大的提升了部署的效率

评论