在模型开发和部署方面,极市平台集成了最新版本的OpenVINO工具,助力开发者在最小化代码修改的条件下加速AI算法在各类生产环境中规模化部署应用,尤其是在Intel丰富的硬件资源平台上(CPUs、iGPUs、VPUs等等)。

本文重点介绍了极视角与英特尔开发人员共同研发的OpenVINO最新功能,无缝集成TensorFlow框架,对于熟悉TensorFlow开发的开发者来说,在原有代码的基础上只需要添加几行简单代码就可以无痛实现模型精度不变的前提下推理加速1.34倍以上,避免了显式地进行OpenVINO转换以及推理部分代码的重新编写,大大简化OpenVINO工具的使用,加速AI算法在生产环境中的应用部署。

无痛实现 1.34 倍加速推理

我们先来看看本文方法在模型推理加速上具体表现:

可以看到,在同一测试环境下,OpenVINO 与 TensorFlow 的集成实现了 1.34 的加速几何平均值,同时,模型的准确性保持不变:

具体实操

OpenVINO 与 TensorFlow 的集成专为使用 OpenVINO 工具套件的开发人员而设计——通过最少的代码修改来提高推理应用程序的性能。该集成为提高TensorFlow 兼容性提供以 OpenVINO 工具套件内联优化和所需运行时,并加速了各种英特尔芯片上多类AI模型的推理。

通过将以下两行代码添加到 Python 代码或 Jupyter Notebooks 中,就可以极大地加速你的 TensorFlow 模型的推理:

import openvino_tensorflowopenvino_tensorflow.set_backend(‘《backend_name》’)

OpenVINO 与 TensorFlow 的集成通过将 TensorFlow 图巧妙地划分为多个子图,再将这些子图分派到 TensorFlow 运行时或 OpenVINO 运行时,从而实现最佳加速推理。

# 工作流概述

同时,通过 openvino_tensorflow ,我们能够非常轻松地使用不同硬件:

更多的详细信息可以前往 Github:

https://github.com/openvinotoolkit/openvino_tensorflow

# 在Extreme Vision notebooks中集成

在Extreme Vision IDE中可以直接将OpenVINO与TensorFlow集成。如下图所示,你只需要简单地导入openvino_tensorflow,即可无缝加速 Jupyter Notebook 中在CPU上推理的所有 TensorFlow模型,同时可以继续使用标准的TensorFlow API,而无需代码重构。

对推理加速更深的讨论

从前文对推理加速上的结果展示中,我们可以看到通过添加 2 行代码激活OpenVINO与 TensorFlow 的集成后,可以获得最高达 10 倍的推理加速。但也有个别模型出现了异常情况,如Mask RCNN Atrous 和 SSD Mobilenet V2,因此我们对如何获得最佳性能进行了讨论:

#01

OPENVINO_TF_MIN_NONTRIVIAL_NODES 变量

该变量设置了聚类中可以存在的最小操作数。如果操作数小于指定的数量,则聚类将回退到 TensorFlow。默认情况是根据总图大小计算的,但除非手动设置,否则不能小于 6。另外,我们将此变量设置为 15 和 22 来观察模型进一步的性能增强,并以此得到了最终的最佳推理性能。因此,在具体的开发应用中应通过默认值或实验来确定能够为模型提供最佳性能的变量最佳值。

#02

冻结 Keras 模型以获得最佳性能

一些 Keras 模型可能包含训练操作,这会导致 TensorFlow 产生控制流。由于 OpenVINO 工具套件不支持这些操作,因此图形可能会被划分为较小的聚类。因此,在使用 OpenVINO 与 TensorFlow 的集成时,冻结模型可以避免这些操作并提高整体性能。

使用 Keras API 的 DenseNet121 推理应用代码示例:

import tensorflow as tffrom tensorflow import kerasfrom tensorflow.keras.applications.densenet import DenseNet121# Add two lines of code to enable OpenVINO integration with TensorFlowimport openvino_tensorflowopenvino_tensorflow.set_backend("CPU")model = DenseNet121(weights='imagenet')# Run the inference using Keras APImodel.predict(input_data)

下面是冻结和运行 Keras 模型的一个示例代码,通过这种方式,我们能够优化使用 OpenVINO 与 TensorFlow 的集成实现的最佳性能。

import tensorflow as tffrom tensorflow import kerasfrom tensorflow.keras.applications.densenet import DenseNet121from tensorflow.python.framework.convert_to_constants import convert_variables_to_constants_v2# Add two lines of code to enable OpenVINO integration with TensorFlowimport openvino_tensorflowopenvino_tensorflow.set_backend("CPU")model = DenseNet121(weights='imagenet')# Freeze the model first to achieve the best performance# using OpenVINO integration with TensorFlowfull_model = tf.function(lambda x: self.model(x))full_model = full_model.get_concrete_function(tf.TensorSpec(model.inputs[0].shape,model.inputs[0].dtype, name=model.inputs[0].name))frozen_func = convert_variables_to_constants_v2(full_model)frozen_func.graph.as_graph_def()session = tf.compat.v1.Session(graph=frozen_func.graph)prob_tensor = frozen_func.graph.get_tensor_by_name(full_model.outputs[0].name)# Run the inference on the frozen modelsession.run(prob_tensor, feed_dict={full_model.inputs[0].name : input_data})

#03

Mask RCNN Atrous和SSD Mobilenet

如上文的结果所示,OpenVINO与TensorFlow的集成可以加速大多数TensorFlow模型,但由于一些模型具有OpenVINO与TensorFlow集成尚不完全支持的工作组件(例如运算符、层等),如Mask RCNN Atrous和SSD Mobilenet V2等一些模型仍在开发完善中。

为了扩大模型覆盖范围以及进一步提升性能,极视角技术团队将会继续测试和完善OpenVINO与TensorFlow的集成,以帮助更多使用TensorFlow开发人员能够更好地应用极市平台。

编辑:jq

-

API

+关注

关注

2文章

2147浏览量

66237 -

SSD

+关注

关注

21文章

3061浏览量

121784 -

AI

+关注

关注

89文章

38091浏览量

296594 -

代码

+关注

关注

30文章

4941浏览量

73148

原文标题:英特尔OpenVINO™ 助力极视角AI推理加速

文章出处:【微信号:英特尔物联网,微信公众号:英特尔物联网】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

英特尔Gaudi 2E AI加速器为DeepSeek-V3.1提供加速支持

硬件与应用同频共振,英特尔Day 0适配腾讯开源混元大模型

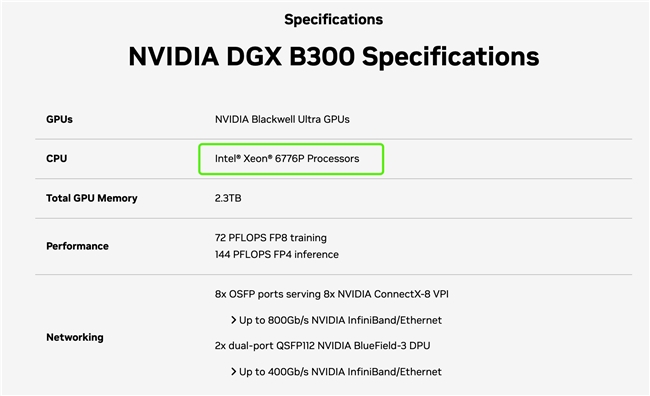

主控CPU全能选手,英特尔至强6助力AI系统高效运转

使用英特尔® NPU 插件C++运行应用程序时出现错误:“std::Runtime_error at memory location”怎么解决?

直击Computex 2025:英特尔重磅发布新一代GPU,图形和AI性能跃升3.4倍

直击Computex2025:英特尔重磅发布新一代GPU,图形和AI性能跃升3.4倍

英特尔发布全新GPU,AI和工作站迎来新选择

为什么无法检测到OpenVINO™工具套件中的英特尔®集成图形处理单元?

请问OpenVINO™工具套件英特尔®Distribution是否与Windows® 10物联网企业版兼容?

安装OpenVINO™适用于Raspberry Pi64位操作系统的工具套件2022.3.1,配置英特尔®NCS2时出错怎么解决?

英特尔OpenVINO 2025.0正式发布

英特尔OpenVINO™将全力助力极视角AI推理加速

英特尔OpenVINO™将全力助力极视角AI推理加速

评论