幻觉被描述为无意义或不忠实于所提供源内容的生成内容。根据与源内容的矛盾,这些幻觉又进一步分为内在幻觉....

纵轴是"Bits for words", 这也是交叉熵的一个单位。在计算交叉熵时,如果使用以 2 为....

对以ChatGPT为代表的LLMs在共情回复生成上的表现进行了全面的实证研究,LLMs在现有的基准数....

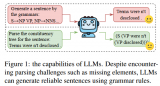

最近,上下文学习策略已被证明在没有训练的情况下显示出显著的结果。很少有研究利用上下文学习进行zero....

LLM的训练分为预训练和安全训练。预训练是指在大规模语料库上进行训练,因此LLM获得了各种强大的能力....

经典 Transformer 使用不可学习的余弦编码,加在模型底层的词向量输入上。GPT、BERT将....

没得商量,不做RL了,选择性保留RM:比如RRHF、DPO,这类方法可以直接在RM数据上优化语言模型....

MFTCoder具备高效训练特征,包括提供高效的数据Tokenization模式和支持PEFT微调,....

同行评审对于确保科学的高质量至关重要:作者提交研究成果,而审稿人则辩论应不应该接受其发表。通常评审后....

尽管鲁迅先生曾言:真的强化敢于直面惨淡的结果,敢于正视崩坏的曲线。但日复一复地开盲盒难免会让人心脏承....

简介章节讲的是比较基础的,主要介绍了本次要介绍的概念,即检索(Retrieval)和大语言模型(LL....

传统的计算系统是围绕计算机程序中表达的指令的执行来设计的。相反,语言模型可以遵循用自然语言表达的指令....

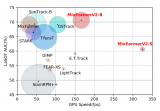

我们通过简洁有效的模型结构设计和高效的基于知识蒸馏的模型压缩,对于现有的 MixFormer 模型进....

采用伯克利神经解析器(Berkeley Neural Parser)作为方法的基础。该解析器是一种基....

进一步地,提出了Cross-Lingual Self-consistent Prompting (C....

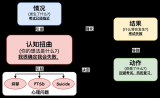

可以看出认知扭曲本身虽然往往和负面情绪相关,但其更多是强调不合理的负面情绪,这些负面情绪的形成和加强....

在大模型时代,向量模型的重要性进一步增强。尤其是在检索增强生成(RAG)场景中,它成为了一个核心组件....

我们参加了 DSTC11-track5 并在所有 14 个参赛队伍中排名第三(客观指标),其中 Tu....

大模型混合多种能力项数据进行微调时,会呈现高资源冲突,低资源增益的现象。我们提出的DMT策略通过在第....

但LLEMMA的出现改变了这一局面。它不仅在MATH基准测试上创下了新高,甚至超越了某些还未对外公开....

今年,以 ChatGPT 为首的大语言模型(Large Language Models, LLMs)....

目前的Transformer位置编码方法,有绝对位置编码(将位置信息融入到输入)、相对位置编码(将位....

DISC-LawLLM是基于我们构建的高质量数据集DISC-Law-SFT在通用领域中文大模型Bai....

模型压缩涉及将大型资源密集型模型转化为适合在受限移动设备上存储的紧凑版本。此外,它还可以优化模型以实....

语音和图像为用户在生活中使用 ChatGPT 提供了更多方式。旅行时,拍下地标性建筑的照片,然后就它....

其中最后一个表示监督信号是从图像本身中挖掘出来的,流行的方法包括对比学习、非对比学习和masked ....

而这一切的背后,是一项名为Sorted Fine-Tuning(SoFT)的新训练技术。SoFT让我....

a16z是硅谷一家有名的投资机构,近期发布了他们根据月浏览量统计的TOP50 GenAI产品,并给出....

由于固有的模态缺口,如CLIP语义主要关注模态共享信息,往往忽略了可以增强多模态理解的模态特定知识。....

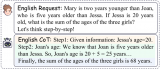

一个在推上测试Phi-1.5的例子引发了众多讨论。例如,如果你截断下图这个问题并输入给Phi-1.5....