这种“幻觉”现象可能是无意中产生的,它可以由多种因素导致,包括训练数据集中存在的偏见、模型不能获取最....

语言模型能够执行各种任务,包括根据一组图像创作引人入胜的故事,比较多个图像中的共同和不同之处,用生动....

使用领域适应技术对预训练LLM进行微调可以提高在特定领域任务上的性能。但是,进行完全微调可能会很昂贵....

要理解大语言模型(LLM),首先要理解它的本质,无论预训练、微调还是在推理阶段,核心都是next t....

大模型是一个实验工程,涉及数据清洗、底层框架、算法策略等多个工序,每个环节都有很多坑,因此知道如何避....

ByteDance Research 也在进行 AI for Science 的研究,包括机器学习与....

近期,一支来自中国的研究团队正是针对这些问题提出了解决方案,他们推出了FLM-101B模型及其配套的....

但,这种前提是「充分训练」,如果只看训练前期的话,使用更长的预热步数(黄色的线)。无论是「上游任务」....

目前,单流架构模型在视频分类、情感分析、图像生成等多模态领域中得以广泛应用,单流模型具有结构简单、容....

从 GPT-3,Gopher 到 LLaMA,大模型有更好的性能已成为业界的共识。但相比之下,单个 ....

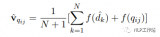

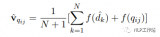

用LLM根据用户query生成k个“假答案”。(大模型生成答案采用sample模式,保证生成的k个答....

OpenAI 研究科学家 Andrej Karpathy 前段时间在微软 Build 2023 大会....

如图所示,在RLAIF中,首先使用LLM来评估给定的文本和2个候选回复,然后,这些由LLM生成的偏好....

为了解决在插值RoPE嵌入时丢失高频信息的问题,[4]中开发了"NTK-aware"插值。与同样乘以....

Transofrmer一个常见的自监督目标是遮罩文本中出现的单词,将该位置的query, key和v....

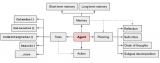

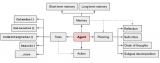

智能代理(AI Agents)长期以来都被视为通往人工通用智能(AGI)的一条希望途径,预期中其能够....

现有的文本嵌入表示方法在应用到新的任务或领域时,通常性能都会受损,甚至应用到相同任务的不同领域也会遇....

对于位置编码,常规的做法是在计算 query,key 和 value 向量之前,会计算一个位置编码向....

减轻幻觉问题并开发用于衡量幻觉的度量标准是一个蓬勃发展的研究课题。有许多初创公司专注于解决这个问题。....

首先团队发现,目前已有的长下文外推方法普遍都是通过修改注意力机制中使用的位置编码系统,指示token....

虽然目前学术界和工业界都在不断推出自家的各种基座模型,但不可否认的是,完全预训练一个具有初等推理能力....

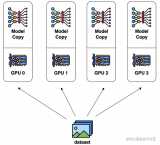

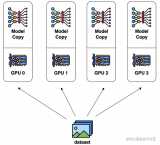

数据并行是最常见的并行形式,因为它很简单。在数据并行训练中,数据集被分割成几个碎片,每个碎片被分配到....

答案是不会。原因是LLM作为语言模型,它的注意力机制是一个单向注意力机制(通过引入 Masked A....

用户使用MathGPT时,用文字或图片方式上传数学题,即可得到对话式的解答反馈,也可以通过“随机来一....

从结构化数据中自然语言生成(NLG)往往会产生多种错误,从而限制了这些模型在面向客户的应用中的实用性....

这对知识表示领域来说是一个巨大的步骤。长时间以来,人们关注的是明确的知识,例如嵌入在文本中的知识,有....

OpenAI所选择的路径就是:「Turn compute into alignment」,通过计算的....

Meta 发布的 Llama 2,是新的 SOTA 开源大型语言模型(LLM)。Llama 2 代表....

因此,我们认为现在是时候审视个性化服务的挑战以及用大型语言模型来解决它们的机会了。特别是,我们在这篇....

这个方法之所以有效,是因为均匀分布帮助我们将Mq(x)提供的“封包”缩放到p(x)的概率密度函数。另....