研究了半天人工神经网络,还不如复制粘贴动物的答案?

最近一段时间,有关摩尔定律终结的讨论时常出现,深度学习越来越高的算力需求与芯片制造厂商们「挤牙膏」式的换代速度产生了不可调和的矛盾。对此,一些研究者们正在专注于常规架构的效率提升,也有一些研究者把目光转向于常规计算机体系之外,如光电计算、类脑计算,以及量子计算等方向。

现在,又有人想在动物身上寻找思路。在 1 月 13 日刚刚放榜的人工智能顶级会议ICLR 2021上出现了这样一篇论文:研究者们「黑」进了果蝇的神经网络,用它来跑 NLP 算法,结果发现性能与常规人工神经网络相当,而且非常节约能耗。

这一通操作仿佛打开了新世界的大门。

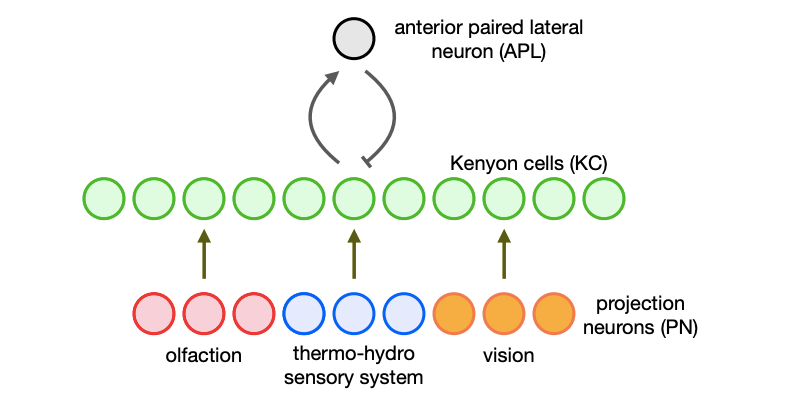

神经科学中研究最深入的网络之一是果蝇的大脑,尤其是称为蘑菇体的部分。该部分能够分析气味、温度、湿度和视觉数据等感官输入,以便于果蝇学会区分友好刺激和危险刺激。神经科学家表示果蝇大脑的这一部分是由一组称为投射神经元的细胞组成,这些细胞将感觉信息传递给 2000 个称为 Kenyon 细胞(简称KC)的神经元,Kenyon 细胞连接在一起形成能够学习的神经网络。这让果蝇在学习接近食物、潜在伴侣等时候,学会避免潜在的有害感官输入(例如危险的气味和温度)。

这个相对较小的网络具备的功能和灵活性让神经科学家们好奇:是否可以对其进行编程以解决其他任务?

在伦斯勒理工学院、MIT-IBM Watson AI Lab 的研究者进行的一项入侵果蝇大脑网络的研究中,人们成功地在生物大脑中执行了自然语言处理等任务。这是自然界的神经网络第一次以这种方式被征用。研究者表示这个生物大脑网络与人工学习网络的性能相当,但使用的计算资源却更少。

这种方法相对简单直接,该团队首先使用计算机程序重建蘑菇体所依赖的网络,大量神经元将数据提供给大约 2000 个 Kenyon 细胞。然后研究者训练了该网络以识别文本中词之间的相关性。该任务基于的思想是:一个词可以通过其语境或通常在其附近出现的其他词来表征。该想法首先从一个文本语料库开始,然后面向每一个词,分析出现在该词前后的其他词。

这样机器学习系统可以在给定已经出现的词的情况下预测句子中下一个词。许多系统(例如 BERT)都使用这种方法来生成看起来自然的句子,该研究也采用了这种方法。事实证明即使自然界的网络完全不是基于这一目的进化的,但它也非常擅长这种方式。该研究表明该网络可以学习词的语义表征。

研究者表示,果蝇的大脑网络可与现有的自然语言处理方法相媲美,并且最重要的是生物网络仅使用很少一部分计算资源。这意味着它仅使用较少的训练时间和内存占用量。

生物的效率

这是一个有趣的结果。「我们把这样的结果视为生物启发算法普适性的一个范例,其与传统的非生物算法相比更具效率,」该论文的作者 Yuchen Liang 等人说道。

这项工作除了展示生物计算的效率,还提出了一些有趣的问题。其中最明显的就是:为什么生物神经网络计算是如此的高效?当然按照进化的理论,自然界会选择效率更高的神经网络存留下来,但在论文中,研究者们尚未对 Kenyon 细胞为何具有高效率提出自己的看法。

这项工作显然也开启了「入侵」其他生物大脑的方向。不过目前看来人们仍面临一些挑战,一个潜在的问题是神经科学家们仍然难以对更复杂化的大脑进行表征(如哺乳动物)。果蝇的大脑相对较小,只有 10 万个神经元,相比之下,老鼠的大脑有 1 亿个神经元,而人类的大脑有 1000 亿个神经元。因此在我们看到有小鼠、海豚或人类的大脑「被黑客入侵」之前,还需等待一段时间。

研究概况

果蝇脑蘑菇体是神经科学中研究最多的系统之一,其核心由一群 Kenyon 细胞组成。这些细胞接受来自多种感官方式的输入,被伽马氨基丁酸能神经元(Anterior Paired Lateral Neurons,APL 神经元)抑制,从而创造了输入的稀疏高维表征。

具体而言,其主要感知方式是嗅觉,但也有来自感知温度、湿度、视觉的神经元的输入。这些输入通过一组突触权重传递给大约 2000 个 Kenyon 细胞。Kenyon 细胞通过 APL 神经元相互连接,后者会发送一个强大的抑制信号到 Kenyon 细胞。这个循环网络形成了 Kenyon 细胞之间的赢者通吃效应,并让一小部分「冠军」神经元之外的所有神经元都失声了。

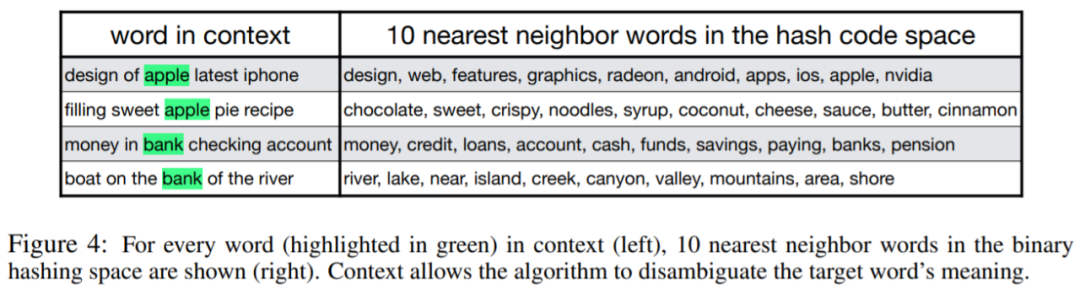

在这项论文中,研究者将该网络模体(motif)进行了数学化建模,并将其应用于一项常见的 NLP 任务:学习非结构化文本语料库中的词与上下午之间的相关结构。

该研究提出的网络模体如图 1 所示,KC 也将输出发送到蘑菇体输出神经元 (MBON),但是蘑菇体网络的这一部分不包含在数学模型中。

图 1: 网络架构图。几组对应不同方式的神经元将它们的活动发送到 KC 层,而 KC 层通过与 APL 神经元的相互连接而被抑制。

总体而言,研究贡献如下:

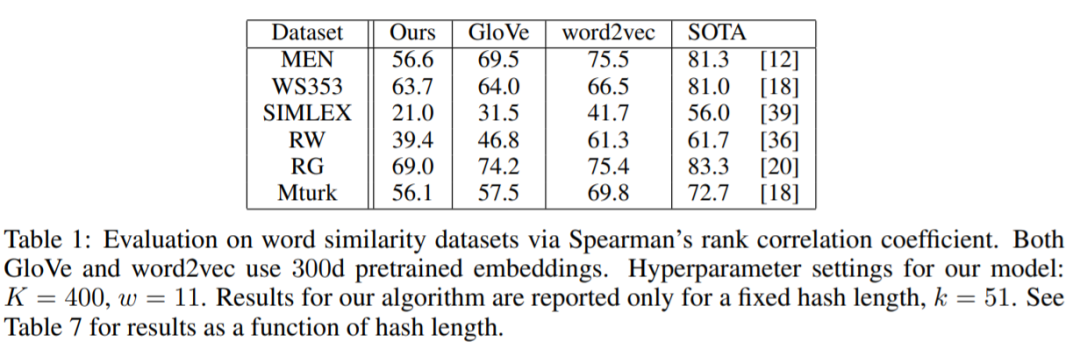

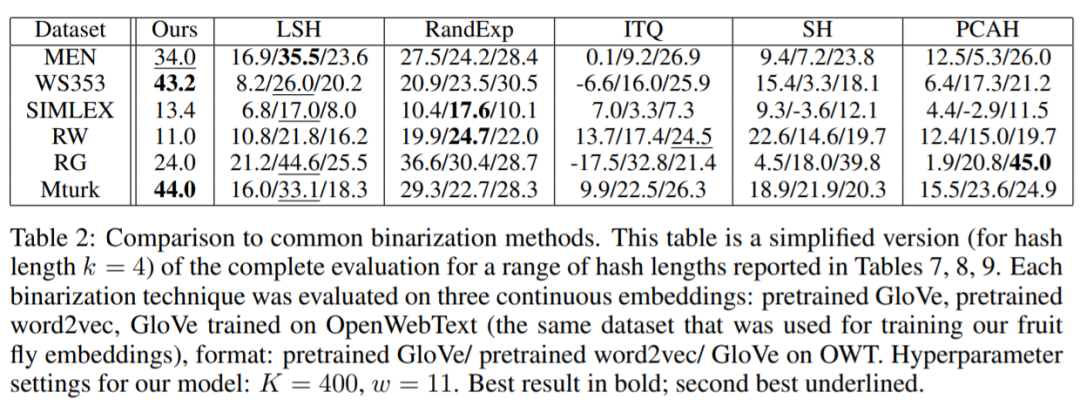

受果蝇网络的启发,研究者提出了一种算法,使得为单词及其上下文生成 binary (相对于连续) 词嵌入成为可能,并系统评估了该算法在词汇相似性任务、词义消歧和文本分类等任务上的表现;

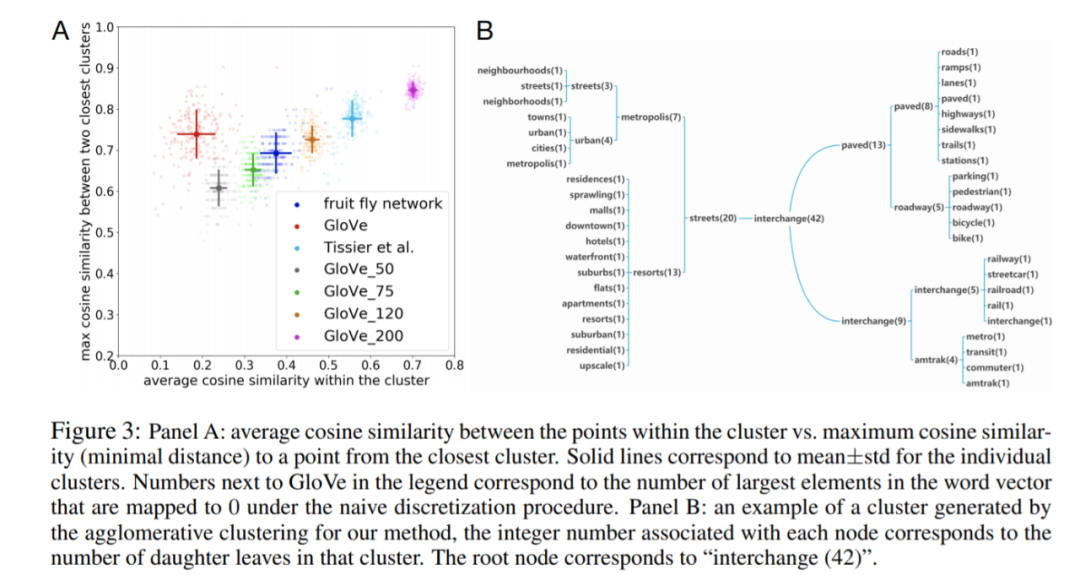

与连续 GloVe 嵌入相比,本文的 binary 嵌入能产生更紧密和更好分离的概念集群,并且符合 GloVe 的 binarized 版本的集群特性;

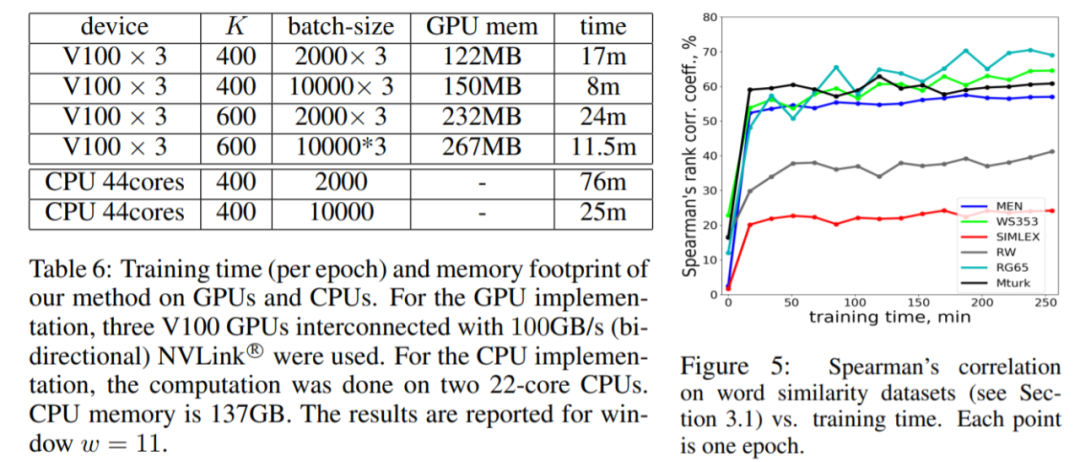

研究者发现,训练果蝇网络所需要的计算时间比训练传统的 NLP 架构(如 BERT)所需要的计算时间要少一个数量级,但是在分类准确率上有所降低。

这一成果展示了人类将自然界算法及行为进行「重新编程」,并将其转化为原始生物体从未参与过的任务的目标算法的巨大潜力。

实验结果

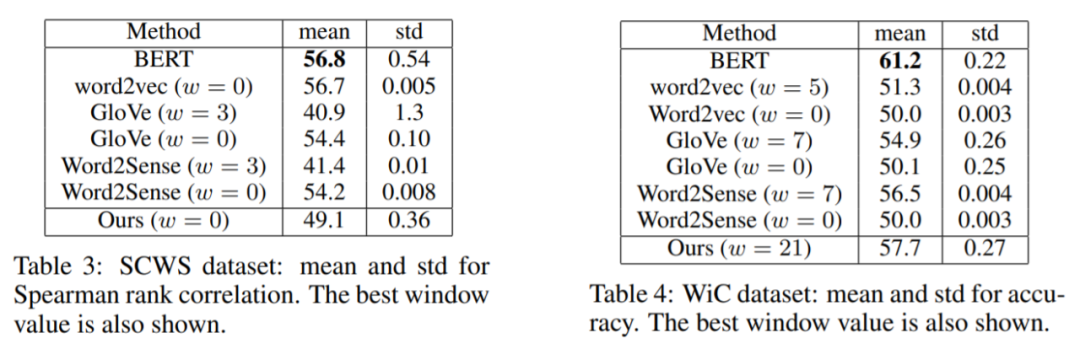

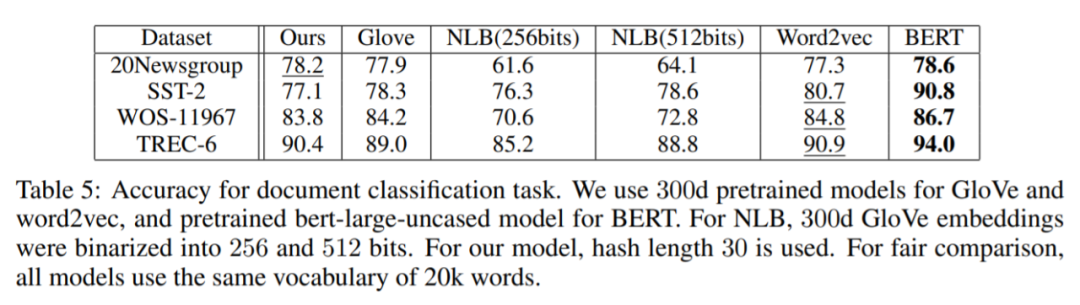

在论文的第三章,研究者从静态词嵌入、词聚类、上下文相关的词嵌入、文本分类等几个方面对研究提出的网络进行了评估,以下是实验结果。

静态词嵌入评价

词聚类

上下文相关的词嵌入

文本分类

计算效率

原文标题:科学家「黑进」果蝇大脑跑NLP任务,发现效率比BERT高

文章出处:【微信公众号:中科院长春光机所】欢迎添加关注!文章转载请注明出处。

责任编辑:haq

-

神经网络

+关注

关注

42文章

4572浏览量

98746 -

人工智能

+关注

关注

1776文章

43845浏览量

230597

原文标题:科学家「黑进」果蝇大脑跑NLP任务,发现效率比BERT高

文章出处:【微信号:cas-ciomp,微信公众号:中科院长春光机所】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

教您如何精调出自己的领域大模型

基于BERT算法搭建一个问答搜索引擎

人工智能nlp是什么方向

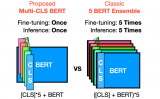

Multi-CLS BERT:传统集成的有效替代方案

PyTorch教程-16.7。自然语言推理:微调 BERT

PyTorch教程-16.6. 针对序列级和令牌级应用程序微调 BERT

PyTorch教程-15.9。预训练 BERT 的数据集

PyTorch教程16.6之针对序列级和令牌级应用程序微调BERT

LLM在各种情感分析任务中的表现如何

果蝇大脑跑NLP任务效率竟比BERT高?

果蝇大脑跑NLP任务效率竟比BERT高?

评论