好的,神经网络包含多种类型的函数,它们在网络的不同位置扮演着关键角色。以下是一些核心函数类别及其常见示例,用中文解释:

1. 激活函数 (Activation Functions)

- 作用: 引入非线性,使神经网络能够学习和逼近任意复杂的函数。没有激活函数,神经网络就只是一个线性模型。

- 常见类型:

- Sigmoid / Logistic: 将输入压缩到

(0, 1)区间。常用于二分类问题的输出层(表示概率)。存在梯度消失问题。 - Tanh (双曲正切): 将输入压缩到

(-1, 1)区间。输出是零中心的(均值接近0),有时比sigmoid收敛更快。也存在梯度消失问题。 - ReLU (修正线性单元):

f(x) = max(0, x)。计算简单高效,能有效缓解梯度消失问题(正向部分梯度为1),是当前最常用的激活函数。缺点是可能导致“死亡神经元”(输入为负时梯度为0)。 - Leaky ReLU:

f(x) = max(αx, x)(α通常很小,如0.01)。是对ReLU的改进,旨在解决“死亡神经元”问题,给负输入一个小的非零梯度。 - Parametric ReLU (PReLU): 类似Leaky ReLU,但斜率参数α是可学习的,而不是固定的。

- ELU (指数线性单元):

f(x) = x if x > 0 else α(exp(x)-1)。结合了ReLU的优点,并试图减轻死亡神经元问题和对噪声的敏感性,输出均值更接近零。 - Softmax: 将K个实数向量压缩为概率分布(和为1),每个元素在

(0,1)区间。主要用于多分类问题的输出层,表示每个类别的概率。 - Swish:

f(x) = x * sigmoid(x)。谷歌提出,在某些任务上表现优于ReLU,是无参平滑的非单调函数。

- Sigmoid / Logistic: 将输入压缩到

2. 损失函数 (Loss Functions / Cost Functions)

- 作用: 衡量模型预测值 (

ŷ) 与真实标签值 (y) 之间的差异(误差)。训练的目标就是最小化这个损失函数的值。 - 常见类型:

- 均方误差 (Mean Squared Error - MSE):

L = 1/N * Σ(ŷ_i - y_i)²。主要用于回归问题,衡量预测值与真实值的平方差。 - 平均绝对误差 (Mean Absolute Error - MAE / L1 Loss):

L = 1/N * Σ|ŷ_i - y_i|。对异常值不如MSE敏感,用于回归问题。 - 二元交叉熵 (Binary Cross-Entropy - BCE):

L = - [y * log(ŷ) + (1 - y) * log(1 - ŷ)]。主要用于二分类问题,衡量预测概率分布与真实标签分布的差异。 - 分类交叉熵 (Categorical Cross-Entropy - CCE):

L = - Σ (y_i * log(ŷ_i))。主要用于多分类问题(标签通常是one-hot编码)。 - 稀疏分类交叉熵 (Sparse Categorical Cross-Entropy): 与CCE相同,但适用于标签是整数索引(非one-hot)的情况。

- Huber Loss: 结合了MSE和MAE的优点,对于较小的误差使用平方项,对于较大的误差使用线性项,对异常值鲁棒,用于回归问题。

- Hinge Loss:

L = max(0, 1 - ŷ * y)。常用于支持向量机 (SVM),但也可在某些神经网络分类任务中使用(尤其是最大间隔分类)。 - KL散度 (Kullback-Leibler Divergence): 衡量两个概率分布之间的差异。常用于生成模型或模型压缩。

- 均方误差 (Mean Squared Error - MSE):

3. 优化器中的函数 (Optimization Functions)

- 作用: 优化器(如SGD, Adam)利用损失函数关于网络参数的梯度 (

∂L/∂w) 来更新权重 (w),以最小化损失。优化器内部使用的更新规则本身也包含特定的函数或公式。 - 核心概念:梯度下降 (Gradient Descent):

w_new = w_old - η * ∂L/∂w(η是学习率)。这是最基础的优化算法。 - 常见优化器(包含特定更新规则):

- 随机梯度下降 (SGD): 使用单个样本或小批量样本计算梯度进行更新。

- 带动量的SGD (SGD with Momentum): 引入动量项加速收敛并减少振荡。

- Adagrad: 自适应地为每个参数调整学习率(累计梯度平方根)。

- RMSProp: 改进Adagrad,使用指数移动平均衰减历史梯度平方,解决学习率急剧下降问题。

- Adam (自适应矩估计): 结合了动量(一阶矩估计)和RMSProp(二阶矩估计)的思想,并进行偏差校正。是目前最常用、效果通常最好的优化器之一。

- Nadam (Nesterov-accelerated Adaptive Moment Estimation): Adam与Nesterov动量的结合。

4. 层操作函数 (Layer Operations)

- 作用: 这些是构成神经网络核心结构的层所执行的数学运算。

- 常见类型:

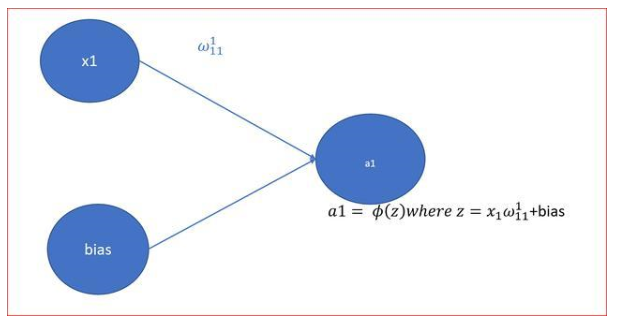

- 全连接/密集层 (Fully Connected / Dense Layer):

y = f(Wx + b)。核心运算是矩阵乘法 (Wx) 和向量加法 (+ b),然后通常跟一个激活函数 (f)。 - 卷积层 (Convolutional Layer): 核心运算是*卷积操作 (``)**。输入特征图与一组卷积核(滤波器)进行滑动窗口的点乘和累加运算,提取局部空间特征。通常也包含偏置项和激活函数。

- 池化层 (Pooling Layer):

Max Pooling / Average Pooling。对局部区域(如2x2窗口)进行最大值 (max) 或 平均值 (mean) 运算,实现下采样和特征不变性。 - 循环层 (Recurrent Layer - RNN, LSTM, GRU): 包含复杂的内部运算,如矩阵乘法、逐元素乘法 (

.*)、加法、以及特定的门控函数(如sigmoid用于门控,tanh用于候选值计算),以实现对序列数据的记忆和上下文处理。 - 嵌入层 (Embedding Layer): 本质是一个查找表 (Lookup Table) 操作,将离散的符号(如单词ID)映射为稠密的连续向量。

- 批量归一化层 (Batch Normalization - BN):

ŷ = γ * (x - μ) / √(σ² + ε) + β。对每层的输入(mini-batch维度)进行标准化 (减均值μ除以标准差σ),然后通过可学习的缩放因子γ和平移因子β进行变换,加速训练并提高稳定性。 - Dropout层: 在训练时,按照概率

p随机关闭(输出置0)一部分神经元的输出,是一种强大的正则化技术,防止过拟合。测试时通常需要缩放(乘以1-p)或使用全部神经元。

- 全连接/密集层 (Fully Connected / Dense Layer):

5. 距离/相似度函数 (Distance/Similarity Functions)

- 作用: 在某些特定任务或网络结构中(如孪生网络、对比学习、聚类层)用于衡量两个向量或特征表示之间的距离或相似度。

- 常见类型:

- 欧氏距离 (Euclidean Distance):

d = √Σ(x_i - y_i)²。 - 余弦相似度 (Cosine Similarity):

sim = (x · y) / (||x|| * ||y||)。衡量向量方向的相似性,忽略大小。 - 曼哈顿距离 (Manhattan Distance / L1 Distance):

d = Σ|x_i - y_i|。 - 点积 (Dot Product):

s = x · y。是余弦相似度的分子部分。

- 欧氏距离 (Euclidean Distance):

总结:

神经网络是一个由多种数学函数构成的复杂系统:

- 激活函数赋予网络非线性建模能力。

- 损失函数定义了学习的目标(要最小化的误差)。

- 优化器利用损失函数的梯度迭代更新网络参数。

- 层操作(矩阵乘、卷积、池化、归一化、Dropout等)构成了网络的基本计算单元和信息处理流程。

- 距离/相似度函数在特定结构中用于比较特征表示。

理解这些函数的作用、特性和适用场景对于设计、构建和理解神经网络至关重要。选择哪种函数取决于具体的任务类型(分类/回归)、网络架构(CNN/RNN/Transformer)、数据特性以及训练目标。

神经网络中的激活函数有哪些

在神经网络中,激活函数是一个至关重要的组成部分,它决定了神经元对于输入信号的反应方式,为神经网络引入了非线性因素,使得网络能够学习和处理复杂的模式。本文将详细介绍神经网络中常用的激活函数,包括其定义、特点、数学形式以及在神经网络中的作用和用途。

2024-07-01 11:52:13

BP神经网络激活函数怎么选择

中,激活函数起着至关重要的作用,它决定了神经元的输出方式,进而影响整个网络的性能。 一、激活函数的作用 激活函数是BP神经网络中神经元的核心组成部分,其主要作用如下: 引入非线性:激活函数将神经元的线性输出转换为非线性输出,使得神经网络能够学习和模拟复杂的

2024-07-03 10:02:01

卷积神经网络激活函数的作用

卷积神经网络(Convolutional Neural Networks, CNNs)是深度学习中一种重要的神经网络结构,广泛应用于图像识别、语音识别、自然语言处理等领域。在卷积神经网络中,激活函数

2024-07-03 09:18:34

图文详解:神经网络的激活函数

什么是神经网络激活函数?激活函数有助于决定我们是否需要激活神经元。如果我们需要发射一个神经元那么信号的强度是多少。激活函数是神经元通过神经网络处理和传递信息的机制

2020-07-05 11:21:21

【PYNQ-Z2试用体验】神经网络基础知识

思考问题的过程。人脑输入一个问题,进行思考,然后给出答案。神经网络就是在模拟人的思考这一过程。而我们要做的就是以数学的方式,将这一抽象的过程进行量化。神经元与激活函数人的大脑有大约1000亿个神经

![]() jj1989

2019-03-03 22:10:19

jj1989

2019-03-03 22:10:19

神经网络移植到STM32的方法

将神经网络移植到STM32最近在做的一个项目需要用到网络进行拟合,并且将拟合得到的结果用作控制,就在想能不能直接在单片机上做神经网络计算,这样就可以实时计算,不依赖于上位机。所以要解决的主要是两个

![]() 遇鱼余的小白

2022-01-11 06:20:53

遇鱼余的小白

2022-01-11 06:20:53

matlab实现神经网络 精选资料分享

习神经神经网络,对于神经网络的实现是如何一直没有具体实现一下:现看到一个简单的神经网络模型用于训练的输入数据:对应的输出数据:我们这里设置:1:节点个数设置:输入层、隐层、输出层的节点

![]() xianhaizhe

2021-08-18 07:25:21

xianhaizhe

2021-08-18 07:25:21

bp神经网络和卷积神经网络区别是什么

结构、原理、应用场景等方面都存在一定的差异。以下是对这两种神经网络的比较: 基本结构 BP神经网络是一种多层前馈神经网络,由输入层、隐藏层和输出层组成。每个神经元之间通过权重连接,并通过激活函数进行非线性转换。BP神经网络通过反向传播算法进行训练,通过调整权重和偏置来最小化损失函数。 卷积神经网络

2024-07-03 10:12:47

如何构建神经网络?

原文链接:http://tecdat.cn/?p=5725 神经网络是一种基于现有数据创建预测的计算系统。如何构建神经网络?神经网络包括:输入层:根据现有数据获取输入的层隐藏层:使用反向传播优化输入变量权重的层,以提高模型的预测能力输出层:基于输入和隐藏层的数据输出预测

![]() pipompipom

2021-07-12 08:02:11

pipompipom

2021-07-12 08:02:11

人工神经网络实现方法有哪些?

人工神经网络(Artificial Neural Network,ANN)是一种类似生物神经网络的信息处理结构,它的提出是为了解决一些非线性,非平稳,复杂的实际问题。那有哪些办法能实现人工神经网络呢?

![]() 燃烧剪族

2019-08-01 08:06:21

燃烧剪族

2019-08-01 08:06:21

神经网络初学者的激活函数指南

作者:MouâadB.来源:DeepHubIMBA如果你刚刚开始学习神经网络,激活函数的原理一开始可能很难理解。但是如果你想开发强大的神经网络,理解它们是很重要的。但在我们深入研究激活函数之前,先

2023-04-21 09:28:42

【案例分享】ART神经网络与SOM神经网络

今天学习了两个神经网络,分别是自适应谐振(ART)神经网络与自组织映射(SOM)神经网络。整体感觉不是很难,只不过一些最基础的概念容易理解不清。首先ART神经网络是竞争学习的一个代表,竞争型学习

![]() h1654155143.8331

2019-07-21 04:30:00

h1654155143.8331

2019-07-21 04:30:00

卷积神经网络如何使用

卷积神经网络(CNN)究竟是什么,鉴于神经网络在工程上经历了曲折的历史,您为什么还会在意它呢? 对于这些非常中肯的问题,我们似乎可以给出相对简明的答案。

![]() 脑洞大赛2

2019-07-17 07:21:50

脑洞大赛2

2019-07-17 07:21:50

神经网络中激活函数的定义及类型

引言 神经网络是一种模拟人脑神经元结构的计算模型,广泛应用于图像识别、自然语言处理、语音识别等领域。在神经网络中,激活函数起着至关重要的作用,它决定了神经元的输出值,进而影响整个网络的性能。本文将

2024-07-02 10:09:55

神经网络算法的结构有哪些类型

神经网络算法是深度学习的基础,它们在许多领域都有广泛的应用,如图像识别、自然语言处理、语音识别等。神经网络的结构有很多种类型,每种类型都有其独特的特点和应用场景。以下是对神经网络算法结构的介绍

2024-07-03 09:50:47

深度神经网络模型有哪些

模型: 多层感知器(Multilayer Perceptron,MLP): 多层感知器是最基本的深度神经网络模型,由多个全连接层组成。每个隐藏层的神经元数量可以不同,通常使用激活函数如ReLU

2024-07-02 10:00:01

反向传播神经网络和bp神经网络的区别

神经网络在许多领域都有广泛的应用,如语音识别、图像识别、自然语言处理等。然而,BP神经网络也存在一些问题,如容易陷入局部最优解、训练时间长、对初始权重敏感等。为了解决这些问题,研究者们提出了一些改进的BP神经网络模型,如径向基函数神经网络(Radial Basis Function Neu

2024-07-03 11:00:20

如何使用神经网络进行建模和预测

输入信号,对其进行加权求和,然后通过激活函数进行非线性转换,生成输出信号。通过这种方式,神经网络可以学习输入数据的复杂模式和关系。 神经网络的类型 神经网络有多种类型,包括前馈神经网络、卷积神经网络、循环神经网络

2024-07-03 10:23:07

基于BP神经网络的PID控制

最近在学习电机的智能控制,上周学习了基于单神经元的PID控制,这周研究基于BP神经网络的PID控制。神经网络具有任意非线性表达能力,可以通过对系统性能的学习来实现具有最佳组合的PID控制。利用BP

![]() zhhx1985

2021-09-07 07:43:47

zhhx1985

2021-09-07 07:43:47

神经网络初学者的激活函数指南

作者:Mouâad B. 来源:DeepHub IMBA 如果你刚刚开始学习神经网络,激活函数的原理一开始可能很难理解。但是如果你想开发强大的神经网络,理解它们是很重要的。 但在我们深入研究激活函数

2023-04-18 11:20:04

卷积神经网络模型有哪些?卷积神经网络包括哪几层内容?

卷积神经网络模型有哪些?卷积神经网络包括哪几层内容? 卷积神经网络(Convolutional Neural Networks,CNN)是深度学习领域中最广泛应用的模型之一,主要应用于图像、语音

2023-08-21 16:41:52

卷积神经网络和bp神经网络的区别在哪

结构、原理、应用场景等方面都存在一定的差异。以下是对这两种神经网络的详细比较: 基本结构 BP神经网络是一种多层前馈神经网络,由输入层、隐藏层和输出层组成。每个神经元之间通过权重连接,并通过激活函数进行非线性转换。BP神经网络通过反向传播算法进行训练,通过调整权重和偏置来最小化损失函数。 卷积神经

2024-07-04 09:49:44

神经网络架构有哪些

神经网络架构是机器学习领域中的核心组成部分,它们模仿了生物神经网络的运作方式,通过复杂的网络结构实现信息的处理、存储和传递。随着深度学习技术的不断发展,各种神经网络架构被提出并广泛应用于图像识别

2024-07-01 14:16:42

卷积神经网络模型发展及应用

的概率。Top-5 识别率指的是 CNN 模型预测出最大概率的前 5 个分 类里有正确类别的概率。2012 年,由 Alex Krizhevshy 提出的 AlexNet给卷 积神经网络迎来了历史性

![]() ss淡淡

2022-08-02 10:39:39

ss淡淡

2022-08-02 10:39:39

前馈神经网络的基本结构和常见激活函数

和激活函数的非线性变换,能够学习和模拟复杂的函数映射,从而解决各种监督学习任务。本文将详细阐述前馈神经网络的基本结构,包括其组成层、权重和偏置、激活函数等,并介绍几种常见的激活函数及其特性。

2024-07-09 10:31:59

什么是神经网络?什么是卷积神经网络?

在介绍卷积神经网络之前,我们先回顾一下神经网络的基本知识。就目前而言,神经网络是深度学习算法的核心,我们所熟知的很多深度学习算法的背后其实都是神经网络。

2023-02-23 09:14:44

人工神经网络模型的分类有哪些

人工神经网络(Artificial Neural Networks, ANNs)是一种模拟人脑神经元网络的计算模型,它在许多领域,如图像识别、语音识别、自然语言处理、预测分析等有着广泛的应用。本文将

2024-07-05 09:13:55