云原生Ingress网关高并发高可用解决思路

当Ingress网关面临高并发请求(如 QPS 超过 10万+)时,可能导致服务崩溃、响应延迟激增或资源耗尽。以下是系统性解决方案和分布式网关架构设计思路:

一、单点性能优化

首先优化现有 Ingress 网关的性能,挖掘单节点潜力:

1.硬件与资源调优

•垂直扩容:提升节点配置(CPU/内存/网络带宽)。

•内核参数优化:

# 调整连接数、端口范围、TIME_WAIT 复用 net.core.somaxconn = 65535 net.ipv4.tcp_max_syn_backlog = 65535 net.ipv4.tcp_tw_reuse = 1 net.ipv4.ip_local_port_range = 1024 65535

•启用 DPDK/用户态协议栈:如 Nginx 的DPDK 模式、Envoy 的Kernel Bypass。

2.Ingress 配置优化

•连接复用:启用 HTTP/2、gRPC 长连接。

•缓冲与超时:合理设置proxy_buffer、proxy_timeout。

•静态资源缓存:在 Ingress 层缓存静态内容(如图片、JS)。

# Nginx Ingress 缓存示例

proxy_cache_path/tmp/nginx_cache levels=1:2keys_zone=my_cache:10mmax_size=1g;

location/static/ {

proxy_cachemy_cache;

proxy_passhttp://backend;

}

3.限流与熔断

•限流策略:

# Nginx Ingress 限流(每秒 1000 请求) annotations: nginx.ingress.kubernetes.io/limit-rps:"1000"

•熔断降级:集成 Hystrix 或 Sentinel,在网关层拦截异常流量。

二、分布式网关架构

突破单点性能瓶颈,设计分布式高可用网关集群:

1.水平扩展(Scale Out)

•多副本负载均衡:部署多个 Ingress 实例,通过 DNS 轮询或外部负载均衡器(如 AWS ALB、Nginx)分发流量。

•自动扩缩容(HPA):基于 CPU、内存或自定义指标(QPS)自动扩缩。

# Kubernetes HPA 示例 apiVersion:autoscaling/v2 kind:HorizontalPodAutoscaler metadata: name:ingress-hpa spec: scaleTargetRef: apiVersion:apps/v1 kind:Deployment name:ingress-nginx minReplicas:3 maxReplicas:100 metrics: -type:Resource resource: name:cpu target: type:Utilization averageUtilization:80

2.分层网关架构

•边缘层:使用云厂商的全球负载均衡(如 AWS Global Accelerator、Cloudflare)就近接入用户。

•区域层:在多个区域部署 Ingress 集群,通过 Anycast 或 GeoDNS 路由流量。

•服务层:每个服务独立部署专用 Ingress,避免全局瓶颈。

3.高性能替代方案

•Envoy + xDS 控制平面:

• 使用 Envoy 作为数据平面,支持动态配置更新和高效连接管理。

• 集成 Istio 或 Gloo 作为控制平面,实现流量拆分、金丝雀发布。

•云原生 API 网关:

•Kong:基于 Nginx 和 OpenResty,支持插件扩展。

•APISIX:基于 etcd 的动态路由,支持多协议(MQTT、gRPC)。

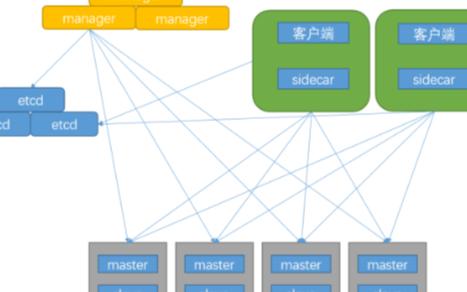

•服务网格(Service Mesh):

• 将流量管理下沉到 Sidecar(如 Istio、Linkerd),分散网关压力。

三、流量治理与异步化

1.流量卸载

•静态资源 CDN 化:将图片、CSS、JS 等静态资源卸载到 CDN。

•API 缓存:对查询类 API 使用 Redis 或 Varnish 缓存响应。

2.异步处理

•请求队列:将非实时请求写入 Kafka/RabbitMQ,后端异步消费。

•边缘计算:在靠近用户的边缘节点处理部分逻辑(如鉴权、过滤)。

3.协议优化

•二进制协议:使用 Protobuf、Thrift 替代 JSON 降低序列化开销。

•QUIC/HTTP3:减少连接建立延迟,提升弱网性能。

四、监控与容灾

1.全链路监控

•指标采集:监控 QPS、延迟、错误率(Prometheus + Grafana)。

•分布式追踪:集成 Jaeger 或 Zipkin 定位慢请求。

2.容灾策略

•多活容灾:跨地域部署网关集群,支持流量快速切换。

•故障注入:通过 Chaos Engineering 测试系统韧性。

五、典型分布式网关架构示例

用户请求 → 全球负载均衡(DNS/Anycast) → 区域 Ingress 集群(Envoy/Nginx)

边缘缓存(CDN) 服务网格 Sidecar(Istio)

异步队列(Kafka) 后端服务集群

总结

•单点优化:最大化单节点性能,配置限流、缓存、资源调优。

•水平扩展:通过多副本 + 自动扩缩容分散压力。

•架构升级:采用 Envoy/APISIX 等高性能网关,结合服务网格和 CDN。

•异步治理:通过队列、边缘计算、协议优化降低实时压力。

最终方案需结合业务场景(如实时性要求、成本预算)选择,可先通过压力测试(如 JMeter、wrk)验证优化效果。

链接:https://blog.csdn.net/Franklin7B/article/details/145693326?spm=1001.2014.3001.5502

-

cpu

+关注

关注

68文章

11216浏览量

222942 -

网关

+关注

关注

9文章

6429浏览量

55577 -

云原生

+关注

关注

0文章

265浏览量

8497

原文标题:云原生Ingress网关高并发高可用解决思路

文章出处:【微信号:magedu-Linux,微信公众号:马哥Linux运维】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

Kubernetes Ingress 高可靠部署最佳实践

从服务端视角看高并发难题

AX58400 EtherCAT转IO-Link网关与马达控制解决方案演示视频

性能提升1倍,成本直降50%!基于龙蜥指令加速的下一代云原生网关

飞腾携手宝兰德推出应用服务器联合解决方案,助力大数据高并发处理

BFE Ingress Controller基于BFE实现的Kubernetes Ingress Controller

Ingress网关高并发请求的解决方案

Ingress网关高并发请求的解决方案

评论