在科技日新月异的今天,每一次技术的突破都可能成为推动行业发展的关键力量。近日,AI领域的独角兽企业DeepSeek,在其开源周活动中连续扔出了两枚震撼业界的“开源王炸”--FlashMLA与DeepEP。这两大开源项目的发布,不仅引发了国内外媒体的广泛关注与热议,更在AI社区内掀起了轩然大波。

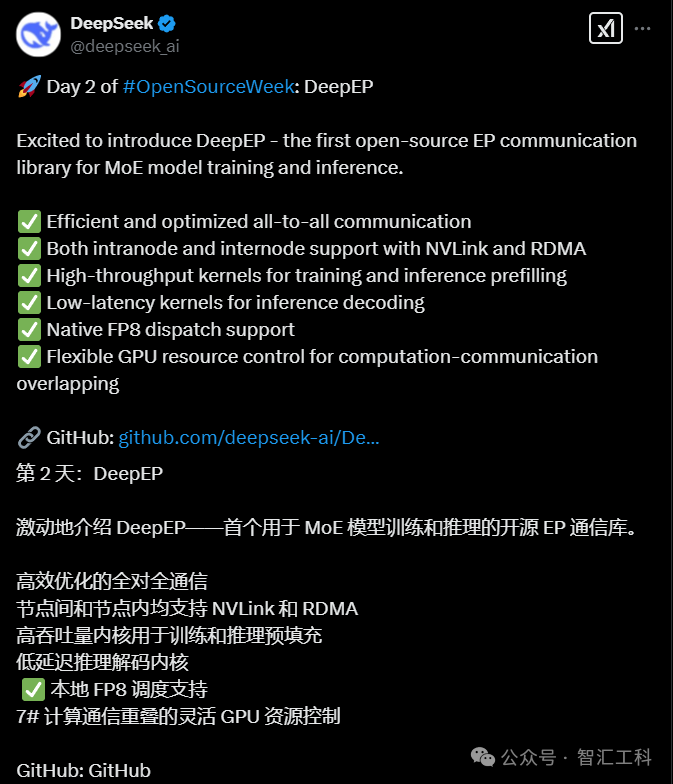

2025年2月25日,DeepSeek在开源周的第二天,正式发布了名为DeepEP的开源代码库。DeepEP是全球首个专为MoE(混合专家)模型训练和推理设计的通信库,它的出现填补了该领域专用工具的空白。MoE模型作为一种能够有效提升AI模型性能和扩展性的架构,近年来在自然语言处理、计算机视觉等领域得到了广泛应用。然而,MoE模型在训练和推理过程中,面临着通信开销大、算力需求高等挑战。DeepEP正是针对这些痛点,通过优化GPU之间的信息传输效率,极大地缓解了从业者的算力焦虑。

DeepEP的核心优势在于其高效的通信机制。在传统的分布式AI训练中,GPU之间的通信往往成为性能瓶颈。DeepEP通过一系列创新技术,如低延迟通信协议、智能数据调度等,显著提升了GPU之间的通信效率。这意味着,原本需要庞大算力支持的重型任务,现在可以在更少的GPU上高效完成。据DeepSeek官方介绍,使用DeepEP后,某些MoE模型的训练速度可提升数倍,同时降低了对硬件资源的依赖。

DeepSeek扔的第二枚开源王炸是全栈通信库DeepEP。与第一枚开源王炸FlashMLA相比,两者在多个方面存在显著差异。以下是对这两者的详细对比以及外媒的热议:

一、DeepEP与FlashMLA的对比

1. 功能定位:

● DeepEP:它是全球首个面向MoE(Mixture of Experts)模型的全栈通信库,旨在优化GPU之间的信息传输效率,从而极大提升AI模型的训练与推理效率。

● FlashMLA:专为英伟达Hopper架构GPU(如H800/H100)优化的高效MLA解码内核,旨在显著提升AI的加速能力,特别是在处理长短句子并行任务时能够动态调整计算资源分配,避免算力浪费。

2. 技术特点:

● DeepEP:具备高效的全员通信能力,支持NVLink与RDMA技术,提供高吞吐量的训练预填充内核以及低延迟的推理解码内核。原生支持FP8调度,灵活的GPU资源管理能力使得计算和通信可以重叠进行。

● FlashMLA:专为高性能显卡设计,能够充分挖掘显卡性能潜力,被视为AI加速的“涡轮增压器”。

3. 硬件兼容性:

● DeepEP:具有更广泛的硬件兼容性,不受特定GPU架构的限制。

● FlashMLA:目前仅适配Hopper架构GPU,国产GPU的兼容性尚待验证。

二、外媒热议

DeepSeek的这两枚开源王炸在国际上引起了广泛关注。外媒对DeepSeek的评价普遍较高,认为其打破了人们对人工智能研发需要“高投入、长周期”的传统认知,提供了低成本、高效能的解决方案。同时,DeepSeek的开源策略也被视为一种促进全球科技进步的积极举措。

具体来说,外媒对DeepEP和FlashMLA的关注点有所不同。对于DeepEP,外媒主要关注其在优化GPU通信效率、提升AI模型训练与推理效率方面的潜力。而对于FlashMLA,外媒则更侧重于其在提升AI加速能力、挖掘显卡性能潜力方面的表现。

综上所述,DeepSeek的第二枚开源王炸DeepEP与第一枚FlashMLA在功能定位、技术特点、硬件兼容性和开源时间等方面存在显著差异。外媒对这两者的评价普遍积极,认为它们为人工智能领域带来了新的突破和进步。

审核编辑 黄宇

-

AI

+关注

关注

89文章

38091浏览量

296602 -

开源

+关注

关注

3文章

4031浏览量

45568 -

DeepSeek

+关注

关注

2文章

824浏览量

2812

发布评论请先 登录

看点:英伟达将在韩国部署26万枚GPU 中国服务器龙头超聚变筹备上市 中芯国际控股公司增资至59.5亿美元

FLIR Lepton红外热成像组件的优势和应用

【「DeepSeek 核心技术揭秘」阅读体验】--全书概览

【「DeepSeek 核心技术揭秘」阅读体验】书籍介绍+第一章读后心得

一枚叶片的独白

9.9万元用上“满血”DeepSeek R1一体机,本地部署成新商机?引发外媒热议

沐曦GPU跑通DeepSeek开源代码库FlashMLA

DeepSeek:引领全球AI竞赛的中国新范式

李建忠:DeepSeek技术革新引领AI生态新变革

DeepSeek扔的第二枚开源王炸是什么,跟第一枚有何不同?强烈引发外媒热议

DeepSeek扔的第二枚开源王炸是什么,跟第一枚有何不同?强烈引发外媒热议

评论