关于这点,在一篇采访OpenAI 总裁Greg Brockman 的报道中提到了:

“Q:ChatGPT是如何产生的?GPT模型当初发布时显得有些违反常识,但却在某种程度上掀起了最新的AI浪潮,这与你们当初构建这些技术时的预期是否一致?

A:ChatGPT、GPT-3、DALL·E 2这些模型看似一夜成名,但其实构建这些模型耗费了整整五年时间,饱含多年的心血。GPT模型的构建要从2017年发布的情感神经元论文(Neural Sentiment Neuron: A novel Neural Architecture for Aspect-based Sentiment Analysis)说起,这篇论文的思想很新颖,不过很多人可能已经忘了。

....“

于是好奇去查了这篇文章,很遗憾,并不是上面提到的这篇文章,而是官网Learning to Generate Reviews and Discovering Sentiment这篇文章。这篇文章的作者很激动、诚恳甚至有点卑微的表达了它的意外发现,那就是单纯训练LSTM 模型的去预测下一个单词,模型中的某个神经元意外对应着情感状态,用Greg Brockman的原话说就是:

“我们发现LSTM模型中的单个神经元有助于开发出SOTA情感分析分类器(sentiment analysis classifier),可以告知你文本情感(正面评价或负面评价),这一发现听起来平平无奇,但我们非常清楚地知道,这是一个超越语法并转向语义的时刻。”

关于为何会出现这种涌现行为,文章的作者提出了他的思路:

“情绪作为条件特征可能对语言建模具有很强的预测能力。(It is possible that sentiment as a conditioning feature has strong predictive capability for language modelling.)“

这个思路是典型的达尔文进化思维:

即模型本身有生成各种能力的潜力,当某项能力有利于模型完成任务(完不成的参数被调整,等驾驭被任务淘汰),这项能力就能自发进化出来。

神经网络在训练的时候,采用的随机梯度下降算法,一定程度上等效于物种的基因突变,本质是有一定方向的随机摸索,在强大的生存压力下,错误的摸索被淘汰,久而久之,积累越来越多的正确摸索,某些高层的功能就这么涌现出来了。

这种思路是不同于还原论的,ChatGPT 的出现让很多这个行业的老人困惑:“似乎原理上没有任何创新,为何能力出现巨大提升呢?”“涌现这个词本身就是个模棱两可的词,我并不知道具体的细节,那就是伪科学。”“ChatGPT 具备的推理能力不过是另一种归纳,永远无法替代演绎”。

还原论的思想讲究从底层到高层的逐渐构建,每行代码都有清晰的含义,这样写出来的系统才叫系统,但进化论的思想完全不同,进化论需要构建一个万能生成器,然后建立一个淘汰机制,对万能生成器生成的各种可能进行筛选淘汰,这样进化出来的系统,就能很好的完成任务,至于里面形成的微结构,那并不是重点,甚至都无法用简单的语言描述,因为本身就是全局共同起作用的。

所谓上下文推理,不过就是给定前文,准确给出后文的能力,这其实就是语言模型预训练时候就在做的事情,为了能做到这点,在训练的过程中,各种有助于提高预测能力的高层能力,都会自然而然的进化出来,所谓的高层能力,不过是一种函数,而神经网络本身可以拟合一切函数,同时随机梯度下降,又让神经网络具备了参数自动填充的能力。当然,进化的过程中,神经网络总会尝试找到更好的解法,比如死记硬背,但这些解法往往跟我们预期的解法不一致,这时候任务的合理构建就很重要了,需要巧妙的设计,让我们预期的解法是神经网络进化的唯一解。

其实换个角度想,人为什么有推理能力?人的一切能力也是进化而来的,人的各种生存压力,配合基因的随机突变和大自然的定向筛选,导致推理等能力的出现,换句话说,当推理能力的出现有助于人这个群体生存的时候,这个能力就会出现,跟GPT 涌现的各种能力的原理一样。

不要总拿着还原论思想去看待世界,几百年前,就出现了进化论思想,因为进化论思想没有写进义务教育的教材,导致太多人没有深刻理解这个工具。

审核编辑 :李倩

-

神经网络

+关注

关注

42文章

4827浏览量

106803 -

模型

+关注

关注

1文章

3649浏览量

51716 -

ChatGPT

+关注

关注

31文章

1596浏览量

10074

原文标题:为什么ChatGPT模型大了就有上下文联系能力?

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

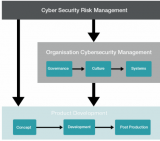

执行脱离上下文的威胁分析与风险评估

请问riscv中断还需要软件保存上下文和恢复吗?

HarmonyOSAI编程编辑区代码续写

HarmonyOS AI辅助编程工具(CodeGenie)代码续写

鸿蒙中Stage模型与FA模型详解

鸿蒙NEXT-API19获取上下文,在class中和ability中获取上下文,API迁移示例-解决无法在EntryAbility中无法使用最新版

Transformer架构中编码器的工作流程

为什么ChatGPT模型大了就有上下文联系能力?

为什么ChatGPT模型大了就有上下文联系能力?

评论