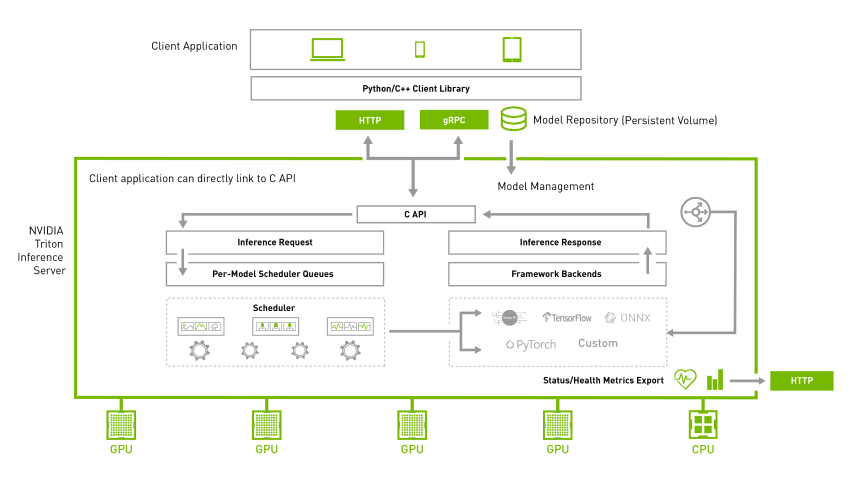

在前一篇文章已经带着读者创建一个 Triton 的推理模型仓,现在只要安装好服务器端与用户端软件,就能进行基本的测试与体验。

为了简化过程,我们使用 NVIDIA Jetson AGX Orin 设备进行示范,所有步骤都能适用于各种基于 NVIDIA Jetson 智能芯片的边缘设备上,也适用于大部分装载 Ubuntu 18 以上操作系统的 x86 设备上,即便设备上没有安装 NVIDIA 的 GPU 计算卡也能使用,只不过我们的提供的内容都是基于 GPU 计算环境,对于纯 CPU 的使用则需要用户自行研读说明文件。

现在就开始安装 Triton 服务器软件,NVIDIA 为 Triton 服务器提供以下三种软件安装的方式:

1. 源代码编译

这种方式需要从https://github.com/triton-inference-server/server下载源代码,然后安装依赖库,再用 cmake 与 make 工具进行编译。通常会遇到的麻烦是步骤繁琐,并且出错率较高,因此并不推荐使用这个方法。

有兴趣者,请自行参考前面下载的开源仓里的docs/customization_guide/build.md文件,有关于 Ubuntu 20.04、Jetpack 与 Windows 等各种平台的编译细节。

2. 可执行文件

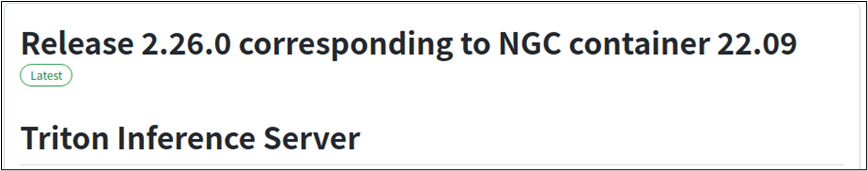

Triton 开发团队为使用者提供编译好的可执行文件,包括 Ubuntu 20.04、Jetpack 与Windows 平台,可以在https://github.com/triton-inference-server/server/releases/ 上获取,每个版本都会提供对应 NGC 容器的版本,如下图:

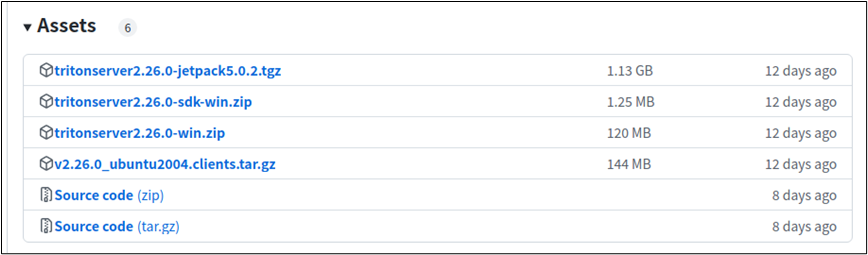

然后到下面的“Assets”选择合适的版本:

以装载 Jetpack 5 的 Orin 为例,就下载

tritonserver2.26.0-jetpack5.0.2.tgz(1.13GB)压缩文件到本机上,然后解压缩到指定目录下就可以,例如 ${HOME}/triton 目录,会生成

在执行 Triton 服务器软件前,还得先安装所需要的依赖库,请执行以下指令:

sudo apt-get update

sudoapt-getinstall-y--no-install-recommendssoftware-properties-commonautoconfautomakebuild-essentialgitlibb64-devlibre2-devlibssl-devlibtoollibboost-devrapidjson-devpatchelfpkg-configlibopenblas-devlibarchive-devzlib1g-dev现在就可以执行以下指令启动 Triton 服务器:

cd ${HOME}/triton

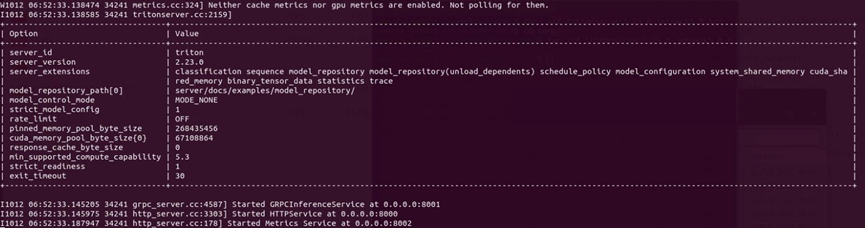

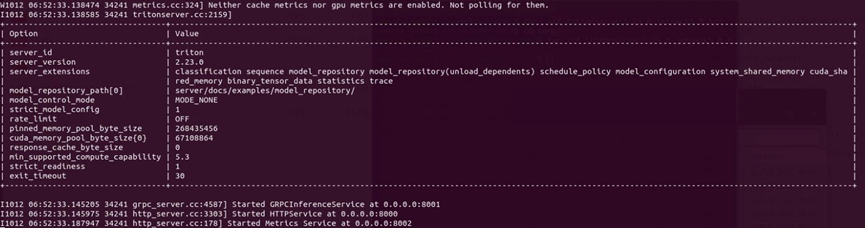

bin/tritonserver--model-repository=server/docs/examples/model_repository--backend-directory=backends--backend-config=tensorflow,version=2如果最后出现以下画面并且进入等待状态:

现在 Triton 服务器已经正常运行,进入等待用户端提出请求(request)的状态。

3. Docker容器

在NGC的

https://catalog.ngc.nvidia.com/orgs/nvidia/containers/tritonserver/tags可以找到 Triton 服务器的 Docker 镜像文件,每个版本主要提供以下几种版本:

year-xy-py3:包含 Triton 推理服务器,支持 Tensorflow、PyTorch、TensorRT、ONNX 和 OpenVINO 模型;

year-xy-tf2-python-py3:仅支持 TensorFlow 2.x 和 python 后端的 Triton 推理服务器;

year-xy-pyt-python-py3:仅支持 PyTorch 和 python 后端的 Triton 服务器;

year-xy-py3-min:用作创建自定义 Triton 服务器容器的基础,如 Customize Triton Container(自定义Triton容器)说明文件所描述的内容;

其中“year”是年份的数字,例如 2022 年提交的就是“22”开头;后面的“xy”是流水号,每次往上加“1”,例如 2022 年 10 月 4 日提交的版本为“22-09”。

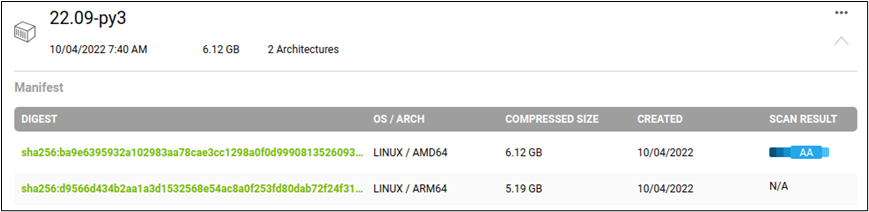

NVIDIA 提供的 Triton 容器镜像是同时支持 x86 / AMD64 与 ARM64 架构的系统,以 22.09-py3 镜像为例,可以看到如下图所标示的“2 Architectures”:

点击最右方的“向下”图标,会展开如下图的内容,事实上是有两个不同版本的镜像,不过使用相同镜像名:

因此在 x86 电脑与 Jetson 设备都使用相同的镜像下载指令,如下:

docker pull nvcr.io/nvidia/tritonserver:22.09-py3就能根据所使用设备的 CPU 架构去下载对应的镜像,现在执行以下指令来启动 Triton 服务器:

# 根据实际的模型仓根目录位置设定TRITON_MODEL_REPO路径

export TRITON_MODEL_REPO=${HOME}/triton/server/docs/examples/model_repository

# 执行Triton服务器

dockerrun--rm--net=host-v${TRITON_MODEL_REPO}:/modelsnvcr.io/nvidia/tritonserver:22.09-py3tritonserver--model-repository=/models如果执行正常,也会出现以下的等待画面,表示运行是正确的:

以上三种方式都能在计算设备上启动 Triton 服务器软件,目前看起来使用 Docker 镜像是最为简单的。当服务器软件启动之后,就处于“等待请求”状态,可以使用“Ctrl-C”组合键终止服务器的运行。

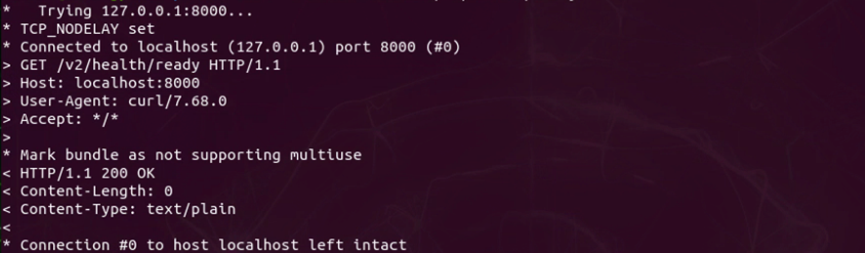

有一种确认 Triton 服务器正常运行的最简单方法,就是用 curl 指令检查 HTTP 端口的状态,请执行以下指令:

curl -v localhost:8000/v2/health/ready如果有显示“HTTP/1.1 200 OK”的信息(如下图),就能确定 Triton 服务器处于正常运行的状态:

接下去就要安装客户端软件,用来对服务器提出推理请求,这样才算完成一个最基础的推理周期。

推荐阅读

NVIDIA Jetson Nano 2GB 系列文章(1):开箱介绍

NVIDIA Jetson Nano 2GB 系列文章(2):安装系统

NVIDIA Jetson Nano 2GB 系列文章(3):网络设置及添加 SWAPFile 虚拟内存

NVIDIA Jetson Nano 2GB 系列文章(4):体验并行计算性能

NVIDIA Jetson Nano 2GB 系列文章(5):体验视觉功能库

NVIDIA Jetson Nano 2GB 系列文章(6):安装与调用摄像头

NVIDIA Jetson Nano 2GB 系列文章(8):执行常见机器视觉应用

NVIDIA Jetson Nano 2GB 系列文章(9):调节 CSI 图像质量

NVIDIA Jetson Nano 2GB 系列文章(10):颜色空间动态调节技巧

NVIDIA Jetson Nano 2GB 系列文章(11):你应该了解的 OpenCV

NVIDIA Jetson Nano 2GB 系列文章(12):人脸定位

NVIDIA Jetson Nano 2GB 系列文章(13):身份识别

NVIDIA Jetson Nano 2GB 系列文章(14):Hello AI World

NVIDIA Jetson Nano 2GB 系列文章(15):Hello AI World 环境安装

NVIDIA Jetson Nano 2GB 系列文章(16):10行代码威力

NVIDIA Jetson Nano 2GB 系列文章(17):更换模型得到不同效果

NVIDIA Jetson Nano 2GB 系列文章(18):Utils 的 videoSource 工具

NVIDIA Jetson Nano 2GB 系列文章(19):Utils 的 videoOutput 工具

NVIDIA Jetson Nano 2GB 系列文章(20):“Hello AI World” 扩充参数解析功能

NVIDIA Jetson Nano 2GB 系列文章(21):身份识别

NVIDIA Jetson Nano 2GB 系列文章(22):“Hello AI World” 图像分类代码

NVIDIA Jetson Nano 2GB 系列文章(23):“Hello AI World 的物件识别应用

NVIDIAJetson Nano 2GB 系列文章(24): “Hello AI World” 的物件识别应用

NVIDIAJetson Nano 2GB 系列文章(25): “Hello AI World” 图像分类的模型训练

NVIDIAJetson Nano 2GB 系列文章(26): “Hello AI World” 物件检测的模型训练

NVIDIAJetson Nano 2GB 系列文章(27): DeepStream 简介与启用

NVIDIAJetson Nano 2GB 系列文章(28): DeepStream 初体验

NVIDIAJetson Nano 2GB 系列文章(29): DeepStream 目标追踪功能

NVIDIAJetson Nano 2GB 系列文章(30): DeepStream 摄像头“实时性能”

NVIDIAJetson Nano 2GB 系列文章(31): DeepStream 多模型组合检测-1

NVIDIAJetson Nano 2GB 系列文章(32): 架构说明与deepstream-test范例

NVIDIAJetsonNano 2GB 系列文章(33): DeepStream 车牌识别与私密信息遮盖

NVIDIA Jetson Nano 2GB 系列文章(34): DeepStream 安装Python开发环境

NVIDIAJetson Nano 2GB 系列文章(35): Python版test1实战说明

NVIDIAJetson Nano 2GB 系列文章(36): 加入USB输入与RTSP输出

NVIDIAJetson Nano 2GB 系列文章(37): 多网路模型合成功能

NVIDIAJetson Nano 2GB 系列文章(38): nvdsanalytics视频分析插件

NVIDIAJetson Nano 2GB 系列文章(39): 结合IoT信息传输

NVIDIAJetson Nano 2GB 系列文章(40): Jetbot系统介绍

NVIDIAJetson Nano 2GB 系列文章(41): 软件环境安装

NVIDIAJetson Nano 2GB 系列文章(42): 无线WIFI的安装与调试

NVIDIAJetson Nano 2GB 系列文章(43): CSI摄像头安装与测试

NVIDIAJetson Nano 2GB 系列文章(44): Jetson的40针引脚

NVIDIAJetson Nano 2GB 系列文章(46): 机电控制设备的安装

NVIDIAJetson Nano 2GB 系列文章(47): 组装过程的注意细节

NVIDIAJetson Nano 2GB 系列文章(48): 用键盘与摇杆控制行动

NVIDIAJetson Nano 2GB 系列文章(49): 智能避撞之现场演示

NVIDIAJetson Nano 2GB 系列文章(50): 智能避障之模型训练

NVIDIAJetson Nano 2GB 系列文章(51): 图像分类法实现找路功能

NVIDIAJetson Nano 2GB 系列文章(52): 图像分类法实现找路功能

NVIDIAJetson Nano 2GB 系列文章(53): 简化模型训练流程的TAO工具套件

NVIDIA Jetson Nano 2GB 系列文章(54):NGC的内容简介与注册密钥

NVIDIA Jetson Nano 2GB 系列文章(55):安装TAO模型训练工具

NVIDIA Jetson Nano 2GB 系列文章(56):启动器CLI指令集与配置文件

NVIDIA Jetson Nano 2GB 系列文章(57):视觉类脚本的环境配置与映射

NVIDIA Jetson Nano 2GB 系列文章(58):视觉类的数据格式

NVIDIA Jetson Nano 2GB 系列文章(59):视觉类的数据增强

NVIDIA Jetson Nano 2GB 系列文章(60):图像分类的模型训练与修剪

NVIDIA Jetson Nano 2GB 系列文章(61):物件检测的模型训练与优化

NVIDIA Jetson Nano 2GB 系列文章(62):物件检测的模型训练与优化-2

NVIDIA Jetson Nano 2GB 系列文章(63):物件检测的模型训练与优化-3

NVIDIA Jetson Nano 2GB 系列文章(64):将模型部署到Jetson设备

NVIDIA Jetson Nano 2GB 系列文章(65):执行部署的 TensorRT 加速引擎

NVIDIA Jetson 系列文章(1):硬件开箱

NVIDIA Jetson 系列文章(2):配置操作系统

NVIDIA Jetson 系列文章(3):安装开发环境

NVIDIA Jetson 系列文章(4):安装DeepStream

NVIDIA Jetson 系列文章(5):使用Docker容器的入门技巧

NVIDIA Jetson 系列文章(6):使用容器版DeepStream

NVIDIA Jetson 系列文章(7):配置DS容器Python开发环境

NVIDIA Jetson 系列文章(8):用DS容器执行Python范例

NVIDIA Jetson 系列文章(9):为容器接入USB摄像头

NVIDIA Jetson 系列文章(10):从头创建Jetson的容器(1)

NVIDIA Jetson 系列文章(11):从头创建Jetson的容器(2)

NVIDIA Jetson 系列文章(12):创建各种YOLO-l4t容器

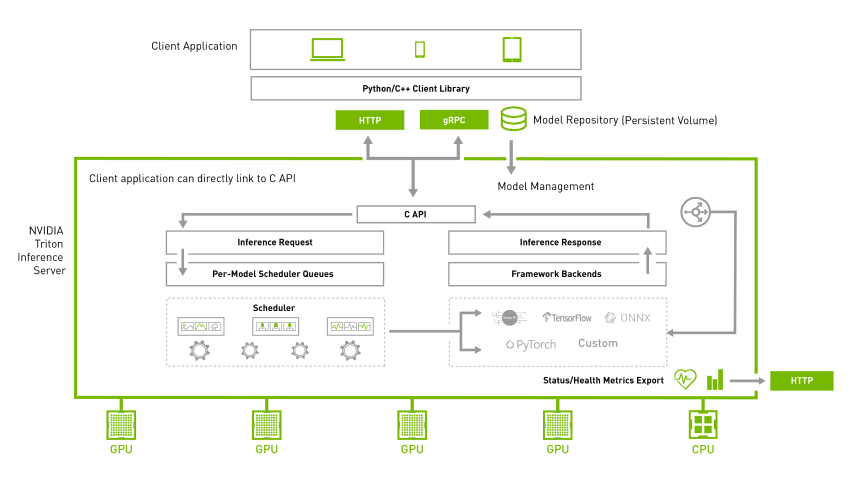

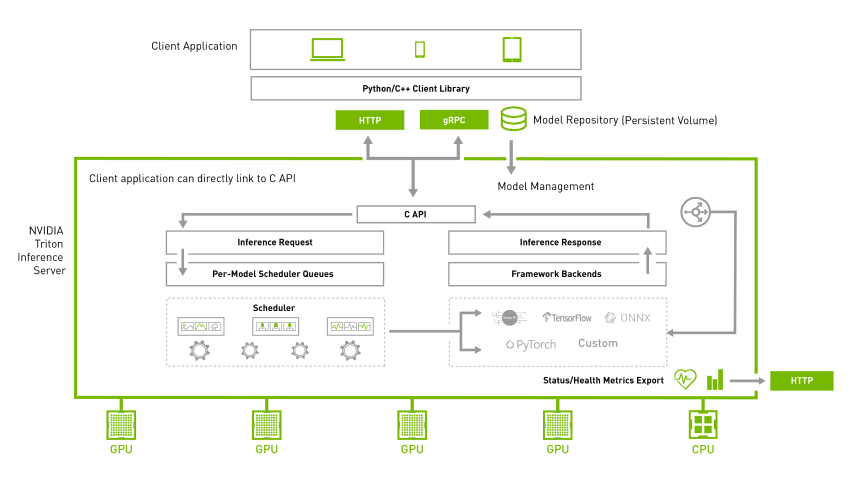

NVIDIA Triton系列文章(1):应用概论

NVIDIA Triton系列文章(2):功能与架构简介

NVIDIA Triton系列文章(3):开发资源说明

NVIDIA Triton系列文章(4):创建模型仓

原文标题:NVIDIA Triton 系列文章(5):安装服务器软件

文章出处:【微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

-

英伟达

+关注

关注

23文章

4041浏览量

97688

原文标题:NVIDIA Triton 系列文章(5):安装服务器软件

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

服务器数据恢复—意外断电!Linux服务器数据恢复大揭秘

使用NVIDIA Triton和TensorRT-LLM部署TTS应用的最佳实践

服务器数据恢复—服务器重装系统导致分区消失的数据恢复案例

服务器数据恢复—如何预防服务器故障与恢复服务器数据!

windows搭建ftp服务器的步骤

Flexus 云服务器 X 实例实践:安装 Dashdot 开源服务器仪表板

Flexus 云服务器 X 实例实践:安装 Ward 服务器监控工具

Flexus 云服务器 X:Python 安装的极致便捷之旅

NVIDIA Triton 系列文章(5):安装服务器软件

NVIDIA Triton 系列文章(5):安装服务器软件

评论